면접 대비 답변

가설함수(Hypothesis Function)은 학습을 통해 최적화를 시키려는 함수로 데이터의 분포를 일반적으로 나타내는 함수가 될 수 있습니다. 이 가설함수를 실제 데이터와 최적화 하기 위한 함수를 cost function 혹은, loss function이라고 합니다. 예를 들어 선형회귀 그래프의 가설함수는 y = wx + bias라면 이 cost function은 이 되며, 이 값을 최소화하기하는 w를 찾는 식으로 학습이 이루어집니다.

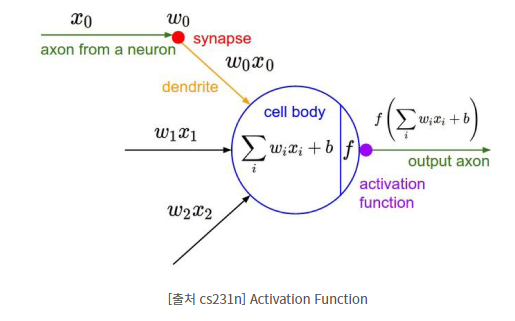

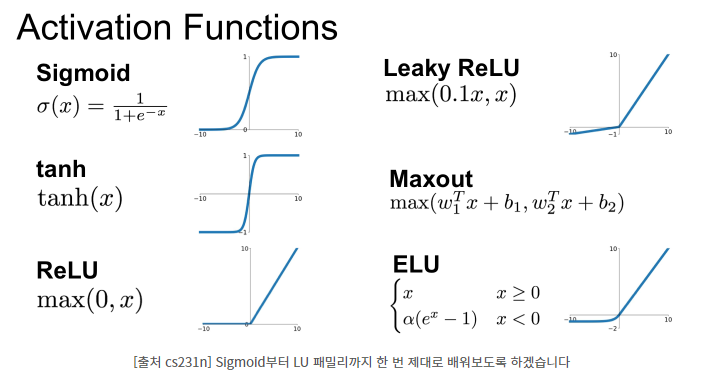

Activation Function은 들어온 값들 중에서 다음 신호에 사용될 값을 추려서 전달하고, 딥러닝에서 뉴런네트워크를 쌓음에 있어서 비선형성을 주어 다양한 정보를 담을 수 있도록 합니다. (선형을 계속 쌓아봤자 선형이기때문에 많은 정보를 담지 못함) Activation Function의 종류로는 0과 1로 표현되는 Sigmoid 함수, 계산이 반복됨에 따라 값이 사라지는 문제를 해소하기 위한 ReLU등이 있습니다.

상세 내용

- input과 weight의 내적 값에 bias를 더한 값을 얼마나 출력시킬지 정하기 위해 Activation Function을 사용합니다.