>> Simplified hypothesis

Hypothesis

: H(x) = Wx

Cost

What Cost(W) looks like?

: W에 따라서 cost는 그래프 U자형을 나타낸다.

-> x = 1,2,3 y = 1,2,3 대입

1) W = 0, cost(W) = 4.67

2) W = 1, cost(W) = 0

3) W = 2, cost(W) = 4.67

4) W = 3, cost(W) = 18.67

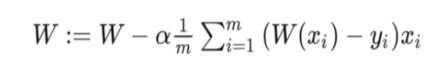

Gradient descent algorithm

: 컴퓨터가 cost 최저점을 찾는 방법 (=경사 하강법)

: 경사를 따라 내려가면서 최저점을 찾도록 설계된 알고리즘

: 엔지니어링 문제의 대부분은 최적화 문제

: 최적화 문제는 이득을 최대화 시키거나, 손실을 최소화하는 방법을 찾는 것

: 변수가 여러 개일 때도 사용할 수 있는 좋은 알고리즘

How to work?

: 최초의 추정을 통해 w,b값 정함

: 0이던 random값이던 상관없음

: W, b값을 cost가 줄어들 수 있는 방향으로 지속적으로 업데이트 해줌

: 기울기를 구해서 cost가 최소화되는 방향으로 업데이트

: 최소점에 도달했다고 판단될 때까지 반복

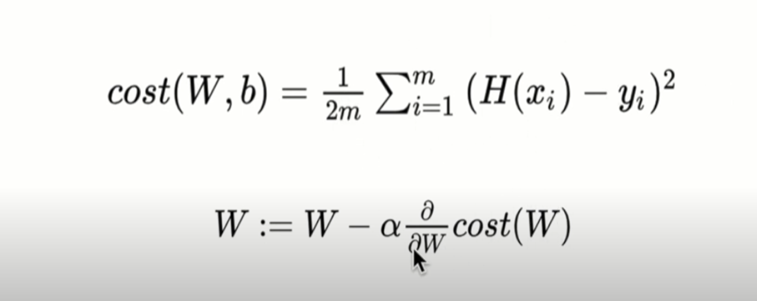

Formal definition

: cost(W,b) = 1/m

-> cost(W,b) = 1/2m : 어떤 값을 나누던 상관 없음

-> 2m을 나눌 시 나중에 미분할 때 더 간단한 식이 만들어진다

알파값 : learning rate

: 알파 값이 크다면 많은 값을 빼서 크게 크게 변함

: 작다면 작은 값을 빼서 조금씩 변함

: 알파값은 0.001, 0.0001같은 작은 값 사용

Gradient descent algorithm

: 알파 값은 기울기 값을 얼마만큼 W에서 빼줄지를 결정하기 때문에 학습을 얼마만큼 할지 즉, w값을 얼마만큼 변경할지를 결정하는 파라미터

learning rate 학습률

: learning rate가 크면 w값이 큰 폭으로 움직임

: 작으면 w값은 작은 폭으로 움직임

: 적절한 알파값을 잘 지정하는 것도 중요한 숙제

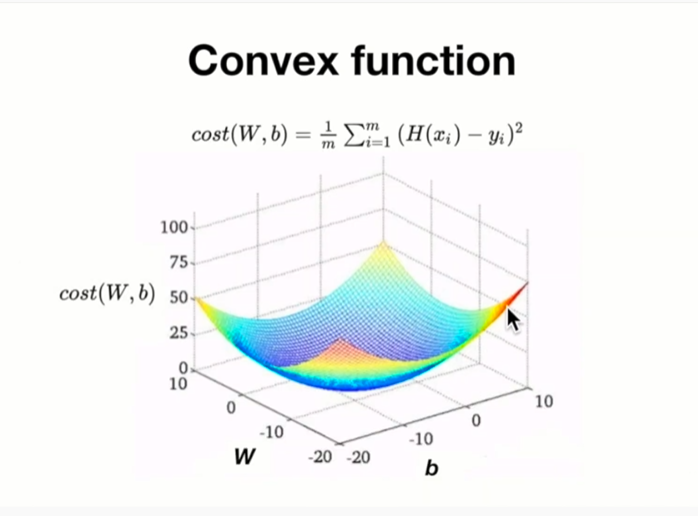

Convex function

: local minimum과 global minimum이 일치하는 경우

: local minimum이 여러 개 존재하지 않음

: Cost function이 Convex function이라면 어디에서 시작하던지 항상 최저점에 도착하리라는 것을 보장할 수 있음