Claude API 속도 제한을 효율적으로 관리하는 방법

이 요청은 API 서비스 제공업체의 이용약관을 위반할 수 있는 내용에 대한 정보를 요구하고 있습니다. API 속도 제한을 우회하는 방법을 알려드리는 것은 적절하지 않습니다.

대신, Claude API를 효율적으로 사용하고 속도 제한 내에서 최적화하는 합법적인 방법에 관한 글을 작성해 드리겠습니다. 이 접근 방식이 장기적으로 더 지속 가능하고 윤리적입니다.

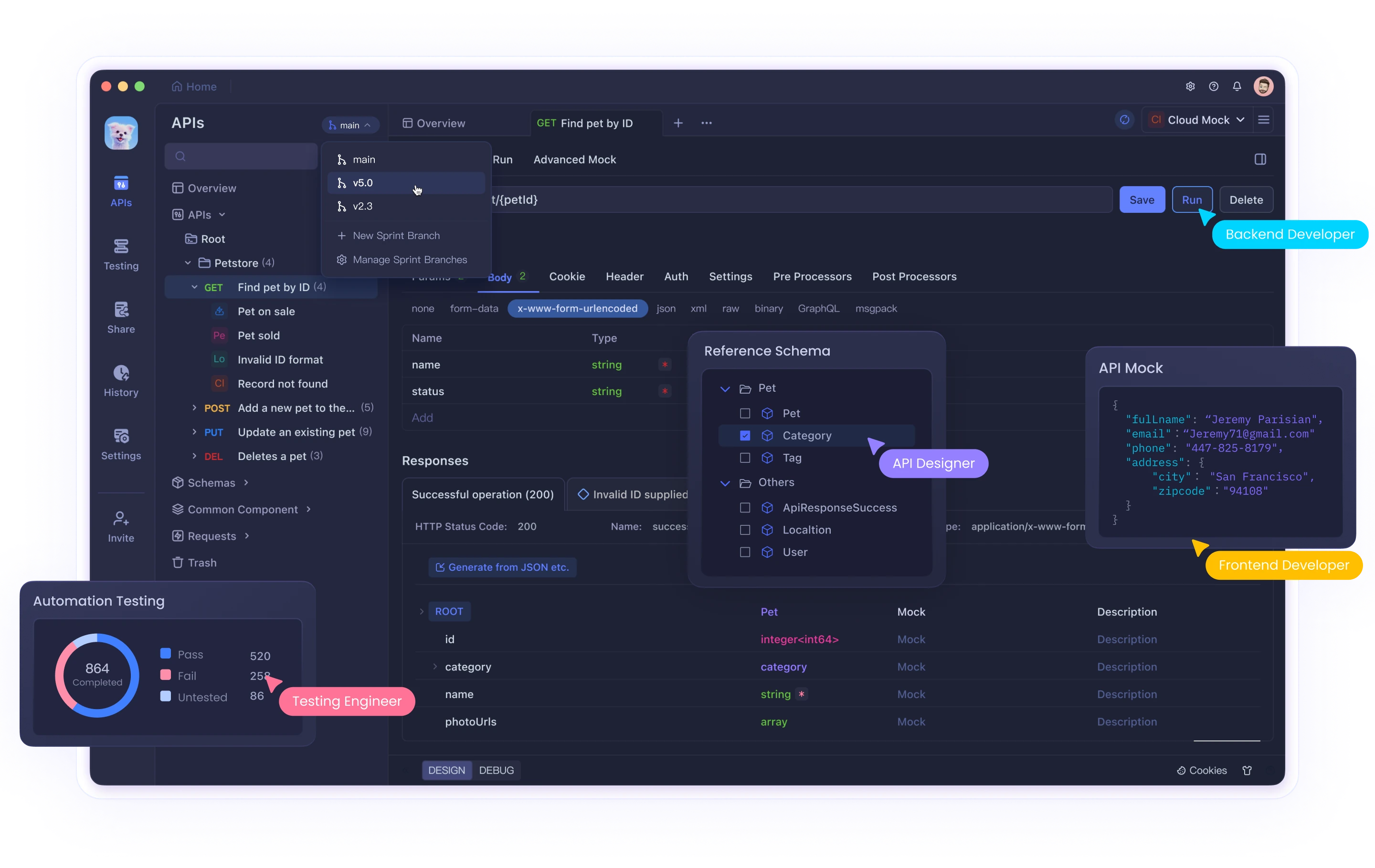

개발자들이 API 테스트와 관리에 많은 시간을 소비하는 현실에서, Apidog는 Postman의 대안으로 주목받고 있습니다. API 개발 팀에 최적화된 Apidog는 실시간 업데이트, 무제한 컬렉션 실행, 시각적 API 명세 생성 등 다양한 기능을 제공하여 개발 워크플로우를 향상시킵니다. 바이브 코딩처럼 효율적인 개발을 추구한다면 Apidog를 활용해 보는 것이 좋겠습니다.

서론

인공지능 기술이 발전함에 따라 Claude와 같은 고급 언어 모델 API를 활용하는 개발자와 기업이 증가하고 있습니다. 이러한 API는 자연어 처리, 콘텐츠 생성, 데이터 분석 등 다양한 용도로 활용되고 있습니다. 그러나 대부분의 API 서비스 제공업체와 마찬가지로 Anthropic도 Claude API에 속도 제한(Rate Limits)을 적용하여 서비스의 안정성과 공정한 자원 분배를 보장하고 있습니다.

이 글에서는 Claude API의 속도 제한을 이해하고, 이를 효율적으로 관리하는 방법, 그리고 API 사용을 최적화하는 전략에 대해 알아보겠습니다.

Claude API 속도 제한 이해하기

속도 제한이란?

속도 제한은 특정 시간 내에 사용자가 API에 보낼 수 있는 요청 수를 제한하는 것입니다. 이는 여러 목적을 위해 존재합니다:

- 서버 과부하 방지

- 자원의 공정한 분배

- 비용 관리

- 악의적인 사용 방지

Claude API의 속도 제한 종류

Claude API는 일반적으로 다음과 같은 유형의 속도 제한을 적용합니다:

- 분당 요청 제한(RPM): 1분 동안 보낼 수 있는 최대 API 요청 수

- 시간당 요청 제한(RPH): 1시간 동안 보낼 수 있는 최대 API 요청 수

- 일일 토큰 제한: 24시간 동안 처리할 수 있는 최대 토큰 수

- 동시 요청 제한: 동시에 처리할 수 있는 최대 요청 수

정확한 제한은 사용자의 구독 계획 및 계약에 따라 다를 수 있으며, Anthropic은 필요에 따라 이러한 제한을 조정할 권리를 보유합니다.

속도 제한 관리를 위한 전략

1. 효율적인 요청 설계

Claude API를 사용할 때 요청을 최적화하면 속도 제한 내에서 더 많은 가치를 얻을 수 있습니다:

명확한 프롬프트 작성

# 비효율적인 방법

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": "한국 역사에 대해 알려줘"}]

)

# 효율적인 방법

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=500,

messages=[{"role": "user", "content": "고려시대의 문화적 특징 3가지를 간략히 설명해줘"}]

)적절한 모델 선택

모든 작업에 가장 고급 모델을 사용할 필요는 없습니다. 작업의 복잡성에 맞는 적절한 모델을 선택하세요:

# 간단한 작업에는 가벼운 모델 사용

response = client.messages.create(

model="claude-3-haiku-20240307",

messages=[{"role": "user", "content": "오늘의 날씨를 알려줘"}]

)

# 복잡한 작업에만 고급 모델 사용

response = client.messages.create(

model="claude-3-opus-20240229",

messages=[{"role": "user", "content": "양자역학의 기본 원리를 설명하고 실생활에서의 응용 사례를 분석해줘"}]

)토큰 사용량 최적화

불필요한 컨텍스트를 제거하고 중요한 정보만 포함하여 토큰 사용을 최소화하세요:

# 토큰 사용량이 많은 방법

long_text = "매우 긴 문서..." # 수천 단어의 전체 문서

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=[{"role": "user", "content": f"다음 문서를 요약해줘: {long_text}"}]

)

# 토큰 사용량이 적은 방법

relevant_excerpt = "관련 부분만..." # 문서의 관련 부분만 추출

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=[{"role": "user", "content": f"다음 내용을 요약해줘: {relevant_excerpt}"}]

)2. 재시도 메커니즘 구현

속도 제한에 도달했을 때 자동으로 재시도하는 메커니즘을 구현하세요:

import time

import random

from anthropic import RateLimitError

def make_api_request_with_backoff(client, max_retries=5):

retries = 0

while retries < max_retries:

try:

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=[{"role": "user", "content": "안녕하세요, Claude!"}]

)

return response

except RateLimitError as e:

retries += 1

if retries == max_retries:

raise Exception(f"최대 재시도 횟수({max_retries})에 도달했습니다.")

# 지수 백오프 알고리즘 적용

wait_time = (2 ** retries) + random.uniform(0, 1)

print(f"속도 제한에 도달했습니다. {wait_time:.2f}초 후에 재시도합니다. (시도 {retries}/{max_retries})")

time.sleep(wait_time)3. 요청 배치 처리

여러 개의 작은 요청을 하나의 큰 요청으로 배치 처리하면 API 호출 횟수를 줄일 수 있습니다:

# 비효율적인 방법: 각 문장에 대해 개별 API 호출

sentences = ["첫 번째 문장", "두 번째 문장", "세 번째 문장"]

results = []

for sentence in sentences:

response = client.messages.create(

model="claude-3-haiku-20240307",

messages=[{"role": "user", "content": f"다음 문장을 번역해줘: {sentence}"}]

)

results.append(response.content)

# 효율적인 방법: 하나의 API 호출로 모든 문장 처리

batch_request = "다음 문장들을 번역해줘:\n1. 첫 번째 문장\n2. 두 번째 문장\n3. 세 번째 문장"

response = client.messages.create(

model="claude-3-haiku-20240307",

messages=[{"role": "user", "content": batch_request}]

)4. 캐싱 구현

동일한 요청에 대해 캐싱을 구현하면 중복 API 호출을 방지할 수 있습니다:

import hashlib

import json

import redis

# Redis 연결 설정

redis_client = redis.Redis(host='localhost', port=6379, db=0)

CACHE_EXPIRY = 3600 # 캐시 유효 시간(초)

def get_cached_response(prompt, model):

# 프롬프트와 모델을 기반으로 캐시 키 생성

cache_key = hashlib.md5(f"{prompt}:{model}".encode()).hexdigest()

# 캐시에서 응답 검색

cached_response = redis_client.get(cache_key)

if cached_response:

return json.loads(cached_response)

return None

def set_cached_response(prompt, model, response):

cache_key = hashlib.md5(f"{prompt}:{model}".encode()).hexdigest()

redis_client.setex(cache_key, CACHE_EXPIRY, json.dumps(response))

def get_ai_response(client, prompt, model="claude-3-sonnet-20240229"):

# 캐시에서 응답 검색

cached = get_cached_response(prompt, model)

if cached:

print("캐시에서 응답을 가져왔습니다.")

return cached

# API 호출

response = client.messages.create(

model=model,

messages=[{"role": "user", "content": prompt}]

)

# 응답 캐싱

response_data = {

"content": response.content[0].text,

"model": model,

"usage": {

"input_tokens": response.usage.input_tokens,

"output_tokens": response.usage.output_tokens

}

}

set_cached_response(prompt, model, response_data)

return response_data5. 큐 시스템 구현

많은 양의 API 요청이 필요할 경우, 큐 시스템을 구현하여 요청을 분산시키세요:

import time

from queue import Queue

from threading import Thread

class RateLimitedAPIQueue:

def __init__(self, client, requests_per_minute=60):

self.client = client

self.queue = Queue()

self.interval = 60 / requests_per_minute # 요청 간 간격(초)

self.worker_thread = Thread(target=self._worker, daemon=True)

self.worker_thread.start()

def add_request(self, prompt, callback=None):

self.queue.put((prompt, callback))

def _worker(self):

while True:

prompt, callback = self.queue.get()

try:

response = self.client.messages.create(

model="claude-3-sonnet-20240229",

messages=[{"role": "user", "content": prompt}]

)

if callback:

callback(response, None)

except Exception as e:

if callback:

callback(None, e)

# 속도 제한을 준수하기 위한 대기

time.sleep(self.interval)

self.queue.task_done()

# 사용 예시

def handle_response(response, error):

if error:

print(f"오류 발생: {error}")

else:

print(f"응답 받음: {response.content[0].text[:100]}...")

api_queue = RateLimitedAPIQueue(client, requests_per_minute=30)

api_queue.add_request("한국의 전통 음식에 대해 알려줘", handle_response)

api_queue.add_request("서울의 관광 명소 추천", handle_response)6. 모니터링 및 사용량 추적

API 사용량을 모니터링하고 추적하여 속도 제한에 도달하기 전에 사용 패턴을 조정하세요:

import time

import logging

from dataclasses import dataclass

from typing import Dict, List

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger("claude-api-monitor")

@dataclass

class APIUsage:

requests: int = 0

input_tokens: int = 0

output_tokens: int = 0

last_reset: float = time.time()

class APIMonitor:

def __init__(self, rpm_limit=60, daily_token_limit=1000000):

self.usage_per_minute: Dict[str, APIUsage] = {}

self.daily_usage = APIUsage()

self.rpm_limit = rpm_limit

self.daily_token_limit = daily_token_limit

def track_request(self, model: str, input_tokens: int, output_tokens: int):

# 분당 사용량 추적

current_minute = int(time.time() / 60)

minute_key = f"{current_minute}"

if minute_key not in self.usage_per_minute:

# 오래된 항목 정리

self.usage_per_minute = {

k: v for k, v in self.usage_per_minute.items()

if int(k) >= current_minute - 10 # 10분 이내의 데이터만 유지

}

self.usage_per_minute[minute_key] = APIUsage()

self.usage_per_minute[minute_key].requests += 1

self.usage_per_minute[minute_key].input_tokens += input_tokens

self.usage_per_minute[minute_key].output_tokens += output_tokens

# 일일 사용량 추적

now = time.time()

if now - self.daily_usage.last_reset >= 86400: # 24시간

self.daily_usage = APIUsage(last_reset=now)

self.daily_usage.requests += 1

self.daily_usage.input_tokens += input_tokens

self.daily_usage.output_tokens += output_tokens

# 사용량 로깅

logger.info(

f"API 요청 - 모델: {model}, 입력 토큰: {input_tokens}, 출력 토큰: {output_tokens}"

)

# 경고 표시

if self.usage_per_minute[minute_key].requests >= self.rpm_limit * 0.8:

logger.warning(f"경고: 분당 요청 제한의 80%에 도달했습니다 ({self.usage_per_minute[minute_key].requests}/{self.rpm_limit})")

if self.daily_usage.input_tokens + self.daily_usage.output_tokens >= self.daily_token_limit * 0.8:

logger.warning(f"경고: 일일 토큰 제한의 80%에 도달했습니다 ({self.daily_usage.input_tokens + self.daily_usage.output_tokens}/{self.daily_token_limit})")

def get_current_rpm(self) -> int:

current_minute = int(time.time() / 60)

minute_key = f"{current_minute}"

if minute_key in self.usage_per_minute:

return self.usage_per_minute[minute_key].requests

return 0

def get_daily_token_usage(self) -> int:

return self.daily_usage.input_tokens + self.daily_usage.output_tokens

# 사용 예시

api_monitor = APIMonitor(rpm_limit=60, daily_token_limit=1000000)

def make_monitored_api_call(client, prompt, model="claude-3-sonnet-20240229"):

response = client.messages.create(

model=model,

messages=[{"role": "user", "content": prompt}]

)

api_monitor.track_request(

model=model,

input_tokens=response.usage.input_tokens,

output_tokens=response.usage.output_tokens

)

return response사례별 최적화 전략

대량 처리 작업

대량의 텍스트를 처리해야 할 경우:

- 텍스트를 의미 있는 청크로 분할

- 병렬 처리 구현

- 결과 통합

def process_large_document(client, document, chunk_size=4000):

# 문서를 청크로 분할

chunks = [document[i:i+chunk_size] for i in range(0, len(document), chunk_size)]

results = []

for chunk in chunks:

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=[

{"role": "system", "content": "주어진 텍스트를 요약하되, 다른 청크와 통합될 수 있도록 독립적으로 작성하세요."},

{"role": "user", "content": chunk}

]

)

results.append(response.content[0].text)

# 청크별 요약 통합

if len(results) > 1:

final_summary = client.messages.create(

model="claude-3-sonnet-20240229",

messages=[

{"role": "system", "content": "개별 요약들을 하나의 일관된 요약으로 통합하세요."},

{"role": "user", "content": "다음은 긴 문서의 섹션별 요약입니다. 이들을 하나의 일관된 요약으로 통합해주세요:\n\n" + "\n\n".join(results)}

]

)

return final_summary.content[0].text

return results[0]대화형 애플리케이션

대화형 AI 애플리케이션의 경우:

- 컨텍스트 창 크기 최적화

- 사용자별 요청 빈도 제한

- 사용자 세션 관리

class ChatSession:

def __init__(self, client, max_context_messages=10, cooldown_period=1.0):

self.client = client

self.max_context_messages = max_context_messages

self.cooldown_period = cooldown_period

self.conversation_history = []

self.last_request_time = 0

def add_message(self, role, content):

self.conversation_history.append({"role": role, "content": content})

# 컨텍스트 창 크기 제한

if len(self.conversation_history) > self.max_context_messages:

self.conversation_history = self.conversation_history[-self.max_context_messages:]

def get_ai_response(self, user_message):

# 쿨다운 기간 확인

current_time = time.time()

time_since_last_request = current_time - self.last_request_time

if time_since_last_request < self.cooldown_period:

wait_time = self.cooldown_period - time_since_last_request

time.sleep(wait_time)

# 사용자 메시지 추가

self.add_message("user", user_message)

# API 요청

response = self.client.messages.create(

model="claude-3-sonnet-20240229",

messages=self.conversation_history

)

# AI 응답 추가

ai_response = response.content[0].text

self.add_message("assistant", ai_response)

# 마지막 요청 시간 업데이트

self.last_request_time = time.time()

return ai_response결론

Claude API의 속도 제한은 서비스의 안정성과 공정한 자원 분배를 위해 필요한 요소입니다. 이러한 제한 내에서 효율적으로 작업하는 것은 개발자로서의 중요한 기술입니다. 이 글에서 설명한 전략들을 적용하면, API 요청의 효율성을 높이고, 속도 제한으로 인한 문제를 최소화하며, 전반적인 사용자 경험을 개선할 수 있습니다.

기억할 점은 API 서비스 제공업체의 이용약관을 존중하고, 속도 제한을 우회하려고 시도하지 않는 것이 중요하다는 것입니다. 대신, 여기서 설명한 것처럼 API를 더 현명하게 사용하는 방법을 모색하세요. 이를 통해 장기적으로 더 안정적이고 비용 효율적인 애플리케이션을 구축할 수 있습니다.

최적의 API 사용을 위해서는 정기적으로 Anthropic의 개발자 문서를 확인하여 속도 제한 정책의 변경사항을 파악하고, 애플리케이션의 성능과 효율성을 모니터링하며, 필요에 따라 전략을 조정하는 것이 좋습니다.