AUC-ROC Curve란?

AUC-ROC Curve는 분류 모델의 성능을 다양한 임계값(threshold)에서 평가하기 위한 지표다.

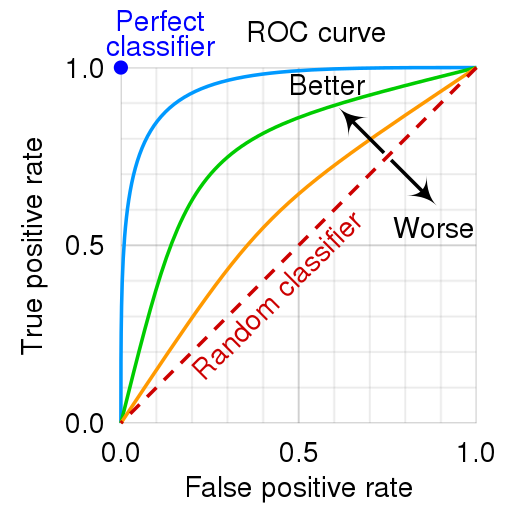

- ROC (Receiver Operating Characteristic) Curve: 확률 곡선(Probability Curve)으로, 모델이 Positive와 Negative 클래스를 얼마나 잘 구분하는지 보여준다.

- AUC (Area Under the Curve): ROC Curve 아래 면적으로, 모델의 클래스 분리 능력(separability)을 나타낸다. AUC 값이 높을수록 모델의 분류 성능이 더 뛰어나다.

ROC Curve 구성

ROC Curve는 FPR (False Positive Rate)을 x축, TPR (True Positive Rate)을 y축으로 그린 그래프다. 모델의 임계값 변화에 따른 TPR과 FPR의 관계를 나타내며, 아래 그림과 같은 형태를 가진다.

AUC-ROC Curve에서 사용하는 주요 용어

1. TPR (True Positive Rate) / Recall / Sensitivity

실제로 Positive인 샘플을 얼마나 정확히 예측했는지를 나타낸다.

2. Specificity

실제로 Negative인 샘플을 얼마나 정확히 예측했는지를 나타낸다.

3. FPR (False Positive Rate)

실제로 Negative인 샘플을 Positive로 잘못 예측한 비율이다. Specificity와의 관계는 다음과 같다.

요약

- AUC 값은 모델의 분류 성능을 단일 값으로 나타낸다.

- AUC 값이 1.0에 가까울수록 완벽한 분류 성능을 가진 모델이다.

- AUC 값이 0.5에 가까울수록 무작위로 예측하는 모델과 다를 바 없다.

- ROC Curve는 모델의 임계값 변화에 따른 성능을 비교하거나 확인할 때 유용하다.