Bigdata

1.Bigdata, Platform

기존 온프레미스 환경에서는 여전히 하둡이 많이 사용된다. 하지만 새로운 데이터 파이프라인 구축에서는 쿠버네티스 기반 Spark, Flink, Trino(Presto) 등이 대세이다.특히, 클라우드 환경에서는 Hadoop 대신 Kubernetes 기반 데이터 처리가 압도

2.Bigdata, Iceberg 개요

Apache Iceberg는 대규모 데이터 세트를 효율적으로 관리하고 처리하기 위한 오픈 소스 테이블 형식이다. Apache Iceberg는 전통적인 RDBMS(Relational Database Management System)를 대체하는 기술이 아니라, 데이터 레이

3.Bigdata, Kubernetes 운영 빅데이터 기술들

Apache Spark는 대규모 데이터 처리를 위한 분산형 배치 및 스트리밍 처리 엔진이다. 주요 특징으로 고속 메모리 연산, 강력한 배치 처리, 머신 러닝 및 그래프 처리가 지원된다. 활용 사례로는 빅데이터 분석, ETL(Extract, Transform, Load)

4.Bigdata, Scala

Scala는 JVM(Java Virtual Machine)에서 실행되는 함수형 및 객체지향 프로그래밍 언어이다. Java와의 높은 호환성을 가지며, 간결하고 강력한 표현력을 제공하는 것이 특징이다. 대표적인 활용 사례로는 Apache Spark 및 분산 데이터 처리,

5.Bigdata, Scala / SBT

SBT(Scala Build Tool)는 Scala 및 Java 프로젝트를 위한 빌드 도구로, 특히 Scala 생태계에서 널리 사용된다. SBT는 병렬 태스크 실행, 증분 컴파일, 플러그인 시스템 등을 지원하여 대규모 프로젝트에서도 효율적인 빌드 환경을 제공한다.증분

6.Bigdata, Scala / GraalVM

GraalVM은 Oracle이 개발한 고성능 JVM 및 네이티브 실행 환경으로, 기존 JVM 대비 더 빠른 실행 속도, 낮은 메모리 사용량, 다중 언어 지원을 제공하는 게 특징이다. 특히, Scala(SBT)와 Rust를 함께 사용하려면 GraalVM을 활용하여 빌드

7.Bigdata, Benchmark

벤치마크(Benchmarking)는 특정 시스템, 애플리케이션, 네트워크, 하드웨어의 성능을 평가하고 최적화하기 위해 수행하는 과정이다. 이를 통해 현재 성능을 객관적으로 측정하고, 개선 방향을 도출할 수 있다.하드웨어나 소프트웨어가 기대하는 성능을 발휘하는지 확인변경

8.Bigdata, HMS

HMS(Hive Metastore Service)는 Apache Hive의 메타스토어(Metastore) 서비스로, 테이블, 데이터베이스, 파티션, 스키마 등의 메타데이터를 관리하는 역할을 한다.여러 최신 기술이 생겼음에도 Hive Metastore (HMS)를 활용

9.Bigdata, Catalog

데이터 레이크의 카탈로그 서비스는 데이터의 메타데이터를 관리하는 중요한 컴포넌트로, 데이터셋을 탐색하고 이해하며 효율적으로 사용할 수 있도록 돕는 역할을 한다. 이를 통해 데이터를 저장소에 저장하는 것뿐만 아니라, 데이터의 구조와 변화를 추적하고, 접근 제어를 적용하며

10.Bigdata, Hive

Hive는 Apache Hadoop 위에서 동작하는 데이터 웨어하우스 시스템으로, 대용량 데이터 분석을 위해 SQL과 유사한 HiveQL(Hive Query Language)을 제공하는 도구이다. Hive는 주로 배치 처리와 데이터 웨어하우스 쿼리에 사용되며, Hado

11.Bigdata, Minio / API

CLI, REST API, SDK를 통해 Minio 버킷에 접근해 보자MinIO API 사용 방법 확인하기CLI 사용하기REST API 사용하기PROGRAMMING SKD 사용하기📗MinIO API 활용(- 🔗\[목차](- 사전 준비( - 도커 설치( - Acc

12.Bigdata, Hadoop -> Kubernetes

하둡에서 Kubernetes로 이관을 고려하는 이유는 주로 운영 효율성과 확장성을 개선하기 위함이다.목표 아키텍처 정의하기스토리지: Object Storage (S3, MinIO) + Iceberg데이터 처리: Spark on Kubernetes, Flink on Ku

13.Bigdata, Trino

Trino를 사용하는 이유는 멀티 데이터 소스 쿼리(Federated Query)를 위함이다. 운영 데이터베이스(MySQL, PostgreSQL)와 빅데이터 플랫폼(Hive, Iceberg) 데이터를 하나의 쿼리로 결합한다. MySQL, PostgreSQL, Iceb

14.Bigdata, Iceberg

Iceberg는 대규모 분석 데이터를 위한 오픈 테이블 포맷이다. 원래 Netflix에서 시작되어 현재는 Apache Software Foundation에서 관리하고 있으며, 데이터 레이크에 저장된 파일들을 효율적으로 관리하고 분석 성능을 높이기 위해 만들어졌다.HDF

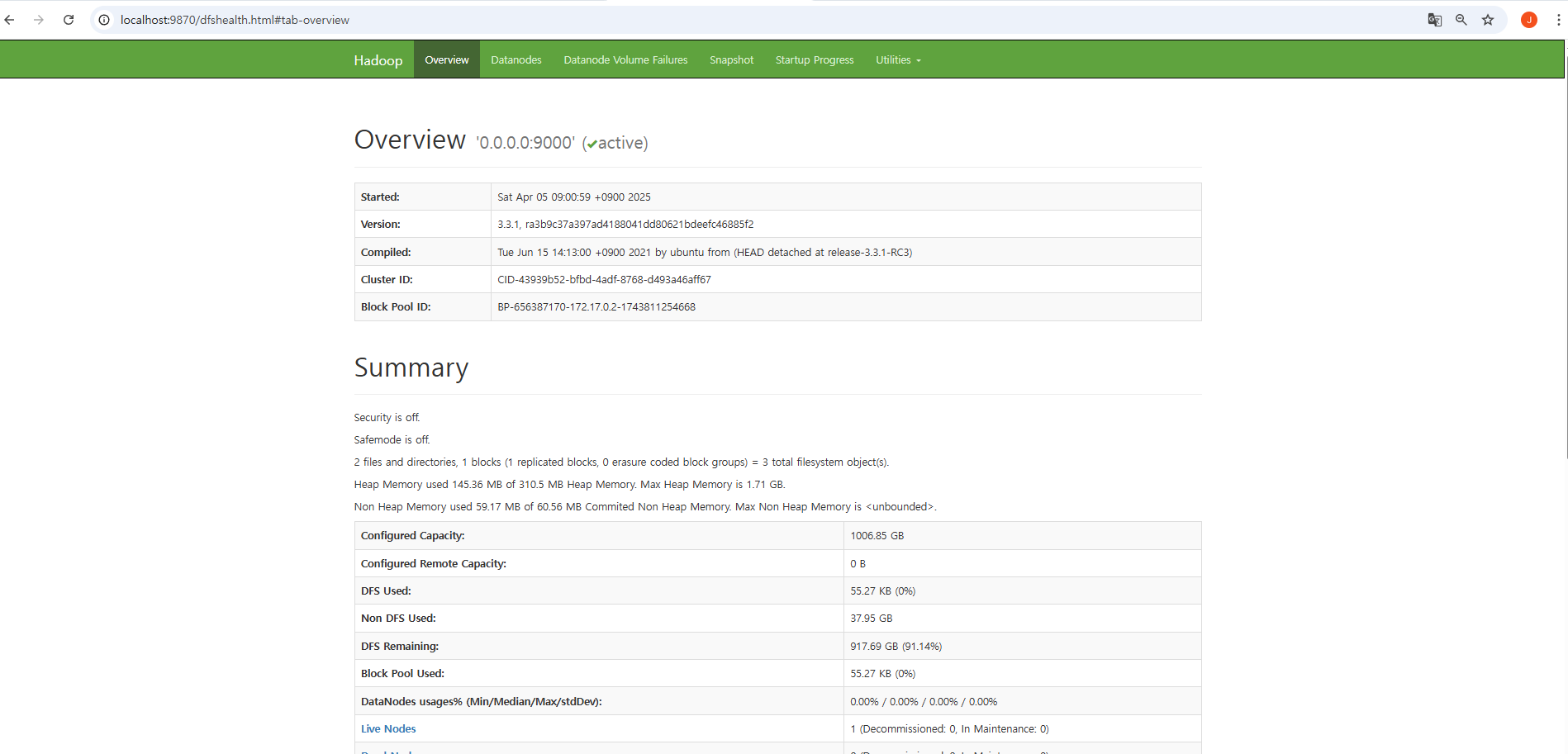

15.Bigdata, Hadoop / HDFS

HDFS(Hadoop Distributed File System)는 대규모 데이터를 저장하고 관리하기 위한 분산 파일 시스템으로, Hadoop 에코시스템의 핵심 구성 요소 중 하나다.HDFS는 클러스터의 여러 노드에 데이터를 분산 저장하여 확장성, 내결함성, 높은 처리

16.Bigdata, datalake / plan

📗하둡-> 쿠버네티스 이관 계획 수립🏳️🌈 궁금한점이관 계획에 대한 템플릿🔗목차1\. 준비 및 분석( - 1-1. 현황 파악( - 기존 Hadoop 환경의 구성 요소 파악( - 데이터 크기 및 분포 확인( - 워크로드 유형 확인( - 의

17.Bigdata, MinIO / 아키텍처

📗MinIO 개요MinIO EC(Erasure Coding)는 MinIO에서 데이터의 고가용성과 내결함성을 보장하기 위한 기능으로 디스크나 노드 일부가 손실되더라도 데이터를 복구할 수 있도록 하는 기술이다.RAID처럼 데이터를 여러 조각으로 나누고, 여분(패리티)을

18.Bigdata, Lakehouse / Snowflake

Lakehouse는 Data Lake + Data Warehouse를 합친 개념이다. ETL 과정이 복잡하고 느리고, 비용도 이중으로 들고 (저장비용 + DW비용) 데이터가 분산돼서 관리가 어려움이 있었다. Data Lake처럼 싸게 저장하고 Data Warehouse

19.Bigdata, Kafka

Kafka는 분산 스트리밍 플랫폼으로, 대규모 실시간 데이터 처리에 사용된다. 실시간 데이터 스트리밍, 로그 수집, 이벤트 소싱, 메시지 브로커로 활용한다.🏳️🌈 궁금한점카프카는 왜 빠를까카프카가 메시지 유실을 막을 방법이 무엇인가MQ와 어떻게 다른가쿠버네티스에

20.Bigdata, Kafka / Optimization

🏳️🌈 궁금한점카프카 최적화 방법Kafka 최적화 가이드( - Kafka broker( - Kafka producer( - Kafka consumer( - Zookeeper or KRaft (Kafka Raft)( - 모니터링 \\& 알림( - 분산 파

21.Bigdata, DBT

dbt란 데이터 변환(transform)을 SQL 기반으로 관리하는 도구이다. 데이터 엔지니어 → 데이터 모델러 → 비즈니스 분석가" 사이를 자연스럽게 이어주는 ELT 중심 도구이다.dbt가 처음 등장한 이유는 다음과 같은 예전 데이터 파이프라인 문제점 때문이다.데이터

22.Bigdata, Lakehouse / 방향성

🏳️🌈 궁금한점레이크 하우스 도입을 위해 뭘 준비해야 할까시장 현황(- 방향성 확립(- 도입 방법( - 필수 개념 다지기( - POC 진행( - 실전 최적화/운영(| 기술 | 기능

23.Bigdata, Lakehouse / JDK

🏳️🌈 궁금한점Kafka, Trino, Spark에서 사용하는 JDK를 통일해야 할까 JDK 어느 버전을 선택해야 할까 JDK 주요 버전 비교( - JDK 버전( - Lakehouse에 적합한 JDK 버전( - JDK 배포판( - Lakehouse 구성요소

24.Bigdata, Lakehouse

🏳️🌈 궁금한점왜 Lakehouse를 써야 할까카탈로그는 무엇인가🔗목차Lakehouse 개요( - Lakehouse 배경 및 필요성( - Lakehouse 아키텍처의 주요 특징( - Lakehouse 구성 요소 예시( - Lakehouse 장점( - 대

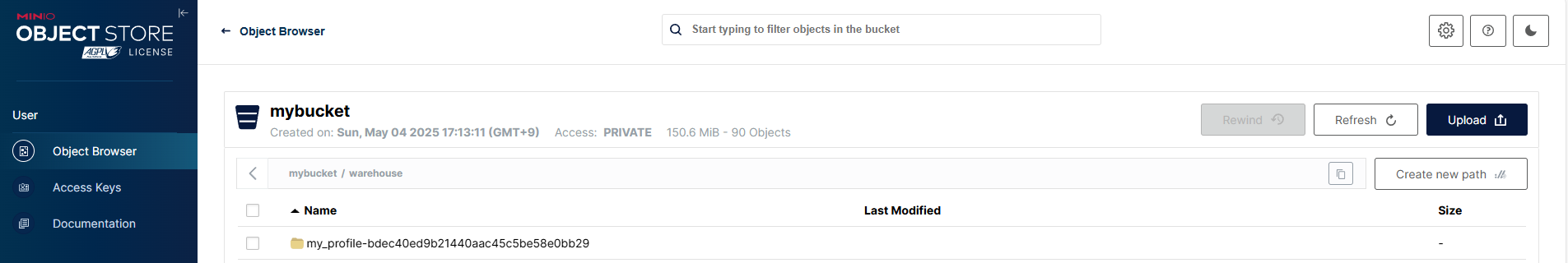

25.Lakehouse, HMS / dataflow

HMS 데이터 흐름(- HMS 구성 요소(- PostgreSQL 연결 정보(- Hive Metastore 주요 테이블(- 데이터 생성( - MinIO 버킷 확인( - PostgreSQL 확인( - DBS( - TBLS( - SDS (StorageDe

26.Lakehouse, 왜 쿠버네티스를 써야 하나

Kafka를 쿠버네티스에 올려야 하는 이유( - 현재 문제( - 쿠버네티스 상에서 카프카를 쓸 때의 기술적 장점( - 비즈니스 가치( - 실증(PoC)(- Spark를 쿠버네티스에 올려야 하는 이유( - 현재 문제( - 쿠버네티스 상에서 스파크를 쓸 때의 기

27.Lakehosue, Jenkins 역할

Jenkins on Kubernetes( - 젠킨스 주요 개념( - CI/CD 개요( - CI/CD 용어( - CI/CD 흐름( - CD (Continuous Delivery / Deployment) 차이( - CI/CD 파이프라인 예시(

28.Trino, 병렬 처리

Trino는 MPP (Massively Parallel Processing) 아키텍처를 기반으로 하며, 대규모 분산 쿼리를 병렬로 처리하는 데 최적화되어 있다. Trino의 병렬 처리 아키텍처는 다음과 같은 주요 컴포넌트와 흐름으로 구성되어 있다클러스터에서 단 하나만

29.Lakehouse, Trinio insert 대안

데이터레이크에서 Flink가 필요한 이유( - 실시간 Ingestion( - CDC(Change Data Capture) 처리( - Exactly-once 보장( - 이벤트 시간 기반 처리( - Lakehouse/ELT 엔진과의 연결(- Spark의 실시간성

30.Flink, 도입 검토

Flink 같은 스트리밍 엔진을 도입하는 이유( - 하드웨어/전통 방식으로 충분한 경우( - Flink를 쓰는 이유(- Flink가 꼭 필요한 이유( - 실시간 데이터 처리/분석( - 상태 기반 스트리밍 (Stateful Streaming)( - Exactly