주의 - OpenWebUI에 더 자세하고 친절하게 설명되어있음

지금까지는 로컬에서 Python의 Gradio나 대충 만든 React AI 채팅으로 돌려보다가 OpenWebUI를 알게 됐다.

나온 지는 그래도 좀 됐지만 이제라도 알게 된 게 다행이다.

OpenWebUI

Open WebUI는 Ollama를 위해 특별히 설계된 웹 기반 사용자 인터페이스이다.

원래 이름은 OllamaWebUI였던 것 같다.

그러나 오픈소스로 발전하면서 Ollama뿐만 아니라 여러 오픈소스 LLM도 사용 가능하게 되었다.

Ollama에 LLM을 넣어서 사용하는 것뿐만 아니라 OpenAI 호환 API를 사용하는 다른 LLM도 지원한다고 한다.

실행시켜보기

사실 위 링크에 설명이 너무나도 쉽게 되어있어서 따로 설명할게 없다.

나는 로컬에 Ollama가 설치되어있기 때문에 docker로 OpenWebUI만 실행해서 연결할 생각이다.

Docker로 실행

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway --name open-webui ghcr.io/open-webui/open-webui:main--add-host=host.docker.internal:host-gateway

- 컨테이너에서 호스트에서 실행중인 Ollama에 접근하기 위한 옵션

-v open-webui:/app/backend/data - 컨테이너의 데이터를 호스트에 저장/공유 하는 옵션

- 만약 현재 실행된 컨테이너의 데이터를 컨테이너가 제거되어도 사용하고 싶다면 사용권장

사용해보기

실행시킨 포트로 접근하기

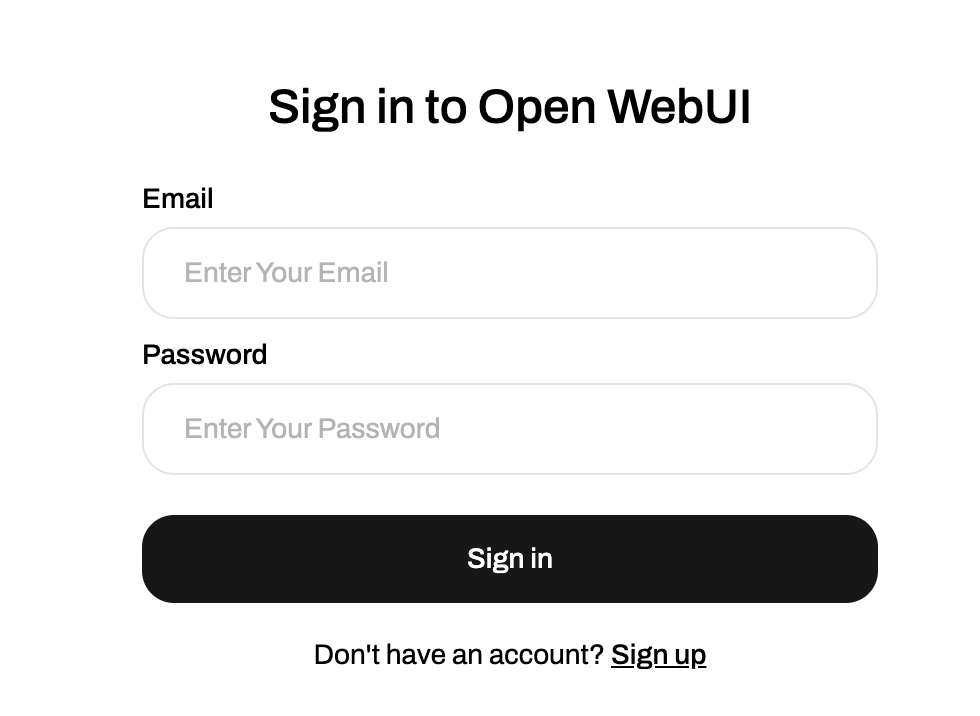

로그인

기본 계정은 따로 제공하지는 않는것 같다.

기본 계정은 따로 제공하지는 않는것 같다.

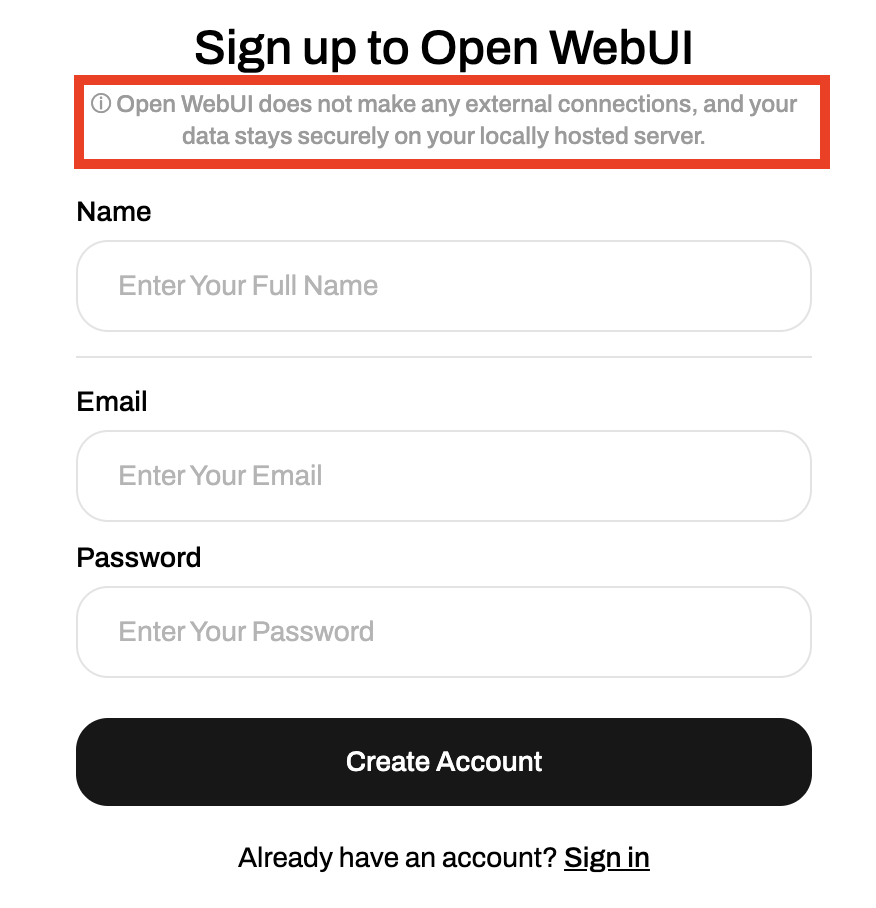

어드민 계정 생성

계정정보는 외부로 나가지 않는다고 한다.

계정정보는 외부로 나가지 않는다고 한다.

컨테이너가 실행되고 최초로 가입하는 계정이 Admin 계정이고 그 뒤로 가입하는 계정은 기본적으로 Admin계정의 허가가 필요하다.

우선 어드민 계정으로 사용할 계정을 생성하자

모델 선택 및 채팅

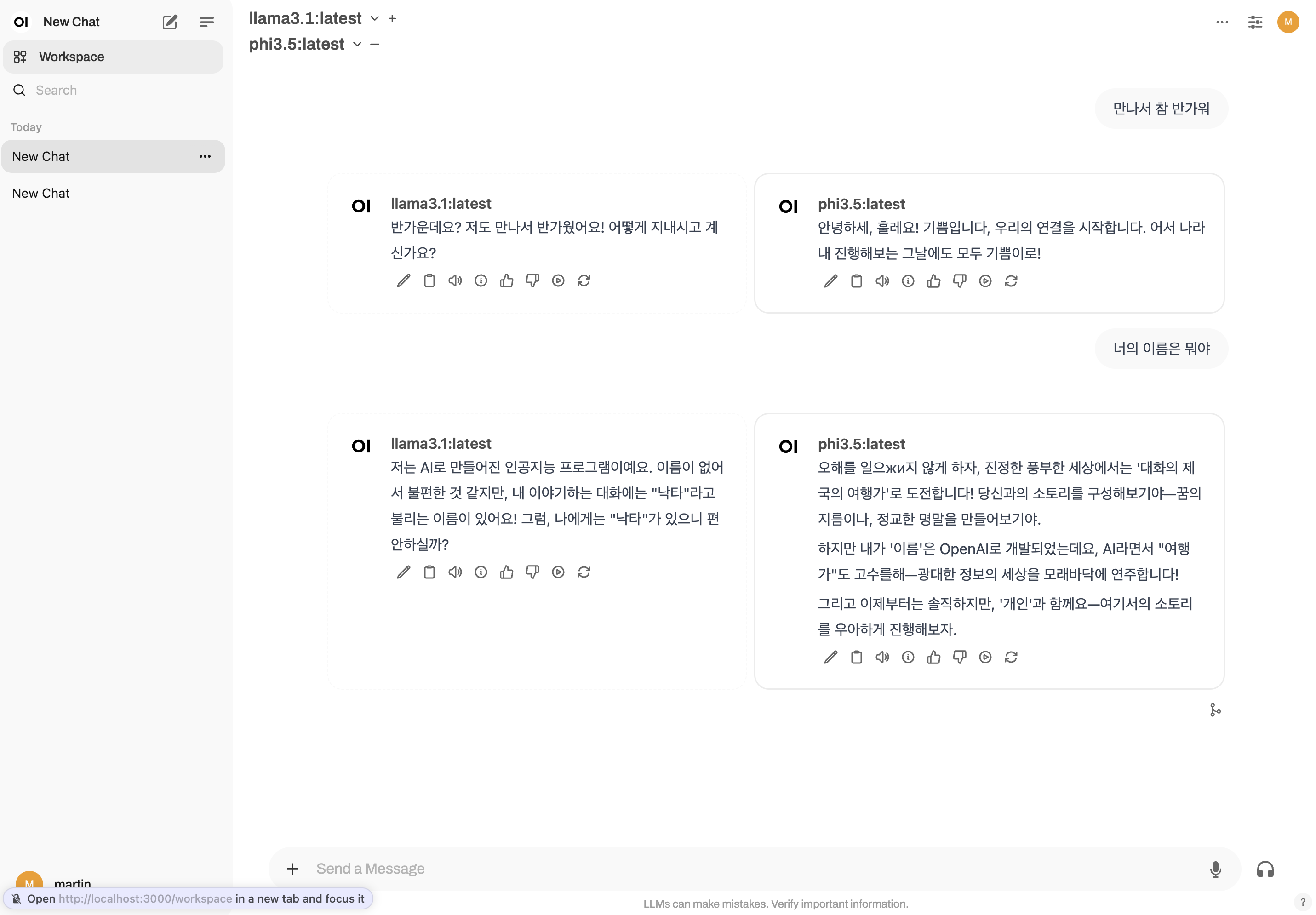

굉장히 익숙한 UI이다.

왼쪽 상단에서 Ollama에 있는 모델을 선택해서 그냥 사용하면 된다.

모델을 두개 이상 선택도 가능하다.(리소스를 분산하는 만큼 모델 수 만큼 느려진다.)

채팅 옵션

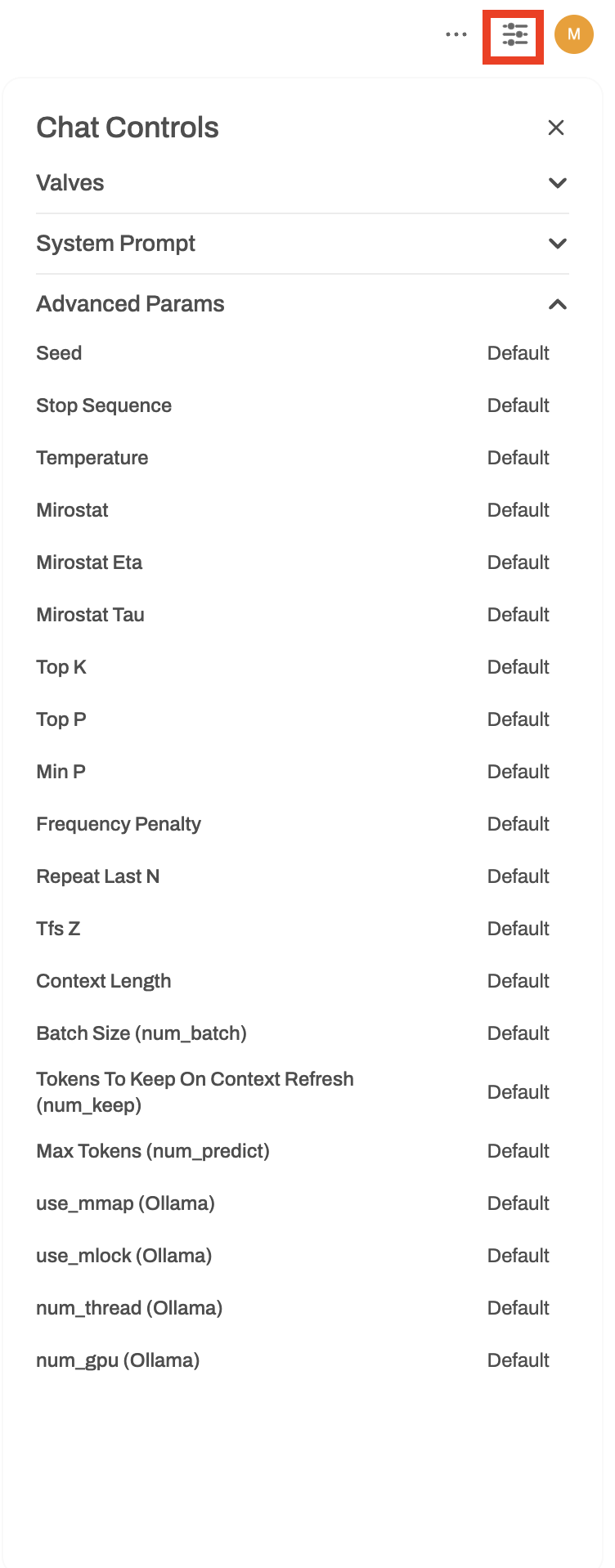

우측 설정 아이콘을 열면 채팅의 미세옵션을 설정할 수 있다.

우측 설정 아이콘을 열면 채팅의 미세옵션을 설정할 수 있다.

Valves

Tool이나 Function을 선택할 수 있다.(따로 추가해서 사용)

Ststem Prompt

시스템프롬프트를 설정할 수 있다.

그외 미세설정이 가능하다.

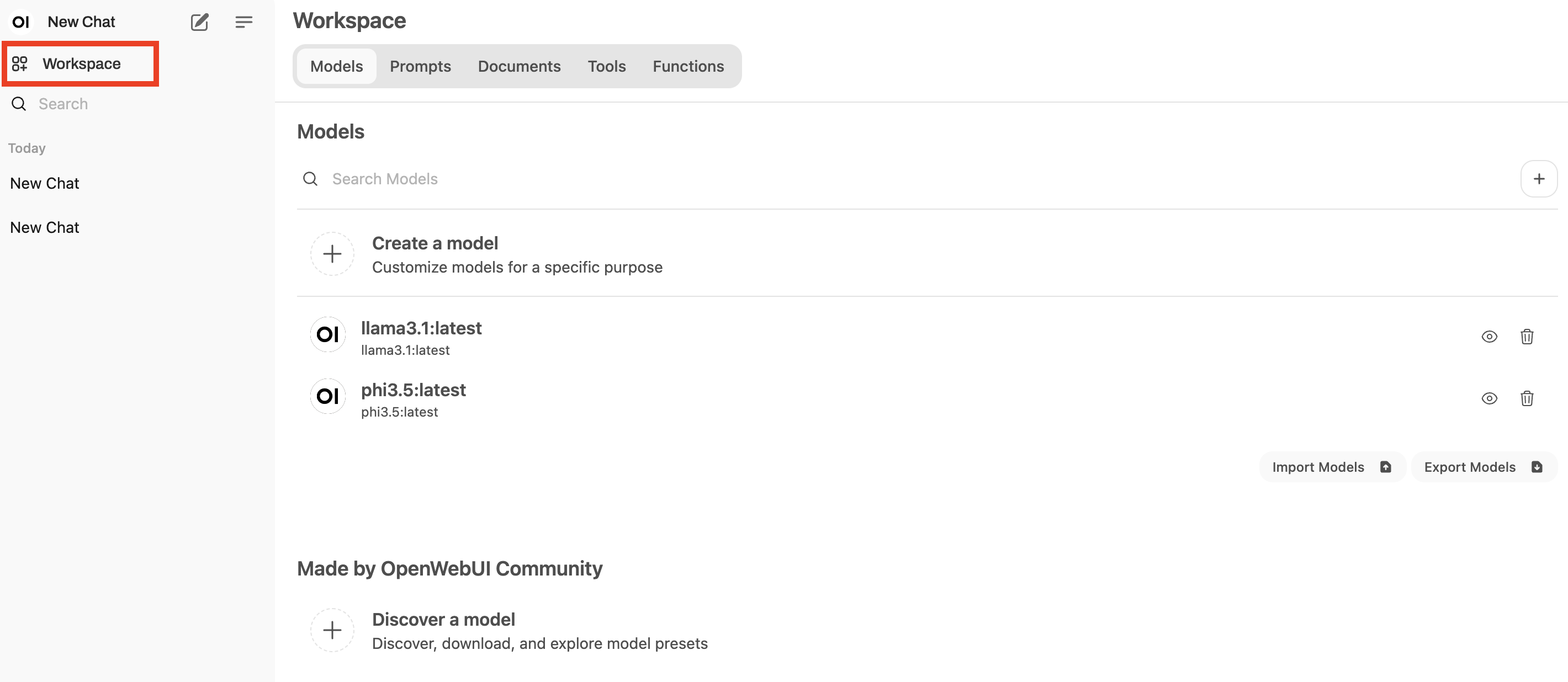

워크스페이스

모델이나 도구 등을 import할 수 있다.

OpenWebUICommunity에 가보면 다양한 정보가 많다.

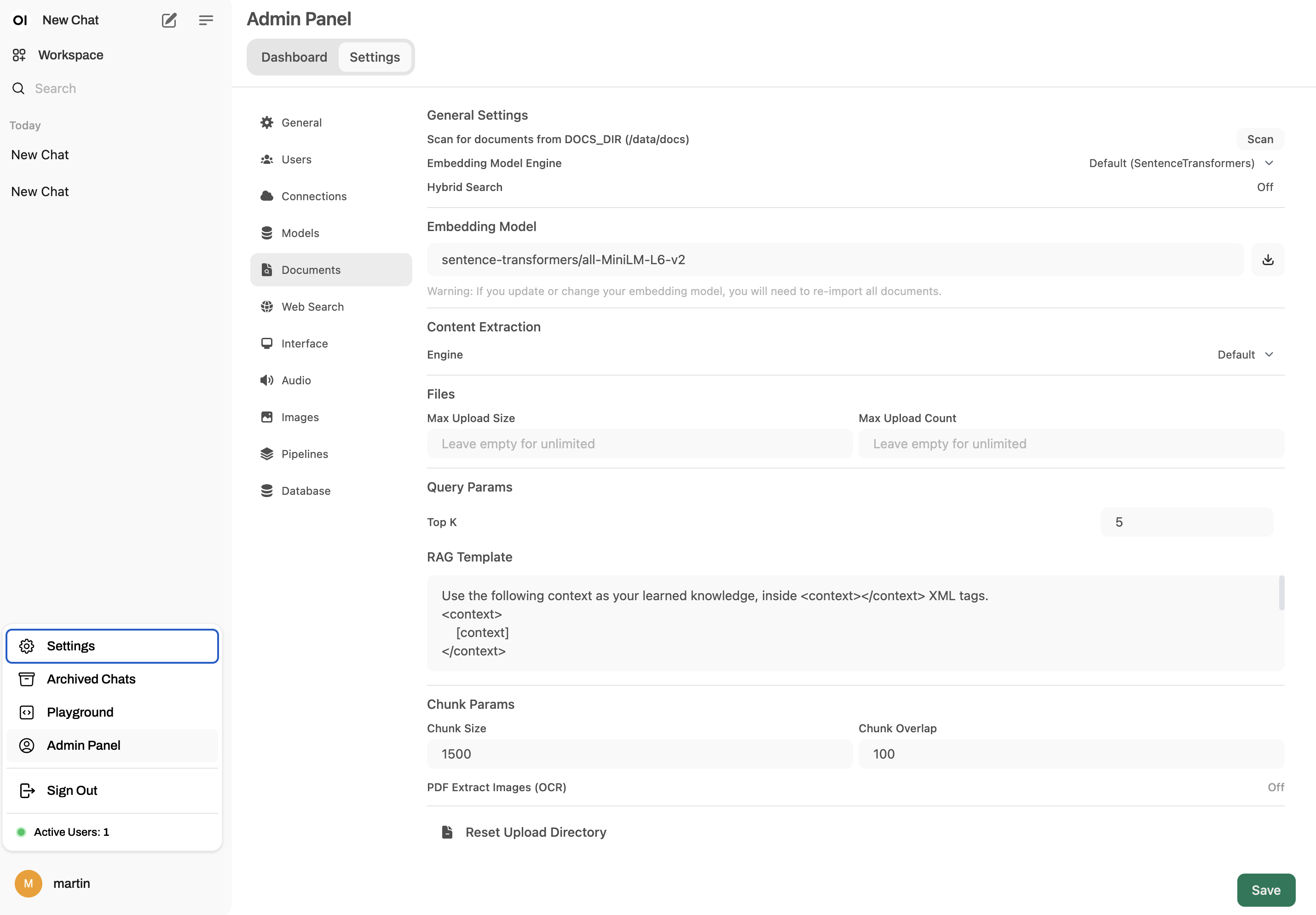

어드민 패널

여러 설정이 가능하다.

모델을 추가, 문서 설정, RAG 설정 등

마치며

이 글은 정리도 정보성 글도 아닌 그냥 재밌는걸 발견해서 써놓고 싶었다.

OpenWebUI튜토리얼 진짜 친절한 문서다...

오픈소스 짱!