딥러닝에서 어떻게 사용되는지 알아보자

- Gradient는 미분계수라고 생각하면 편하다.

- 미분계수를 기반으로한 최적화 문제

1. Case : Quadratic Functions

미분계수의 부호

- 함수 값을 최소화 ( argmin(f(x)) ) 시키기위해 가야할 방향을 말해준다.

- 미분 계수가 양수 -> 음수로 이동

- 미분 계수가 음수 -> 양수로 이동

문제점

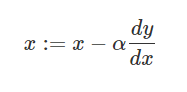

- 미분 계수를 그대로 사용하면 발산하게 된다.

y = x^2 에서 (1, 1) 지점의 미분 계수를 구한 후 위 공식에 대입하면 -1이

나오는데,

( 1, 1 ) 지점에서 ( -1, -1 )로 이동하게 된다. ( 1, 1 ) 지점에서

미분 계수가 0이 되는 곳으로 점차적 이동을 해야하는데 그러지 못하는 문제가 있다.

해결법

- 알파를 learning rate이라고 부른다.

- 알파 값은 1보다 작은 숫자다.