시작하기 전에!

이 문제는 TPU를 이용해서 성능 향상을 경험하는 것이 목표인 문제이다. 이런 목적이 있어서 Getting Started 노트북을 제공하고 나도 이것을 이용해서 풀었기 때문에, 제공되는 코드 초반의 데이터 읽어오기, 설정, 데이터 시각화와 관련된 부분은 생략하고 포스팅 하도록 하겠다.

혹여 이 문제를 해보고 싶을 때는 아래 링크에서 제공하는 코드를 같이 섞어서 이용해야 한다.

이 문제에서 배운 것

.tfrec파일 이용해보기- TPU v3-8를 이용한 학습 속도 향상

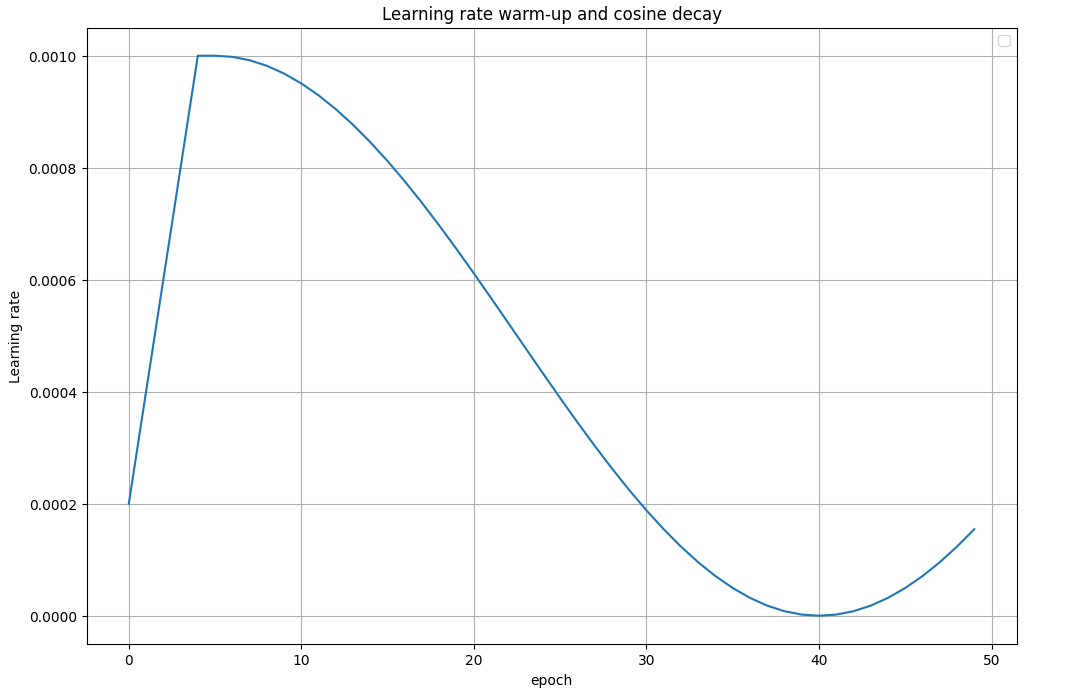

- Learning rate warm up과 decay를 이용한 성능 향상

- 여러 pre-trained 모델의 전이학습을 이용한 성능 향상

실습한 코드

Model

제공되는 코드에서 사용한 모델 대신에 VGG16, ResNet, DenseNet의 다양한 버전을 사용해봤다. 학습률과 같이 여러 시도를 했을 때, 아래 코드에서 이용한 ResNet152가 가장 좋은 성능을 보였다.

with strategy.scope():

#img_adjust_layer = tf.keras.layers.Lambda(lambda data: tf.keras.applications.xception.preprocess_input(tf.cast(data, tf.float32)), input_shape=[*IMAGE_SIZE, 3])

#pretrained_model = tf.keras.applications.Xception(weights='imagenet', include_top=False)

img_adjust_layer = tf.keras.layers.Lambda(lambda data: tf.keras.applications.resnet.preprocess_input(tf.cast(data, tf.float32)), input_shape=[*IMAGE_SIZE, 3])

pretrained_model = tf.keras.applications.ResNet152(weights='imagenet', include_top=False)

pretrained_model.trainable = False # False = transfer learning, True = fine-tuning

model = tf.keras.Sequential([

img_adjust_layer,

pretrained_model,

tf.keras.layers.GlobalAveragePooling2D(),

tf.keras.layers.Dense(len(CLASSES), activation='softmax')

])

model.compile(

optimizer='adam',

loss = 'sparse_categorical_crossentropy',

metrics=['sparse_categorical_accuracy'],

# NEW on TPU in TensorFlow 24: sending multiple batches to the TPU at once saves communications

# overheads and allows the XLA compiler to unroll the loop on TPU and optimize hardware utilization.

steps_per_execution=16

)

model.summary()Callback

학습률을 크게 설정하여 충분히 학습하되 과대 적합을 피하기 위해서 조기 종료를 사용하였다. 또한 학습률을 스케줄링 하여 보다 안정적으로 학습할 수 있도록 하였다. warm-up은 선형으로, decay는 cosine 형태로 이루어지게 하였다.

# 조기 종료

early_stopping = tf.keras.callbacks.EarlyStopping(patience=3, restore_best_weights=True)

# 학습률 스케줄링

init_lr = 0.001

warmup_epochs = 5

total_epochs = EPOCHS # EPOCHS=40

def scheduler(cur_epoch):

if cur_epoch < warmup_epochs:

return init_lr * (cur_epoch + 1) / warmup_epochs

else:

cos_decay = np.cos([(cur_epoch-5) / (total_epochs-warmup_epochs) * np.pi]) + 1

return init_lr * 0.5 * cos_decay[0]

lr_scheduler = tf.keras.callbacks.LearningRateScheduler(scheduler,verbose=1)

callbacks = [early_stopping, lr_scheduler]plt.figure(figsize=(12, 8))

plt.title("Learning rate warm-up and cosine decay")

plt.xlabel("epoch")

plt.ylabel("Learning rate")

plt.grid(True)

plt.plot(np.arange(50), [scheduler(e) for e in range(50)])

plt.legend(loc='best')

plt.show()

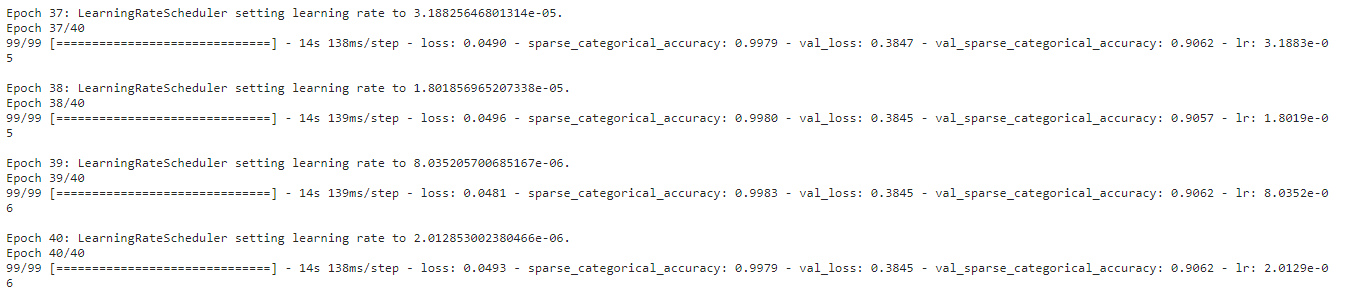

Training

history = model.fit(get_training_dataset(), steps_per_epoch=STEPS_PER_EPOCH, epochs=EPOCHS,

validation_data=get_validation_dataset(), validation_steps=VALIDATION_STEPS,

callbacks=callbacks)

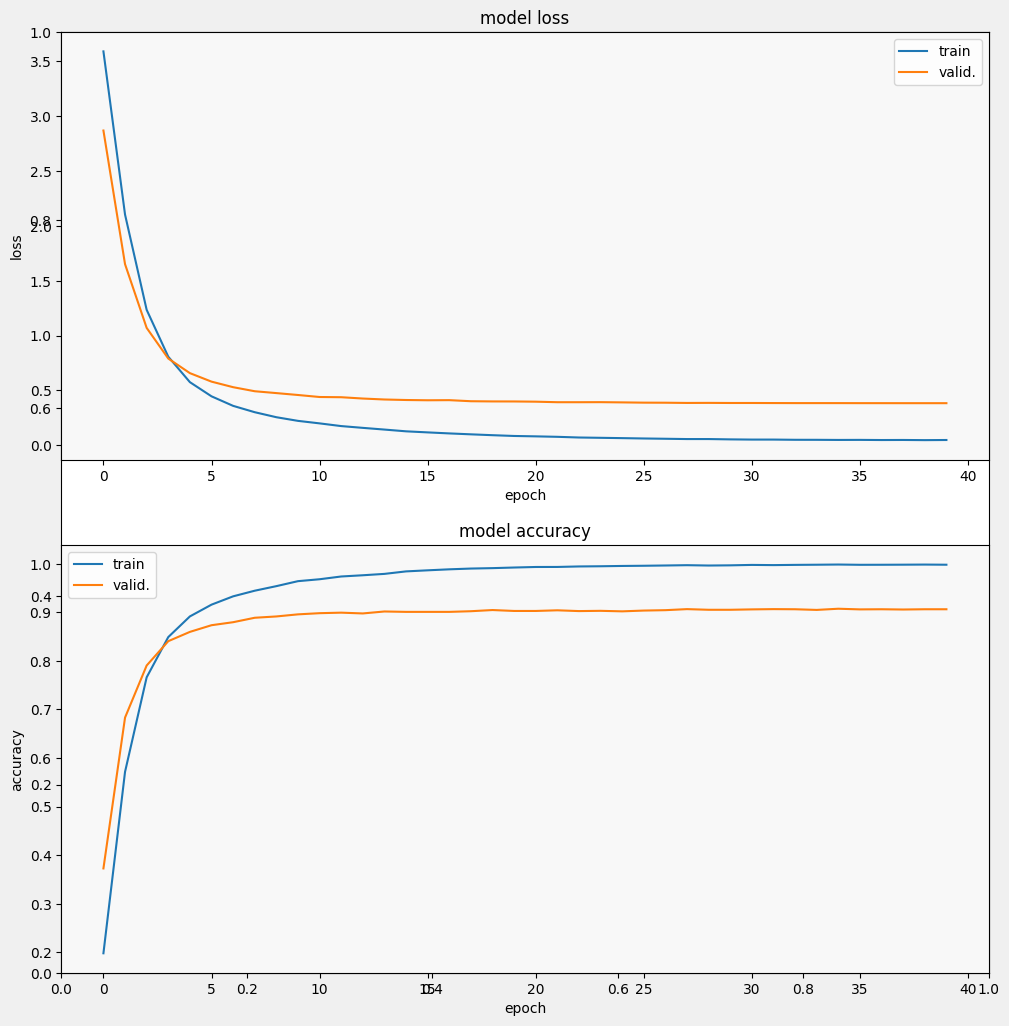

display_training_curves(history.history['loss'], history.history['val_loss'], 'loss', 211)

display_training_curves(history.history['sparse_categorical_accuracy'], history.history['val_sparse_categorical_accuracy'], 'accuracy', 212)

- f1_score: 0.900

- precision: 0.931

- recall: 0.885

getting started 노트북에서 예시 코드로 올라온 것은 f1 score가 0.851, precision 0.885, recall 0.835이였던 것을 고려하면 성능이 소폭 상향된 걸 알 수 있다.