안녕하세요. 🥸 민 입니다 ! 요즘 파이썬을 하고있는데 파이썬의 장점이 뭐라고 생각하시나요 ?? 파이썬의 특징에서도 말씀드렸지만 다양한 분야에 사용된다는 장점이 존재합니다. 그 다양한 분야에 해당하는 이번에는 웹 스크래핑, 크롤링 기능에 대해서 설명해드리려고 글을 작성하게 되었습니다 !

이제 확인하러 가시죠 ! 😤

목차

0. 크롤링을 이해하기 위해 알아야 할 것

1.크롤링이란 vs 웹 스크래핑?

2.크롤링의 장점

3.크롤링의 단점

여러분은 크롤링에 대해서 알고 계신가요 ?? 🤔 처음에 저는 설명을 들었을 때 번거롭게 찾고싶은 정보를 직접 복사, 붙여넣기를 통해서 가져오는 것이 아닌 크롤링의 자동화로 인해서 정보에 대한 문제를 해결할 수 있다고 들었습니다.

즉 시간을 줄이고 자신의 일에 더 많은 시간을 투자할 수 있는 것이죠 !

💁♂️ 0. 크롤링을 알기 위해서

저희가 크롤링을 알기 위해서는 먼저 웹 페이지의 구조를 알아야 합니다 .

그 이유는 ?? -> 크롤링으로 원하는 내용을 가져오는 방법은 웹 페이지에 존재하는

태그를 찾아서 데이터를 찾는 것 인데요.

그렇다면 이제 데이터를 감싸고 있는 태그를 찾는 방법이 궁금하실 겁니다 . 따라 오시죠 !!

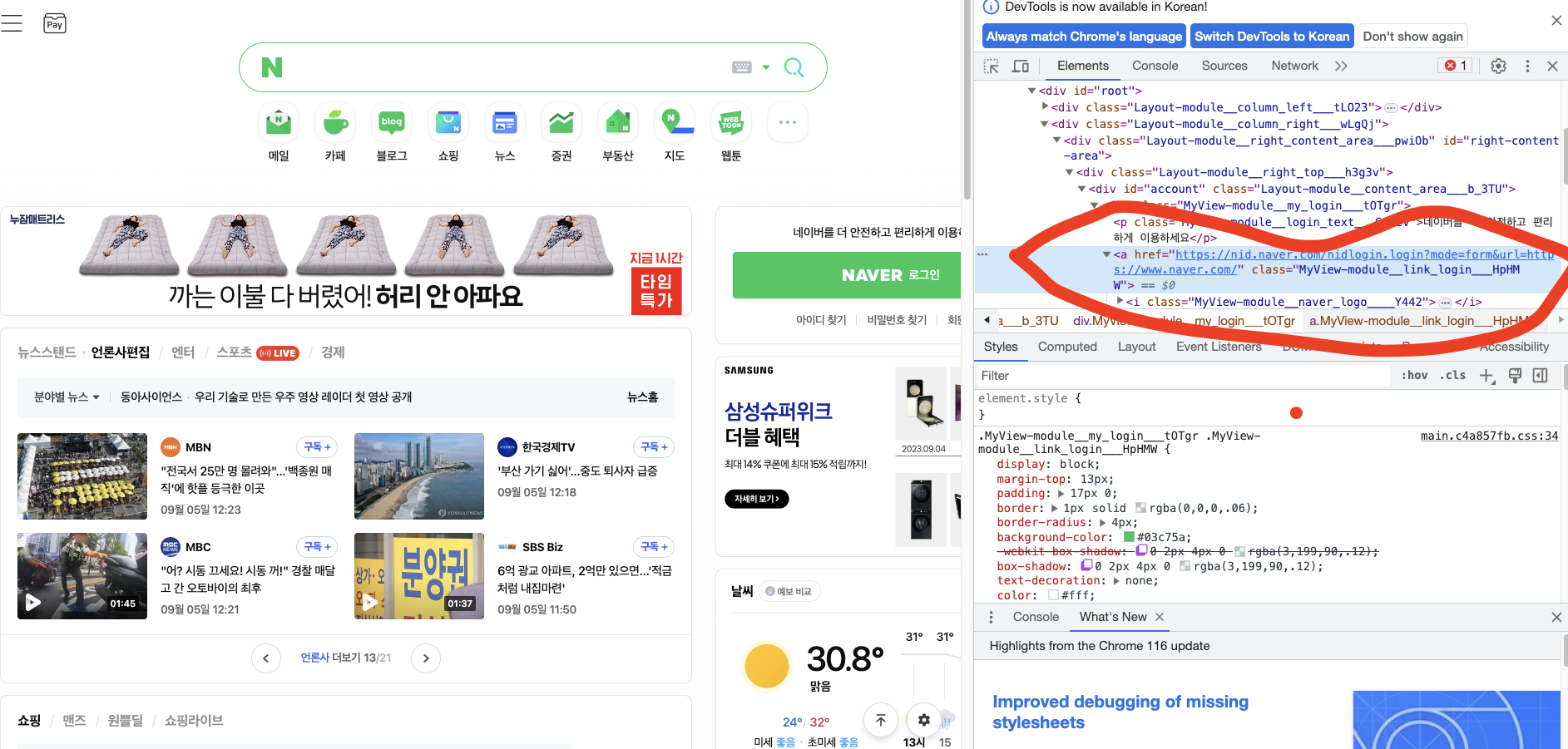

1.우선 네이버<-여기눌러주세요 에 들어가주시고요.

2.개발자도구에 들어가줍니다. 개발자 도구 단축키 보러가기

3.화살표 버튼을 눌러준다.

4.가져오고 싶은 정보를 클릭해준다

해당하는 정보에 대한 태그를 확인했다면 이제 크롤링을 가져올 준비가 모두 끝났습니다 !!

💁♂️ 1. 웹 스크래핑과 웹 크롤링

누군가 당신에게 파이썬을 이용해서 대표적으로 무엇을 할 수 있냐고 물으면

당신은 크게 2가지가 존재한다고 대답하시면 됩니다.

바로 크롤링과 데이터분석이죠 그만큼 크롤링이 파이썬에서 대표적으로 이용하고 있는 기술입니다 !!

크롤링과(crawling)와 스크래핑(scrapping)이란 웹 페이지에 있는

데이터들을 프로그래밍을 이용하여 추출하는 것을 의미합니다.

크롤링을 왜 사용하는 걸까요 ? 🤔

인터넷에 존재하는 많은 양의 정보를 하나씩 복사, 붙여넣기로 가져온다는 것은

매우 많은 시간과 오류를 발생할 수 있습니다. 그리하여 웹 페이지 , 웹 문서등을 자동으로 탐색해주는 컴퓨터 프로그램, 웹 크롤러가 만들어지게(Crawler)를 만들게 되었는데요

하지만, 크롤링(Crawling)과 스크래핑(Scraping)의 차이도 존재합니다.

웹 페이지의 정보를 긁어온다는 점은 동일하기 때문에 둘을 혼동해서 사용하는 경우가 있는데요

이번 게시물에서는 크롤링위주의 설명이기 때문에 크롤링에 대해서 조금 더 들어가보고

크롤링과 스크래핑의 차이점정도만 다룰 것 입니다.

크롤링은 개인 혹은 단체에서 필요한 데이터가 있는 웹(Web)페이지의 구조를 분석하고 파악하여 긁어옵니다. 여기서 긁어온다는 의미는 모두 그대로 가져오는 것을 말합니다. 이것은 데이터를 추출한다로 설명할 수 있으며 크롤링이라는 행위를 하는 소프트웨어(혹은 프로그램)를 크롤러(Crawler)라고 부릅니다.

핵심 !

크롤링은 웹 사이트에서 태그를 이용하여 프로그래밍적으로 데이터를 가져온다.

크롤링과 스크래핑은 웹 페이지의 정보를 가져온다는 점에서 동일하지만 같지는 않다 .

웹 크롤링과 웹 스크래핑의 차이점

크롤링과 스크래핑은 ‘원하는 데이터를 모을 수 있다’는 점이 비슷하여 의미가 자주 혼용되곤 합니다. 또한 기술적으로 함께 사용되는 경우가 많아 더욱 헷갈립니다.

하지만 둘의 차이점이 존재 하는데요

이번 블로그에서는 둘의 차이점을 간략하게만 설명 할 예정이기 때문에 차이점만 암기해주시면 됩니다.

웹 크롤링 -> 웹 페이지의 링크를 타고 계속해서 탐색, 사용자가 찾는 정보와 연관된 링크

웹 스크래핑 -> 특정 웹 사이트 탐색 , 상품의 가격, 주식 정보, 뉴스 등 원하는 데이터가 명확, 흩어져있는 데이터를 자동으로 추출

2. 크롤링의 장점

모든 데이터를 긁어 모으기 때문에 확장성이 넓다는 장점이 존재한다 .

--

✔ 정적 크롤링-정적인 데이터를 수집

장점: 수집속도가 빠르다.

단점: 수집대상에 한계가 있다.

✔ 동적 크롤링-동적인 데이터를 수집

장점: 수집대상에 한계가 없다.

단점: 수집속도가 느리다.

3. 크롤링의 단점

모든 데이터를 가져오기 때문에 서버의 자리를 많이 차지한다는 단점이 존재합니다

4. 결론

이렇게 크롤링은 웹 사이트의 정보를 가져올 수 있고 그로 인해 저희가 반복해야 할 일들을 모두 줄어드는 것이죠. 다음시간에는 크롤링을 사용해서 스포츠사이트를 분석한 이후에 정보를 csv, json 파일의 형식으로 저장해보는 시간을 가지겠습니다 !! .