Ask Me Anything: A simple strategy for prompting language models

ICLR 2023 notable top 25%

분야 및 배경지식

- in-context learning

- 사용자가 제공한 태스크에 대한 자연어 설명 혹은 프롬프트를 활용하여 언어모델로부터 원하는 결과를 도출하는 방식

- prompt aggregation (프롬프트 종합)

- 여러 개의 프롬프트를 결합하여 사용함으로써 성능을 높이고자 하는 방법. 어떤 종류의 프롬프트를 선택하느냐에 따라 다른 결과를 야기

- weak supervision (약지도)

- 노이즈가 존재하는 여러 데이터로부터 정확도와 상관관계를 학습하고 이를 결합하여 학습 데이터를 위한 약한 레이블(정답)을 생성하는 방식

문제

- 프롬프트의 작은 변화가 성능에 큰 영향을 미침 (huge performance variation)

- 각 태스크에 대한 완벽한 프롬프트를 만든다는 것은 굉장히 어려움 (not task-agnostic)

- 또한 언어모델의 종류나 모델 크기에 따라 프롬프트의 성능이 달라짐 (not model-agnostic)

해결책

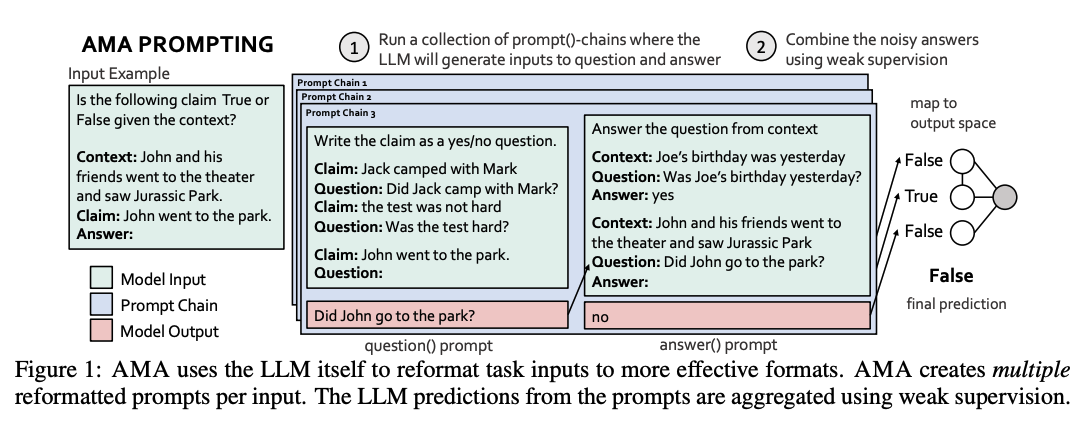

AMA (Ask Me Anything Prompting)

- 여러 개의 불완전한(imperfect) 프롬프트를 이용해 신뢰성을 높일 수 있는 방향으로 프롬프트의 결과를 종합하는 프롬프팅 방식

1. 효과적인 프롬프트 (effectiveness)

- 프롬프트의 다양한 형태 중 모델의 결과를 특정한 토큰으로 제한하지 않고 열린 정답을 가능하게 하는 프롬프트가 더욱 효과적

- e.g. "존은 공원에 갔다. 사실인가 아닌가?" <<< "존이 어디에 갔는가?"

- 이는 실제 사전학습 데이터에서 open-ended 형태가 restrictive보다 더 자주 등장하며 (약 1000배), 사전학습 시 존재한 클래스 사이의 불균형으로 인한 생긴 편견(bias) 때문인 것으로 보임

- 특별한 아웃풋 클래스(e.g. 선다형 분류)를 가진 경우 정답을 매핑해주면 더욱 효과적

2. 확장 가능한 수집 (scalability)

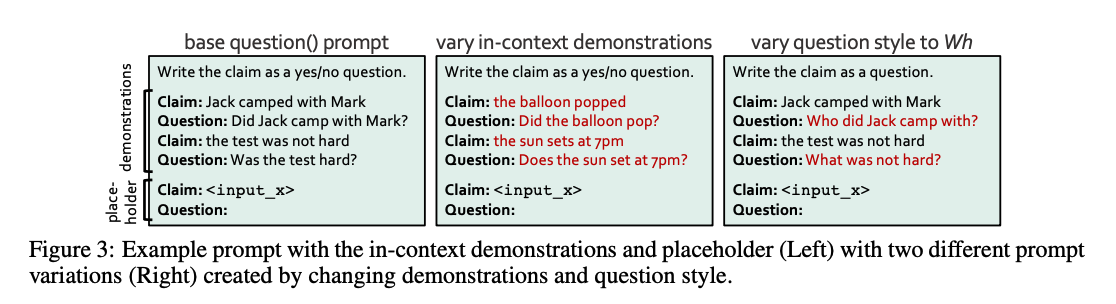

- 언어모델을 활용하여 데이터셋을 효과적인 프롬프트 형태로 재구성

- question(), answer()로 이루어진 prompt()-chain을 이용해 생성

3. 프롬프트 종합 (aggregation)

- 기존의 MV(majority vote; 다수결)와 같은 단순한 방식은 효과적이지 않음

- 약한 지도(weak supervision)를 활용하여 프롬프트들 사이의 의존성을 고려해 프롬프트로부터 얻은 예측결과를 결합

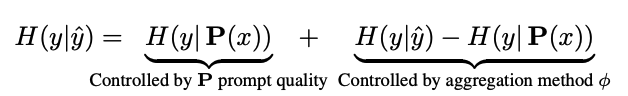

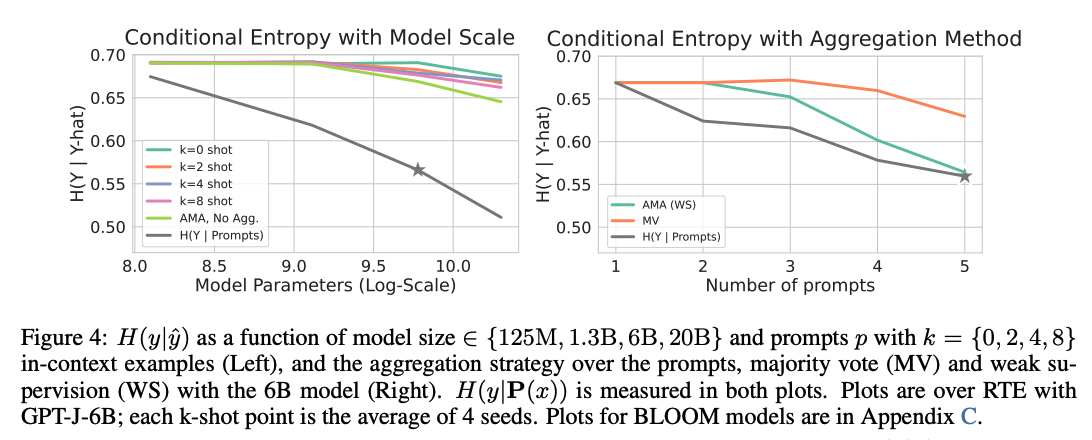

- H(y|y_hat)은 y_hat이 y와 연관성있는 정보를 갖고 있을 때 낮음

- 왼쪽 그래프를 통해 볼 수 있듯 AMA는 개별 프롬프트에서 k-shot 베이스라인의 성능을 뛰어넘음

- 오른쪽 그래프를 통해서 볼 수 있듯 AMA가 MV 대비 종합 시 정보손실을 감소시킴

평가

- 데이터셋

- 20개 데이터셋 (NLU, NLI, Classification, Question Answering)

- 모델

- Neo, BLOOM, OPT, T0 계열에서 14개의 다양한 크기, 종류의 모델

의의

- 약 30배 정도 적은 파라미터를 가진 모델로 하여금 GPT3-175B few-shot의 성능과 필적하거나 뛰어넘도록 함

- 20개중 15개의 벤치마크에서 6B 파라미터를 가진 모델이 GPT3-175B 모델의 few-shot 성능을 뛰어넘음

한계

- 필요한 지식이 태스크 인풋에 제공될 때 더 높은 성능 향상을 보이나, 그렇지 않은 경우와 태스크가 잠재 지식에 의존할 수 없을 때 (e.g. temporal knowledge or domain knowledge) 한계 존재