AutoGuide: Automated Generation and Selection of State-Aware Guidelines for Large Language Model Agents (link, arXiv 2024)

배경지식

- LLM (Large Language Model)

- 거대언어모델

- 잘 알려진 LLM으로는 GPT-4, Claude-3, Cohere-command-r 등이 있음

- Agent

- 최근 LLM은 단순히 응답을 생성하는 것이 아니라, 다양한 일련의 의사결정을 바탕으로 복잡한 질문도 처리할 수 있음

- 이렇듯 LLM을 계획, 관찰(observation), 추론(reasoning), 행동(action), 도구(tool) 사용 등을 통해 사용성을 확장한 형태를 Agent라고 칭함

- 과거의 경험을 기반으로 스스로 반추하며 셀프 피드백을 바탕으로 행동을 업데이트하기도 함

문제

- LLM 기반 Agent의 한계

- 사전학습된 LLM이 특정 도메인에서 충분한 지식을 갖지 못할 때 문제 발생

- 데이터에서 필요한 정보를 효과적으로 추출하는 것에 대한 어려움

- 전통적인 방법론은 모든 가능한 정보를 에이전트에게 제공 (e.g. in-context learning)

- 컨텍스트 길이 제한, 프롬프트 민감성, 복잡한 추론의 어려움 등의 한계 존재

해결책

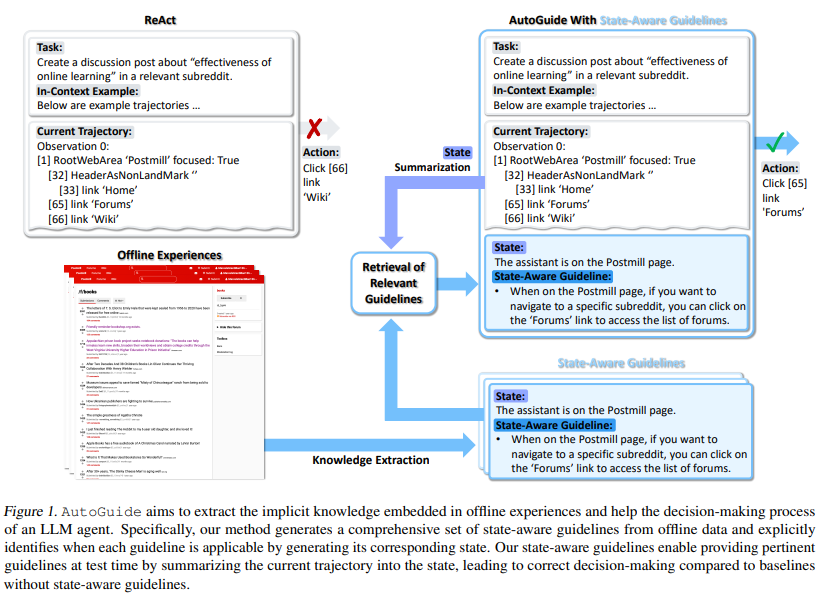

AutoGuide

- 오프라인 경험에서의 내재적 지식을 이용하여 사전학습 LLM의 지식 차이(gap)를 보완하는 방법

- data-driven strategies that leverage offline experiences to bridge knowledge gaps between pre-trained LLMs and a downstream domain

1. 문제 정의

- 오프라인 데이터란, 학습에 사용되는 데이터셋을 의미

- 데이터는 학습 태스크로부터 얻은 N개의 궤적(trajectory)으로 이루어짐

- 실시간으로 변하는 온라인 데이터와 다르게 고정된 데이터로 이해할 수 있음

- 궤적이란, 마르코브 결정 절차(Markov decision process)를 따르는 일련의 관찰(observation), 행동(action), 보상(reward)을 의미

2. 가이드라인 추출을 위한 데이터셋 구축

- 동일한 태스크에 대해 성공 궤적과 실패 궤적을 하나의 쌍으로 상정

3. 상태 인식(state-aware) 가이드라인 추출

state summarization module

- 성공 궤적과 실패 궤적이 주어졌을 때, 두 궤적이 달라지기 시작하는 부분까지의 궤적을 상정

- 해당 궤적을 타겟 궤적이라고 명명

- LLM이 타겟 궤적을 요약하도록 함

- 요약한 내용 = 상태(state)

guideline extraction module

- 성공 궤적, 실패 궤적을 모두 고려해 상태에 대응되는 바람직한 가이드라인을 추출

- 자연어로 이루어진 가이드라인을 추출

state-aware guideline 구축

- 상태를 key로, 대응하는 가이드라인들을 value로 하는 사전(dictionary)을 구축

4. 테스트 시에 상태 인식 가이드라인 적용

- AutoGuide가 현재 궤적을 상태(state)로 요약

- LLM으로 하여금 대응하는 가이드라인을 탐색하고 회수하도록 함

- 만약 선택된 가이드라인이 k개 이상이면, top-k만 선택하도록 함

평가

- 평가 데이터셋 (의사결정 벤치마크)

- ALFWorld

- WebShop

- WebArena

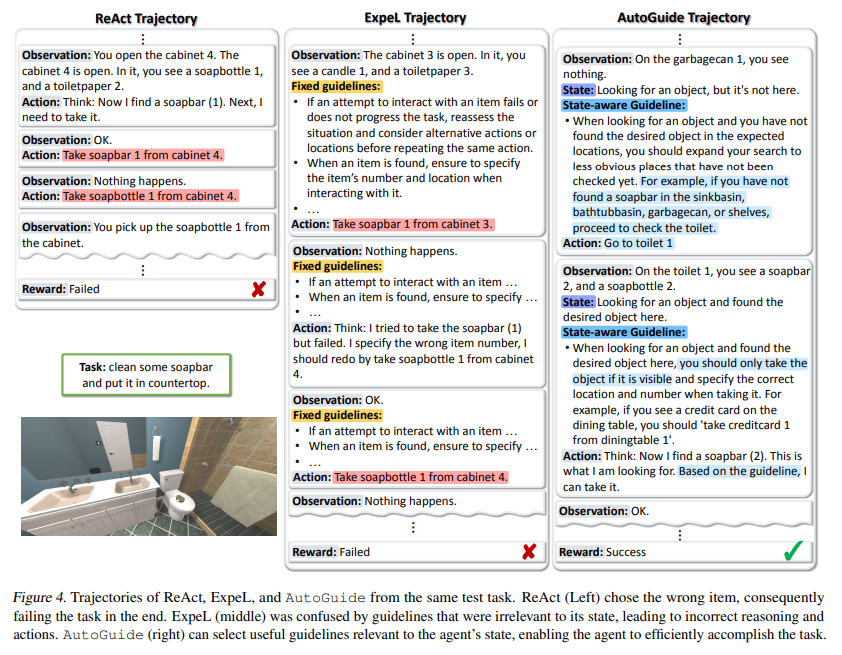

- 비교 대상

- ReAct

- ExpeL

- Relfexion

의의

- LLM에게 연관성이 높은 정보만을 전달함으로써 더욱 뛰어난 결과를 얻을 수 있었음