들어가며

- Cross-entropy와 KL-divergence는 확률분포가 하나 이상 존재하고 서로 얼마나 공평한지(fair with) 비교하기 위해 사용

- KL-divergence 대신에 Cross-entropy를 최소화하는 것이 동일한 결과를 야기

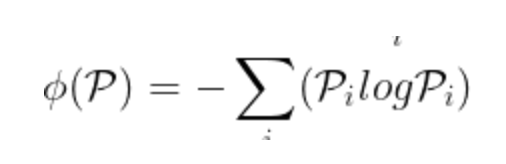

엔트로피

- 시스템의 불확실성을 측정하는 지표

- 직관적으로 이해했을 때, 시스템으로부터의 불확실성을 제거하기 위해 필요한 정보량

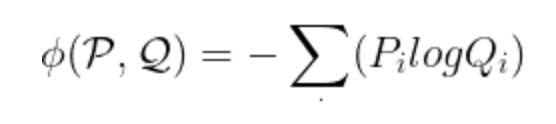

크로스엔트로피(Cross-Entropy)

- 두 확률분포 사이에 존재하는 정보량을 의미

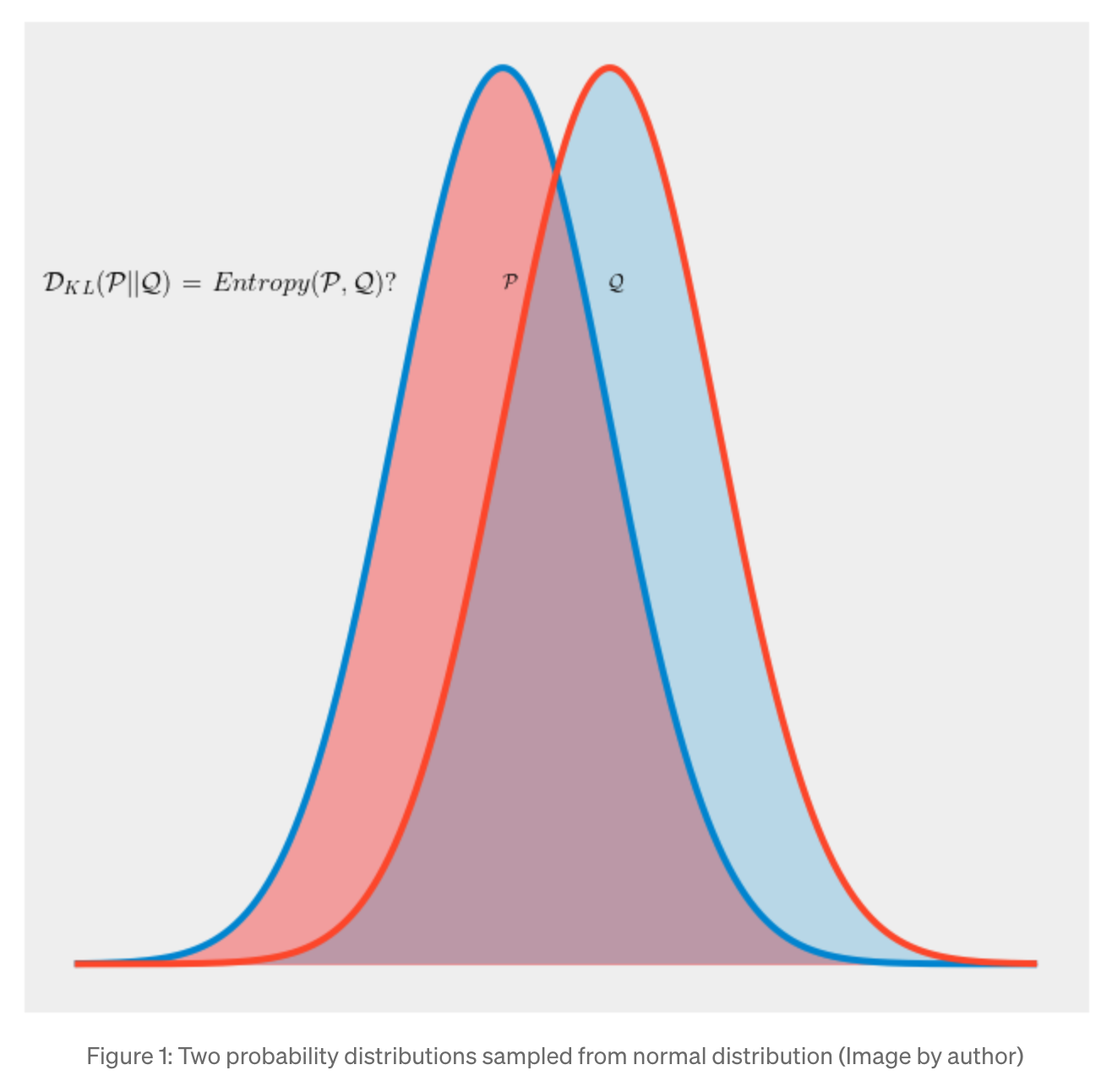

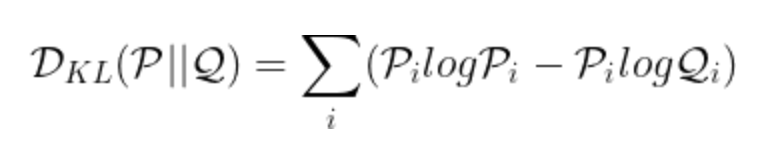

KL-divergence

- 두 확률분포 사이의 divergence는 둘 사이에 존재하는 거리를 측정

- PlogP 형태는 분포 p의 엔트로피를 나타냄

- PlogQ 형태는 p에 대한 분포 q의 기댓값(expectation of distribution q in terms of p)을 표현

- 실제 응용에서 p는 실제 데이터/측정을 나타내며 q는 가설에 기초한(hypothetical) 분포를 나타냄

- GAN의 경우, p는 실제 이미지의 확률분포이며 q는 가짜 이미지의 확률분포

검증

- cross-entropy == KL-divergence + entropy of p

- 분포 p의 엔트로피는 constant, 즉 상수로 취급 가능하므로, cross entropy를 최소화하는 것이 KL-divergence를 최소화하는 것과 유사해짐

- 모든 머신러닝 최적화는 실험동안 변하지 않는 controlled dataset에 대하여 진행되기 때문에, p의 entropy가 상수라고 가정할 수 있음

관련 링크 (link)