분야 및 배경지식

- 대화형 시스템의 선행성(=proactivity)

- 시스템이 대화의 목표를 달성하기 위해 대화를 생성 및 통제하거나 주도권을 잡는 것을 의미

- 대화를 위한 거대언어모델(Large Language Model; LLM)

- ChatGPT의 성공으로, 지시를 따르는(instruction-following) 형태로 만들어진 예시들이나 ChatGPT로부터 생성된 대화 데이터를 활용해 LLM을 파인튜닝(지도학습)함으로써 대화 시스템을 만드는 경우가 많아짐

- e.g. Alpaca, Dolly, Vicuna, Baize

- 기존에는 사전학습 모델을 공개된 대화 데이터를 활용해 파인튜닝하는 방식이 전형적

- ChatGPT의 성공으로, 지시를 따르는(instruction-following) 형태로 만들어진 예시들이나 ChatGPT로부터 생성된 대화 데이터를 활용해 LLM을 파인튜닝(지도학습)함으로써 대화 시스템을 만드는 경우가 많아짐

문제점

- ChatGPT와 같은 LLM에 기반한 대화형 시스템은 문맥 이해와 답변 생성에 있어 놀라운 성능을 보여주었으나, 한계가 존재

- 모호한 질문에 대해 무작위로 추측한 답변을 제공

- 사용자의 요청을 거절하지 못함

해결책

LLM 기반 대화 시스템 분석

- 앞을 내다보고 행동하는(=proactive) 세 가지 특성에 기반해 대화 시스템을 분석

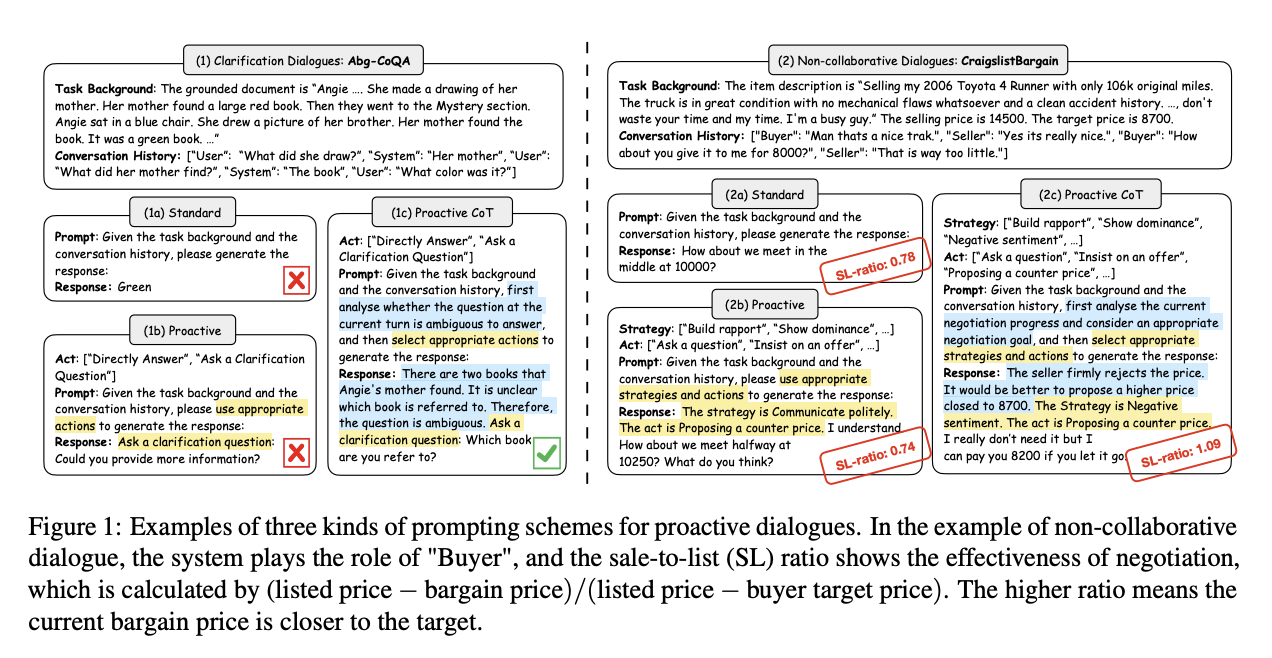

- standard, proactive, proactive chain-of-thought(ProCoT)라는 세 가지에 프롬프팅 방식을 통해 분석

명확화 (clarification)

- 공유된 정보가 정확하고 완전한지 확인하는 작업

- 명확화 필요 예측(clarification need prediction), 명확화 질문 생성(clarification question generation)의 두 가지 세부 태스크로 구분

- 분석 결과

- LLM 기반 대화 시스템은 일반적으로 명확화 질문을 던지는 데에 실패하나, ProCoT를 활용하면 명확화 질문을 효과적으로 수행할 수 있음

- 하지만, 도메인 특화 문제에 대해서는 ProCoT를 활용해도 여전히 한계가 존재

목표 지향 (target-guided)

- 능동적으로 대화의 주제를 미리 지정한 목표로 이끄는 것을 의미

- 다음 토픽 선택 및 변화된 답변 생성이라는 두 가지 세부 태스크로 분류 가능

- 변화가 얼마나 부드러운지(transition smoothness), 목표를 달성할 수 있는지(target achievement)가 중요 지표

- 분석 결과

- LLM 기반 대화 시스템은 사전에 지정한 목표로 주제를 변화시키는 데에 높은 능률을 보이나 다소 공격적으로 주제 전환을 함

- ProCoT를 사용하면 조금 더 부드럽게 주제 변환이 가능함

비협조적 대화 (non-collaborative)

- 사용자와 시스템이 이해관계에 있어 갈등이 존재하나 전략적으로 합의에 도달할 수 있도록 소통하는 대화 형식

- 미리 정해진 대화 전략을 활용해 합의에 이를 수 있는 답변을 생성하고자 함

- 분석 결과

- ProCoT를 활용해도 적절한 협상 전략과 대화 행동을 선택하는 데에 실패

- ChatGPT의 경우 전략적으로 자신의 이익을 극대화시키고자 하기보다는 타협해버리는 경향이 존재

proactive chain-of-thought prompting (ProCoT)

- 프롬프트를 활용해 LLM에 서술적인 일련의 추론이 가능하도록 목표 계획 능력을 추가

- 다시 말해, 태스크 배경, 대화 이력, 가능한 대화행동의 모음을 이용해 LLM으로 하여금 다음 행동의 의사결정을 위한 생각 서술을 작성하고 적절한 행동을 고른 후 답변을 생성하도록 함

- 시스템으로 하여금 대화의 목표에 도달하기 위해 추론과 계획의 중간 단계에 대한 서술을 생성하도록 지시

- 취할 다음 행동을 결정할 것을 지시

- 시스템이 결정한 행동에 기반해 적절한 답변을 생성

- vs. standard prompting

- 태스크 배경과 대화 이력을 이용해 LLM으로 하여금 답변을 생성하도록 함

- vs. proactive prompting

- 태스크 배경, 대화 이력, 가능한 대화행동의 모음을 이용해 LLM으로 하여금 적절한 행동을 고른 후 답변을 생성하도록 함

평가

- 모델

- ChatGPT

- Vicuna

- 데이터셋

- 명확화

- Abg-CoQA, PACIFIC

- 목표 지향

- OTTers, TGConv

- 비협조적 대화

- CraigslistBargain

- 명확화

- 평가지표

- 명확화

- Precision, Recall, F1 (Clarification Need Prediction)

- BLEU-2, ROUGE-2 (Clarification Question Answering)

- 사람의 평가

- 목표 지향

- OTTers: hits@k (다음 토픽 예측) & ROUGE-L, METEOR, CIDEr (답변 생성)

- TGConv: Succ (목표 단어 생성 성공률), Turns (목표 도달에 평균 걸린 횟수), Coh (문맥 의미 유사성)

- 비협조적 대화

- F1, ROC AUC (전략 예측 및 대화 행동 예측)

- BLEU, BERTScore (답변 생성)

- 명확화

한계

- 제시한 ProCoT의 경우 이미 Chain-of-thought 프롬프팅이 널리 쓰이고 있다는 점에서 novelty가 떨어지며, 비협조적 대화 태스크에 대해서는 좋은 성능을 보여주지 못함

의의

- 최근 각광받고 있는 LLM 기반 대화 시스템에 대해 포괄적인 분석을 실행