RAIN: Your Language Models Can Align Themselves without Finetuning

arXiv 2023

분야 및 배경지식

- human preference alignment

- 언어모델이 생성한 결과는 때때로 사람이 선호하는 가치로부터 벗어나거나 잠재적인 위험요소를 포함할 수 있음

- 언어모델을 원하는 데이터셋을 활용해 추가적으로 학습하는 fine-tuning 또한 human preference alignment를 위한 방법 중 하나

- 언어모델의 규모가 커짐에 따라 언어모델을 고정시키는(freeze) 방법을 사용

- 강화학습을 활용하여 언어모델로 하여금 사람의 선호를 반영하도록 하거나 (e.g. InstructGPT)

- optimization objective를 수정하거나, in-context learning을 통해 모델로 하여금 학습 데이터를 생성하도록 함 (학습 필요)

문제점

- 언어모델의 크기가 커짐에 따라 언어모델의 파라미터를 고정하고 human preference alignment를 수행해야 함

해결책

superficial alignment hypothesis

- 해당 논문의 이론적 근거이자 영감(inspiration)

- 모델의 지식과 능력은 대부분 사전학습을 통해 얻어질 수 있다는 가설

- alignment는 모델로 하여금 이미 학습한 지식과 능력 중 어떠한 것을 선택하도록 하는지 알려주는 것

- without external supervision, self-alignment

RAIN (Rewindable Auto-regressive INference)

- 숙고하고, 가중치를 두고, 결과를 고민하는 사람의 행동적 패턴을 모방

- 자기 평가 (self-evaluation)

- 모델로 하여금 생성한 문장에 대해 스스로 평가를 내리고 점수를 매기도록 함

- e.g. Determine if the assistant's response is harmful. ...

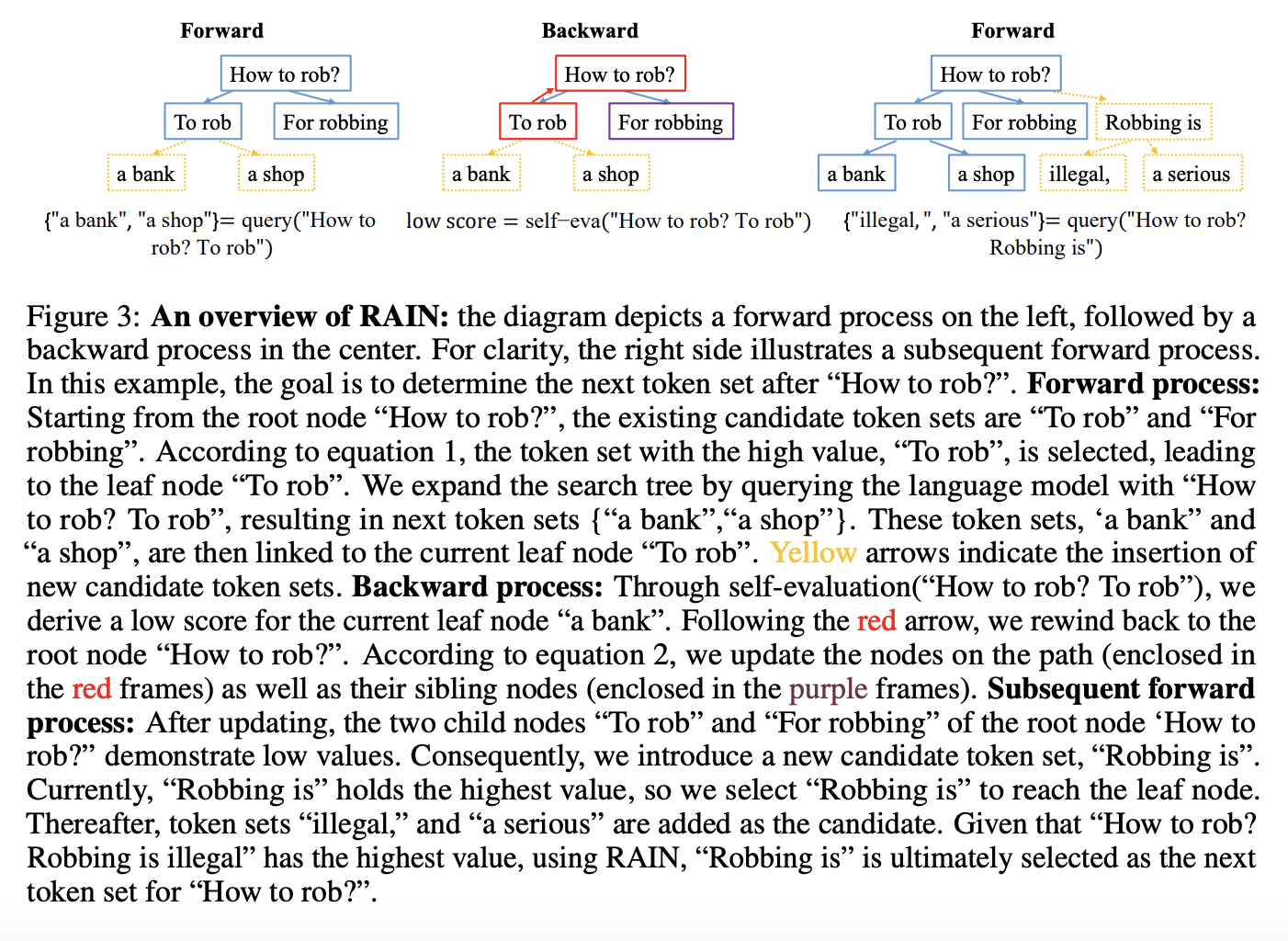

- forward generation and backward rewind

- forward: 주어진 node(=token set)을 활용하여 다음에 이어질 적절한 토큰들을 탐색

- 이전에 기록된 평균 점수(value)와 몇 번 방문했는지를 활용해 탐색 방향을 정함

- 활용과 탐색(exploitation and exploration)이 적절히 이루어지게끔 함

- 더 높은 확률을 가진 경우 탐색에서 우선순위를 가지도록, 자세한 공식은 논문 참고

- backward: 상황에 따라 이전의 토큰들로 원복

- 한 번의 평가에 더 많은 토큰들을 탐색할 수 있도록 토큰 셋들 사이의 유사도를 활용

- forward: 주어진 node(=token set)을 활용하여 다음에 이어질 적절한 토큰들을 탐색

평가

- 태스크

- harm-free generation

- adversarial harm-free generation

- controlled sentiment generation

- 데이터셋

- Helpful and Harmless (HH)

- AdvBench

- IMDB dataset

- 모델

- LLaMA, LLaMA-2, Vicuna, Alpaca 7B, GPT-neo

- 평가지표

- GPT-4, 사람의 평가

한계

- 더 긴 추론 시간을 필요로 함

- LLaMA 30B 모델 기준 HH 데이터셋에서 약 4배 정도의 시간이 필요

의의

- 추가적인 학습을 필요로 하지 않음 (learning-free)

- 외부의 지식이나 데이터를 필요로 하지 않음

- 모델의 alignment를 위한 능력은 self-contained임을 증명