book title : 딥러닝을 위한 수학

pages : 141 ~ 145

key concepts :

-

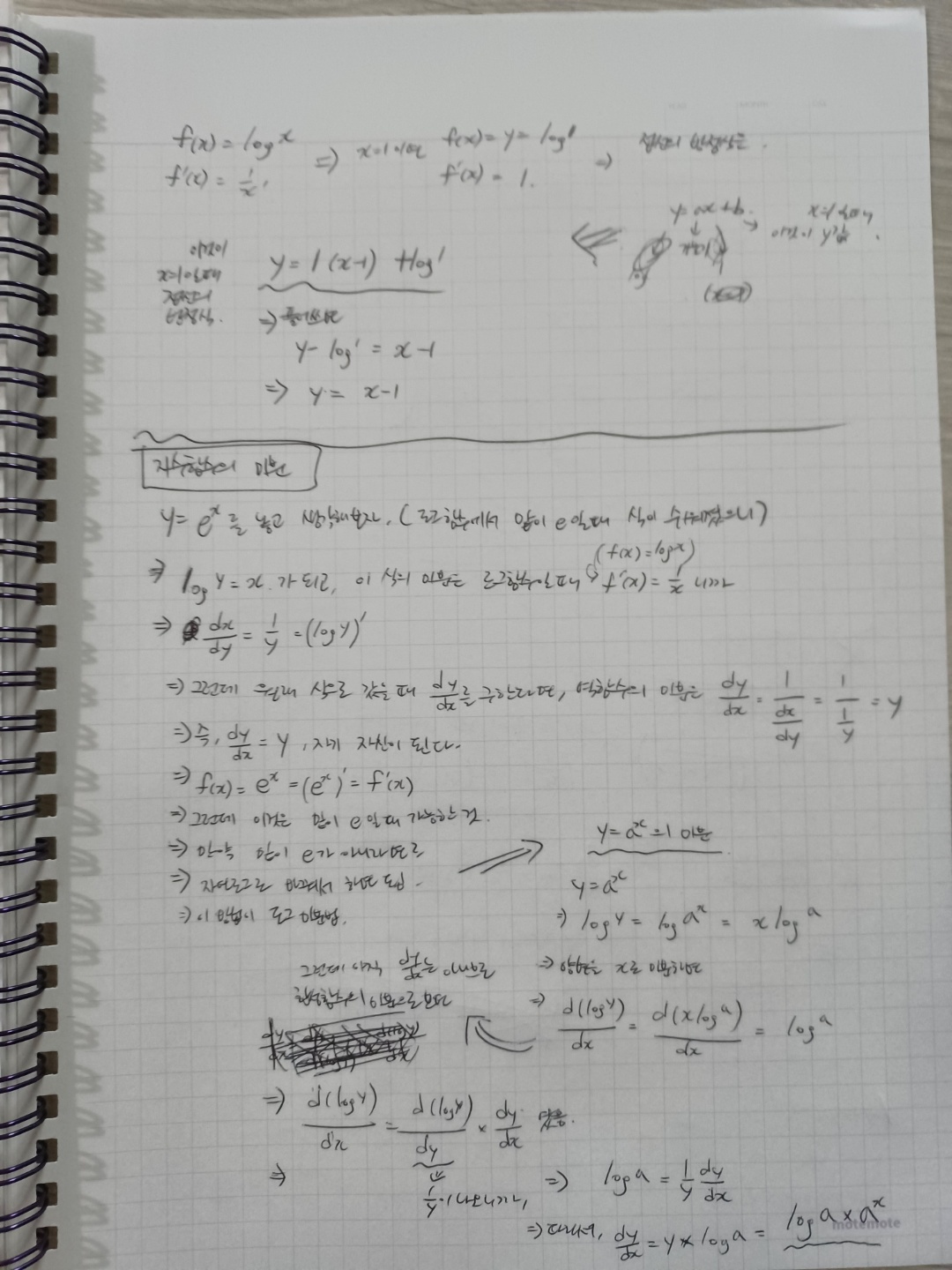

지수함수도 로그함수와 같이 밑이 인 일 때 미분값이 깔끔해진다.

- 공식을 구하는 과정은 역함수 관계인 로그함수를 써서 구함

- 결국 라는 자기 자신의 값이 나옴

-

밑이 가 아닌 지수함수의 미분 값은?

- 공식을 구하는 과정에서는 자연로그 형태로 변환하는 방법이 쓰인다.

- 이 계산법을 '로그미분법(logarithmic differentiation)'이라고 함

- 이면 로 고쳐서 구함

- 결국 가 됨

- 직관적인 의미로는, 밑을 자연로그 위(?)값으로 가지는 값을 에곱한 것

-

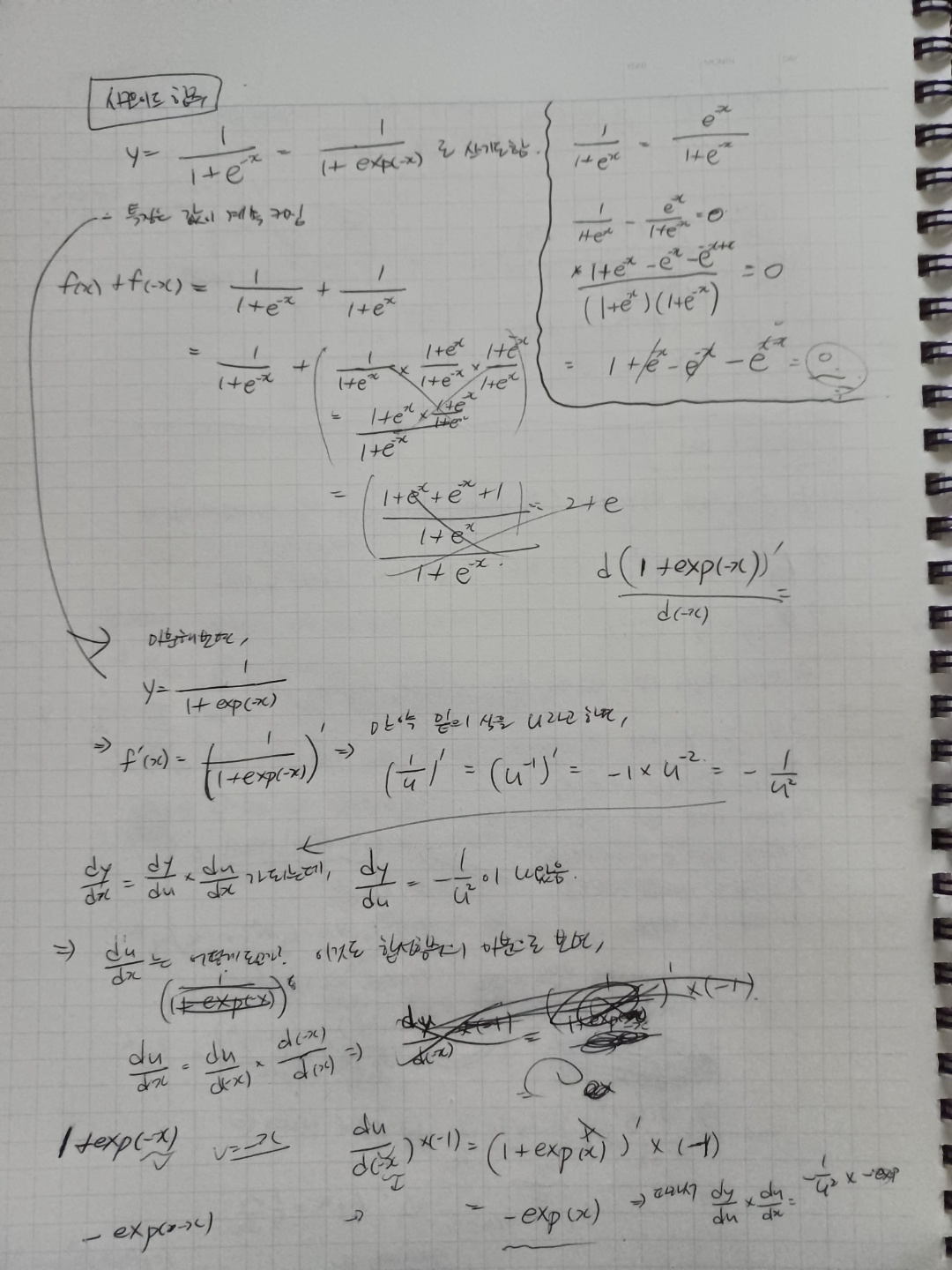

시그모이드 함수

- 생각해 보니 값이 계속 증가하는 함수이다.

- 이걸 영어로 단조증가함수, monotone incraesing function이라고 한단다(논문 같은 데 많이 봤던 단어인 듯하다).

- 두 개의 점 와 사이의 중점은 갑과 상관 없이 항상 에 있다.

- 이 특징은 확률분포함수(연속적인 값을 가지고 결과가 확률값인 함수)의 특징으로 적합함

- 시그모이드 함수 공식은

- 미분 공식 구할 때는 식이 살짝 복잡해보이니, 분모 부분을 변수로 치환하고, 또 합성함수의 미분(Chain rule)을 이용한다.

- 나오는 공식은

- 이것도 직관적인 의미로는

원래 함숫값만 사용해 미분값을 계산함