1. Entropy

- 정보를 표현하는데 필요한 평균 최소 자원량

- 정보를 어떻게 표현할까?

- 클로드 섀넌이 제안

- bit(0또는1)으로 표현 → 많이 쓰는 정보는 적은 비트를 할당해야한다

- 확률이 크면 길이를 짧게, 확률이 작으면 길이를 크게 → -logP(x)함수

- 엔트로피는 정보를 표현하는데 필요한 평균 최소 자원량이고, bit로 표현합니다. -logP(x)를 사용해서 확률이 큰 사건은 적은 비트를 할당하고 확률이 적은 사건에는 큰 비트를 할당합니다

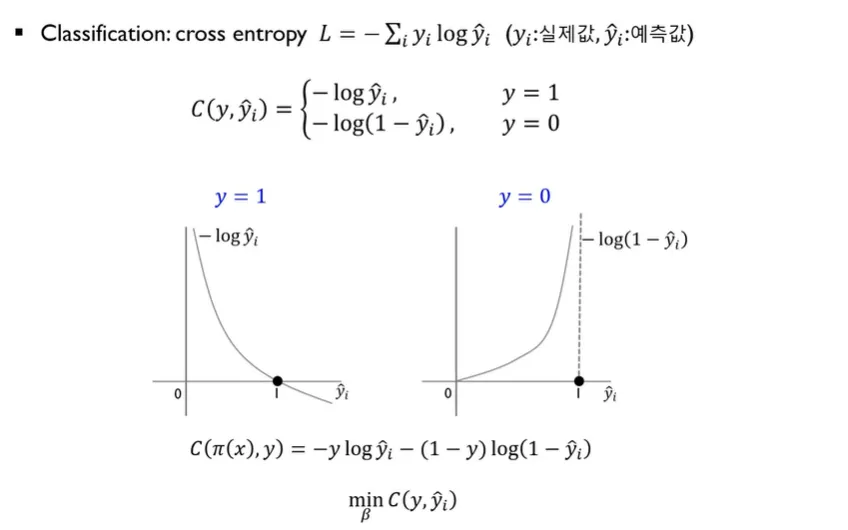

2. Cross-entropy

- 분류 문제에서 비용함수로 많이 쓰인다

- y가 1인 경우 -log y^이 최소가 되도록 한다

- y가 0인 경우 -log(1-y^) 이 최소가 되도록 학습한

.jpg)