0. INTRO

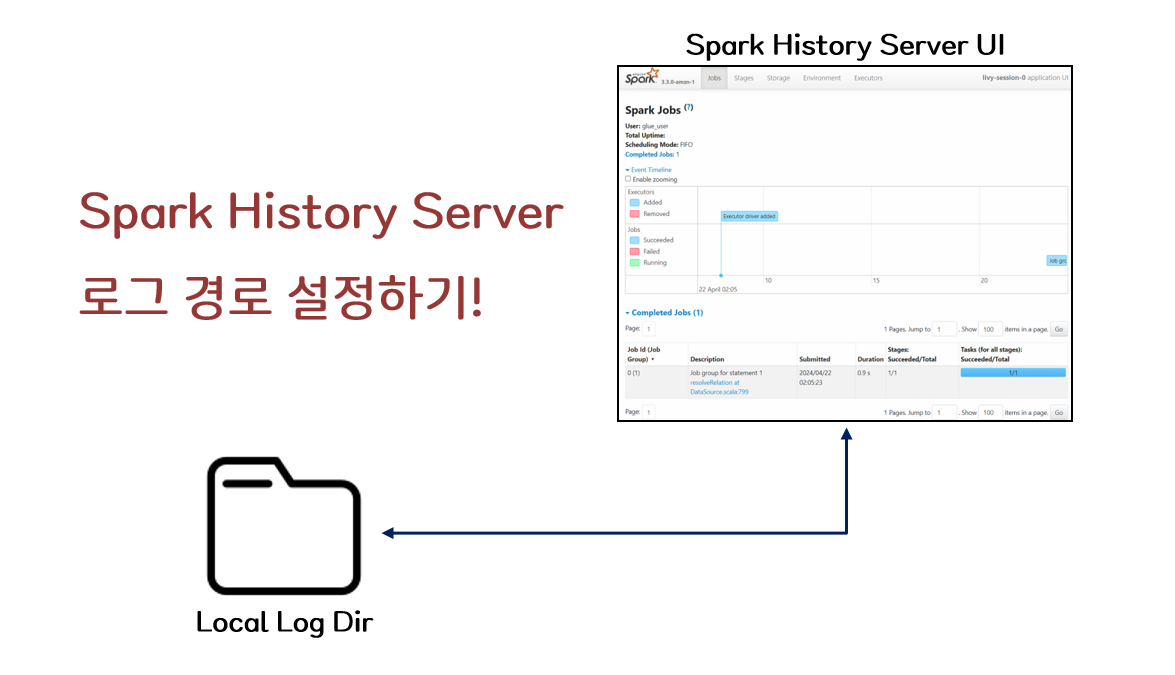

- Spark History Server는 Spark 작업의 실행 이력을 시각적으로 추적하고 분석할 수 있는 필수 도구이다.

- UI에는 작업의 실행 시간, 자원 사용량, 작업의 내부 Flow, 에러 로그 등이 포함되어 있어 작업자가 실행한 Spark 작업의 성능 및 실행 상태를 손쉽게 파악할 수 있기 때문에 작업과 함께 중간중간 살펴본다면 굉장히 큰 도움을 받을 수 있다.

- 이번 글에서는 Spark History Server에서 참고하는 Spark Log의 경로를 어떻게 바꿀 수 있는지 간단하게 알아보도록 할 것이다.

1. 본문

1. spark-defaults.conf 파일 수정

-

$SPARK_HOME으로 지정되어 있는 경로 혹은 Spark Download 경로에서 zip 파일을 내려받아 압축을 푼 경로를 기준으로SPARK_HOME/conf/디렉토리로 들어가면spark-defaults.conf.template파일이 있는 것을 볼 수 있다. 이 템플릿을spark-defaults.conf파일로 복사를 해준다.> cp spark-defaults.conf.template spark-defaults.conf -

spark-defaults.conf파일 하단에 아래 내용을 추가해준다. 아래 내용은/tmp/spark-events-local경로를 기본 log 경로로 정하겠다는 설정이다.spark.history.fs.logDirectory file:/tmp/spark-events-local # spark history log 경로 spark.eventLog.dir file:/tmp/spark-events-local spark.eventLog.enabled true

2. spark history server 재시작

-

추가가 되었으면 아래 명령어를 통해 spark history server를 재시작해준다.

> bash SPARK_HOME/sbin/start-history-server.sh starting org.apache.spark.deploy.history.HistoryServer, logging to /spark/logs/spark--org.apache.spark.deploy.history.HistoryServer-1-6e2cfe9c81fd.out