SPARK

1.실무에서 자주 쓰는 Pyspark 명령어 정리

Pyspark를 약 2년여간 사용해오면서 개인적으로 자주 쓰는 분석 명령어들을 정리해보았다.

2.Apache Spark 자격증 취득기

Databricks Certified Associate Developer for Apache Spark 3.0 자격증 취득과 관련된 내용들을 정리하여 보았습니다.

3.Spark Certified Associate 자격증 시험 관련 내용 정리

Databricks Certified Associate Developer for Apache Spark 자격증 관련 내용 정리

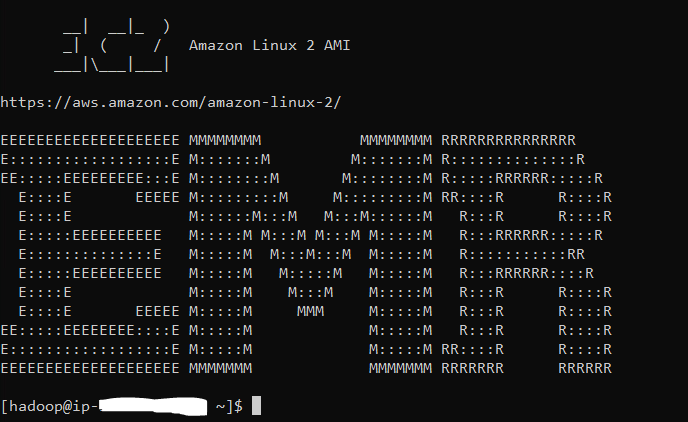

4.EMR step job에 대한 로그 보는 방법

EMR master node에서 step의 로그 보는 방법에 대해 간략히 서술

5.[Spark] Pyspark UDF 함수에 변수를 넘겨주어 실행하는 방법들

Pyspark UDF(User Defined Function)에 변수를 넘겨주어 실행하는 방법들

6.[K8S-SPARK 1부] spark-on-k8s-operator를 통한 쿠버네티스에서 Spark Job 실행 환경 만들기

spark-on-k8s-operator를 통한 쿠버네티스상의 Spark 작업 환경 구축하기 1부

7.[K8S-SPARK 2부] Spark on K8S 환경에서 custom pyspark 스크립트 실행하기

Custom한 spark 스크립트를 도커 이미지에 함께 포함시켜 만들어서 SparkApplication YAML 파일로 해당 스크립트를 실행해보자!

8.[K8S-SPARK 3부] Pyspark Container 환경에서 Cloud Storage에 결과물 저장하기

Spark Container 환경에서 Cloud Storage로 데이터 저장하는 방법

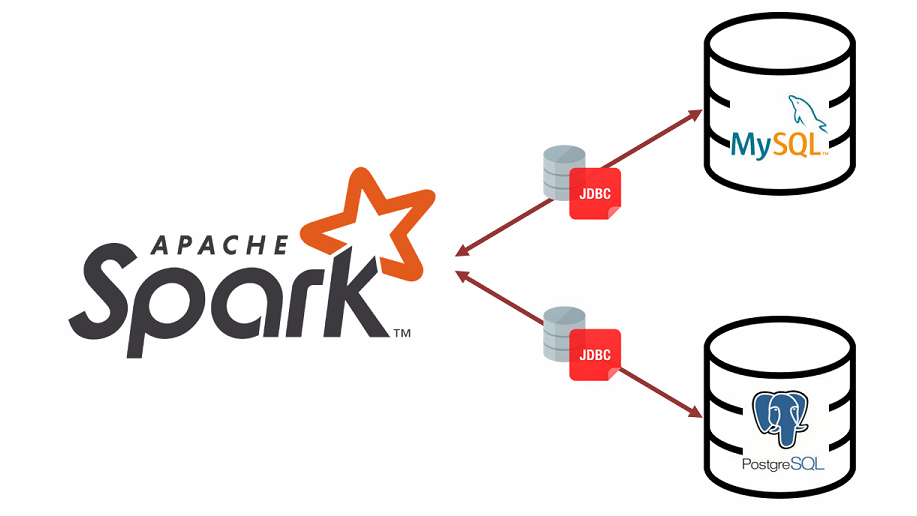

10.[SPARK] Spark로 DB 데이터 read & write 하는 방법(postgresql, mysql)

Spark로 Database Connection 생성 후 테이블 데이터 다뤄보기!

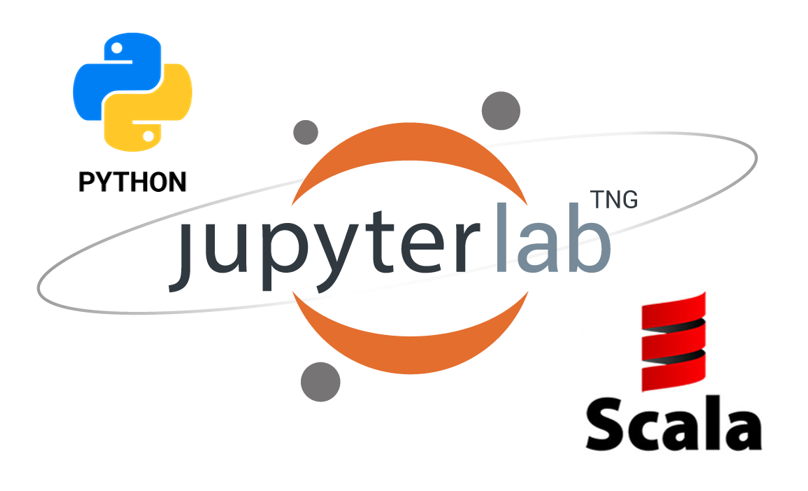

11.[SPARK] Python, Scala Kernel이 모두 있는 Jupyter Lab Docker 이미지 만들기

python과 scala 커널이 모두 있는 Jupyter Lab Docker Image

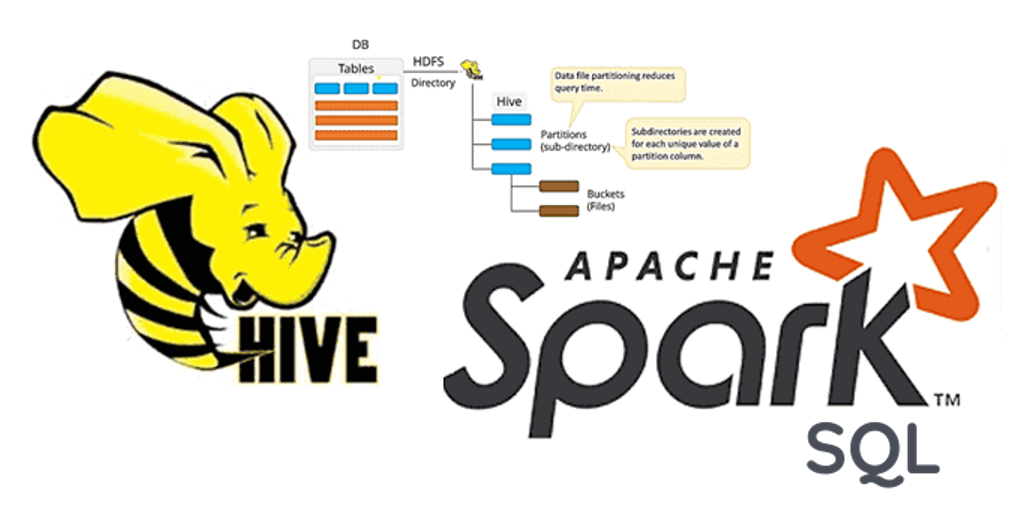

12.[SPARK] Spark SQL과 Spark Catalog를 통한 테이블 관리 및 데이터 프로세싱

SPARK SQL 및 Catalog에 대하여

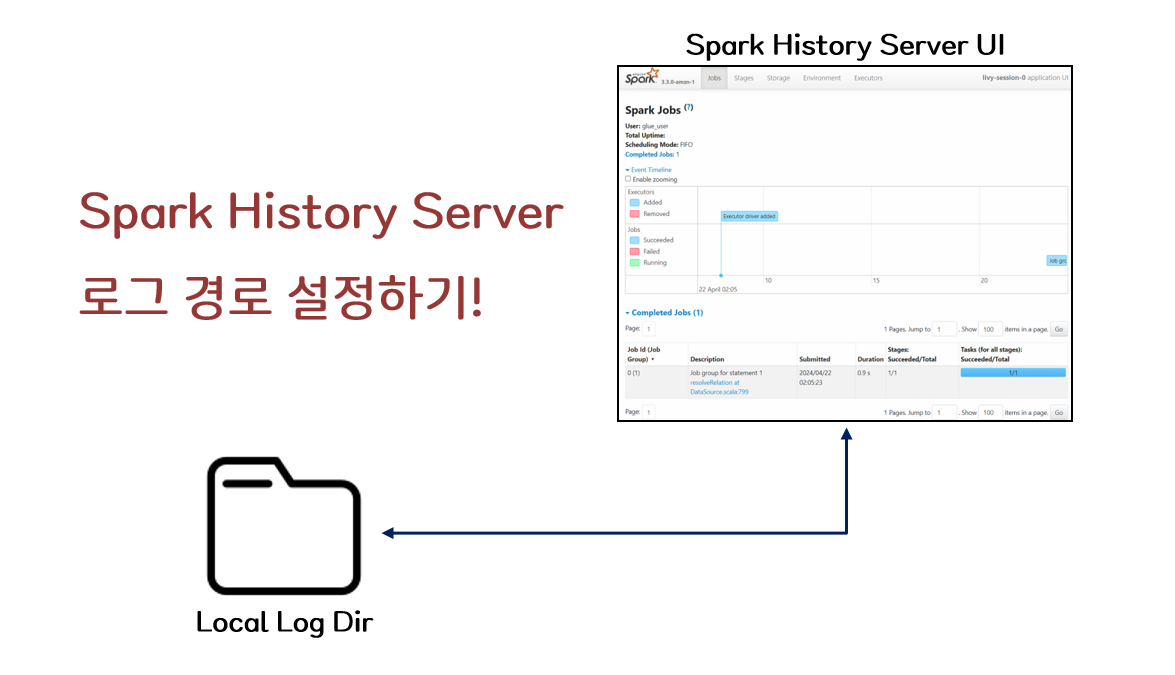

13.[Spark] Spark History Server Log 경로 설정하기

0. INTRO Spark History Server는 Spark 작업의 실행 이력을 시각적으로 추적하고 분석할 수 있는 필수 도구이다. UI에는 작업의 실행 시간, 자원 사용량, 작업의 내부 Flow, 에러 로그 등이 포함되어 있어 작업자가 실행한 Spark 작업의 성능 및 실행 상태를 손쉽게 파악할 수 있기 때문에 작업과 함께 중간중간 살펴본다면 굉장히...

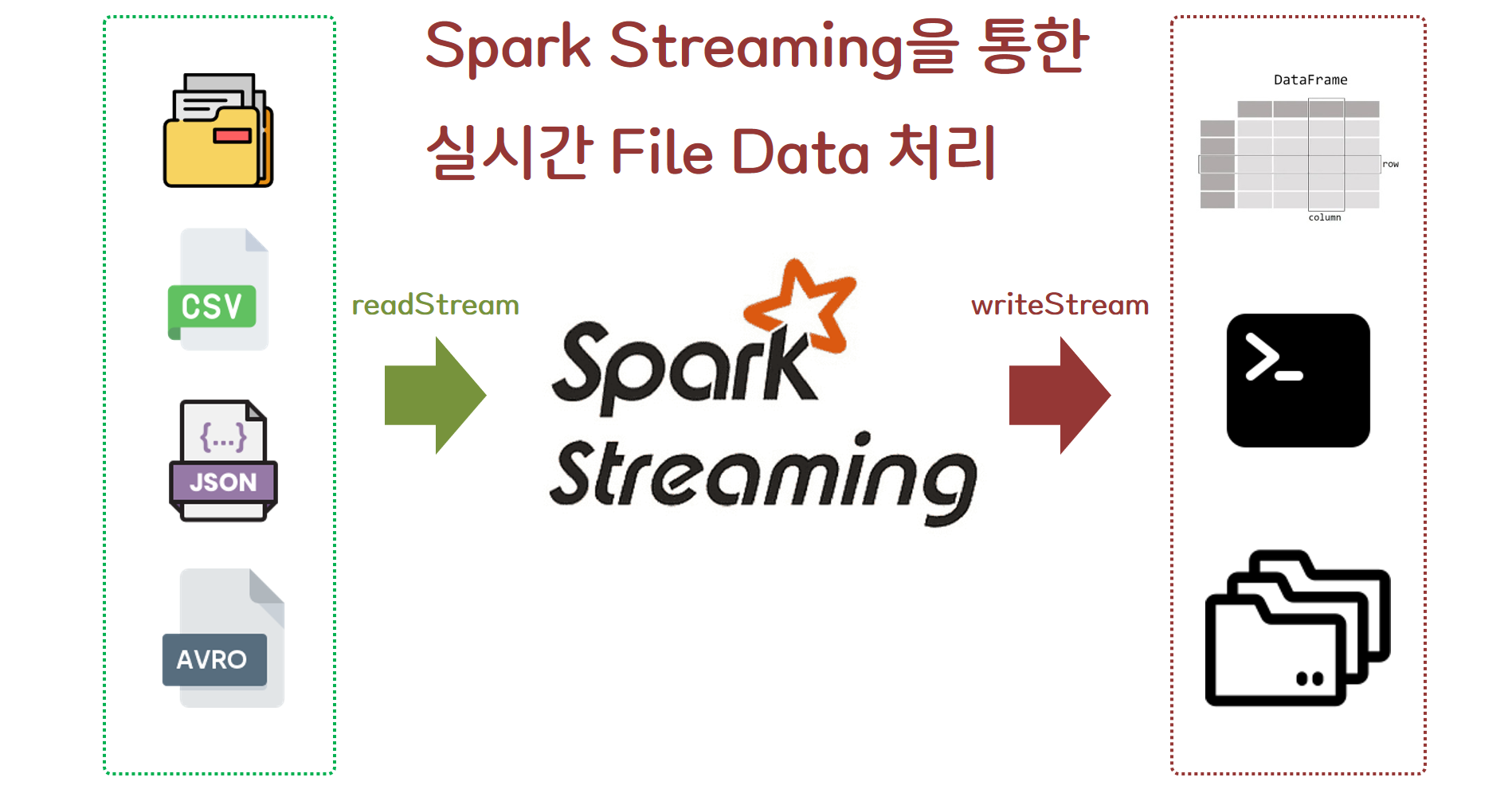

14.[Spark] Multi Node Spark Cluster에서 Spark Streaming을 통한 실시간 파일 처리

Spark File Streaming

15.[Spark] Kafka를 통해 들어오는 데이터를 Spark Streaming을 통한 실시간 처리하기

Kafka 데이터를 Spark Streaming으로 실시간 처리

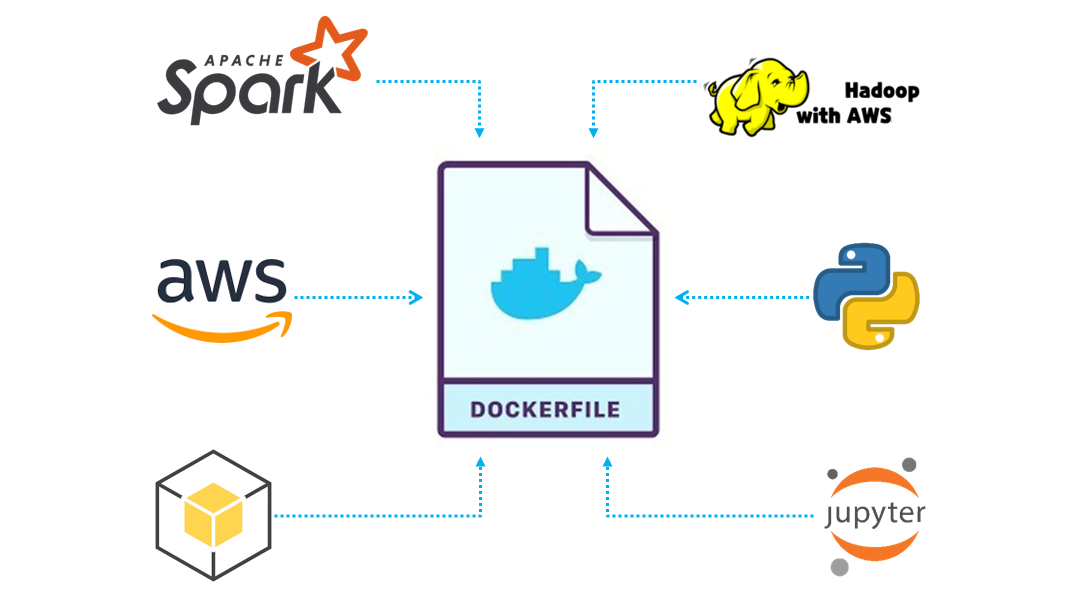

16.[Spark] Spark와 hadoop-aws 호환 버전에 따른 AWS S3와 통신할 수 있는 Spark Jupyter Lab Docker Image 구성하기

🔹 0. INTRO AWS S3는 거의 무제한의 저장 용량을 제공하며, 이를 통해 대규모 데이터를 저장하고 관리할 수 있어 Data Lake, Data Warehouse, Data Mart 등 다양한 티어의 데이터들을 저장하는 저장소로 활용하기 적합합니다. AWS

17.[Spark] 실무에서 바로 써먹는 PySpark 핵심 명령어 총정리

Pyspark로 데이터 분석시 자주 사용하는 코드에 대하여 정리해 보았습니다.

18.[Spark] Spark로 Google Cloud Storage 데이터 읽어오기!

0. INTRO 대규모 데이터를 클라우드 객체 저장소에 보관한 뒤 Spark를 활용해 분석하는 방식은 이제 데이터 분석의 대표적인 사례로 자리 잡았습니다. 특히, 클라우드 서비스 환경에서는 Spark와 객체 저장소 간의 통합이 이미 기본적으로 설정된 경우가 많아, 별다른 추가 설정 없이 바로 사용할 수 있는 편리함이 있습니다. 그러나 로컬 환경에서 Spar...