히익 벌써 9주차라니 두달이 끝났다니

언어지능 딥러닝

언어지능 딥러닝은 마이 프랜드 지피티와 관련된 기술이다.

chatgpt에 관심이 많아서 관련 강의를 들으며 언어지능에 대해 미리 접해봤는데도

이번 수업,, 여전히 배울게 너무많고 어려웠다..

하지만 매번 신기하고 대단한 인공지능~~

1. RNN

이번 시간은 언어지능을 잔뜩 남발해보려한다~ 지피티야~~~

첫 시간에는 가장 일찍 등장하고 영향력있는 딥러닝 모델인 RNN에 대해 배웠다.

개념

과거의 정돈된 정보와 현재의 raw 정보를 동시에 고려해, 모델의 목적에 맞는 representation을 하여 새롭고 정확한 특징을 추출해낸다.

특징

-

Weight Sharing

: 고려하는 시점이 달라져도 동일한 가중치를 사용한다.

(이를 다르게 표현하면 다음과 같다.)

👉 일관된 규칙으로 반복한다.

👉 시간이 달라져도 정보를 추출하는 규칙은 동일하다.

👉 시간이 지나도 중요하다고 판단되는 규칙(정보)만을 추출한다! -

금붕어

🐟 강사님이 잊으라고 하셨지만.. 가장 기억에남아버린 골드피시,,~~~

: RNN은 sequence model로, 순서를 중요하게 여기는 모델이다. 즉, 순서에 영향을 받는다.

🐟 따라서, 과거의 것들을 잊어버리고 마지막 시점의 정보를 중요하게 여기는 경향이 있다.

2. LSTM

그런 금붕어의 기억소실 문제를 보완하기 위해 나온 LSTM(Long Short Term Memory)!!

특징

RNN의 구조적 특징(시점과 무관하게 일관된 규칙 적용) + 기억

👉 RNN의 특징을 전부 가지고 있으면서 기억 생성과 유지보수 장치를 더한 구조

구조

구조를 자세히 보면 다음과 같다.

- cell state

- hidden state

- forget gate

- input gate

기존 RNN보다 노드가 더 많이 생긴 덕분에 기억력의 문제는 더 나아졌으나 가중치가 4배가 된다는 단점이 있다.

기억력 문제가 나아졌다고 했지만 어쨌든 RNN을 기반으로 한 모델이기 때문에 기억 소실의 문제가 조금은 발생할 가능성이 있다고 한다.

강사님은 잊으라 하셨지만..

암튼 그래서,, 정리하자면 ,, LSTM은 똑똑하고 무거운 금븡어...

3. GRU

LSTM 보다 더 발전된 모델로, GRU(Gradient Recurrent Unit)가 등장했다.

구조

- hidden state + cell state

- forget gate

- input gate

앞서 나온 LSTM은 총 4개의 노드로 이루어지는 반면, GRU는 hidden state와 cell state를 합쳐 총 세 개의 노드로 이루어져있다.

구조가 축소되어 가진 효과는 다음과 같다.

- 가중치가 가벼워짐

- 더 적은 파라미터로 좋은 성능을 냄

- RNN에 비해 더 긴 시퀀스 처리 가능

- 불필요한 정보 제거 -> 효과적인 정보 전달

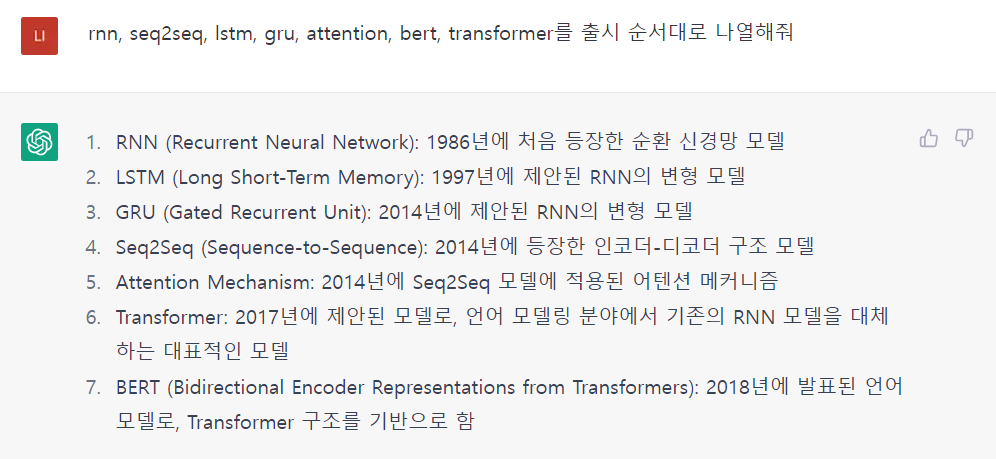

등장 시기별 언어지능 모델

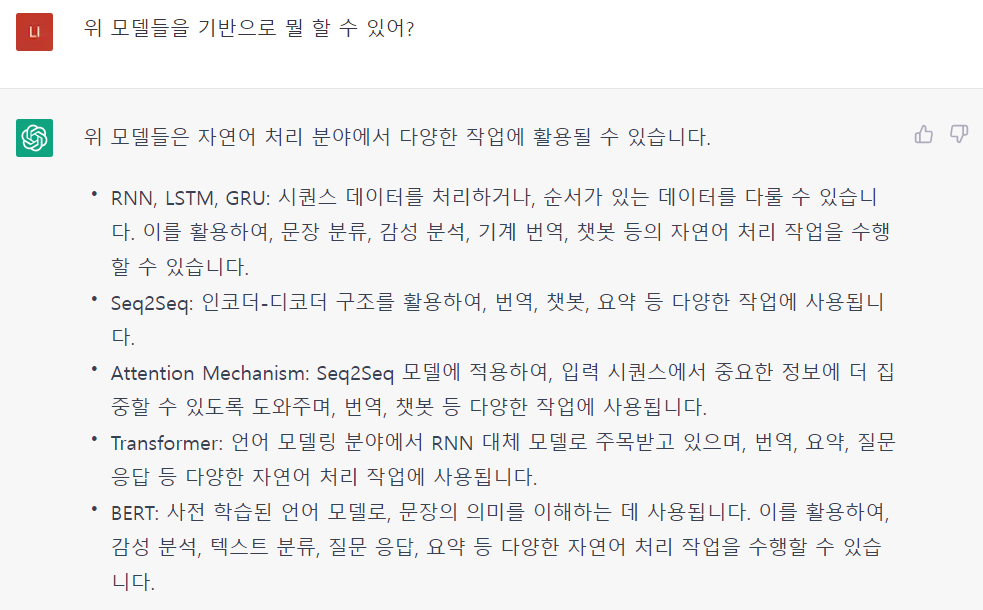

그 외에도 seq2seq, attention 등에 대해 배우고 text 분류, 생성에 대한 코드를 작성해보는 시간도 있었다. 하지만 전부 다 이야기하면 너무!너무! 길기 때문에 간단히 정리하고 마무리하려 한다.

그래서

지피티야~

음~ 우리의 똑똑이가 최근 동향까지 알려줬다~ chatgpt의 최근이라고 하면 2021년 데이터가 최선이겠지만~ 추가적으로 지식을 준 덕분에~ CNN이 자연어 처리에도 사용되는 것을 알게되었다.

끝!