1. Ollama

LLM(대형 언어 모델)을 로컬 환경에서 실행할 수 있도록 도와주는 툴로 쉽게 말해 GPT 같은 AI 모델을 로컬에서 직접 돌릴 수 있게 해주는 오픈소스 소프트웨어로 OpenAI API처럼 클라우드를 사용하지 않고, 내 컴퓨터에서 AI 모델을 실행할 수 있다.

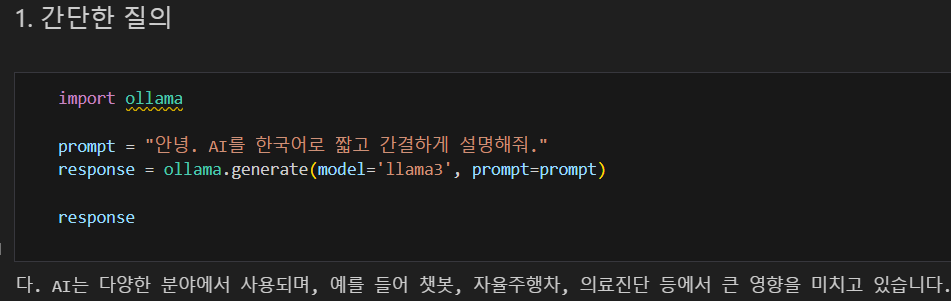

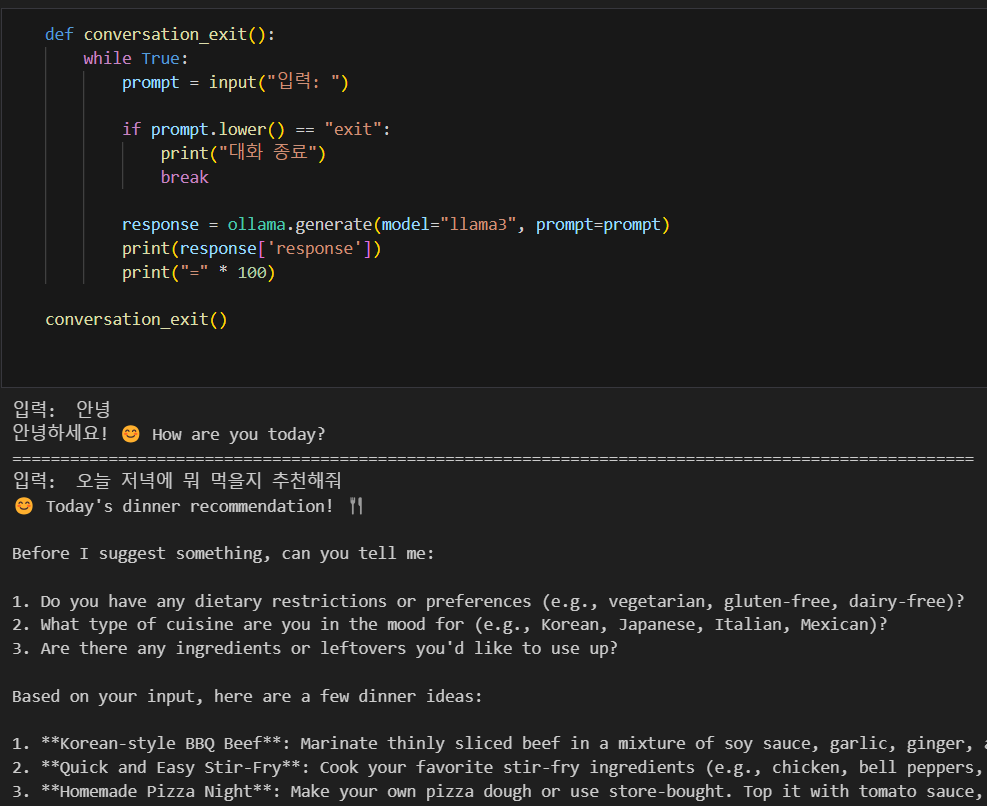

아래와 같이 ollama.generate를 사용하여 llama3 모델로 간단한 질의도 가능하고 대화가 가능한 대화 시스템도 구현해볼 수 있다.

2. RunPod

RunPod은 클라우드에서 GPU 서버를 임대하여 AI 모델을 실행할 수 있는 플랫폼으로 비용을 내고 클라우드 GPU(A100, H100 등)를 사용하여 AI 모델을 학습/추론할 수 있다.

2-1. 주요 특징

- 클라우드 기반 GPU 임대 → 내 PC가 아니라 원격 GPU 서버에서 AI 모델 실행 가능

- 다양한 AI 모델 실행 가능 → LLaMA, Mistral, Stable Diffusion, Whisper 등

- 사용한 만큼 비용 지불 → 시간 단위 과금

- 인터넷이 연결된 어디서든 실행 가능 → 구글 Colab보다 더 강력한 GPU 사용 가능

RunPod을 통해 HuggingFace에서 다운로드 받은 한국어 모델 EEVE-Korean-10.8B를 사용하여 한국어 챗봇 만들기도 가능하다.

# 한국어 챗봇 만들기

def korean_chatbot():

memory = []

while True:

user_input = input("입력: ")

if user_input == "종료":

print("대화 종료")

break

memory.append({"role": "user", "content": user_input})

response = ollama.chat(

model="EEVE-Korean-10.8B",

messages=memory

)

bot_reply = response['message']['content']

memory.append({"role": "assistant", "content": bot_reply})

print("유저:", user_input)

print("AI:", bot_reply)

print("=" * 100)

korean_chatbot()3. ollama.chat vs ollama.generate

| 기능 | ollama.chat | ollama.generate |

|---|---|---|

| 대화 히스토리 유지 | ✅ 가능 | ❌ 불가능 |

| 입력 방식 | messages=[...] | prompt="..." |

| 용도 | 챗봇, 문맥을 고려한 답변 | 단순한 텍스트 생성 |

| 출력 방식 | response["message"] | response["response"] |

| GPT 방식 비교 | chat.completions.create() | text.completions.create() |

4. RunPod + Ollama의 장점 & 단점

4-1. 장점

- PC 성능이 부족해도 강력한 AI 모델 실행 가능

- LLaMA, Mistral, Gemma 같은 오픈소스 LLM을 쉽게 활용 가능

- GPU 최적화된 환경에서 AI 모델을 빠르게 실행

- Python 등에서 API 방식으로 원격 제어 가능

4-2. 단점

- RunPod 사용 시 시간당 비용 발생 (A100 약 $0.5~$1/시간)

- 인터넷이 필요함 (로컬 실행이 아님)

5. Ollama vs OpenAI API vs RunPod 비교

| 기능 | Ollama | OpenAI API | RunPod |

|---|---|---|---|

| 운영 방식 | 로컬에서 실행 | 클라우드 서버에서 실행 | 클라우드 GPU에서 실행 |

| 인터넷 필요 여부 | ❌ 불필요 (로컬 실행) | ✅ 필요 | ✅ 필요 |

| 지원 모델 | LLaMA, Mistral, Gemma 등 오픈소스 모델 | GPT-4, GPT-3.5 등 OpenAI 모델 | 원하는 모델 설치 가능 |

| 비용 | ✅ 무료 | ❌ 사용량에 따라 과금 | ❌ GPU 사용량에 따라 과금 |

| 데이터 보안 | ✅ 데이터가 로컬에서만 처리됨 | ❌ 데이터가 OpenAI 서버로 전송됨 | ❌ 클라우드에서 처리됨 |

| 사용 용도 | 로컬에서 개인 AI 실행 | GPT-4/3.5 API 활용 | 고성능 GPU 활용 |