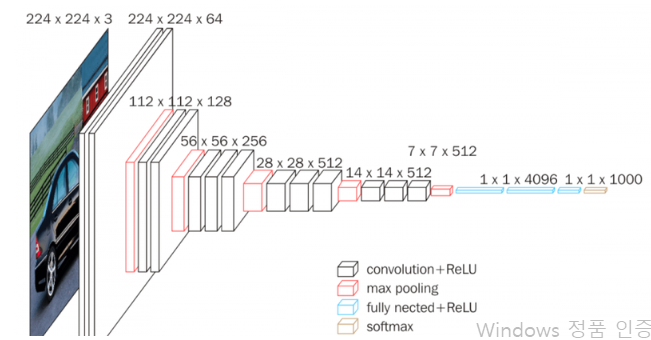

VGG

2014년 이미지넷 챌린지 준우승

간결한 구조로 많은 활용

이전에 우승한 네트워크들이 10개가 안 되는 CNN층을 가진 반면, VGG16과 VGG19라는 이름 뒤의 숫자로 볼 수 있듯이, VGG는 16개, 19개의 층

CNN을 만들 때 커널 크기(kernel size)를 조절

VGG에서는 3x3 커널을 사용해서 더 많은 레이어를 쌓고 이미지의 비선형적 특성을 더 잘 잡아낼 수 있게 만듦

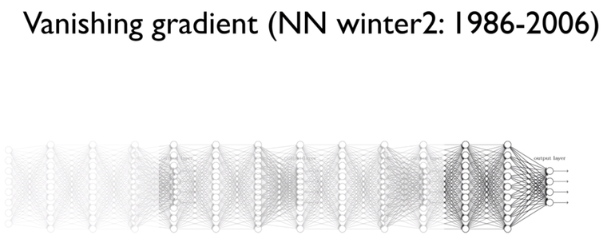

Vanishing Gradient

멀리서 말하는 사람의 목소리가 잘 안 들리듯, 모델이 깊어질수록 모델의 학습을 위한 Gradient가 사라지는 현상이 발생

네트워크는 Gradient descent를 통해서 기울기를 학습하는데 깊은 레이어에는 데이터에 따른 차이가 충분하게 반영되지 못함

Gradient가 매우 작아져서 레이어를 학습시키기 위해 충분한 값을 표현하지 못할 경우를 Vanshing 했다고 하여 기울기 소실(경사소실, Vanishing Gradient) 이라고 한다.

발생 원인은, 레이어가 깊어지면서 Gradient가 매우 커지거나 작아지기 때문

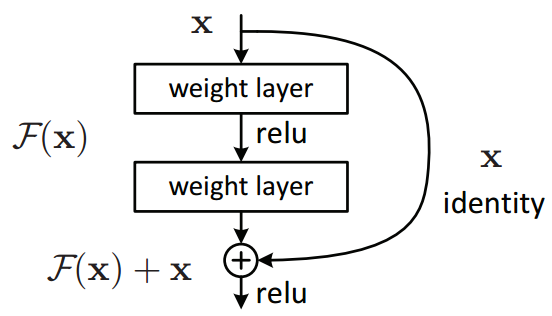

Gradient가 사라져서 깊은 레이어가 적절히 학습되지 않는 문제를 해결하기 위해서 ResNet은 새로운 방법을 도입

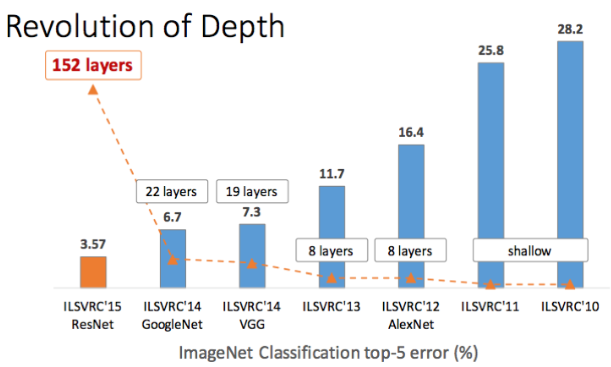

Resnet

ResNet의 레이어 수는 무려 152개인데 어떤 방식을 도입해서 이렇게 깊은 레이어를 쌓을 수 있었을까?

ResNet에서는 Residual Model에서 보이는 것처럼 Skip Connection이라는 구조를 사용해서 Vanishing Gradient 문제를 해결.

Skip Connection은 레이어의 입력을 다른 곳에 이어서 Gradient가 깊은 곳까지 이어지도록 한다.

위 그림처럼 레이어와 Skip Connection이 있는 블록을 Residual Block