나도 ai를 로컬에 띄워서 간단한건 공짜로 써보고싶다!!!

도커 띄우기

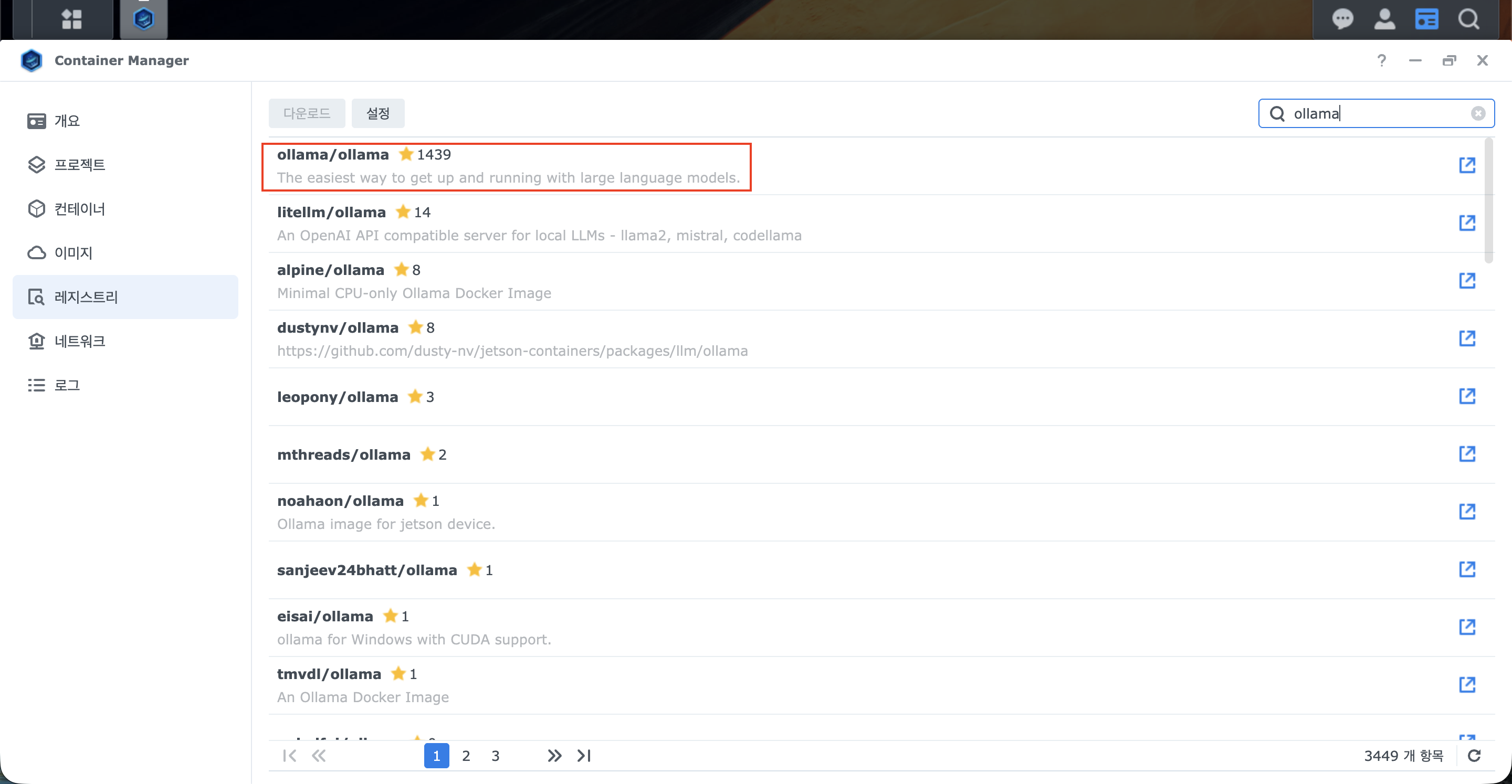

자자 시놀로지 서버에 띄워봅시다.

올라마 이미지 다운로드 딸깍

docker 으로 띄워보자

- 포트는 통상적으로 11434 쓰는것같아서 따라했다.

/root/.ollama에 데이터가 저장되는것 같아 볼륨도 따로 잡아줬다.

docker run -d -p 11434:11434 -v /volume1/docker/ollama:/root/.ollama --name ollama-pack ollama/ollama:latest도커 띄우기 -완-

모델 다운받기

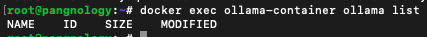

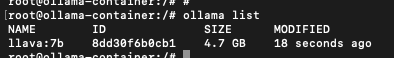

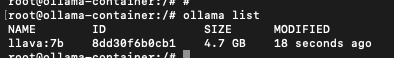

처음에 들어가서 보면 사용할수 있는 모델이 없다는걸 확인할 수 있다.

ollama list

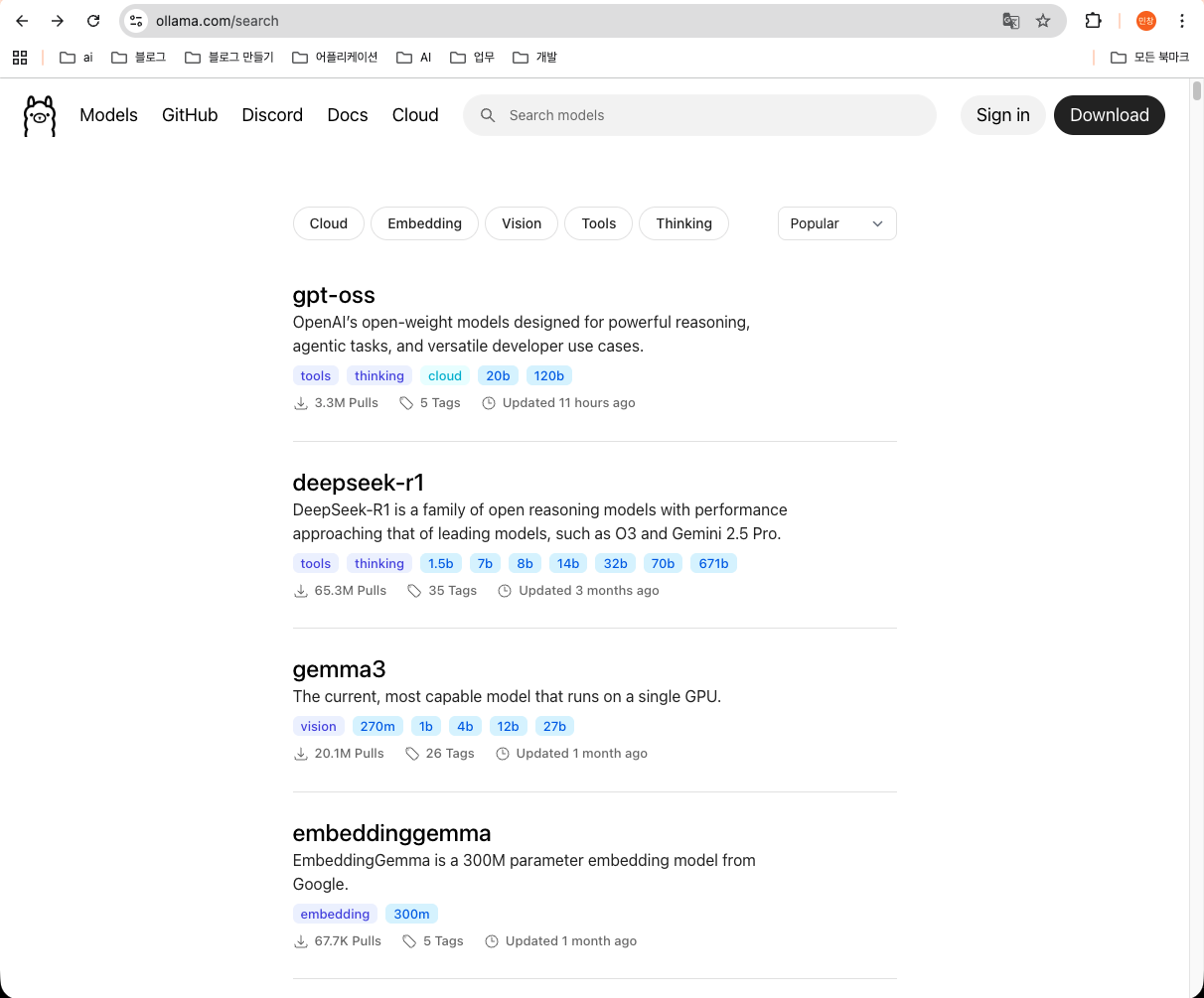

다음 사이트를 들어가보자

https://ollama.com/search

아주 많은 모델들이 있는데, 이름이 예쁜걸로 다운받아보자

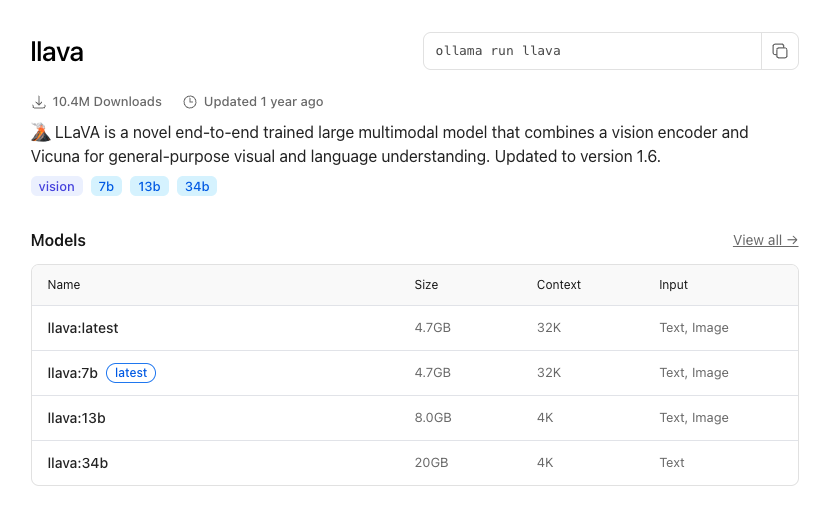

나는 llava 를 선택했다.

해당 모델을 설치하는데 한참 걸리고있다.

ollama pull [이미지명]

다운로드 -완-

이제 확인해보면 내가 설치한 모델이 뜬다.

ai 질문해보기

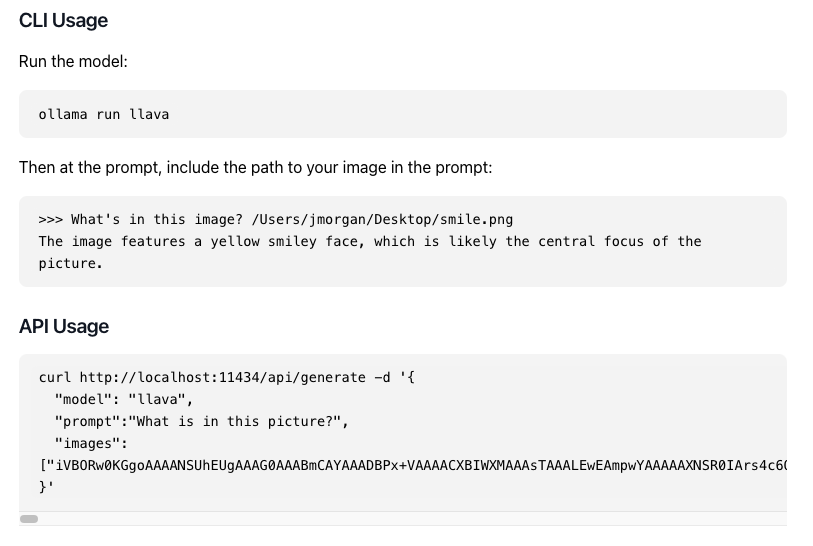

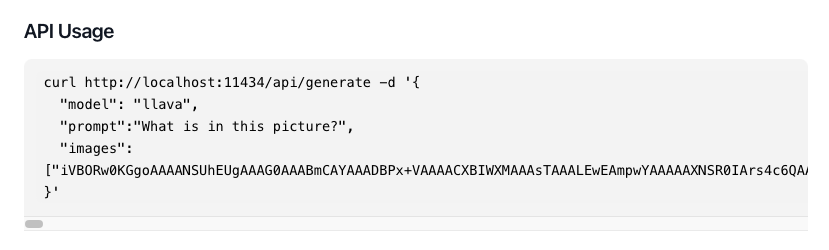

먼저, 홈페이지에서 사용법이 나와있다.

모델 사용하기 (모델에 접속)

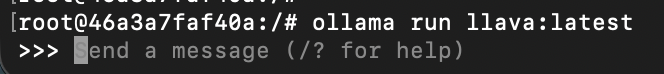

해당 모델에 접속 해보자

ollama run [모델명]

이제 이녀석에게 질문을 해보자.

- 2 + 3이 뭔지아니?

(감격의 눈물...)

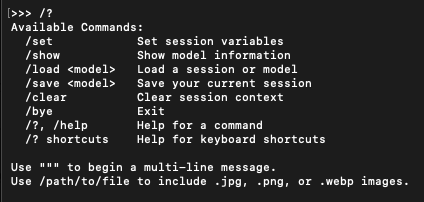

이미지 내부에서 명령어가 어떤게 있는지 알려면 다음으로 볼 수 있는데, 이것저것 나오긴 한다.

/?

모델 사용하기(api 요청)

모델에서 정상 동작하는걸 봤으니, 이제 내가 사용하는 api 형태로 사용하도록 요청해보자.

홈페이지의 예시처럼 curl 명령어로 요청할 예정

이벤트 스트림 형태로 요청이 오는걸 확인할 수 있다!

이제 개인 프로젝트에서 간단한 ai 는 공짜로 사용할수 있겠다!