발표영상

발표자료

내용

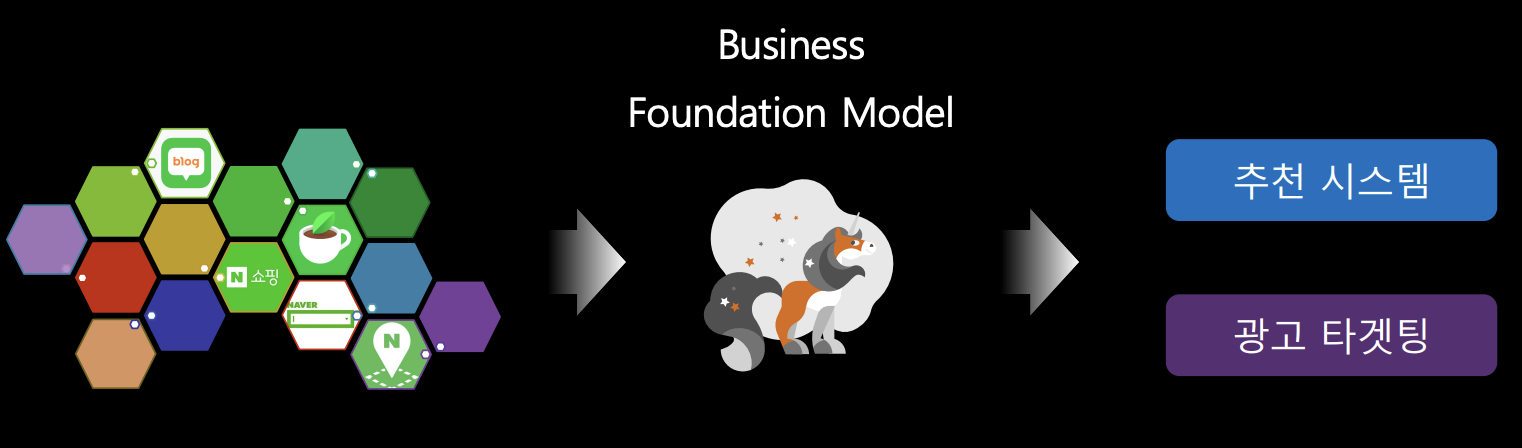

- Business Foundation Models

- Self-Supervised Learning : 대규모 데이터를 수집하여 학습

- 학습 모델을 다른 서비스에 활용

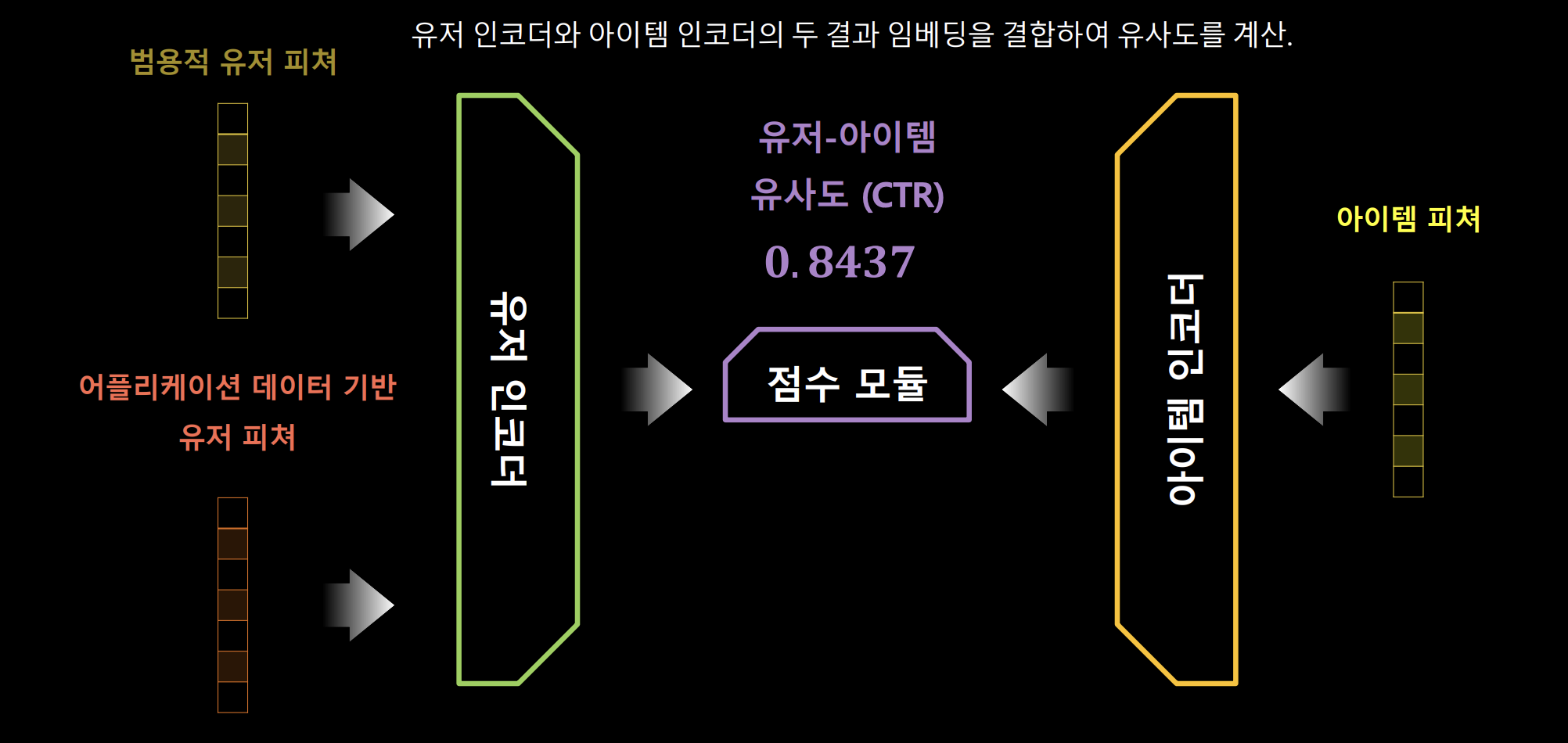

- Feature-based Transfer Learning

- 모델 추론이 아닌 유저의 피처를 제공하는 방식

- 언어 모델을 활용한 유저 모델링 연구

- 최근 NLP input 활용 각광 : 언어 모델링 → 추천 성능 향상에 도움

- U-BERT: Pre-training User Representations for Improved Recommendation(2021)

- A Unified Pretrain, Personalized Prompt & Predict Paradigm (P5) (2022)

- M6-Rec: Generative Pretrained Language Models are Open-Ended Recommender Systems (2022)

- Towards Universal Sequence Representation Learning for Recommender Systems (2022)

- Scaling Law for Recommendation Models: Towards General-purpose User Representations (2023)

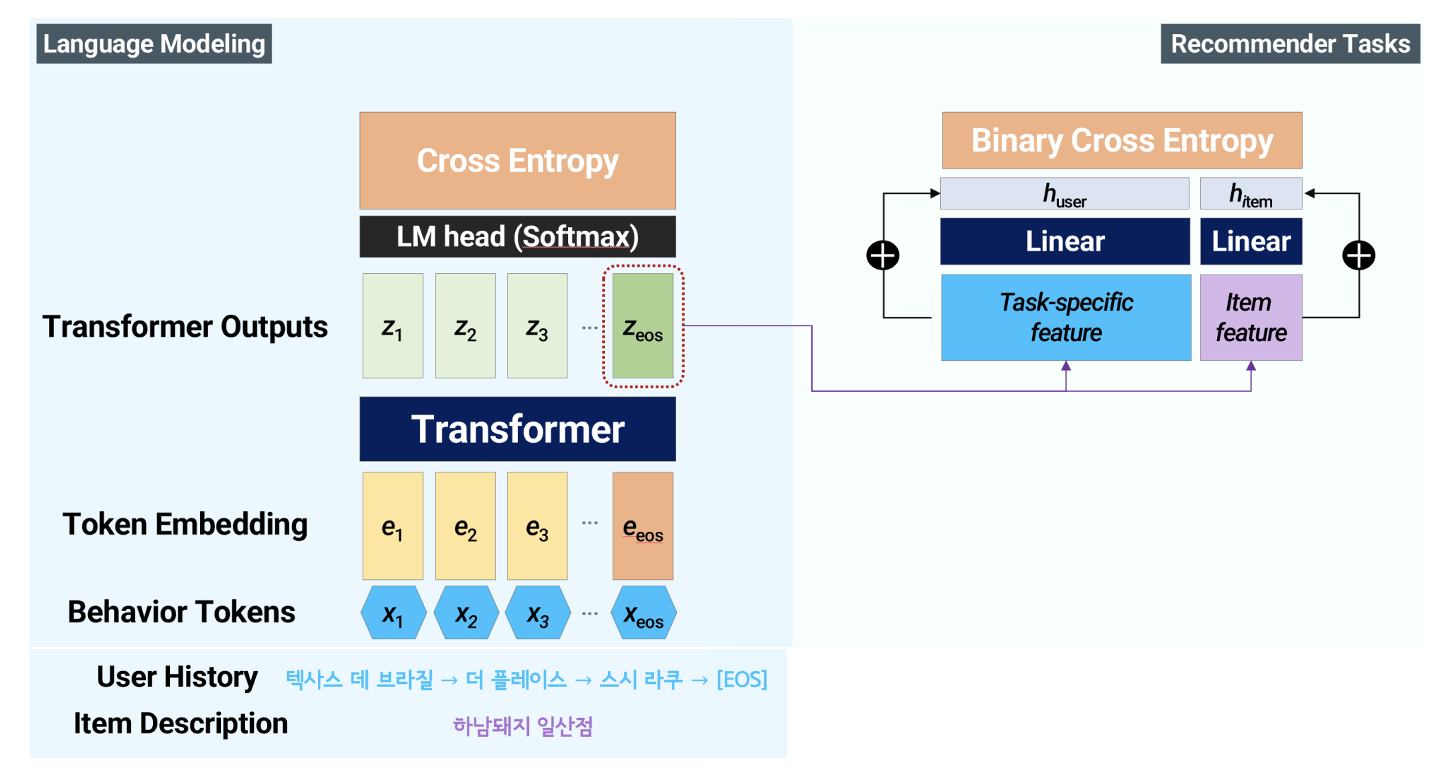

- 추천을 위한 언어 모델링

- [Insight] 적절한 language corpus로 language model pretraining → downstream task에 긍정적인 영향

- (인풋 구성) 사용자 로그를 자연어 형태 tokenize → 모델 인풋으로 사용

- downstream task의 logs data 뿐만 아니라 다른 logs data도 활용하고자 함

- (제안 기본 구조)

- (인풋 구성) 사용자 로그를 자연어 형태 tokenize → 모델 인풋으로 사용

- 서비스 적용 사례