학습한 내용

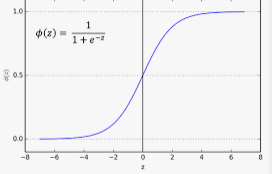

sigmoid 함수는 양 극단으로 갈수록 기울기가 0으로 수렴한다

gradient vanishing,exploding

학습의 역전파 과정에서 미분 계산값이 소실되거나 발산되어 이상 가중치 발생

다른 활성함수를 쓰거나 가중치 초기화,정규화 등으로 해결한다.

optimizer는 loss function값이 최저가 되는 지점을 찾는다.

적절한 learning rate가 필요 학습의 속도와 정확성을 위하여

batchsize는 mini-batch를 통해 적당한 학습률과 컴퓨팅 자원을 아낀다.

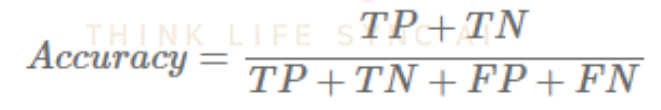

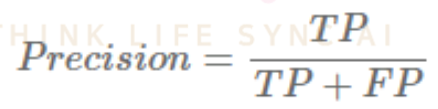

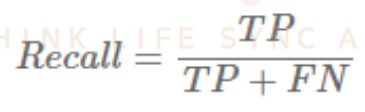

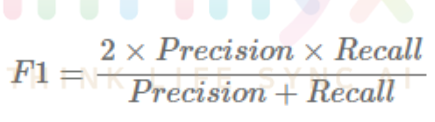

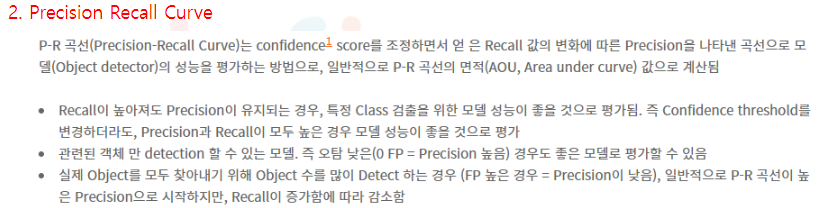

recall이 높아져도 precision이 유지된다면 모델이 무조건적으로 positive라고 하는것이 아닌 잘 맞추는것이므로 좋은모델

학습한 내용 중 어려웠던 점 또는 해결못한 것들

해결방법 작성

학습 소감

문서를 읽으려니 어렵다