1. 정의

"Implicitly defined, continuous, differentiable signal representations parameterized by neural networks" - Vincent Sitzmann, Julien N. P. Martel, Alexander Bergman,David B. Lindell, Gordon Wetzstein

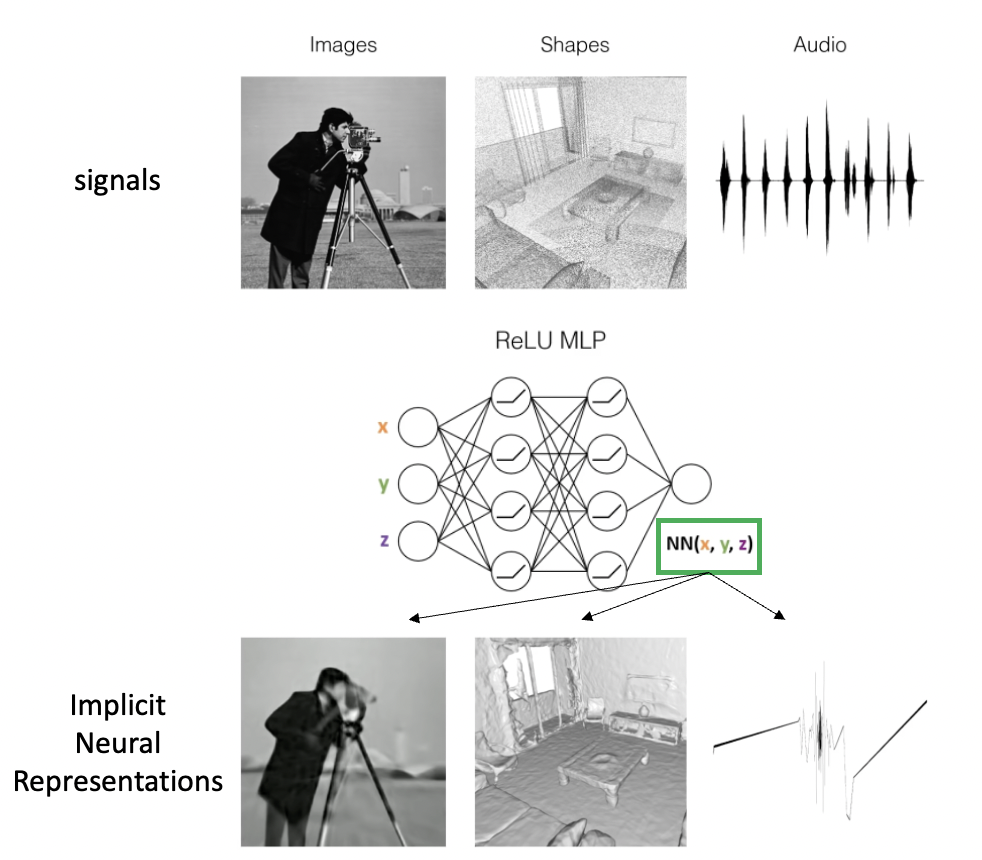

INR (Implicit Neural Representations) 는 모든 종류의 신호들(signals)을 Neural Network 를 통해 패러미터화 (paremeterize) 하는 방법이다.

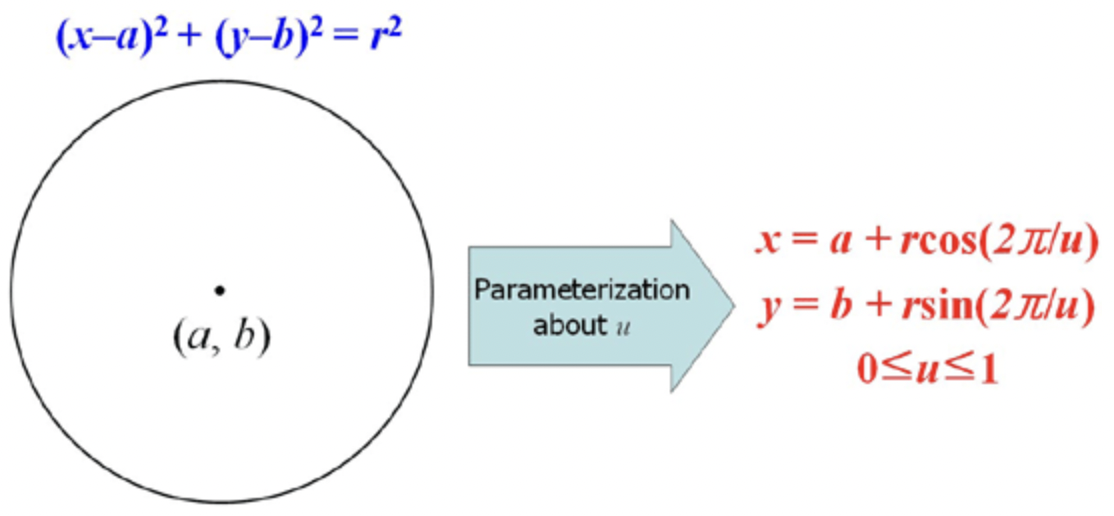

- Parameterization / 패러미터화

여기서 패러미터화는 하나의 표현식에 대해 다른 parameter를 사용하여 다시 표현하는 과정을 의미한다. 정말 쉽게 말하자면 3차 함수를 2차 함수로 표현하는거다. 보통 기존의 표현식의 차수보다 적은 수의 parameter를 사용해 보다 간결 (compact) 하게 만들기 위함이다.

딱봐도 알겠지만 수학적 지식을 많이 요한다고 한다. ㅠㅠ

신호를 input으로 받아 NN에서 부호화(encoding) 하여

더욱 간결하거나 패러미터(parameter) 조작이 용이한 대체 표현 (representation)을 output으로 출력하는 일종의 회귀 모델(regression task) 이다.

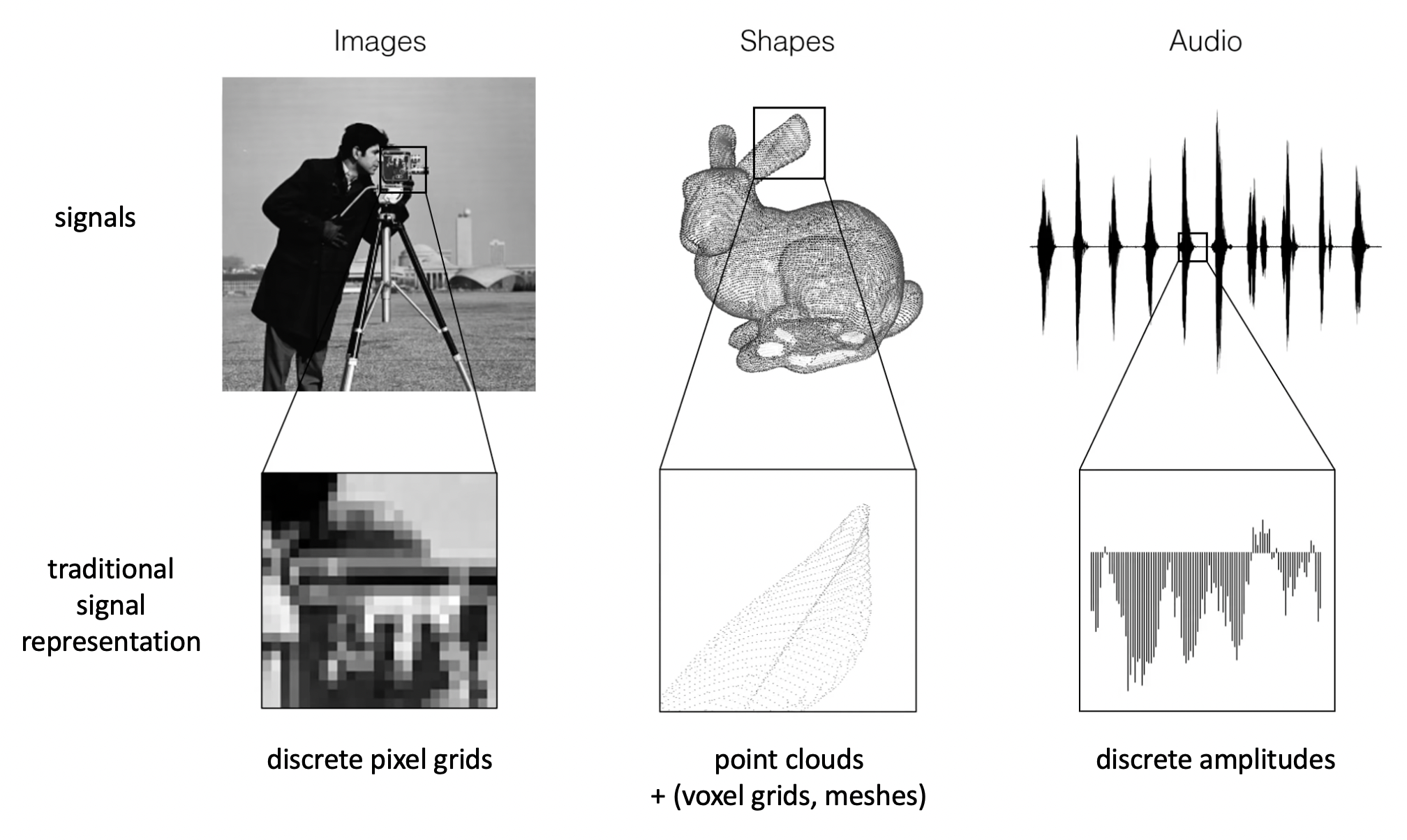

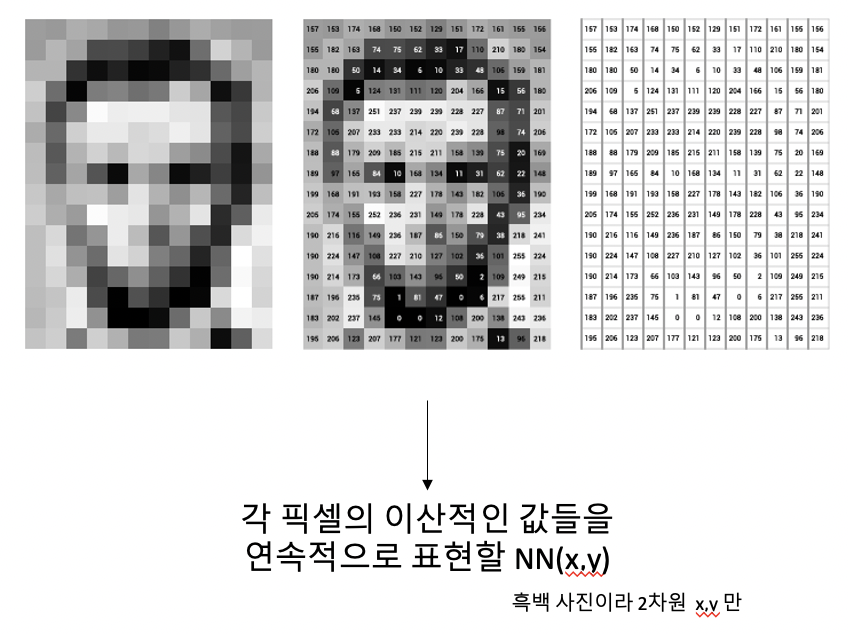

전통적인 신호 표현 (signal representation)은 주로 이산적이었다면, INR은 신호를 연속적

인 식으로 표현해준다.

-

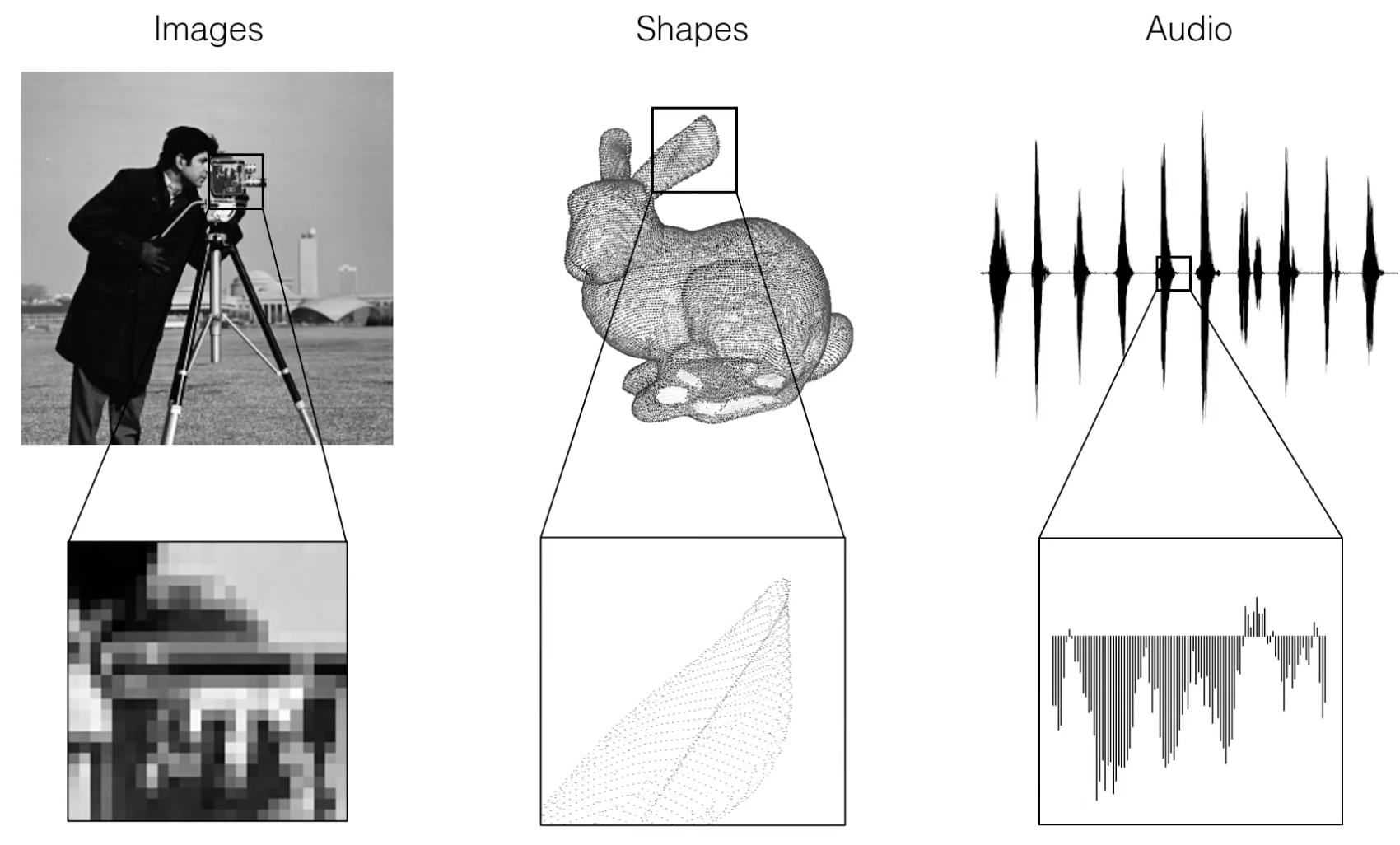

전통적인 신호 표현의 예 :

이미지 -> 이산적인 픽셀 그리드

음성 -> 이산적인 진폭

3D 도형 -> voxel grids, point clouds, meshes -

INR 의 신호 표현의 예:

이미지를 어떻게 연속적인 식으로 표현해요 ㅡㅡ 먼소립니까.. 라고 생각 드는게 정상이다. 사람이 자연 이미지를 식으로 써서 일일이 함수식으로 표현 가능하겠냐고...

그래서? 이걸 Neural Network가 식을 대략적으로 최대한 예측해내는 겁니다~ 그게바로 INR

위 사진 속에서 x, y, z 그리드를 받아 NN(x,y,z) 를 출력하듯

신호의 도메인 (예: 픽셀 좌표 값)을 해당 좌표 값 (RGB color)에 매핑(map) 한다.

졸라 구린 representation 같지만 이건 추후 보완되니 대충 넘어가자. ReLU랑 잘 안 맞는다고 한다.

2. 장점

뭔가 당장 이해하기론... (이미지 처리 예시) CNN에 이미지 벡터를 넣기 전에 하나의 단계가 추가 되는 기분이다.

장점이 있으니까 이걸 굳이 하겠죠?

1. 해상도의 영향을 안 받는다 (agnostic)

그리드 포인트가 엄청나게 밀집해도 적용 가능

2. model scales with complexity of object, not with resolution

진지하게 무슨 말인지 아직 모르겠음. 아무튼 해상도 영향 안 받음

이 부분을 사실 잘 이해 못했는데, 3D shape 이나 3D scene 을 다룰 때 좀 더 중요한 내용인것 같다. 이미지밖에 안 다뤄봐서 추후 보충 설명, 수정하겠음

3. 고빈도 자료 / 고빈도 데이터 (High Frequency Data)

(1) SIREN

To encode potentially high frequency data such as sound or images, it is much more efficient to start from periodic feature transformations.