깊은 신경망

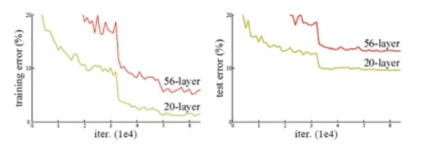

장점

- 신경망이 깊어질수록 정확도가 올라감

단점

- 하지만 신경망이 깊어지면 연산량이 대폭 증가해 성능 저하 발생

- 과잉적합문제 발생

- 경사소멸 문제 발생

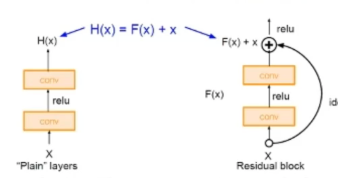

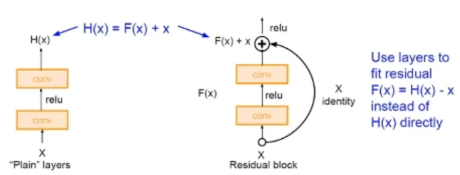

잔류학습

residual block

- 컨볼루션과 활성함수를 거친 값과 처음 인풋값을 합쳐줌

- 역전파 과정에서 발생하는 깊은 신경망 경사소멸문제를 해결

- 덧셈 연산만 증가해 매개변수 개수에 영향주지 않고 연산량 증가도 거의 없음

- 따라서 깊은 신경망을 사용할 수 있고 전체적인 훈련 정확성이 올라가게 됨

ResNet 구조

- 34층의 깊은 신경망을 가짐

- VGGNet과 다르게 3 * 3 커널 사용

- 전역 평균 풀링층 사용해 FC 층이 없음(매개변수 적음)

- 배치 정규화 사용