앙상블ensemble

- 서로 다른 여러 개의 모델을 결합해 일반화 오류를 줄이는 기법

- 현대 기계 학습은 앙상블도 규제로 여김

모델의 구성

- 서로 다른 신경망 여러 개를 학습

- 같은 구조를 사용하지만 다른 초기값과 하이퍼 매개변수를 다르게 설정하고 학습

예시

- 배깅bagging (훈련집합을 여러 번 샘플링하여 서로 다른 훈련집합을 구성)

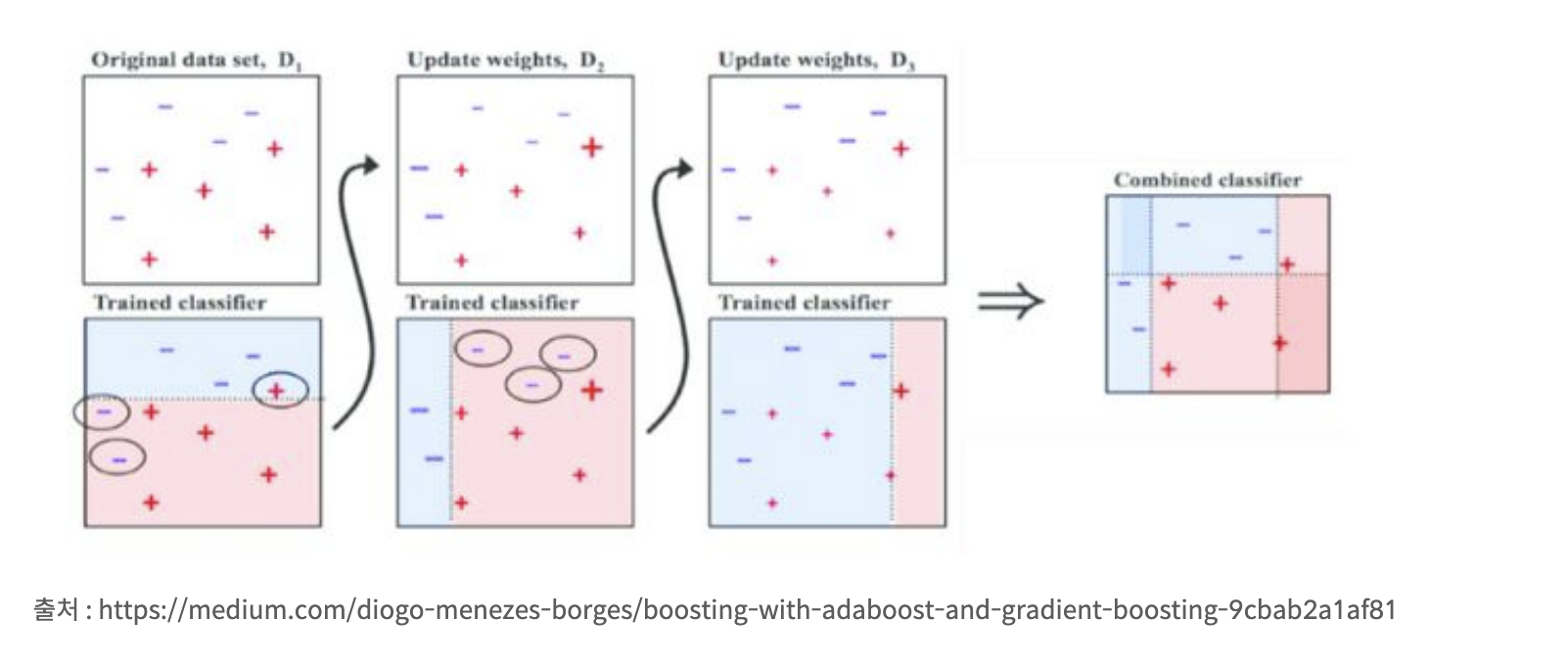

- 부스팅boosting(i번째 예측기가 틀린 샘플을 i+1번째 예측기가 잘 인식하도록 연계성을 고려, 나중에 합침)

모델 평균(model averaging)

- 여러 모델의 출력에서 평균을 구하거나 투표해 최종 결과 결정