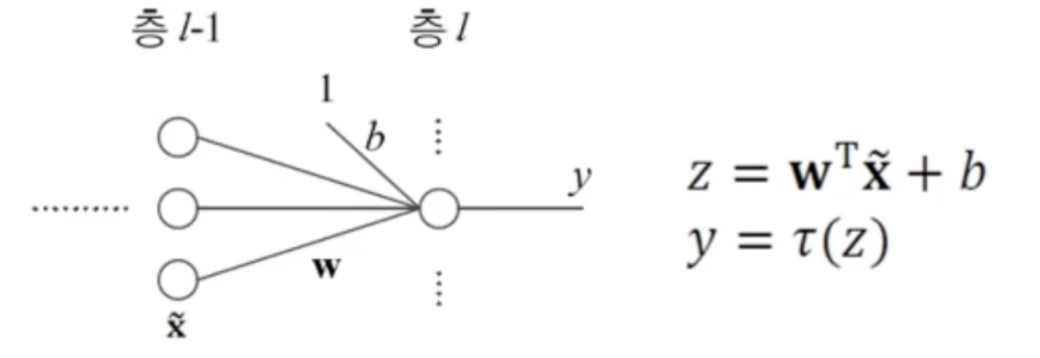

활성함수의 역할

- 입력값과 가중치를 곱해주고 활성함수를 위한 b(bias)를 더해준 값을 활성함수에 입력함

- 활성함수는 입력에 가중치가 곱해서 나온값의 정도를 결정해서 다음으로 넘겨줌!

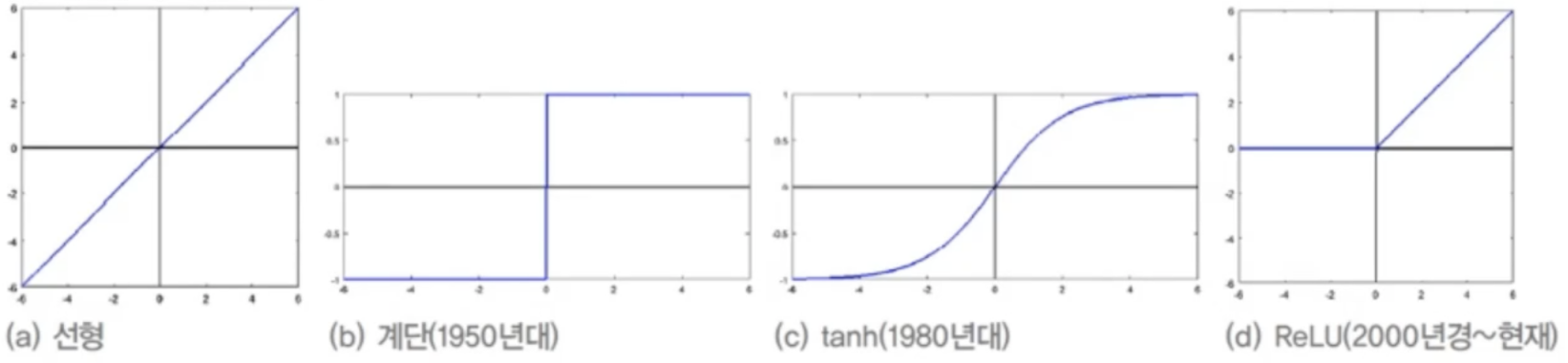

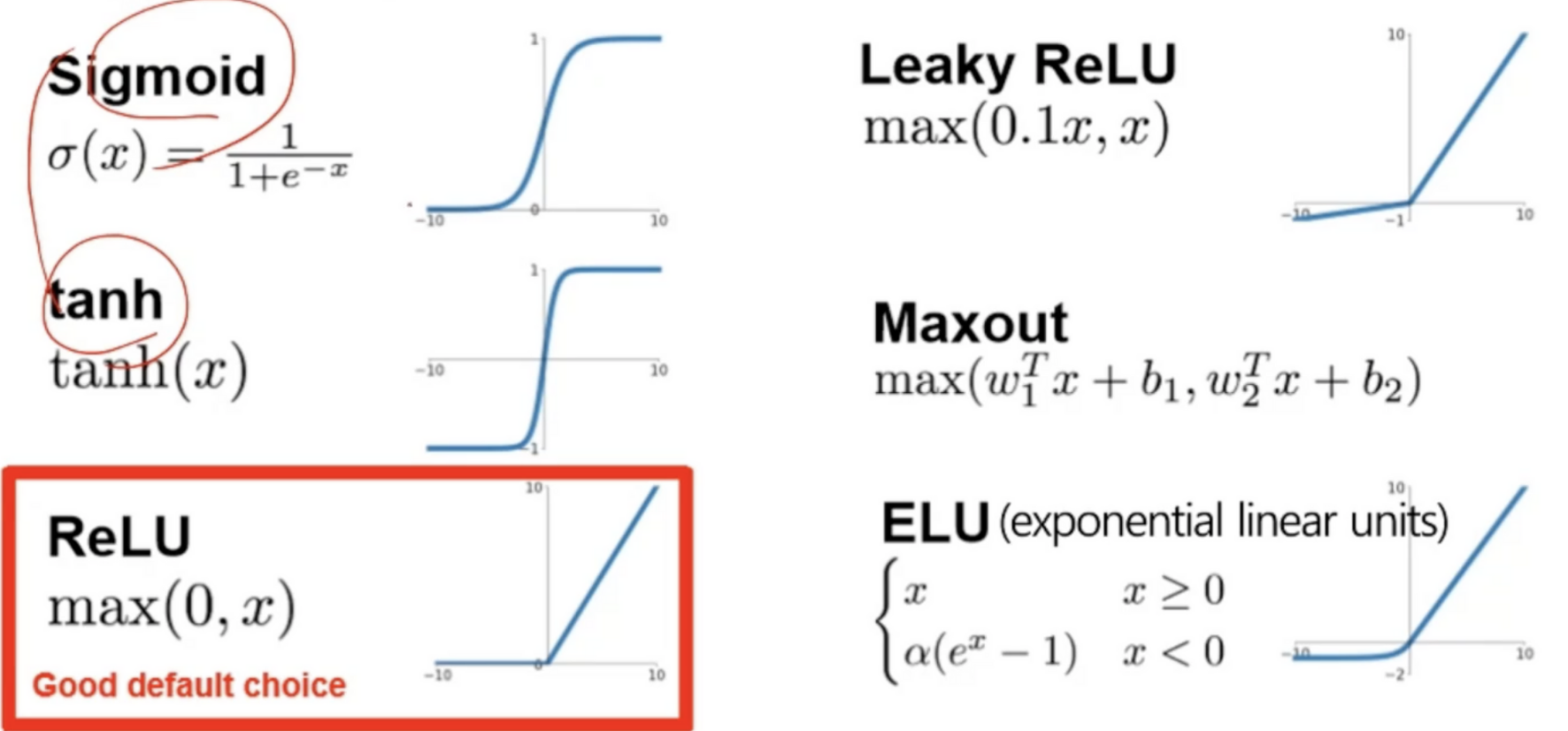

활성함수의 종류

- 선형함수에서 ReLU까지 활성함수가 발전해온 과정

- sigmoid와 계단함수 같은 경우 값이 너무 작거나 너무 커지면 미분값에서 경사도가 0에 가까운 값을 출력해 최저저점을 수렴하는 속도가 느려짐

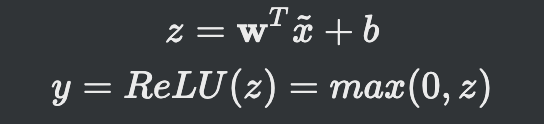

ReLU(Rectified Linear Unit) 활성함수

- ReLU함수를 거친 값은 0 미만의 값은 0으로 초과의 값은 입력값과 가중치를 내적하고 바이어스텀을 더한값으로 나가게 됨

- ReLU의 도함수를 보면 경사도 포화문제를 해소

- 일정 음수에 수치가 사라지는 문제가 남아있음

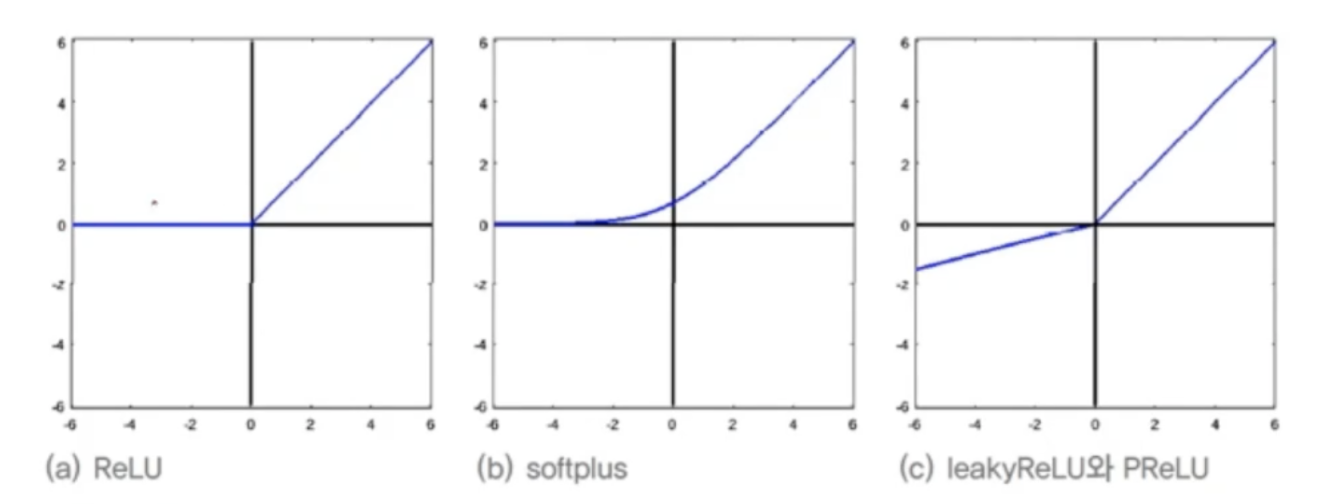

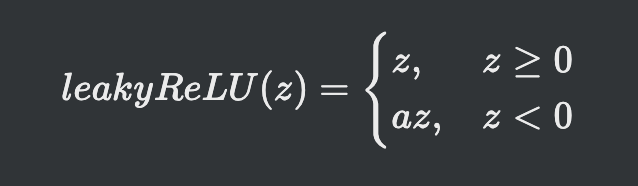

Leaky ReLU

- 0미만의 값은 a라는 계수를 곱한 음수의 상태를 유지함

- 보통 a = 0.01을 사용

- a를 학습으로 알아냄

활성함수 비교

- 경사도 문제를 해결하기 위한 여러가지 시도가 있엇고

- 현재는 ReLU 활성함수가 좋은 성능을 냄