현장 1~5까지의 데이터를 각 모델에 fine tuning한 결과로 model 1~5 그리고 all model 이렇게 5개의 모델이 생성됬다. 이렇게 생성된 모델의 정확도 수준을 분석했고 대부분의 모델이 수그린 자세에 대해 많이 학습되었고 fine tuning이 되지 않은 기존 모델로 구성한 데이터 셋과 대조했을 때 당연하게도 fine tuning 모델들의 정확도가 낮았다.

그 이유는 기존 모델은 학습이 적당히 진행되어 수그리는 동작이 진행됨에 따라 dumping confidence가 완만하게 증가했는데 fine tuning 모델들은 거의 다 수그린 상태에서야 dumping confidence가 확 증가하기 때문이다. 이렇게 되면 중간 동작에 대해서 fine tuning 모델들은 dumping으로 인식하지 못하게 된다. 하지만 이러한 점은 오검출에서 유리하게 작용할 수 있다. 아래 사진을 통해 실제 오검출 데이터를 fine tuning 모델로 inference한 결과를 확인하자.

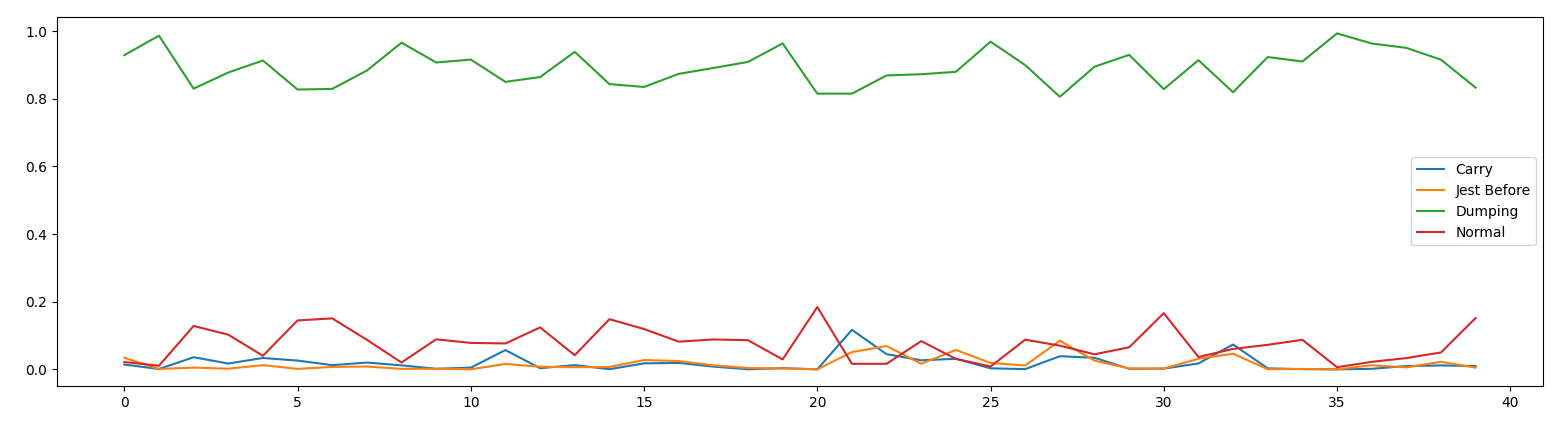

첫 번째 사진은 기존 모델의 오검출 결과로 실제 데이터의 라벨링은 모두 Normal이지만 dumping으로 판단하는 것을 확인할 수 있다. 같은 데이터를 fine tuning한 모델(all model)을 통해 inference한 결과가 두 번째 사진이다. 두 번째 사진을 보면 알 수 있듯이 모든 사진에 대해 Carry, 즉 Normal로 판단하는 것을 확인할 수 있다. 기존 모델이 모두 오검출한 것과는 대조되는 결과이다.

위 실험을 통해 알 수 있는 점은 fine tuning을 통해 확실히 Dumping이라는 Global Minimum에 더 가깝게 학습이 되었다는 점과 이를 통해 실제 오검출을 줄일 수 있었다는 점이다.

하지만 이렇게 학습되는 것이 마냥 좋은 것 만은 아닌 것이 FP는 줄였지만 FN이 늘어날 수도 있다. 실제로 FN 너무 늘어나게 되면 모델이 오버피팅된 것으로 볼 수 있다.