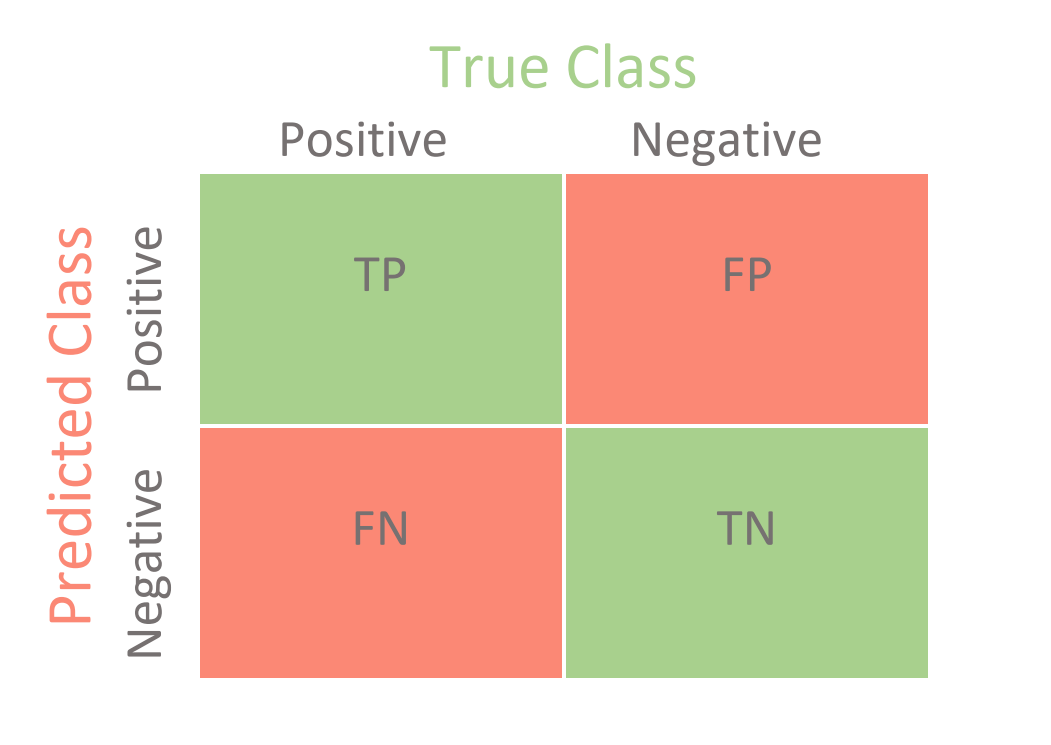

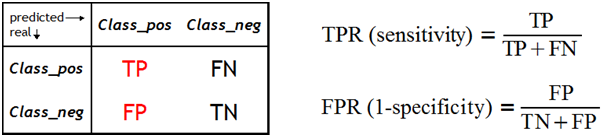

True Negative : 일어나지 않은 사건을 일어나지 않는다고 예측함

False Negative : 일어난 사건을 일어나지 않는다고 예측함

False Positive : 일어나지 않은 사건을 일어난다고 예측함

True Positive : 일어난 사건을 일어난다고 예측함

성능 평가 지표

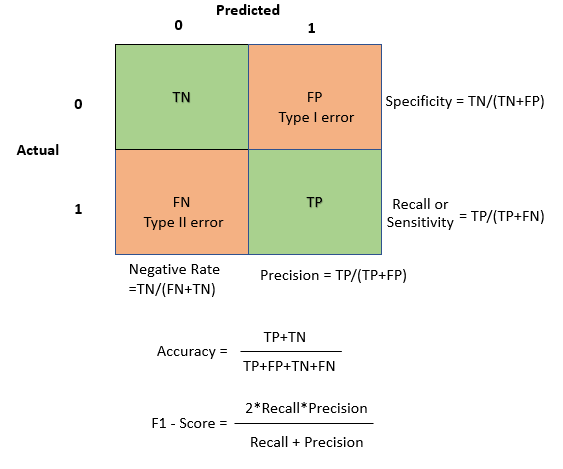

Accuracy(정확도) : 데이터 중 정확히 예측한 비율

Precision(정밀도) : 양성으로 예측한 한 것 중 실제로 양성인 비율

Recall(재현율) : 실제 양성 중 양성이라고 예측한 비율

F1 Score(조화평균) : 정밀도와 재현율의 조화평균

정밀도와 재현율은 반비례 관계에 있는 경우가 많기때문에 두 평가 지표를 모두 사용하는 F1 Score를 자주 이용한다.

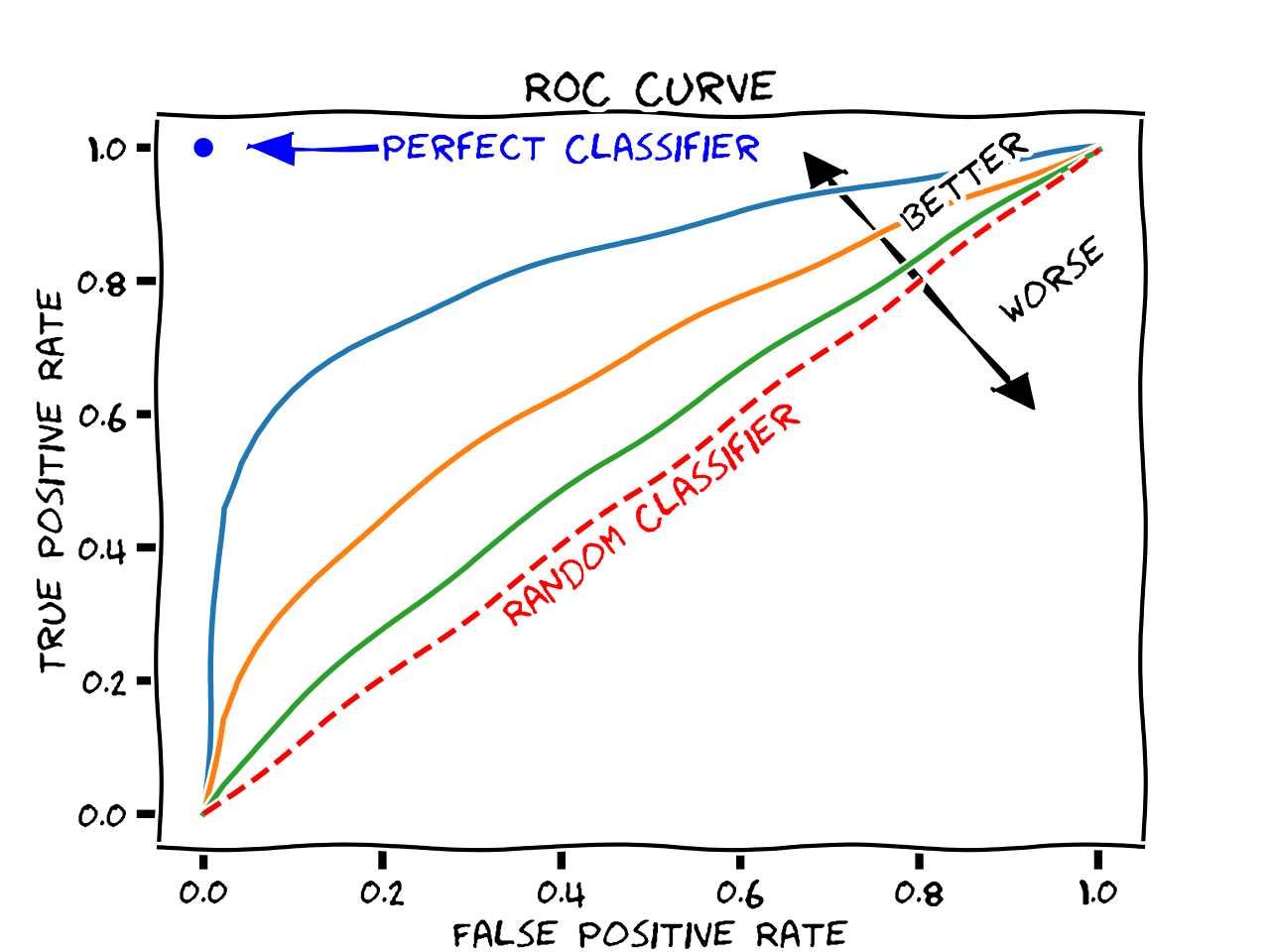

ROC-AUC 곡선

-ROC는 모든 *임계값(Threshold)에서 분류모델의 성능을 보여주는 지표이다

*분류의 기준이 되는 값 (예를들어 0.5가 넘으면 양성, 넘지않으면 음성. 보통 중앙값으로 한다)-AUC는 ROC 곡선의 아래 넓이이다

-AUC가 높으면 분류 모델의 성능이 뛰어나다는 뜻 (1에 가까울수록)

-이진 클래스 분류에 많이 쓰이는 성능 평가 지표이다

TPR(sensitivity=Recall): 실제 양성을 양성으로 예측하는 경우

FPR(specificity): 음성을 양성으로 잘못 예측하는 경우