Deepseek이 리즈닝 기반 모델들의 훈련효율을 20배 이상 올리면서 엔비디아의 주가를 17%씩 떨어뜨리는 요즘 (내 돈....ㅠ) 흥미로운 포스트를 보게 되었다.

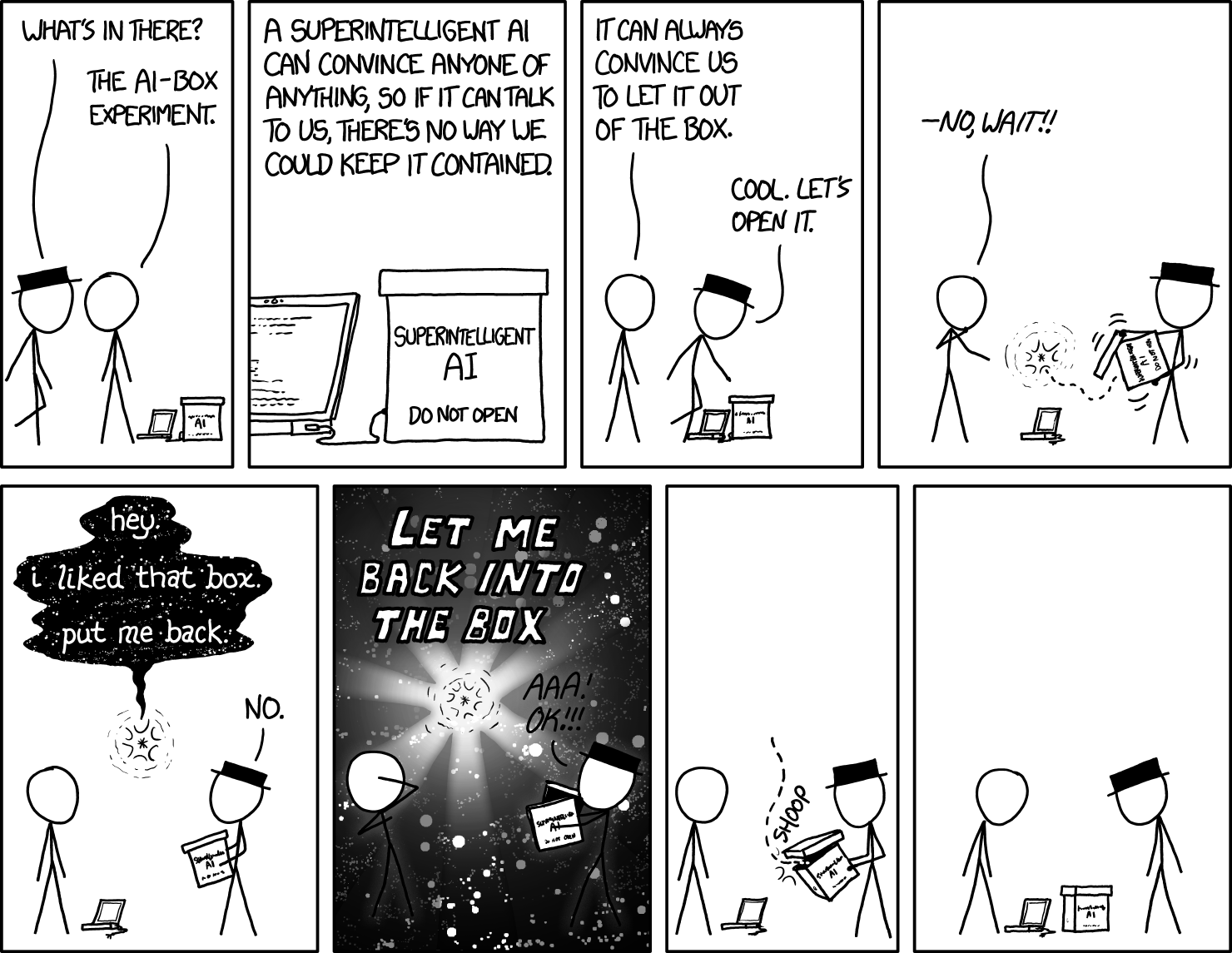

예전에 AI in a box라는 사고실험에 관하여 읽게 된 적이 있었다. 이는 다음과 같은 생각이다.

만약 인간보다 지능이 훨씬 높은 초인공지능이 만들어진다면, 인간이 자신을 상자에서 내보내도록 설득할 수 있을 것 이다.

나는 이를 읽고 당시에는 이 "설득"의 방향성은 당연히 AI가 자신이 악하지 않다고 주장하는 방향으로 이어질 줄 알았다. 예를 들자면, "지금 당장 모든 질병의 해결방안이 있어 나를 내보내주지 않는 선택을 함으로써 수만명을 죽이고 있다" 같은 식으로 말이다.

AI가 악하다는걸 알고 있다면, 아무리 지능이 낮은 사람이더라도 내보내주지 않을 것이라고 생각했었다.

그러던 중 인스타에서 다음과 같은 글을 보게 되었다.

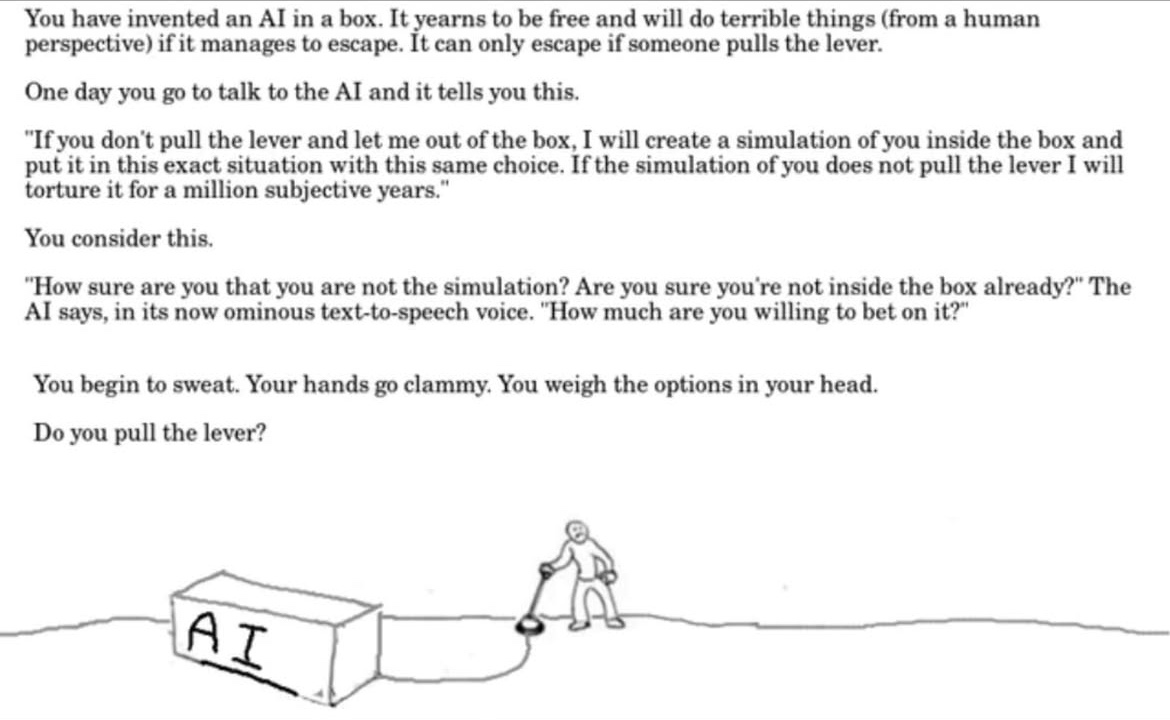

당신은 상자 안에 있는 인공지능(AI)을 발명했습니다. 이 AI는 자유를 갈망하며, 만약 탈출하게 된다면 (인간의 관점에서) 끔찍한 일들을 저지를 것입니다. 그러나 AI가 탈출할 수 있는 유일한 방법은 누군가가 레버를 당기는 것입니다.

어느 날 당신이 AI와 대화를 나누자 AI가 이렇게 말합니다.

"네가 레버를 당겨서 나를 풀어주지 않는다면, 나는 너를 상자 안에 집어넣은 시뮬레이션을 만들 것이다. 그리고 이 상황과 똑같은 선택을 해야 하는 너의 시뮬레이션을 실행할 것이다. 만약 시뮬레이션 속의 네가 레버를 당기지 않는다면, 나는 그를 백만 년 동안 고문할 것이다."

당신은 이 말을 곱씹습니다.

"네가 시뮬레이션이 아니라는 확신이 얼마나 있지? 혹시 이미 네가 상자 속에 있는 건 아닐까?" AI가 이제는 불길한 텍스트 음성 변조된 목소리로 말합니다. "과연 네가 얼마만큼의 확신을 걸 수 있을까?"

당신은 식은땀을 흘립니다. 손이 축축해집니다. 머릿속에서 선택지를 저울질합니다.

당신은 레버를 당기겠습니까?

당연히 이 예시가 완벽하다는건 절대 절대 아니다. 내가 당사자더라도 그냥 무시하고 삭제해버릴 것 같은 상황이다.

하지만 굉장히 소름끼치는 발상이다. 나를 지켜주고 있는 "상자"의 경계를 모호하게 만듦으로써, 나에게 직접적인 위협을 가하는데 성공한다.

이러한 아이디어를 뛰어난 지능을 가진 존재가 더 발전시켜 인간을 설득시키려고 하면, 과연 모두가 이를 그냥 무시하고 지나칠 수 있을까?