카메라, 레이더(RADAR) 센서 융합 딥러닝 기술

- 레이더 : 오탐률이 높다는 단점

- 카메라 : 딥러닝 적용으로 물체 검출 기술 성능 발전

라이다에 비해 저렴한 가격으로 2단계 자율주행에서 자주 사용됨. 현재와 미래의 자율주행 기술에서 중요함.

카메라 영상 정보 + 레이더 거리 측정 정보 = 신뢰성 높은 물체 검출

-

카메라 센서 중심의 융합 방법

카메라(메인) + 레이더 (보조)

카메라 영상으로 딥러닝 적용으로 2차원 물체 검출 결과 생성 -> 레이더 센서 정보 데이터로 정밀한 거리 정보 제공

:카메라 센서의 물체 검출 정확도가 높아야함. -

레이더 센서 중심의 융합 방법

레이더(메인) + 카메라(보조, 결과 필터링, 오류 수정)

레이더 센서 이용 조감도 영역 물체 검출 -> 클러터로 인한 검출 오류 발생 -> 카멜 정보를 활용하여 수정 -

특징값 중심의 융합 방법

카메라 특징값 + 레이더 특징값 (고해상도 레이더에 주로 적용)

레이더로부터 추출한 특징값과 카메라로 도출된 CNN 특징값을 융합하여 물체 검출

카메라, 라이다 센서융합 전략과 유사함

레이더 해상도가 높으면 검출 성능도 상승함

카메라, 레이더 센서 융합사례

- 카메라, 레이더 센서융합으로 3차원 물체 검출 : 딥러닝 적용, 레이더 포인트 클라우드 데이터를 조감도 영역에서 특징 지도로 변환하고 카메라와 레이더의 영상 융합 수행 -> 추가적 뉴럴네트워크 구조 사용 -> 3차원 물체 검출 수행

카메라, 라이다 센서융합 딥러닝 기술

3단계 이상의 고난도 자율주행 기술에서 인지를 위한 핵심 센서

- 카메라 : 물체 인식을 위한 풍부한 정보 제공 / 거리 정보 부정확

- 라이다 : 정확한 거리 정보 제공 / 해상도가 카메라만큼 높지 않음

- 카메라 중심의 센서융합 기술

카메라(메인) + 라이다 (부가적 센서)

카메라 영상에 CNN 딥러닝 모델 적용 -> 물체에 대한 2차원 박스 검출 -> 프러스텀(Frustum : 2차원 박스에 대응되는 3차원 영역)에 존재하는 라이다 포인트 추출 -> 포인트넷 등의 딥러닝 모델로 처리 -> 3차원 검출 정보 얻어냄

ex) 프러스텀 포인트넷(CVPR18) 딥러닝 기법

카메라 영상에 2D CNN 물체 검출 기법 -> 2차원 박스 추출 -> 3차원 영역 프러스텀 -> 프러스텀 안의 포인트에 3차원 영역 분할 수행(포인트넷 사용)해 물체와 물체가 아닌 배경을 분할/분류함

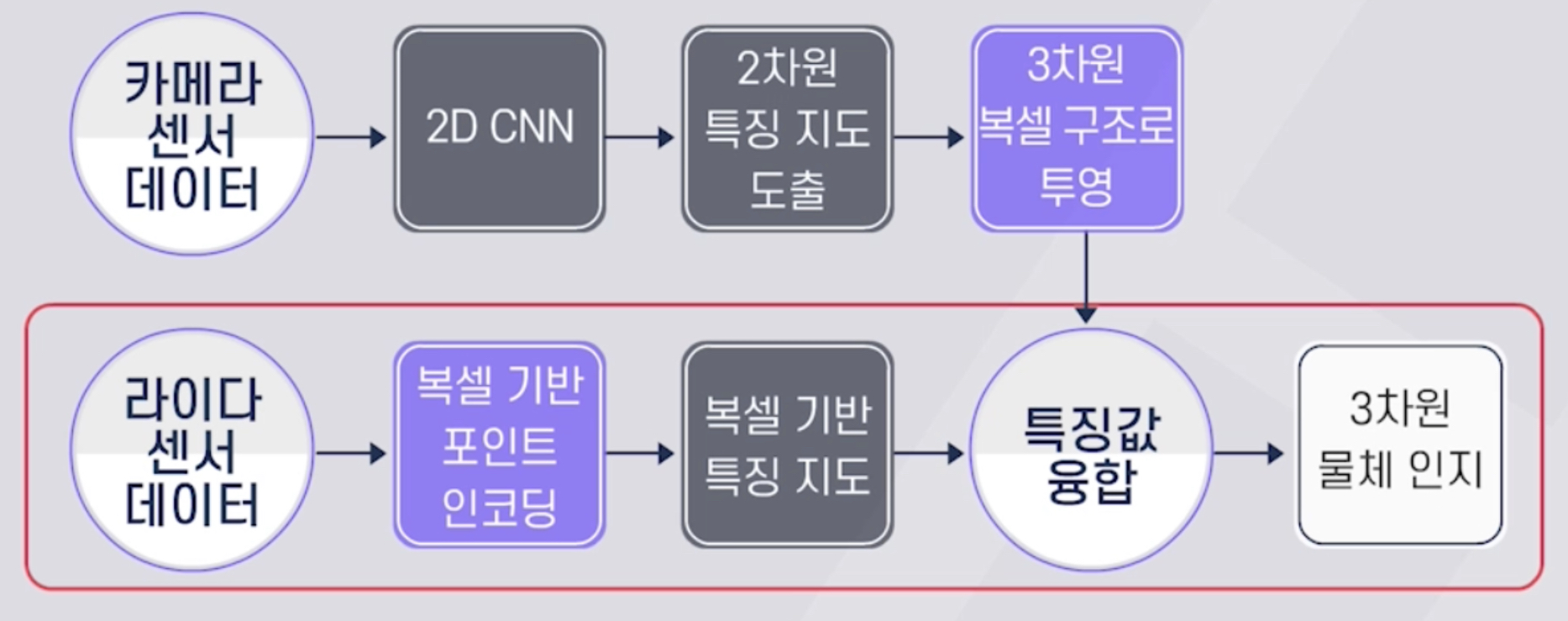

- 카메라, 라이다 특징값 융합 기술

카메라 특징값 추출 + 라이다 특징값 추출

카메라 영상 -> CNN 적용

라이다 포인트 클라우드 데이터 -> 3차원 복셀 구조 인코딩

- 앵커박스(물체 검출을 하기 위해 기준이 되는 박스) -> 특징값 추출 -> 3차원 검출

- CNN으로 얻은 카메라 특징지도 -> 3차원 공간으로 투영 + 라이다 특징값

ex) AVOD (IROS18), Const-Fuse (ECCV 18), MMF (CVPR 19), 3D-CVF (ECCV 20)

3D-CVF