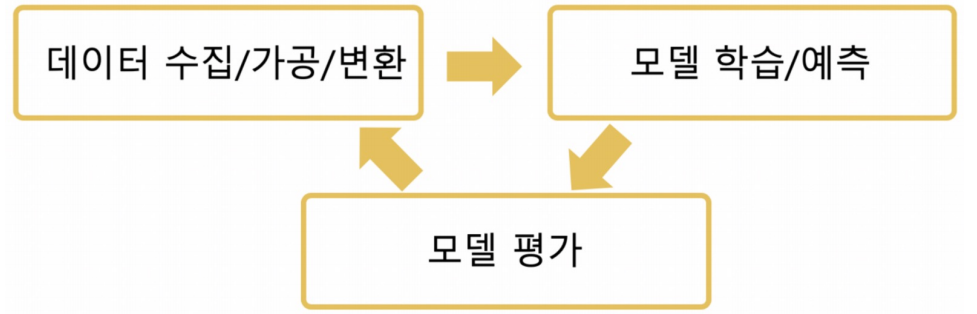

모델 평가의 개념

여전히 우리가 만든 모델은 얼마나 좋은 것일까?

- 모델을 좋다, SOSO, 나쁘다 등으로 평가할 방법은 없다.

- 대부분 다양한 모델, 다양한 파라미터를 두고, 상대적으로 비교한다.

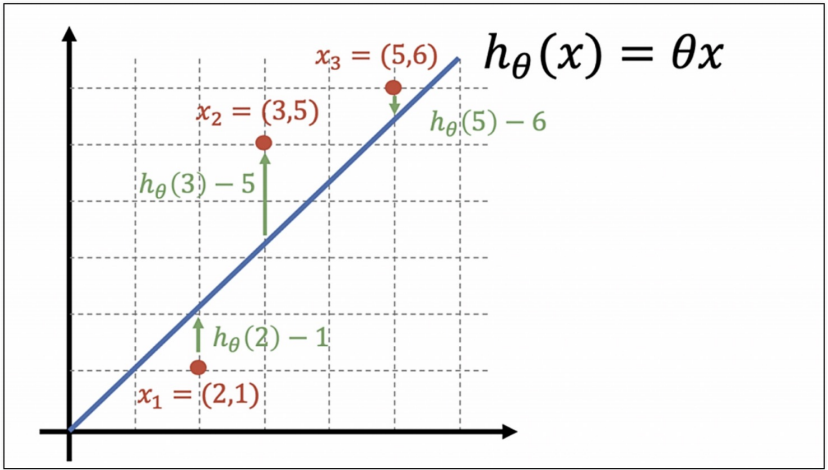

회귀모델들은 실제 값과의 에러치를 가지고 계산

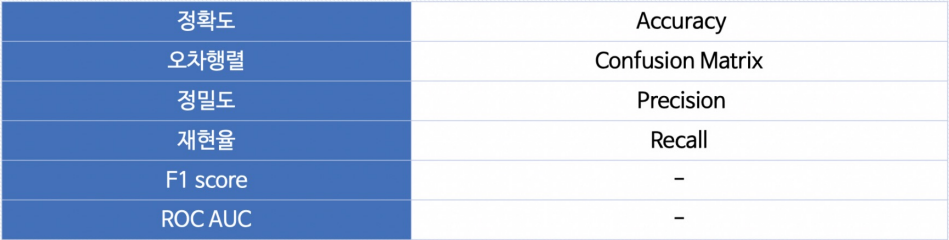

분류 모델의 평가 항목이 조금 많음

이진 분류 모델의 평가

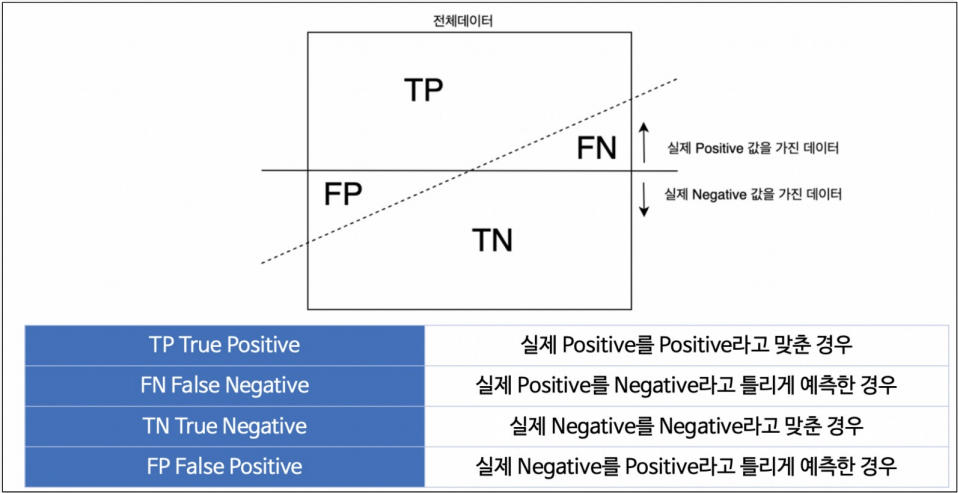

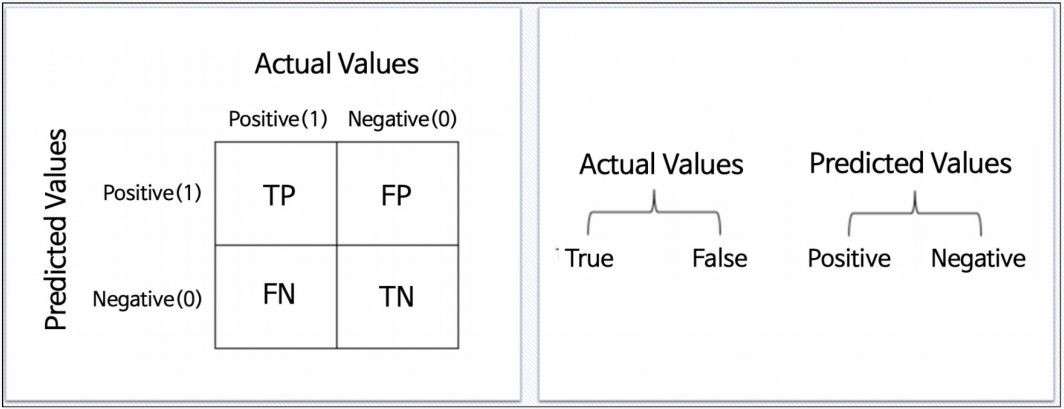

이진 분류에서 predict vs real

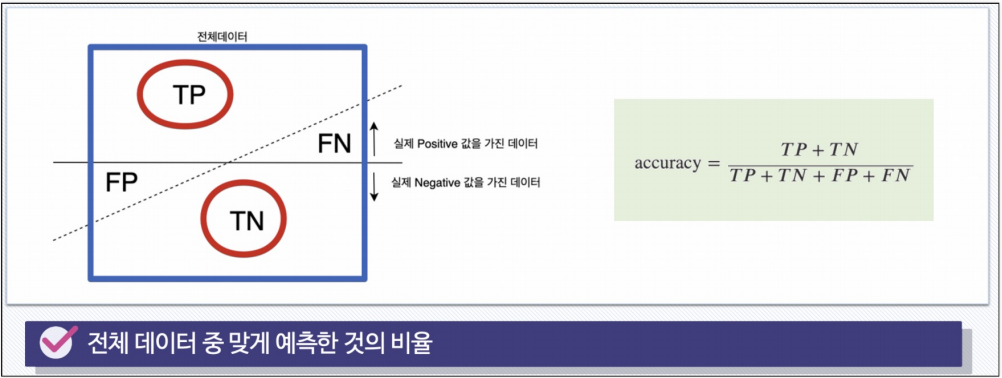

Accuracy

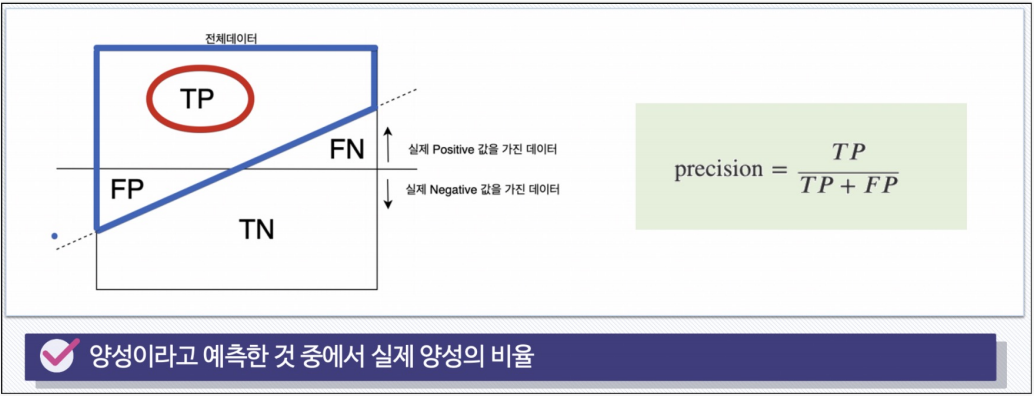

Precision

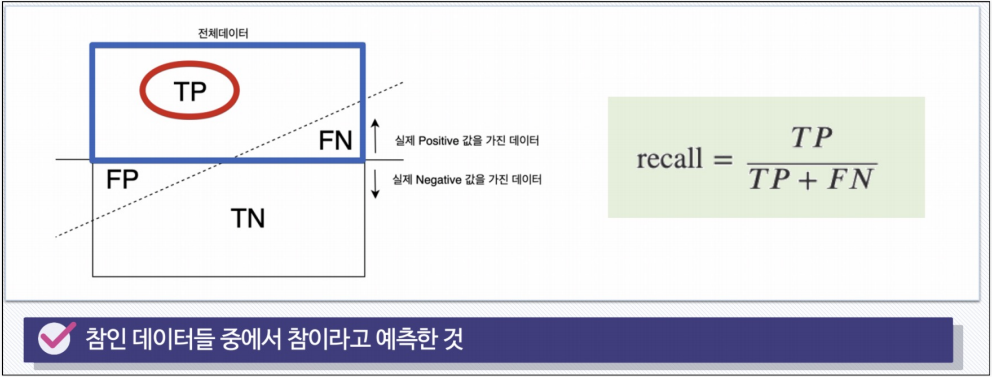

RECALL (TPR TRUE POSITIVE RATIO)

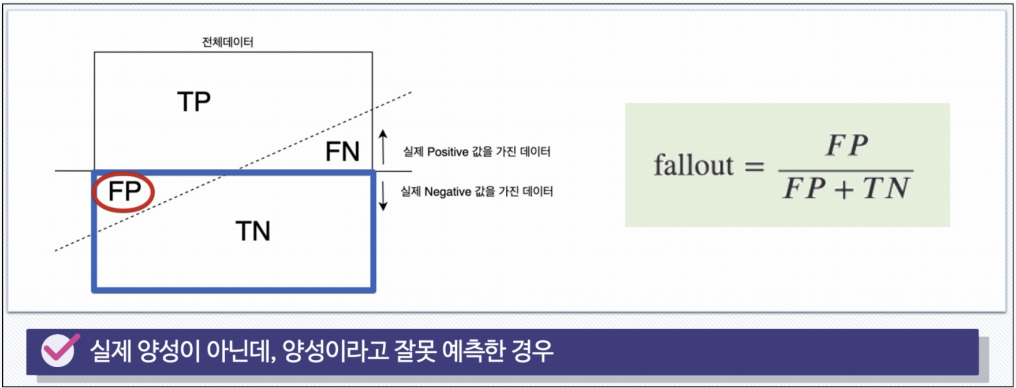

FALL-OUT (FPR FALSE POSITION RATIO)

분류모델은 그 결과를 속할 비율(확률)을 반환한다

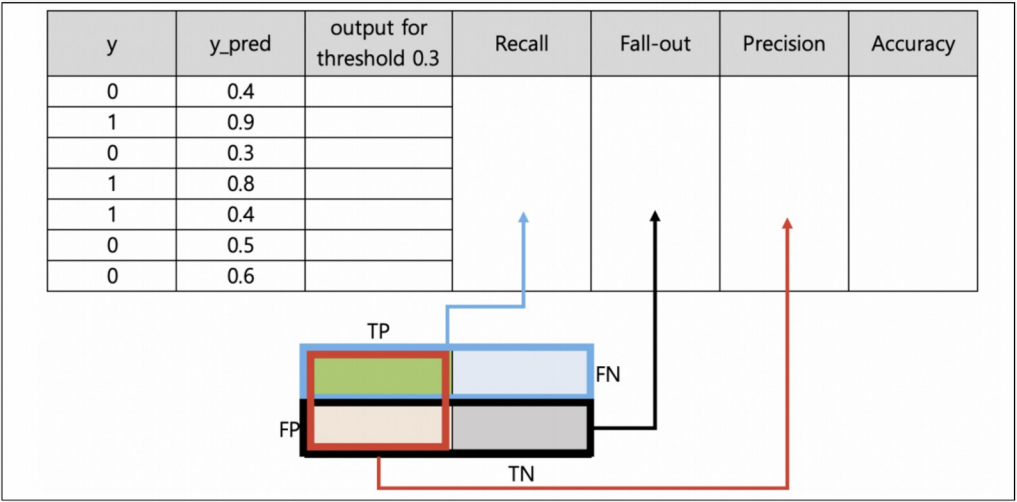

지금까지는 그 비율에서 threshold를 0.5라고 하고 0, 1로 결과를 반영했다. (if 이진분류)

iris의 경우 가장 높은 확률값이 있는 클래스를 해당 값이라고 했다.

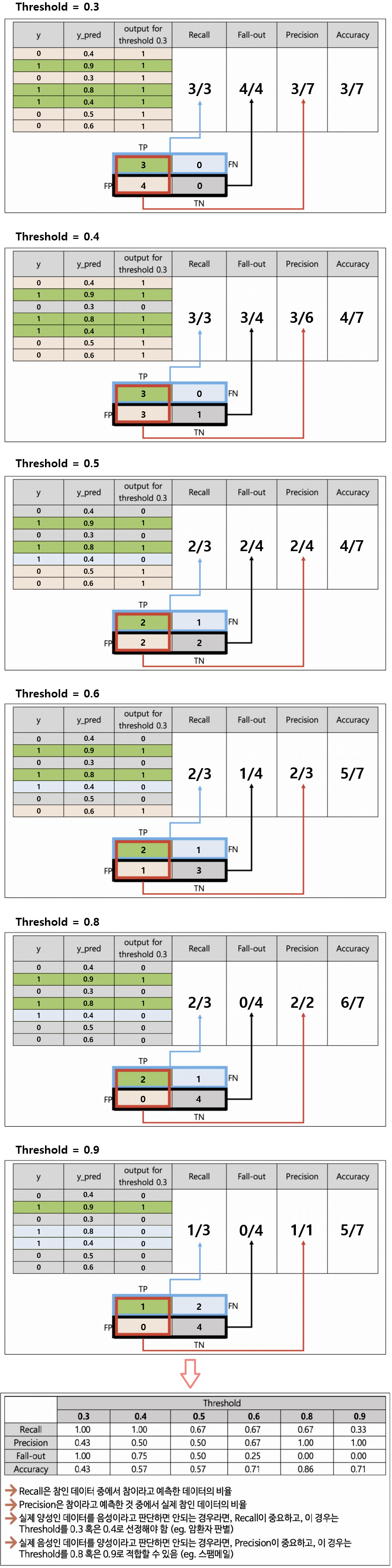

threshold를 변경해 가면서 모델 평가 지표들을 관찰

- 예제

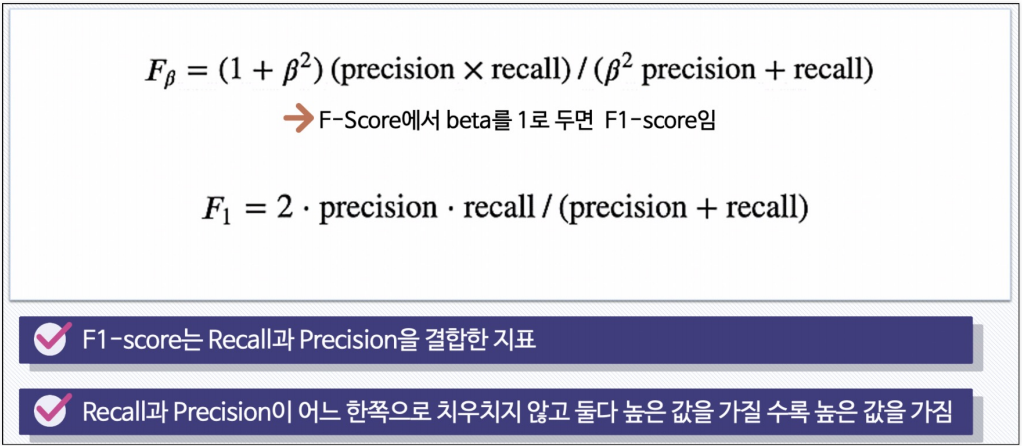

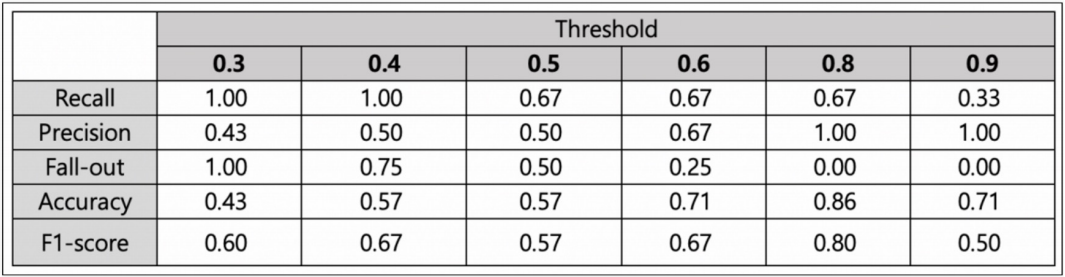

F1-Score

- 예제

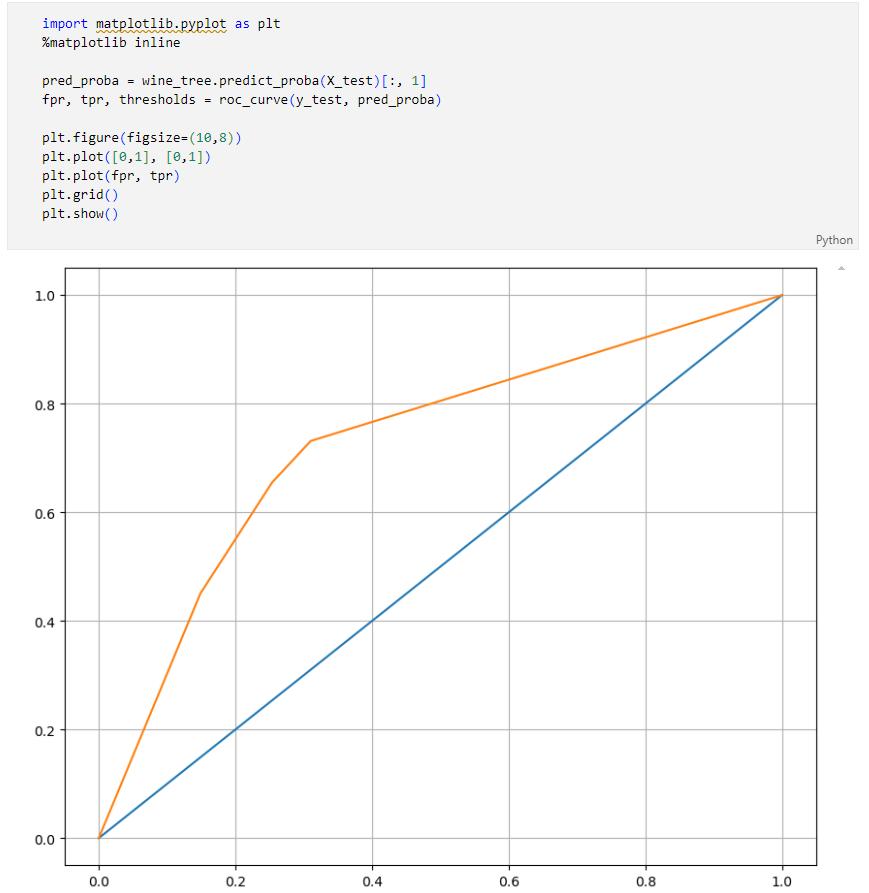

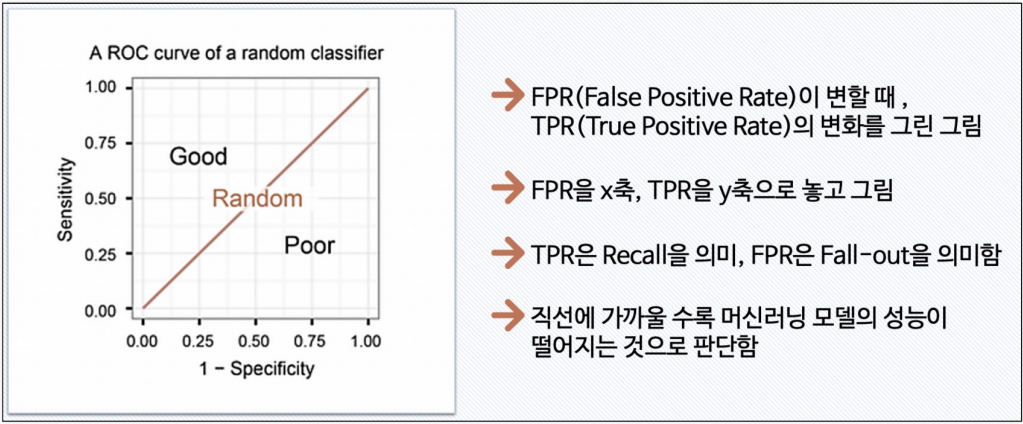

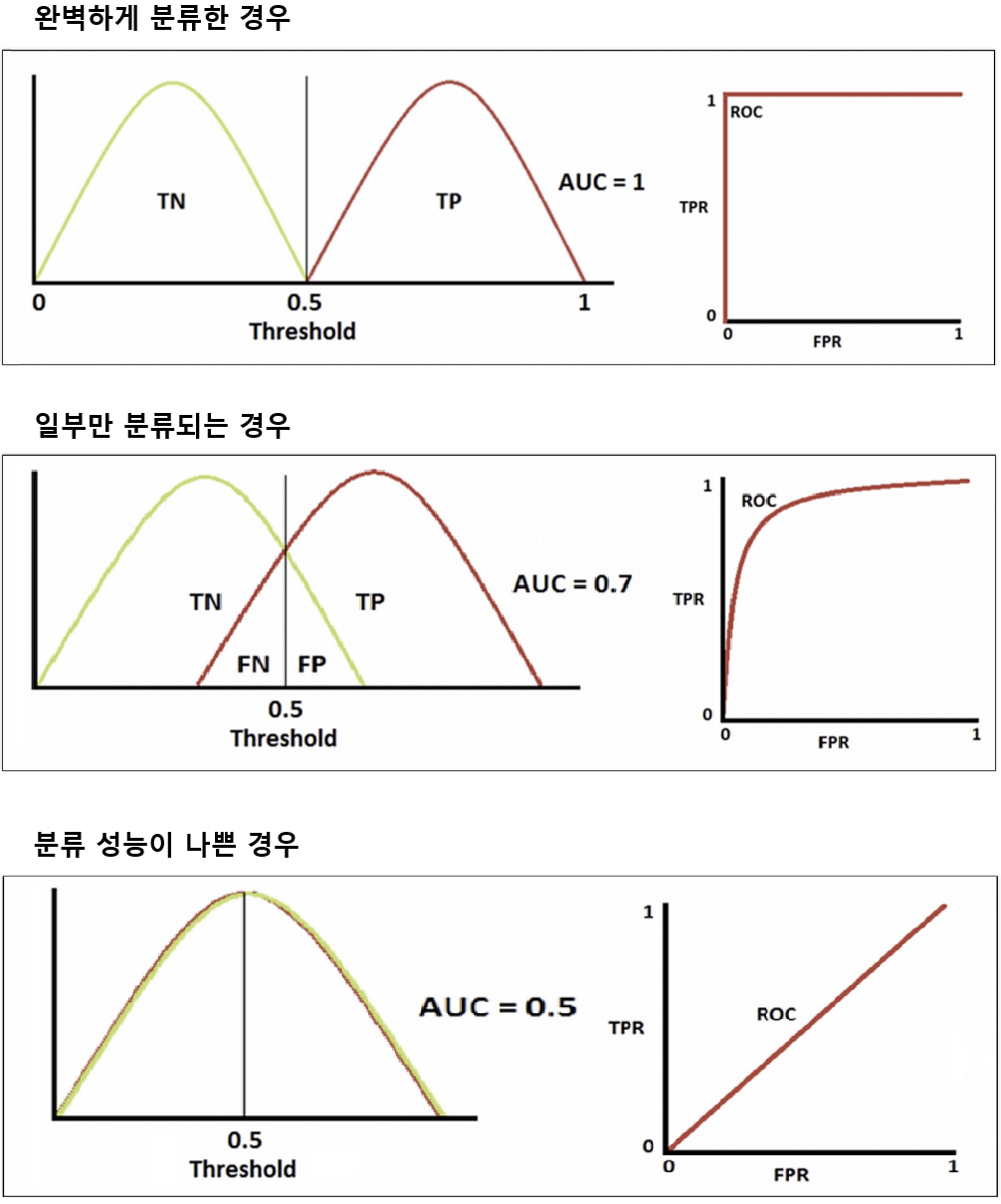

ROC와 AUC

ROC 곡선

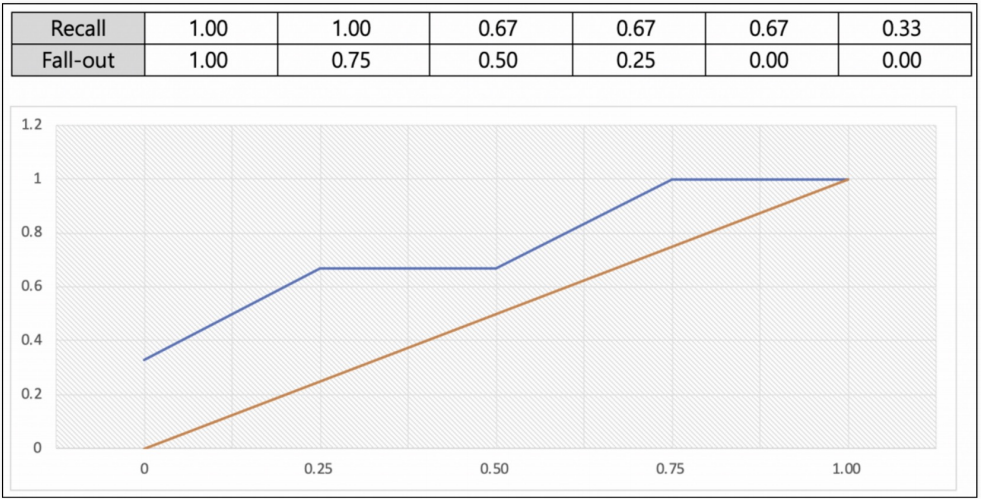

- 예제

- 방금 전 예제에서의 ROC 곡선

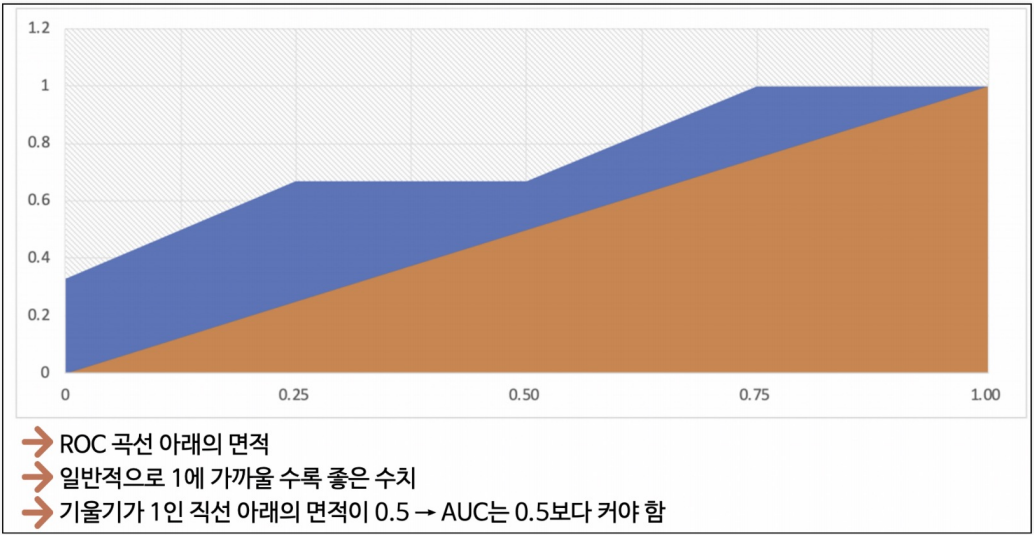

AUC

ROC 커브 그려보기

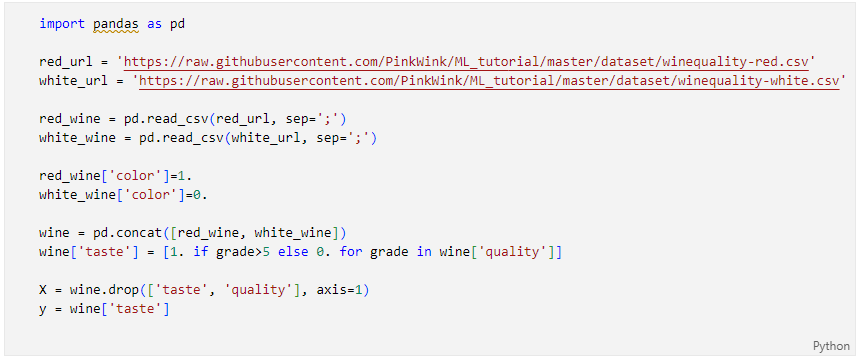

데이터 읽어보기

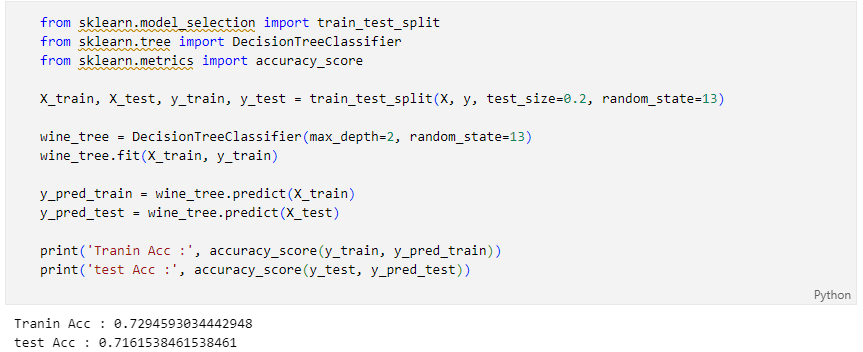

간단히 결정나무 적용

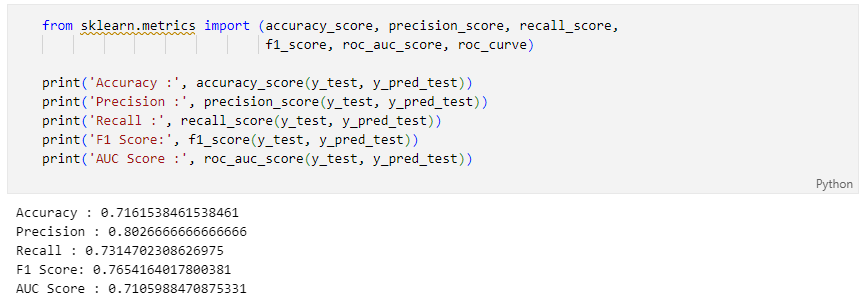

각 수치 계산

ROC 커브