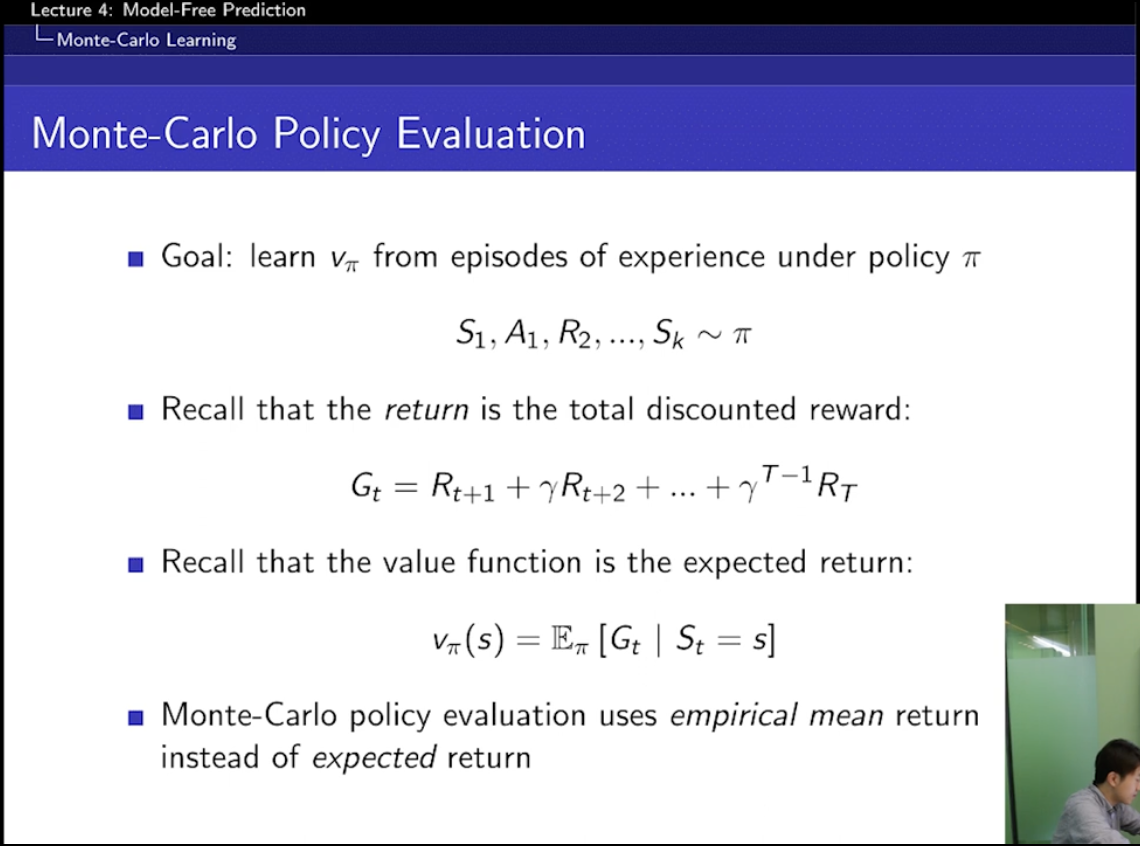

어떻게 prediction을 할까?

environment가 모르는데 어떻게?해?!

몬테카를로!

Temporal Difference!

몬테카를로 : 세보는 거!

아 이렇네~~

policy를 따라서 계속 해보고,

return들을 평균 내보는 것!

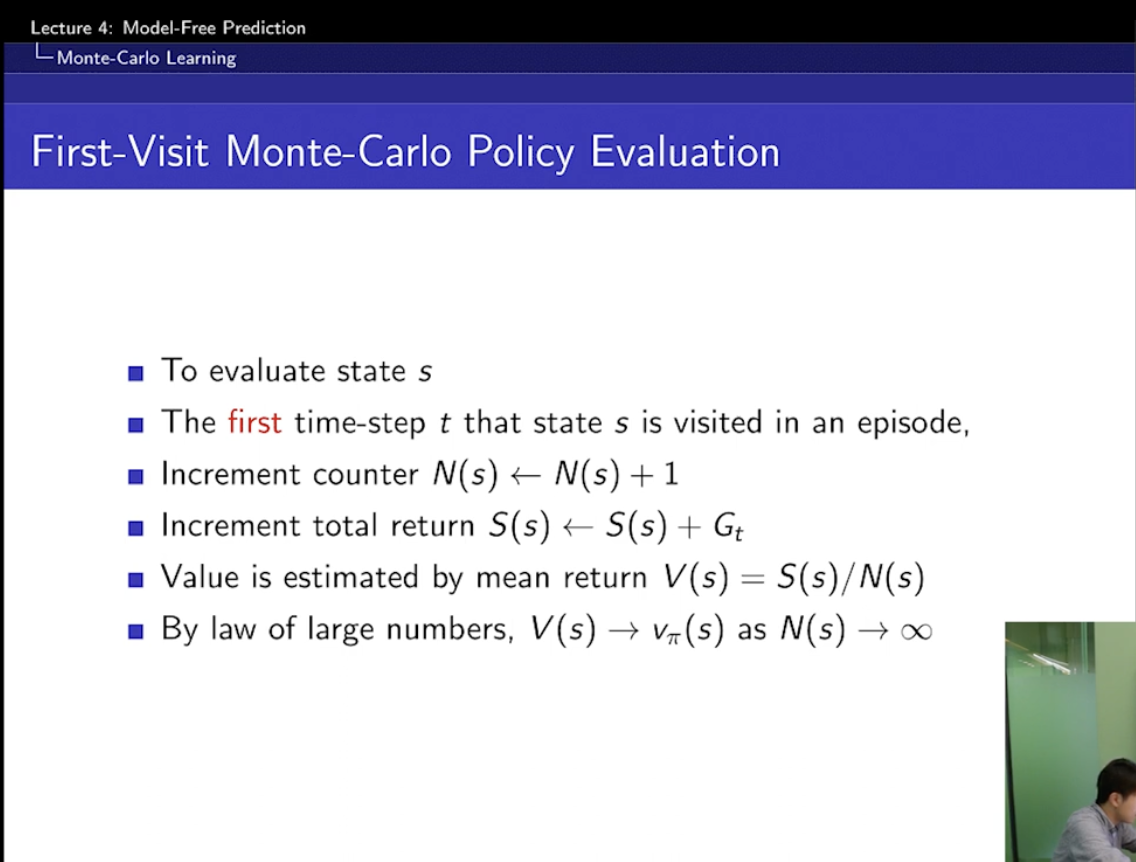

처음 방문한 것만 쳐주는 게 first-visit MC!

=> 방문한 모든 타임스텝을 고려하는 게 아니라 각 상태를 에피소드에서 처음 방문했을 때만 업데이트하는 방식

에피소드 경로: S1 → S2 → S3 → S2 → S4 (종료)

보상: 0 → 1 → -1 → 2 → 3

First-Visit MC는 S2를 두 번째 방문했을 때(보상 2)를 무시하고, 첫 방문 시점(보상 1)만 반영.

Every-Visit MC는 S2에서 두 번 방문한 모든 보상을 업데이트함.

일단 왜 counter가 필요한지...?

이렇게 측정을 해야하기 때문에 필요한 것!

- Increment Counter (방문 횟수 증가)

특정 상태 S가 방문될 때마다 그 상태의 방문 횟수를 증가시키는 과정.

즉, 해당 상태가 몇 번 방문되었는지 기록하는 변수.

- Increment Total Return (총 보상 업데이트)

상태 S를 방문했을 때, 해당 에피소드에서 얻은 총 보상(return)을 업데이트하는 과정.

이 값을 누적해서 평균을 계산하면 상태 가치 V(S) 를 추정할 수 있음.

아직도 왜 몬테카를로여야하는지?

✅ 몬테카를로 방법이 RL에서 하는 일

1. 에피소드(게임 한 판)를 여러 번 실행

2. 각 상태에서 받는 총 보상(return)을 기록

3. 여러 번 실행한 결과를 평균 내서 상태 가치 V(S) 를 추정

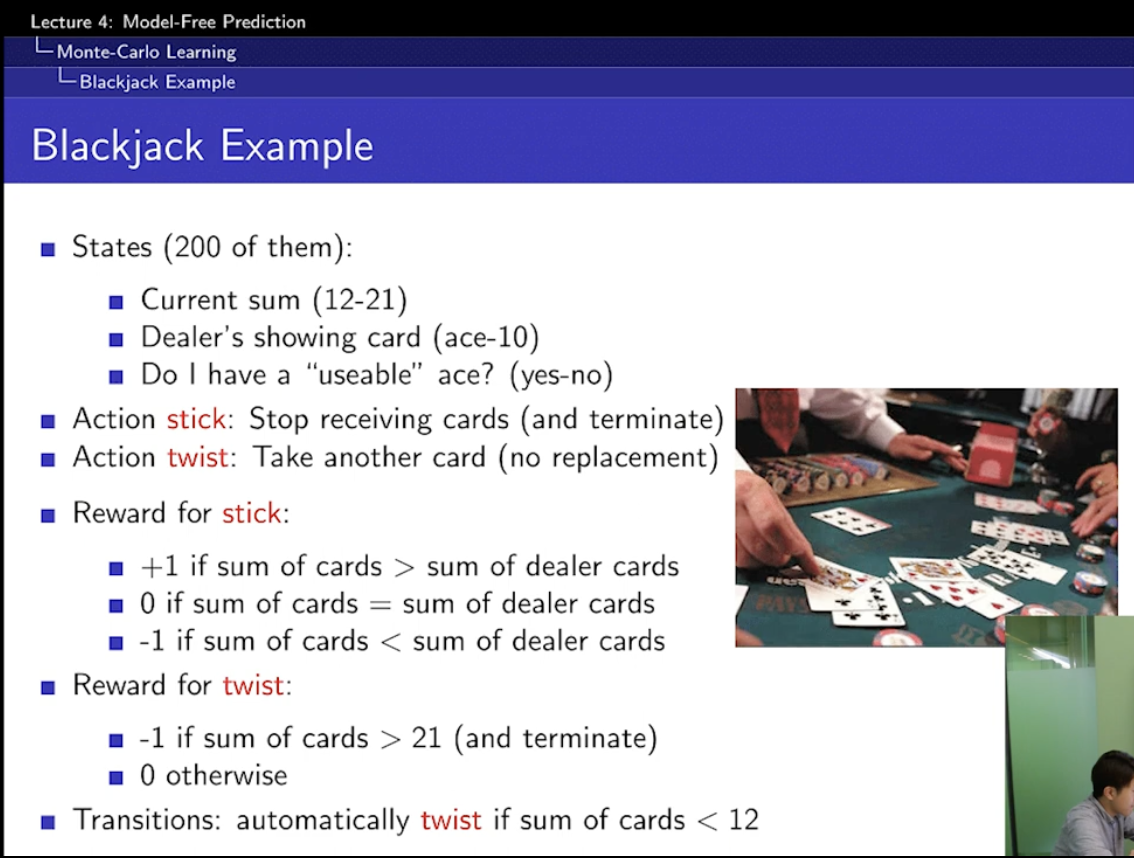

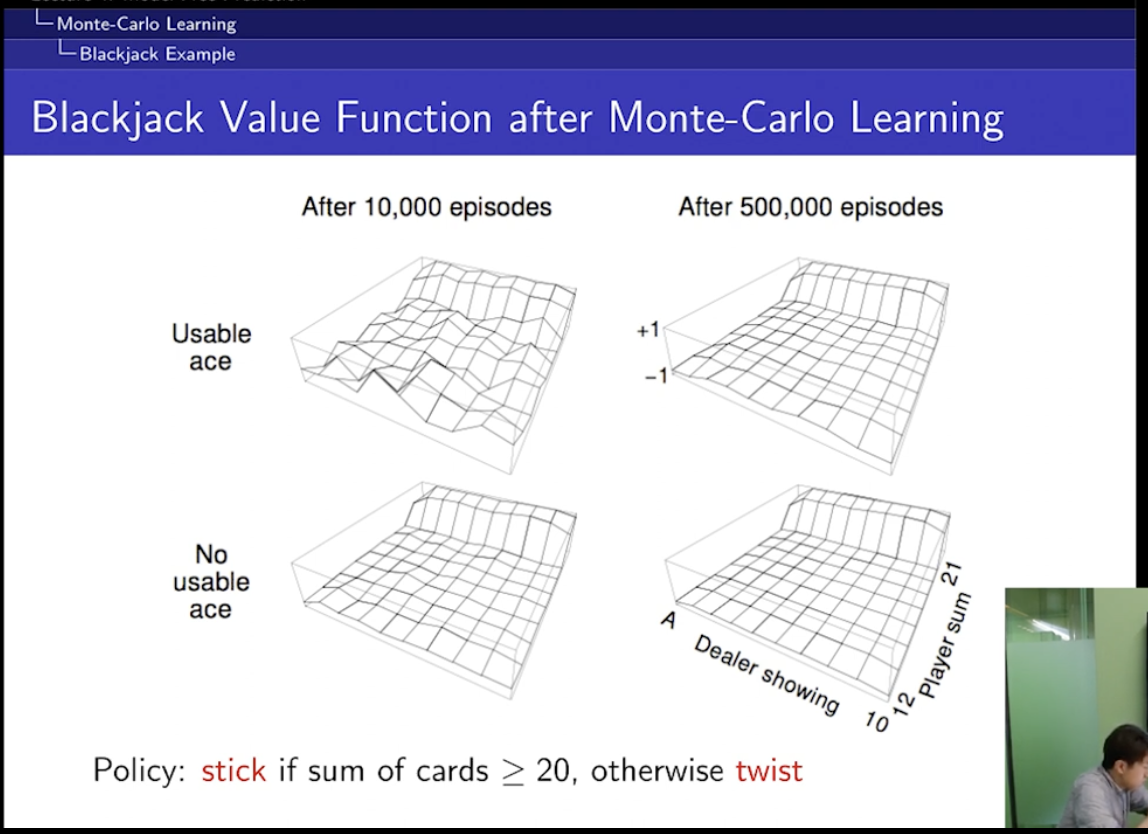

Blackjack Example

action1 stick - 카드 받기 stop!

action2 twist - 카드 받기

reward는 규칙에 따라...

-> 이게 뭐지

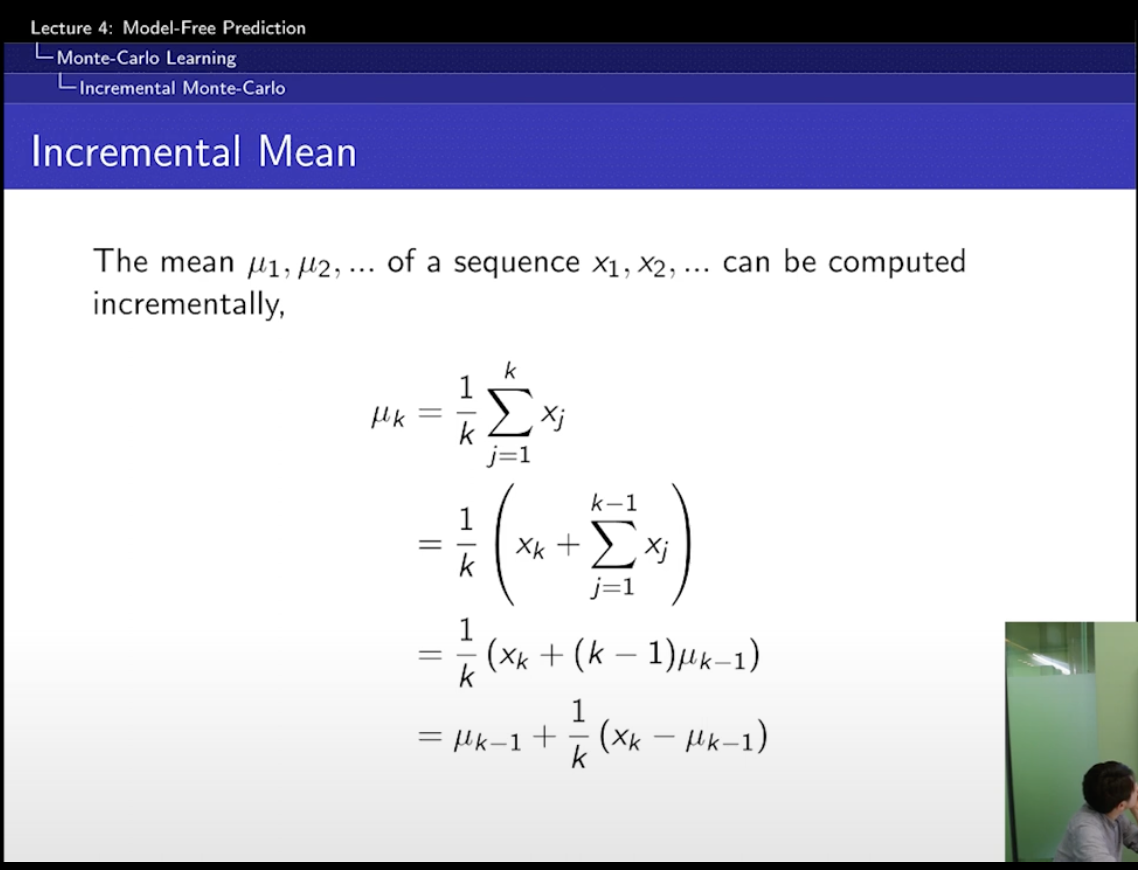

x=1부터 x=k까지의 평균