학습목표

시맨틱 세그멘테이션 데이터셋을 전처리할 수 있습니다.

시맨틱 세그멘테이션 모델을 만들고 학습할 수 있습니다.

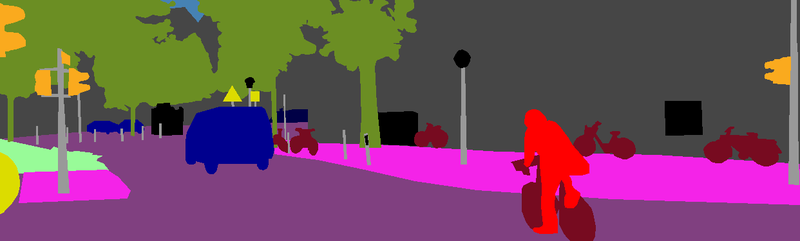

시맨틱 세그멘테이션 모델의 결과를 시각화할 수 있습니다.

학습내용

시맨틱 세그멘테이션 데이터셋

시맨틱 세그멘테이션 모델

시맨틱 세그멘테이션 모델 시각화

시맨텍 세그멘테이션 데이터셋

이미지, 데이터 가져오기

시맨틱 세그멘테이션으로 도로의 영역을 분리하기 위해 도로의 영역을 라벨로 가진 데이터셋을 가지고 학습하도록 파싱이 필요합니다.

KITTI 데이터셋의 세그멘테이션 데이터를 다운로드하겠습니다.

*KITTI

*Segmentation

*Segmentation rgb

! mkdir -p ~/aiffel/semantic_segmentation/data

! ln -s ~/data/* ~/aiffel/semantic_segmentation/data/데이터 로더 만들기

모델을 학습시킬 데이터 로더를 만듭니다.

입력값(224,224) , 출력값(224,224)크기 갖는 모델을 학습 시키도록 데이터셋을 파싱합니다.

Augmentation을 적용합니다.

! pip list | grep albumentations학습셋의 일정량을 검증데이터셋으로 활용합니다.

파싱을 잘하면 오류가 거의 없고 설사 생겨도 문제를 찾기 쉽습니다.

#필요한 라이브러리를 로드합니다.

import os

import math

import numpy as np

import tensorflow as tf

from PIL import Image

import matplotlib.pyplot as plt

from skimage.io import imread

from skimage.transform import resize

from glob import glob

from tensorflow.keras.models import *

from tensorflow.keras.layers import *

from tensorflow.keras.optimizers import *

print('슝=3')Albumentation의 사용법입니다.

Albumentation에 다양한 augmentation기법을 확률적으로 적용하여 Compose()의 활용예시입니다.

from albumentations import HorizontalFlip, RandomSizedCrop, Compose, OneOf, Resize

def build_augmentation(is_train=True):

if is_train: # 훈련용 데이터일 경우

return Compose([

HorizontalFlip(p=0.5), # 50%의 확률로 좌우대칭

RandomSizedCrop( # 50%의 확률로 RandomSizedCrop

min_max_height=(300, 370),

w2h_ratio=370/1242,

height=224,

width=224,

p=0.5

),

Resize( # 입력이미지를 224X224로 resize

width=224,

height=224

)

])

return Compose([ # 테스트용 데이터일 경우에는 224X224로 resize만 수행합니다.

Resize(

width=224,

height=224

)

])import os

dir_path = os.getenv('HOME')+'/aiffel/semantic_segmentation/data/training'

augmentation = build_augmentation()

input_images = glob(os.path.join(dir_path, "image_2", "*.png"))

# 훈련 데이터셋에서 5개만 가져와 augmentation을 적용해 봅시다.

plt.figure(figsize=(12, 20))

for i in range(5):

image = imread(input_images[i])

image_data = {"image":image}

resized = augmentation(**image_data, is_train=False)

processed = augmentation(**image_data)

plt.subplot(5, 2, 2*i+1)

plt.imshow(resized["image"]) # 왼쪽이 원본이미지

plt.subplot(5, 2, 2*i+2)

plt.imshow(processed["image"]) # 오른쪽이 augment된 이미지

plt.show()

class KittiGenerator(tf.keras.utils.Sequence):

'''

KittiGenerator는 tf.keras.utils.Sequence를 상속받습니다.

우리가 KittiDataset을 원하는 방식으로 preprocess하기 위해서 Sequnce를 커스텀해 사용합니다.

'''

def __init__(self,

dir_path,

batch_size=16,

img_size=(224, 224, 3),

output_size=(224, 224),

is_train=True,

augmentation=None):

'''

dir_path: dataset의 directory path입니다.

batch_size: batch_size입니다.

img_size: preprocess에 사용할 입력이미지의 크기입니다.

output_size: ground_truth를 만들어주기 위한 크기입니다.

is_train: 이 Generator가 학습용인지 테스트용인지 구분합니다.

augmentation: 적용하길 원하는 augmentation 함수를 인자로 받습니다.

'''

self.dir_path = dir_path

self.batch_size = batch_size

self.is_train = is_train

self.dir_path = dir_path

self.augmentation = augmentation

self.img_size = img_size

self.output_size = output_size

# load_dataset()을 통해서 kitti dataset의 directory path에서 라벨과 이미지를 확인합니다.

self.data = self.load_dataset()

def load_dataset(self):

# kitti dataset에서 필요한 정보(이미지 경로 및 라벨)를 directory에서 확인하고 로드하는 함수입니다.

# 이때 is_train에 따라 test set을 분리해서 load하도록 해야합니다.

input_images = glob(os.path.join(self.dir_path, "image_2", "*.png"))

label_images = glob(os.path.join(self.dir_path, "semantic", "*.png"))

input_images.sort()

label_images.sort()

assert len(input_images) == len(label_images)

data = [ _ for _ in zip(input_images, label_images)]

if self.is_train:

return data[:-30]

return data[-30:]

def __len__(self):

# Generator의 length로서 전체 dataset을 batch_size로 나누고 소숫점 첫째자리에서 올림한 값을 반환합니다.

return math.ceil(len(self.data) / self.batch_size)

def __getitem__(self, index):

# 입력과 출력을 만듭니다.

# 입력은 resize및 augmentation이 적용된 input image이고

# 출력은 semantic label입니다.

batch_data = self.data[

index*self.batch_size:

(index + 1)*self.batch_size

]

inputs = np.zeros([self.batch_size, *self.img_size])

outputs = np.zeros([self.batch_size, *self.output_size])

for i, data in enumerate(batch_data):

input_img_path, output_path = data

_input = imread(input_img_path)

_output = imread(output_path)

_output = (_output==7).astype(np.uint8)*1

data = {

"image": _input,

"mask": _output,

}

augmented = self.augmentation(**data)

inputs[i] = augmented["image"]/255

outputs[i] = augmented["mask"]

return inputs, outputs

def on_epoch_end(self):

# 한 epoch가 끝나면 실행되는 함수입니다. 학습중인 경우에 순서를 random shuffle하도록 적용한 것을 볼 수 있습니다.

self.indexes = np.arange(len(self.data))

if self.is_train == True :

np.random.shuffle(self.indexes)

return self.indexesaugmentation = build_augmentation()

test_preproc = build_augmentation(is_train=False)

train_generator = KittiGenerator(

dir_path,

augmentation=augmentation,

)

test_generator = KittiGenerator(

dir_path,

augmentation=test_preproc,

is_train=False

)시맨틱 세그멘테이션 모델

모델 구조 만들기

세그멘테이션 모델 중 구조상으로 단순한 U-Net구현입니다.

입력 이미지의 크기는(224,224)

필요에따라 dropout등의 다른 레이어도 적용할 수 있습니다.

def build_model(input_shape=(224, 224, 3)):

inputs = Input(input_shape)

#Contracting Path

conv1 = Conv2D(64, 3, activation='relu', padding='same',kernel_initializer='he_normal')(inputs)

conv1 = Conv2D(64, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv1)

pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)

conv2 = Conv2D(128, 3, activation='relu', padding='same',kernel_initializer='he_normal')(pool1)

conv2 = Conv2D(128, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv2)

pool2 = MaxPooling2D(pool_size=(2, 2))(conv2)

conv3 = Conv2D(256, 3, activation='relu', padding='same',kernel_initializer='he_normal')(pool2)

conv3 = Conv2D(256, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv3)

pool3 = MaxPooling2D(pool_size=(2, 2))(conv3)

conv4 = Conv2D(512, 3, activation='relu', padding='same',kernel_initializer='he_normal')(pool3)

conv4 = Conv2D(512, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv4)

drop4 = Dropout(0.5)(conv4)

pool4 = MaxPooling2D(pool_size=(2, 2))(drop4)

conv5 = Conv2D(1024, 3, activation='relu', padding='same',kernel_initializer='he_normal')(pool4)

conv5 = Conv2D(1024, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv5)

#Expanding Path

drop5 = Dropout(0.5)(conv5)

up6 = Conv2DTranspose(512, 2, activation='relu', strides=(2,2), kernel_initializer='he_normal')(drop5)

merge6 = concatenate([drop4,up6], axis = 3)

conv6 = Conv2D(512, 3, activation='relu', padding='same',kernel_initializer='he_normal')(merge6)

conv6 = Conv2D(512, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv6)

up7 = Conv2DTranspose(256, 2, activation='relu', strides=(2,2), kernel_initializer='he_normal')(conv6)

merge7 = concatenate([conv3,up7], axis = 3)

conv7 = Conv2D(256, 3, activation='relu', padding='same',kernel_initializer='he_normal')(merge7)

conv7 = Conv2D(256, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv7)

up8 = Conv2DTranspose(128, 2, activation='relu', strides=(2,2), kernel_initializer='he_normal')(conv7)

merge8 = concatenate([conv2,up8], axis = 3)

conv8 = Conv2D(128, 3, activation='relu', padding='same',kernel_initializer='he_normal')(merge8)

conv8 = Conv2D(128, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv8)

up9 = Conv2DTranspose(64, 2, activation='relu', strides=(2,2), kernel_initializer='he_normal')(conv8)

merge9 = concatenate([conv1,up9], axis = 3)

conv9 = Conv2D(64, 3, activation='relu', padding='same',kernel_initializer='he_normal')(merge9)

conv9 = Conv2D(64, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv9)

conv9 = Conv2D(2, 3, activation='relu', padding='same',kernel_initializer='he_normal')(conv9)

conv10 = Conv2D(1, 1, activation='sigmoid')(conv9)

model = Model(inputs = inputs, outputs = conv10)

return model

모델 학습하기

이제 모델을 만들었으니 위에서 만들어본 데이터셋과 학습을 해봅시다! 적절한 learning rate와 epoch를 찾아서 모델을 학습하고 저장합니다.

model_path = os.getenv('HOME')+'/aiffel/semantic_segmentation/seg_model_unet.h5'

model = build_model()

model.compile(optimizer = Adam(lr = 1e-4), loss = 'binary_crossentropy')

model.fit_generator(

generator=train_generator,

validation_data=test_generator,

steps_per_epoch=len(train_generator),

epochs=100,

)

model.save(model_path) #학습한 모델을 저장해 주세요.모델 시각화

# 미리 준비한 모델을 불러오려면 아래 주석을 해제하세요

# model_path = dir_path + '/seg_model_unet.h5'

model = tf.keras.models.load_model(model_path)

def get_output(model, preproc, image_path, output_path):

origin_img = imread(image_path)

data = {"image":origin_img}

processed = preproc(**data)

output = model(np.expand_dims(processed["image"]/255,axis=0))

output = (output[0].numpy()>0.5).astype(np.uint8).squeeze(-1)*255 #0.5라는 threshold를 변경하면 도로인식 결과범위가 달라집니다.

output = Image.fromarray(output)

background = Image.fromarray(origin_img).convert('RGBA')

output = output.resize((origin_img.shape[1], origin_img.shape[0])).convert('RGBA')

output = Image.blend(background, output, alpha=0.5)

output.show()

return output 위에서 작성한 함수를 이용해 시각화를 해봅시다.

# 완성한 뒤에는 시각화한 결과를 눈으로 확인해봅시다!

i = 1 # i값을 바꾸면 테스트용 파일이 달라집니다.

get_output(

model,

test_preproc,

image_path=dir_path + f'/image_2/00{str(i).zfill(4)}_10.png',

output_path=dir_path + f'./result_{str(i).zfill(3)}.png'

)

def calculate_iou_score(target, prediction):

intersection = np.logical_and(target, prediction)

union = np.logical_or(target, prediction)

iou_score = float(np.sum(intersection)) / float(np.sum(union))

print('IoU : %f' % iou_score )

return iou_scoreIoU를 계산하려면 모델이 도로 영역이라고 판단한 부분이 1로, 나머지 부분이 0으로 표시된 행렬,

그리고 라벨 데이터에서 도로 영역이 1, 나머지 부분이 0으로 표시된 행렬이 필요합니다. 각각을 prediction, target이라고 불렀을 때 이를 계산하는 함수를 구현해 보겠습니다.

origin_img = imread(image_path)

data = {"image":origin_img}

processed = preproc(**data)

output = model(np.expand_dims(processed["image"]/255,axis=0))

output = (output[0].numpy()>=0.5).astype(np.uint8).squeeze(-1)*255 #0.5라는 threshold를 변경하면 도로인식 결과범위가 달라집니다.

prediction = output/255 # 도로로 판단한 영역

output = Image.fromarray(output)

background = Image.fromarray(origin_img).convert('RGBA')

output = output.resize((origin_img.shape[1], origin_img.shape[0])).convert('RGBA')

output = Image.blend(background, output, alpha=0.5)

output.show() # 도로로 판단한 영역을 시각화!

if label_path:

label_img = imread(label_path)

label_data = {"image":label_img}

label_processed = preproc(**label_data)

label_processed = label_processed["image"]

target = (label_processed == 7).astype(np.uint8)*1 # 라벨에서 도로로 기재된 영역

return output, prediction, target

else:

return output, prediction, _ 완성한 뒤에는 시각화한 결과를 눈으로 확인해봅시다!

i = 1 # i값을 바꾸면 테스트용 파일이 달라집니다.

output, prediction, target = get_output(

model,

test_preproc,

image_path=dir_path + f'/image_2/00{str(i).zfill(4)}_10.png',

output_path=dir_path + f'./result_{str(i).zfill(3)}.png',

label_path=dir_path + f'/semantic/00{str(i).zfill(4)}_10.png'

)

calculate_iou_score(target, prediction)