톺아보기

해커톤 3에서 XAI기법을 이용하여, 타당성 및 성능 개선을 하려고 합니다. 하지만, AI, ML, DL 그리고 지도, 비지도, 강화학습 등 다양한 방식들 중에서 어떠한 방식으로 어떻게 할지 모르기에 논문을 리서칭하던 중 기존의 XAI for NLP기법보다 성능이 좋고 최신인 논문을 찾게 되었습니다.

논문에 대한 내용 및 저자 깃허브에 있는 code를 어느정도로 이해하여 구축할지가 제겐 너무나 큰 도전이 될 것 같아서 기대됩니다.

Abstract

*배경

-

기존 XAI 방식들은 지도학습 끝부분이나 조사방식에 대한 설명만 함

- (비)지도 학습 훈련 때, 모델 지식 전달이 불충분하게 설명이 된다.

*TX-Ray 뉴런

-

촘촘하게 knowledge 전달

-

사람처럼 분석하도록 가이드

*TX-Ray 효과

-

사전학습 때, self or 지도학습된 NLP모델이 처음 knowledge abstrations하는 것을 분석한다

-

새로운 도메인(영역)에 추상화된 것을 전달한다.

-

지도학습 시, fine-tuning을 돕는다.

*저자의 발견

-

pruning: 가지치기(학습 후 불필요한 부분을 제거하는 방식)

-

TX-ray with pruning

-

test set 생성 향상: 자동적으로 자기주도학습을 통해 언어 추상화한다.

- 품사 분류같은 것이 가능해진다.(효과가 뭘까?)

-

Introduction

-

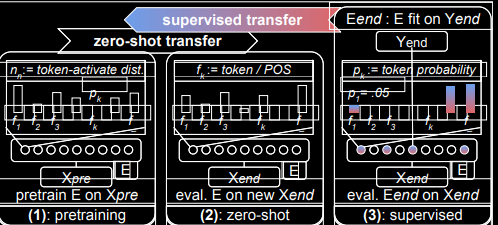

pretraining: 입력 특징들 수집 단계

-

zero-shot: 재학습x, 새로운 값을 추가하게 되면 뉴런 활성함수가 바뀌고 그로 인해 벌어지는 색깔의 차이를 통해서 유사도 측정 후 potenial or data match전달

-

Supervised: 지도학습labels을 이용해서 fine tune encoder 생성되고 이를 통해 knowledge추출

Unsupervised Knowledge absorption

- 사전학습 동안, XAI가 자기주도학습된 모델이 knowledge abstractions의 변화 및 생성 분석이 가능한가?

-

XAI가 knowlege 변화를 측정 가능한가?

- 설령 측정한다고 해도 Perplexity, PPL평가처럼 일치하게 가능할까?

*Perplexity: 링크텍스트

- 모델이 품사처럼 언어를 abstractions하여 학습하면?

zero-show knowledge transfer

재학습없이 새로운 domain에 사전학습된 모델을 적용할 것인가?

supervised/ backwards transfer

-

사전학습된 모델에 지도학습 라벨을 backwards로 전달할 수 있는가?

-

뉴런의 재구성을 통해 연관성 판단

-

가지치기된 관련있거나 없는 뉴런들에 의해서 측정된 것을 전달하는 과정을 확인 가능한가

결국엔 새로운 값이나 사전학습된 모델의 변화를 확인하여 catching이 가능한가가 핵심이지 결국 우리가 보고 싶은 거는 Flow입니다.

Tx-Ray can analyze and quantify (self)supervised model knowledge changes

이 부분에서는 위의 질문들에 대한 해법을 제시합니다.

-

Activation maximization: 활성함수 최대화하여 feature map이 갖는 의미 파악

- 입력 뉴런 시각화 가능

- NLP적용 가능

- Training, 각각의 뉴런의 level에서 knowlege 변화 측량 혹은 전달 가능

-

model knowledge 변화

- 세부적으로 뉴런의 변화 감지

- 통상적으로 모델의 level변화 감지

정리하자면,

저자는 TX-Ray의 전달 수단을 사용하여 뉴런을 guide하고 가지치기 및 작업을 식별할 수 있는지 경험적으로 확인 후 예상대로 테스트 세트 일반화를 높이거나 낮추는 관련된 뉴런을 인식합니다.

그러고, 지도학습이 치명적인 정보 손실을 야기할 뿐만 아니라 이전에 선호하지 않았던 새로운 지식을 추가한다는 것을 보여줍니다.