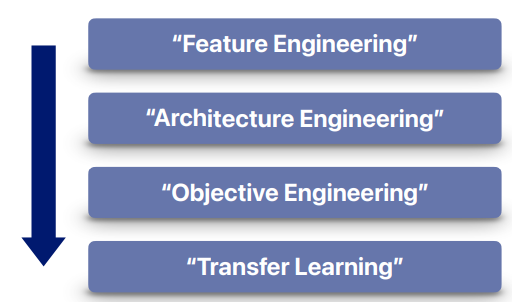

왜 Transfer Learning 인가?

ML에서 DL으로 변화하며, Feature Engineering에서 Architecture Engineering으로

ML을 하던 시절에는 결국에는 좋은 Feature를 찾는 것이 메인이었다.

그게 어려워서 딥러닝으로 넘어왔는데, 딥러닝은 feature를 뽑는 과정까지 gradient와 back propagation을 이용해 end-to-end로 구하는 방식이다. 이렇게 딥러닝을 이용한 방법들은 cnn(ResNet),rnn(lstm,gru ...),transformer등의 다양한 모델들의 발전으로 이어졌다.

architecture engineering에서 objective engineering 으로

그러나 supervised learning 이라는 목표는 그대로 두고 architecture만 변화하며 접근했다.

즉, 학습을 하는 방식 자체가 변화하지 않고 supervised learning으로 ERM(empirical risk minimization) 이라는 동일한 objective를 가지고 연구가 진행되었다.

그러나 언제까지 우리가 supervised learning으로 label data를 받아와 쓸 것인가 하는 문제가 있다. 그래서 architecture적인 것 뿐만 아니라 학습이라는 것을

semi-supervised로 쓸것인가 아니면 self-supervised로 풀어나갈 것인가 하는 objective engineering 관점에서 발전을 해오게 되었다.

transfer learning의 시대로

예전에는 feature extractor를 잘 만드는것을 고민

이제는 feature extractor는 좋아. 그것을 어떻게 잘 활용할 것인가 하는 방식으로 접근

그것이 transfer learning의 핵심이다.

feature extractor가 있을 때 어떻게 그것을 잘 활용해서 새로운 target task에 적용 할 것인가 하는 방향으로 많이 변화해 갔다.

그러한 관점에서 요즘은 transfer learning의 시대가 왔다.

결국은 큰 데이터와 큰 모델 (하지만 라벨 데이터는 적은...) 을 효율적으로 사용하기 위해서 발전해온것이다.

Transfer Learning과 Semi-Supervised Learning 비교

~~(추가할 것)