신경망 모델 구성에서 사용되는 함수

1. layers.Dense: 활성화 함수(activation)

층을 구성하는 단계에서 사용되는 함수로, 입력된 데이터의 가중 합을 출력신호로 변환하는 함수

- 텐서연산에서 설명한 내용을 참고

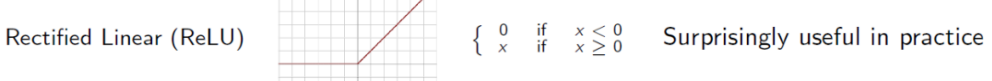

1) relu

ReLU 활성화: max(x, 0)

2) sigmoid

시그모이드 활성화: sigmoid(x) = 1 / (1 + exp(-x))

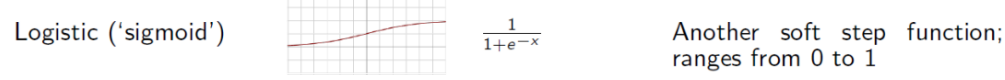

3) softmax

소프트맥스 활성화: exp(x) / reduce_sum(exp(x)).

- sigmoid와 softmax는 본질적으로 같은 함수다.

- 이진 분류시 sigmoid, 다중 분류시 softmax를 사용한다.

- 최종 출력층에 사용되며, 여러 출력 노드의 합을 비중값으로 나타낸다.

- 지수함수는 입력값 중 큰 값은 더 크게, 작은 값은 더 작게 만들어

입력벡터가 더 잘 구분되게 한다.

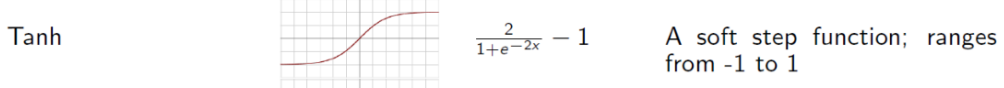

4) tahn

tahn 활성화: tanh(x) = sinh(x)/cosh(x) = ((exp(x) - exp(-x))/(exp(x) + exp(-x))).

4) 기타

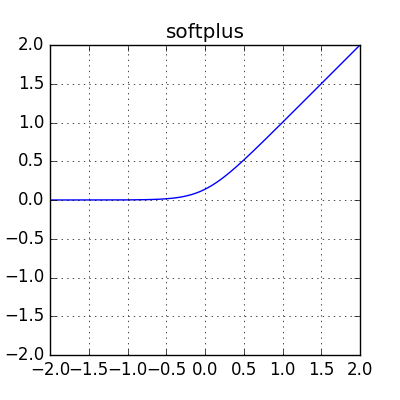

🔸 softplus

softplus(x) = log(exp(x) + 1)

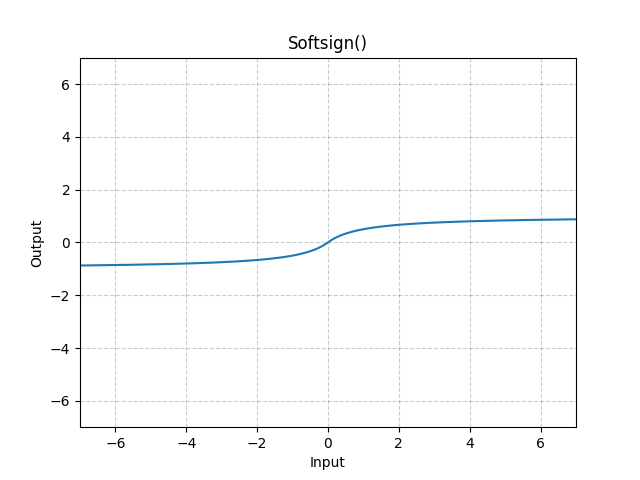

🔸 softsign

softsign(x) = x / (abs(x) + 1)

🔸 selu

Scaled Exponential Linear Unit

selu(x) = scale * elu(x, alpha)

if x > 0: return scale * x

if x < 0: return scale * alpha * (exp(x) - 1)

2. model.compile

- 예시

model.compile(optimizer = 'rmsprop',

loss = 'binary_crossentropy',

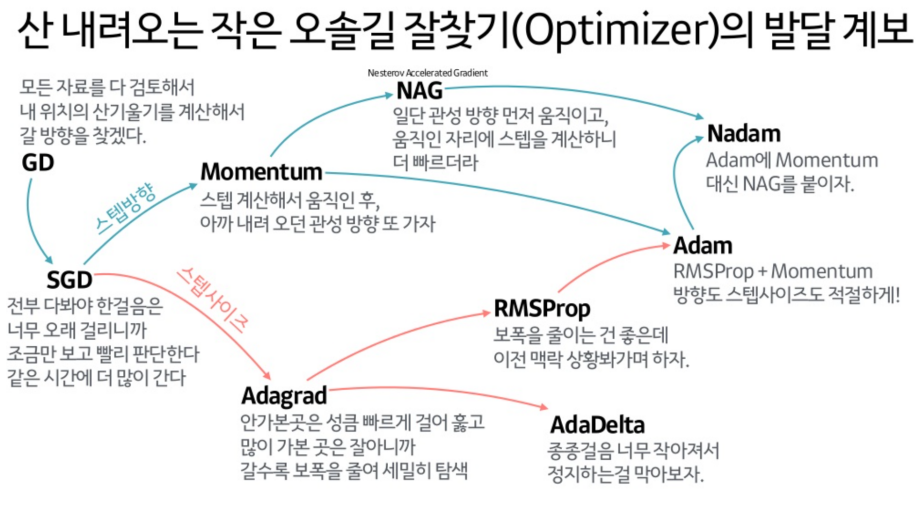

metrics='acc')1) 옵티마이저 함수(optimizer)

Gradient 기반( GD )

- 그레이디언트 기반 최적화에서 설명한 내용 참고

사용가능한 함수

SGD

RMSprop

Adam

Adadelta

Adagrad

Adamax

Nadam

Ftrl

2) 손실함수(loss function)

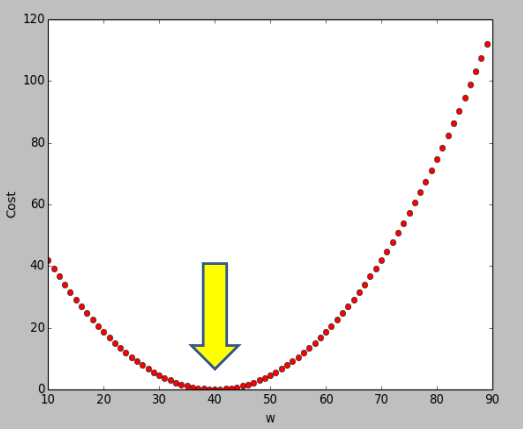

- 목적함수(objective function), 비용함수(cost function)이라고도 함

- X축이 가중치, y축이 오차(비용,손실)

- X축이 가중치, y축이 오차(비용,손실)

- 비용함수를 최소로 하는 w를 찾는 것이 학습

🔸 사용가능한 함수

-

확률(Probabilistic losses)

- binary_crossentropy

- categorical_crossentropy

- sparse_categorical_crossentropy

- poisson

- kl_divergence

-

회귀(Regression losses)

- mean_squared_error

- mean_absolute_error

- mean_absolute_percentage_error

- mean_squared_logarithmic_error

- cosine_similarity

- huber

- log_cosh

-

"최대 마진" 분류를 위한 힌지

- hinge

- squared_hinge

- categorical_hinge

🔸 기억해야할 점

- 분류, 회귀에 사용하는 손실 함수는 다름

- 분류문제도 구분해서 사용

- 다중분류

- 레이블을 범주형으로 인코딩(원핫인코딩): categorical_crossentropy

- 레이블을 정수로 인코딩: sparse_categorical_crossentropy

- 이진분류

- binary_crossentropy

- 다중분류

3) 평가 지표(metrics)

🔸 사용가능한 함수

-

정확도(Accuracy metrics)

- Accuracy

- BinaryAccuracy

- CategoricalAccuracy

- SparseCategoricalAccuracy

- TopKCategoricalAccuracy

- SparseTopKCategoricalAccuracy

-

확률(Probabilistic metrics)

- BinaryCrossentropy

- CategoricalCrossentropy

- SparseCategoricalCrossentropy

- KLDivergence

- Poisson

-

회귀지표(Regression metrics)

- MSE: MeanSquaredError

- RMSE: RootMeanSquaredError

- MAE: MeanAbsoluteError

- MAPE: MeanAbsolutePercentageError

- MSLE: MeanSquaredLogarithmicError

- CosineSimilarity

- LogCoshError

-

참/거짓, 긍정/부정에 기반한 평가지표

- AUC

- Precision

- Recall

- TruePositives

- TrueNegatives

- FalsePositives

- FalseNegatives

- PrecisionAtRecall

- SensitivityAtSpecificity

- SpecificityAtSensitivity

-

이미지세분화(Image segmentation metrics)

- MeanIoU

-

"최대 마진" 분류를 위한 힌지

- Hinge

- SquaredHinge

- CategoricalHinge