Scholar GPT

이번 ChatGPT 활용기에서는 논문리뷰를 GPT를 이용해봤다.

GPT에서는 GPT를 활용하여 사용자들이 fine-tuning한 여러 APP들을 이용할 수 있는데 이중 영어 논문을 한국어로 번역하여 요약해 주는 Scholar GPT를 활용하여 논문 리뷰를 진행해 보았다.

이 앱을 이용하면 번거롭게 해석하며 읽어야 했던 논문들을 쉽게 요약 및 번역하여 읽을 수 있어 매우 유용하다고 생각한다.

Florence-2 논문 리뷰

아래부터는 GPT와 대화하며 했던 대화체 형식으로 포스팅 할 것이다.

논문 Model 한국어로 설명해줘

논문 "Florence-2: Advancing a Unified Representation for a Variety of Vision Tasks"의 주요 내용을 한국어로 요약해 드리겠습니다.

### Florence-2: 다양한 비전 작업을 위한 통합 표현 모델

### 개요

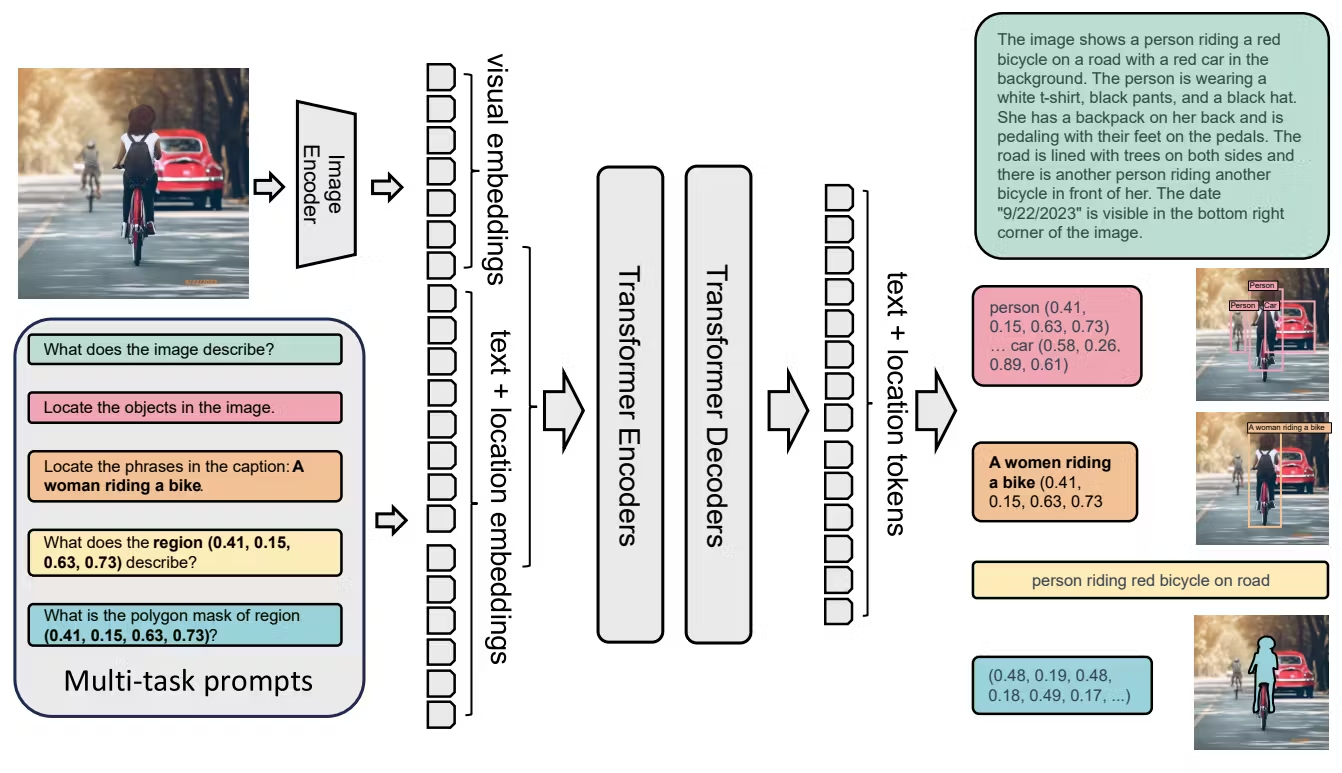

Florence-2는 다양한 컴퓨터 비전 및 비전-언어 작업을 위해 통합된, 프롬프트 기반 표현을 사용하는 새로운 비전 기초 모델입니다. 기존의 대규모 비전 모델은 전이 학습에서 뛰어나지만, 다양한 작업을 간단한 지시로 수행하는 데 어려움을 겪습니다. Florence-2는 텍스트 프롬프트를 작업 지시로 받아 캡션 작성, 객체 감지, 시각적 근거 제시 및 분할 등 다양한 작업에서 원하는 결과를 생성할 수 있도록 설계되었습니다. 이를 위해 5.4억 개의 시각적 주석이 포함된 FLD-5B 데이터세트를 공동 개발했습니다. Florence-2는 시퀀스-투-시퀀스 구조를 채택하여 다양한 비전 작업을 수행하도록 훈련되었습니다.

### 주요 특징

- **통합 아키텍처**: Florence-2는 단일 통합 모델로서 공간 계층 구조와 의미적 세분화를 포괄하는 다양한 인지 기능을 제공하도록 설계되었습니다.

- **대규모 주석 데이터**: FLD-5B는 1억 2천 6백만 개의 이미지에 대한 5.4억 개의 주석으로 구성되어 있으며, 자동 이미지 주석화 및 모델 정제를 통해 생성되었습니다.

- **다목적 학습**: 시퀀스-투-시퀀스 구조를 채택하여, 다양한 비전 작업을 단일 모델에서 수행할 수 있도록 훈련되었습니다.

- **뛰어난 성능**: 다양한 작업에서 전례 없는 zero-shot 성능과 미세 조정 기능을 보여줍니다.

### 기술적 접근

1. **공간 계층 구조 및 의미적 세분화**: 모델은 다양한 크기의 공간적 세부 사항을 이해하고, 고수준 캡션에서 세밀한 설명까지 다양한 의미적 세분화를 이해할 수 있어야 합니다.

2. **데이터 엔진**: 두 개의 효율적인 처리 모듈을 사용하여 이미지에 대한 광범위한 주석을 자동으로 생성합니다.

3. **시퀀스-투-시퀀스 아키텍처**: 이미지 인코더와 다중 모달리티 인코더-디코더를 통합하여 다양한 작업을 단일 구조로 처리합니다.

### 성과

- **zero-shot 성능**: COCO 캡션 작성, Flick30k 시각적 근거 제시, RefCOCO/+/g 참조 표현 이해 등 다양한 작업에서 새로운 state-of-the-art 성능을 달성했습니다.

- **미세 조정 후 성능**: 공개된 인간 주석 데이터를 사용한 미세 조정 후에도 경쟁력 있는 성능을 유지하며, 특히 COCO 객체 감지 및 인스턴스 분할, ADE20K 의미적 분할 작업에서 뛰어난 성과를 보였습니다.

### 결론

Florence-2는 다양한 컴퓨터 비전 작업을 통합적으로 수행할 수 있는 강력한 비전 기초 모델입니다. 대규모 주석 데이터와 통합된 시퀀스-투-시퀀스 아키텍처를 통해 다양한 비전 작업에서 높은 성능을 발휘합니다.

논문의 전체 내용은 파일에 포함된 내용을 참고하시기 바랍니다.

3.Model 부분 한국어로 설명해줘

### 3. 모델 (Model)

Florence-2는 다양한 비전 작업을 단일 가중치 집합과 통합 아키텍처로 처리할 수 있는 범용 표현 학습을 위해 설계된 기초 모델입니다. 다음은 Florence-2의 주요 구성 요소에 대한 자세한 설명입니다.

### 모델 구성 요소

1. **시퀀스-투-시퀀스 학습 방식**:

- **작업 공식화**: Florence-2는 모든 작업을 통일된 방식으로 처리합니다. 입력 이미지와 작업 프롬프트를 입력으로 받아서, 필요한 출력을 텍스트 형태로 생성합니다.

- **텍스트 및 영역 표현**: 작업에 따라 프롬프트와 응답을 텍스트 또는 영역으로 구분합니다.

- **텍스트**: 프롬프트나 응답이 단순한 텍스트일 경우, 이를 시퀀스-투-시퀀스 형식으로 유지합니다.

- **영역**: 영역별 작업의 경우, 위치 토큰을 사용하여 정량화된 좌표를 나타내고, 작업 요구 사항에 맞게 형식을 설정합니다.

- **박스 표현**: 객체 감지 및 밀집 영역 캡션 작업에 사용되며, 박스 좌표를 토큰으로 사용합니다.

- **쿼드 박스 표현**: 텍스트 감지 및 인식 작업에 사용되며, 쿼드 박스의 각 좌표를 토큰으로 사용합니다.

- **다각형 표현**: 참조 분할 작업에 사용되며, 다각형의 각 꼭지점을 토큰으로 사용합니다.

2. **비전 인코더**:

- **DaViT (Vision Encoder)**: 입력 이미지를 시각적 토큰 임베딩으로 변환합니다. 이 토큰들은 나중에 텍스트 임베딩과 결합되어 멀티모달 인코더-디코더로 전달됩니다.

3. **멀티모달 인코더-디코더**:

- **표준 인코더-디코더 구조**: 시각적 토큰 임베딩과 프롬프트 텍스트 임베딩을 결합하여 멀티모달 인코더-디코더 모듈로 처리합니다.

- **텍스트 프롬프트 임베딩**: 확장된 언어 토크나이저와 단어 임베딩 레이어를 사용하여 프롬프트 텍스트 임베딩을 얻습니다.

- **결합된 입력**: 시각적 토큰 임베딩과 프롬프트 임베딩을 결합하여 멀티모달 인코더 모듈 입력으로 사용합니다.

4. **최적화 목표**:

- **언어 모델링 및 교차 엔트로피 손실**: 입력 이미지와 프롬프트, 그리고 목표 텍스트를 조합하여 표준 언어 모델링 목표로 모든 작업을 최적화합니다.

- **수식**:

\[

L = -\sum_{i=1}^{|y|} \log P_\theta(y_i | y_{<i}, x)

\]

여기서, θ는 네트워크 파라미터, \(|y|\)는 목표 토큰의 수입니다.

이와 같은 구성 요소를 통해 Florence-2는 다양한 비전 작업을 통합된 구조로 효율적으로 처리할 수 있습니다.

- Data Engine 부분 한국어로 설명해줘

### 4. 데이터 엔진 (Data Engine)

Florence-2 모델을 훈련하기 위해 다양한 이미지 데이터 측면을 포괄하는 포괄적이고 대규모의 고품질 다중 작업 데이터세트가 필요합니다. 이를 위해 우리는 새로운 다중 작업 이미지 데이터세트인 FLD-5B를 개발했습니다. 이 데이터세트는 1억 2천 6백만 개의 이미지, 5억 개의 텍스트 주석, 13억 개의 텍스트-영역 주석, 36억 개의 텍스트-구문-영역 주석을 포함합니다. 데이터 엔진 파이프라인은 다음과 같은 주요 단계로 구성됩니다.

### 4.1 이미지 수집

우리는 다양한 소스에서 이미지를 수집하여 데이터세트를 구축합니다. 이미지 분류, 객체 감지 및 이미지 캡션과 같은 주요 작업을 소스로 삼아 이미지 코퍼스를 구성합니다. 이를 통해 ImageNet-22k, Object 365, Open Images, Conceptual Captions, LAION과 같은 다양한 데이터세트를 결합하여 총 1억 2천 6백만 개의 이미지를 포함하는 데이터세트를 만듭니다.

### 4.2 데이터 주석

우리의 주요 목표는 다중 작업 학습을 효과적으로 지원할 수 있는 포괄적인 주석을 생성하는 것입니다. 이에 따라 주석 작업은 텍스트, 텍스트-영역 쌍, 텍스트-구문-영역 삼중 주석의 세 가지 범주로 나뉩니다. 데이터 주석 워크플로우는 다음과 같은 세 가지 주요 단계로 구성됩니다.

1. **초기 주석화**:

- **전문가 모델 사용**: 우리는 공용 데이터세트와 클라우드 플랫폼에서 호스팅되는 온라인 서비스를 통해 훈련된 전문가 모델을 사용하여 초기 주석을 생성합니다.

- **기존 주석 병합**: 일부 이미지 데이터세트는 이미 부분적으로 주석이 달려 있습니다. 예를 들어, Object 365 데이터세트는 이미 사람에 의해 주석된 경계 상자와 해당 카테고리를 포함하고 있습니다. 이러한 경우, 기존 주석과 전문가 모델이 생성한 주석을 병합하여 주석의 범위와 다양성을 향상시킵니다.

2. **데이터 필터링 및 향상**:

- **텍스트 주석**: SpaCy를 기반으로 객체, 속성 및 동작을 추출하는 도구를 개발하여 과도한 객체를 포함하는 텍스트를 필터링합니다. 또한, 동작과 객체의 복잡성을 평가하여 시각적 개념의 풍부함을 유지합니다.

- **영역 주석**: 경계 상자에 대해 신뢰도 점수 임계값을 적용하여 노이즈 상자를 제거하고, 비최대 억제를 사용하여 중복 또는 겹치는 상자를 줄입니다.

3. **반복적인 데이터 정제**:

- **모델 재훈련**: 필터링된 초기 주석을 사용하여 멀티태스크 모델을 훈련하고, 이를 통해 업데이트된 주석을 원래 주석과 결합하여 다시 모델을 훈련합니다. 이 과정은 데이터세트의 품질을 점진적으로 향상시킵니다.

- **세부 작업 주석**: 초기 주석화 과정에서 생략된 세부 작업에 대해서는, 미세 조정된 모델을 사용하여 주석을 생성합니다.

### 4.3 주석별 변형

- **텍스트 주석**: 이미지에 대해 세 가지 수준의 텍스트 주석(간단한, 자세한, 더 자세한)을 생성합니다.

- **텍스트-영역 쌍**: 이미지의 의미적 영역에 대한 설명 텍스트 주석을 생성합니다.

- **텍스트-구문-영역 삼중 주석**: 이미지에 대한 설명 텍스트, 관련 구문, 해당 객체의 영역 주석을 포함합니다.

이와 같은 주석 과정을 통해 우리는 다양한 작업을 지원하는 포괄적이고 대규모의 고품질 데이터세트를 생성할 수 있습니다.논문에 나오는 encoder에 대해 설명해줘

논문 "Florence-2: Advancing a Unified Representation for a Variety of Vision Tasks"에서 언급되는 인코더(Encoder)는 이미지 데이터를 처리하고 다양한 비전 작업을 수행할 수 있는 시각적 토큰 임베딩으로 변환하는 역할을 합니다. 이 논문에서 사용된 인코더의 주요 특징과 작동 방식은 다음과 같습니다.

### 비전 인코더 (Vision Encoder)

Florence-2 모델의 비전 인코더는 DaViT(Dual-Path Vision Transformer)로 구현됩니다. 이 인코더는 입력 이미지를 시각적 토큰 임베딩으로 변환하여 후속 처리 모듈로 전달합니다. 구체적인 작동 방식은 다음과 같습니다.

### 1. 입력 이미지 처리

- 입력 이미지 \(I \in \mathbb{R}^{H \times W \times 3}\)는 높이 \(H\)와 너비 \(W\), 3개의 색상 채널(RGB)을 가진다.

- 이미지는 고정된 크기의 패치(patch)로 분할됩니다. 각 패치는 선형 임베딩을 통해 고차원 벡터로 변환됩니다.

### 2. 패치 임베딩

- 이미지 패치들은 각각의 벡터로 변환되어, 시각적 토큰(visual token) 임베딩 \(V \in \mathbb{R}^{N_v \times D_v}\)로 표현됩니다. 여기서 \(N_v\)는 시각적 토큰의 수, \(D_v\)는 각 토큰의 차원입니다.

- 패치 임베딩 과정은 일반적으로 선형 변환과 LayerNorm(층 정규화) 레이어를 포함합니다.

### 3. 멀티-헤드 셀프 어텐션

- 각 시각적 토큰은 멀티-헤드 셀프 어텐션 메커니즘을 통해 다른 토큰들과 상호작용합니다. 이를 통해 이미지의 전반적인 문맥을 이해할 수 있습니다.

- 여러 어텐션 헤드를 사용하여 다양한 시각적 패턴과 특징을 동시에 학습합니다.

### 4. 출력 생성

- 어텐션 결과는 피드 포워드 네트워크를 통과하여 비선형 변환을 거칩니다.

- 최종 시각적 토큰 임베딩은 후속 멀티모달 인코더-디코더 모듈로 전달되어 다양한 비전 작업을 수행할 수 있는 입력으로 사용됩니다.

### 멀티모달 인코더-디코더와의 통합

- 비전 인코더에서 생성된 시각적 토큰 임베딩은 텍스트 프롬프트 임베딩과 결합되어 멀티모달 인코더-디코더 모듈로 전달됩니다.

- 멀티모달 인코더-디코더는 텍스트와 시각적 정보를 결합하여 다양한 비전 작업의 결과를 생성합니다.

### 요약

Florence-2 모델의 비전 인코더는 이미지 데이터를 시각적 토큰 임베딩으로 변환하여 멀티모달 인코더-디코더에 입력으로 제공하는 역할을 합니다. 이 과정에서 이미지의 공간적 정보와 문맥을 효과적으로 캡처하여 다양한 비전 작업을 수행할 수 있습니다.비전 인코더에서 생성된 시각적 토큰 임베딩은 텍스트 프롬프트 임베딩과 결합이 어떻게 하는지 자세히 한국어로 설명해줘

Florence-2 모델에서 비전 인코더가 생성한 시각적 토큰 임베딩을 텍스트 프롬프트 임베딩과 결합하는 과정은 다음과 같이 이루어집니다.

### 1. 비전 인코더의 시각적 토큰 임베딩 생성

먼저, 비전 인코더(DaViT)가 입력 이미지 \(I\)를 처리하여 시각적 토큰 임베딩 \(V\)를 생성합니다.

- 입력 이미지 \(I \in \mathbb{R}^{H \times W \times 3}\)는 패치로 분할되어, 각 패치는 고차원 벡터로 변환됩니다.

- 이 벡터들은 시각적 토큰 임베딩 \(V \in \mathbb{R}^{N_v \times D_v}\)로 표현되며, 여기서 \(N_v\)는 시각적 토큰의 수, \(D_v\)는 각 토큰의 차원입니다.

### 2. 텍스트 프롬프트 임베딩 생성

다음으로, 입력 텍스트 프롬프트는 텍스트 임베딩 \(T_{\text{prompt}}\)으로 변환됩니다.

- 텍스트 프롬프트는 단어 수준으로 토큰화되고, 각 단어는 임베딩 벡터로 변환됩니다.

- 텍스트 임베딩 \(T_{\text{prompt}} \in \mathbb{R}^{N_t \times D}\)는 텍스트 토큰의 수 \(N_t\)와 임베딩 차원 \(D\)를 갖습니다.

### 3. 시각적 토큰 임베딩과 텍스트 프롬프트 임베딩 결합

시각적 토큰 임베딩 \(V\)와 텍스트 프롬프트 임베딩 \(T_{\text{prompt}}\)를 결합하여 멀티모달 인코더-디코더의 입력으로 사용합니다.

- 시각적 토큰 임베딩 \(V\)는 선형 변환과 LayerNorm(층 정규화)을 거쳐 차원을 정렬합니다. 이렇게 변환된 시각적 토큰 임베딩을 \(V'\)라고 합니다.

- \(V' \in \mathbb{R}^{N_v \times D}\)와 \(T_{\text{prompt}} \in \mathbb{R}^{N_t \times D}\)를 결합하여 최종 입력 \(X \in \mathbb{R}^{(N_v + N_t) \times D}\)를 생성합니다.

### 4. 멀티모달 인코더-디코더로 입력 전달

결합된 임베딩 \(X\)는 멀티모달 인코더-디코더로 전달되어 다양한 비전 작업의 결과를 생성합니다.

- 멀티모달 인코더는 결합된 입력 \(X\)를 처리하여 시각적 정보와 텍스트 정보를 통합합니다.

- 디코더는 인코더의 출력을 기반으로 최종 결과를 생성합니다. 이 결과는 객체 감지, 이미지 캡션 생성, 시각적 근거 제시 등의 작업에 사용됩니다.

이 과정은 시각적 토큰 임베딩과 텍스트 프롬프트 임베딩을 효과적으로 결합하여, 모델이 다양한 비전 작업을 수행할 수 있도록 합니다. Florence-2 모델은 이러한 통합 과정을 통해 입력 이미지와 텍스트 프롬프트 간의 상호작용을 잘 이해하고, 원하는 작업을 수행하는 데 필요한 정보를 학습합니다.시각적 토큰 임베딩과 텍스트 프롬프트 임베딩 결합은 단순히 덧셈으로 결합하는 것인지 궁금한데 한국어로 설명해줘

Florence-2 모델에서 시각적 토큰 임베딩과 텍스트 프롬프트 임베딩을 결합하는 과정은 단순히 덧셈으로 이루어지는 것이 아니라, 두 임베딩을 단순히 순차적으로 연결(concatenate)하여 결합합니다. 결합 과정은 다음과 같습니다.

### 1. 시각적 토큰 임베딩 생성

먼저, 비전 인코더(DaViT)를 통해 입력 이미지가 시각적 토큰 임베딩 \(V\)로 변환됩니다.

- 예를 들어, \(V \in \mathbb{R}^{N_v \times D_v}\)는 \(N_v\)개의 시각적 토큰을 가지고 있으며, 각 토큰은 차원 \(D_v\)를 가집니다.

### 2. 텍스트 프롬프트 임베딩 생성

텍스트 프롬프트는 텍스트 임베딩 \(T_{\text{prompt}}\)으로 변환됩니다.

- 텍스트 임베딩 \(T_{\text{prompt}} \in \mathbb{R}^{N_t \times D}\)는 \(N_t\)개의 텍스트 토큰을 가지고 있으며, 각 토큰은 차원 \(D\)를 가집니다.

### 3. 시각적 토큰 임베딩 차원 정렬

시각적 토큰 임베딩 \(V\)는 텍스트 프롬프트 임베딩 \(T_{\text{prompt}}\)과 동일한 차원을 가지도록 선형 변환과 LayerNorm을 통해 차원 정렬을 수행합니다.

- 정렬된 시각적 토큰 임베딩을 \(V'\)라고 하며, \(V' \in \mathbb{R}^{N_v \times D}\)가 됩니다.

### 4. 시각적 토큰 임베딩과 텍스트 프롬프트 임베딩 결합

정렬된 시각적 토큰 임베딩 \(V'\)와 텍스트 프롬프트 임베딩 \(T_{\text{prompt}}\)를 결합하여 최종 입력 \(X\)를 생성합니다.

- 결합 방법은 단순한 덧셈이 아닌, 두 임베딩을 순차적으로 연결(concatenate)하는 방식입니다.

- 즉, \(X = [V'; T_{\text{prompt}}]\)로 표현됩니다.

- 최종 결합된 입력 \(X\)는 \(X \in \mathbb{R}^{(N_v + N_t) \times D}\)의 형태를 가집니다.

### 5. 멀티모달 인코더-디코더로 전달

결합된 임베딩 \(X\)는 멀티모달 인코더-디코더로 전달됩니다.

- 인코더는 이 결합된 입력을 처리하여 시각적 정보와 텍스트 정보를 통합합니다.

- 디코더는 인코더의 출력을 기반으로 다양한 비전 작업의 결과를 생성합니다.

이 과정은 단순한 덧셈이 아닌, 시각적 토큰 임베딩과 텍스트 프롬프트 임베딩을 하나의 시퀀스로 연결하여 처리하는 방식입니다. 이를 통해 모델은 입력 이미지와 텍스트 프롬프트 간의 상호작용을 잘 이해하고, 다양한 비전 작업을 수행할 수 있습니다.후기

GPT는 원하는 바를 자세하게 서술해야 원하는 대답을 얻을 수 있으며 항상 정확한 정보만을 전달하는 것은 아니기에 GPT 사용 시 항상 거짓 정보에 대해 원문도 같이 확인해야 함을 명심해야 한다.