이번에 포스팅할 GPT 활용기는 Bert Architecture에 대해서 알아보는 활용기이다.

지난번 포스팅과 마찬가지로 대화체 형식으로 표현되어 있다

Me : 공개된 transformer 모델 중에 모델 architecture를 보고 따라할만 한 소스코드가 있을까?

GPT : 네, 공개된 트랜스포머 모델 중에서는 모델 아키텍처를 참고하기 좋은 소스코드들이 많이 있습니다. 특히 Hugging Face의

transformers라이브러리는 다양한 트랜스포머 모델의 구조와 구현을 잘 설명하고 있습니다. 다음 몇 가지 리소스를 참고해 보시면 좋을 것 같습니다.

1. Hugging Face Transformers 라이브러리: 이 라이브러리는 BERT, GPT, T5 등 다양한 트랜스포머 모델의 소스코드를 포함하고 있으며,Model및Config클래스를 통해 모델 아키텍처를 쉽게 파악할 수 있습니다.

- Hugging Face Transformers GitHub Repository

modeling_bert.py,modeling_gpt2.py와 같은 파일에서 BERT, GPT 등의 모델을 확인할 수 있습니다.

- TensorFlow Model Garden: TensorFlow에서 제공하는 Model Garden에는 BERT를 비롯한 여러 NLP 모델이 구현되어 있습니다. 모델의 아키텍처가 TensorFlow/Keras로 구현되어 있으므로, Keras 스타일로 트랜스포머 구조를 보고 따라하기에 좋습니다.

- Fairseq (Facebook AI Research Sequence-to-Sequence Toolkit): Fairseq는 PyTorch 기반의 고성능 NLP 라이브러리로, 트랜스포머 모델 아키텍처의 상세 구현을 확인할 수 있습니다. 특히, 여러 확장 모델과 실험적인 트랜스포머 구조들도 포함되어 있어 고급 사용자를 위한 참고 자료로 적합합니다.

- OpenAI GPT Models: OpenAI에서 공개한 GPT 모델 (예: GPT-2)의 소스코드도 참고할 수 있습니다. 원본 GPT-2 모델 구현은 PyTorch로 되어 있으며, 트랜스포머 구조를 이해하기 위한 좋은 예시입니다.

- OpenAI GPT-2 GitHub Repository

이 외에도 Google Research에서 발표한 트랜스포머 모델(예: T5, BERT) 관련 논문 및 블로그 글들도 모델 아키텍처를 이해하는 데 도움이 될 것입니다.

ME : modeling_bert.py 에 대해서 자세히 알려줘

GPT : modeling_bert.py는 Hugging Face의transformers라이브러리 내에서 BERT 모델의 구조를 구현한 Python 파일입니다. 이 파일은 BERT의 기본적인 아키텍처뿐만 아니라 다양한 파라미터 설정과 학습을 위한 여러 기능들을 포함하고 있습니다. 주요 구성 요소를 통해 자세히 살펴보겠습니다.

1. 파일 구조와 주요 클래스

modeling_bert.py는 크게 다음과 같은 클래스와 함수로 나누어집니다.

- BertModel: BERT의 기본 구조를 정의하는 메인 클래스.

- BertLayer, BertAttention, BertSelfAttention, BertSelfOutput: BERT의 레이어와 어텐션 메커니즘을 구현한 서브 클래스.

- BertIntermediate와 BertOutput: BERT의 피드포워드 네트워크를 정의하는 부분.

- BertPooler: [CLS] 토큰의 출력을 풀링(pooling)하여 문장의 전체 표현을 생성하는 모듈.

- BertForPreTraining, BertForSequenceClassification, BertForTokenClassification: 다양한 다운스트림 태스크를 위한 파인튜닝 클래스.

2. BertModel

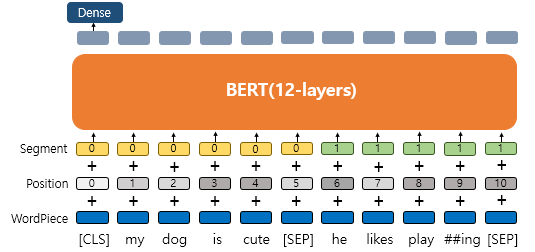

BertModel 클래스는 BERT의 기본적인 아키텍처를 정의합니다. 일반적으로 BertEmbeddings (임베딩 레이어), 여러 개의 BertLayer (트랜스포머 레이어), BertPooler로 구성됩니다.

- BertEmbeddings: 입력 텍스트를 임베딩 벡터로 변환합니다. 토큰 임베딩, 위치 임베딩, 세그먼트 임베딩 등을 포함하고 있으며, BERT의 입력을 구성하는 중요한 부분입니다.

- Encoder: BERT는 여러 개의

BertLayer로 구성된 인코더를 사용하며, 각 레이어는 어텐션 헤드와 피드포워드 네트워크를 포함합니다. - BertPooler: [CLS] 토큰을 기반으로 한 풀링 레이어로, 문장 수준의 표현을 반환합니다.

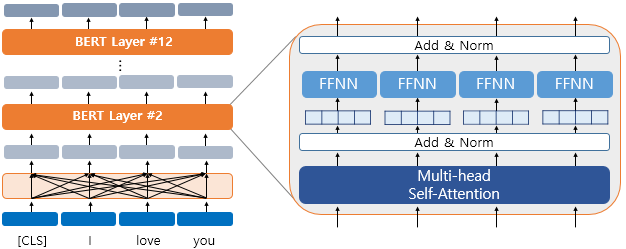

3. BertLayer

BertLayer는 트랜스포머의 기본 레이어로, Self-Attention과 Feed-Forward Network로 이루어져 있습니다.

- BertAttention:

BertLayer내의 어텐션 메커니즘을 구현합니다. Self-Attention을 수행하는BertSelfAttention과 그 결과를 레이어 노름과 함께 처리하는BertSelfOutput으로 구성되어 있습니다. - BertIntermediate와 BertOutput: Self-Attention 이후의 피드포워드 네트워크입니다.

BertIntermediate는 일반적으로 활성화 함수(ReLU 또는 GELU)와 함께 선형 변환을 수행합니다.BertOutput은 그 결과를 다시 출력 레이어로 보내며, 레이어 노름과 드롭아웃을 적용합니다.

4. BertForPreTraining

BERT를 사전 학습할 때 사용하는 클래스입니다. BERT의 사전 학습 태스크인 마스크드 언어 모델링(MLM)과 문장 간 관계 예측(NSP)을 위한 헤드를 포함하고 있습니다.

- Masked Language Modeling (MLM): 입력 텍스트의 일부 토큰을 마스킹하고, 이 마스킹된 토큰을 예측하는 훈련 작업입니다.

BertLMPredictionHead를 통해 구현됩니다. - Next Sentence Prediction (NSP): 두 문장이 순서대로 이어지는지를 예측하는 작업으로,

BertOnlyNSPHead를 통해 구현됩니다.

5. 다운스트림 태스크용 클래스들

modeling_bert.py에는 BERT를 기반으로 다양한 다운스트림 태스크에 맞게 변형된 모델들이 포함되어 있습니다.

- BertForSequenceClassification: 문장 분류와 같은 태스크를 위해 BERT 위에 추가로 분류 헤드를 붙인 구조입니다.

- BertForTokenClassification: 토큰 분류 태스크(예: 개체명 인식)를 위해 토큰 단위로 분류를 수행합니다.

- BertForQuestionAnswering: 질의응답 태스크를 위해 시작 위치와 종료 위치를 예측하는 레이어를 추가합니다.

6. 하이퍼파라미터와 설정 (Config)

BERT 모델을 초기화할 때, BertConfig 객체가 필요합니다. 이 객체는 모델의 크기, 레이어 수, 어텐션 헤드 수 등 모델의 구조적인 세부사항을 정의합니다. 이를 통해 동일한 BertModel 클래스에서 다양한 BERT 모델 변형을 생성할 수 있습니다.

예제 코드

BertModel을 사용하는 간단한 예제 코드입니다.

from transformers import BertModel, BertTokenizer

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

model = BertModel.from_pretrained("bert-base-uncased")

text = "Hello, how are you?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model(**inputs)

last_hidden_states = outputs.last_hidden_state이 예제는 주어진 텍스트를 BERT 모델에 입력하고, 각 토큰의 최종 히든 상태를 출력합니다.

참고 문서

더 자세한 내용은 Hugging Face의 Transformers 문서에서 BertModel과 관련된 내용을 확인할 수 있습니다.