Distributions

Logistic Sigmoid

σ(x)=1+exp(−x)1

Softplus Function

ζ(x)=log(1+exp(x))

- softened version of x+=max(0,x)

Properties of Sigmoid

-

σ(x)=1+exp(−x)1=exp(x)+exp(0)exp(x)

-

dxdσ(x)=σ(x)(1−σ(x))

-

1−σ(x)=σ(−x)

-

logσ(x)=−ζ(−x)

-

dxdζ(x)=σ(x)

-

∀x∈(0,1),σ−1(x)=log(1−xx)

Entropy

Information theory는 information이라는 개념에 대한 quantifying하는 것에 대한 학문이다. 여기서 가장 기본 개념은, 발생 확률이 낮은 event가 더 informative하다는 것이다.

어떤 event x이 가지고 있는 information quantity 또는 self-information은 event x가 발생할 확률 P(x)를 표현하기 위한 최소 bits 개수로, 다음과 같이 정의한다.

I(x)=−log2P(x)

P(x)가 낮을수록 I(x)는 증가한다는 것을 알 수 있다.

이 때, entropy란 self-information의 expectation을 말하며, 다음과 같이 정의된다.

H(x)=Ex∼P[I(x)]=−Ex∼P[logP(x)]

어떤 distribution에서 발생한 event의 information quantity의 기댓값이므로, 해당 distribution의 uncertainty 크기에 대한 measure로 볼 수 있다.

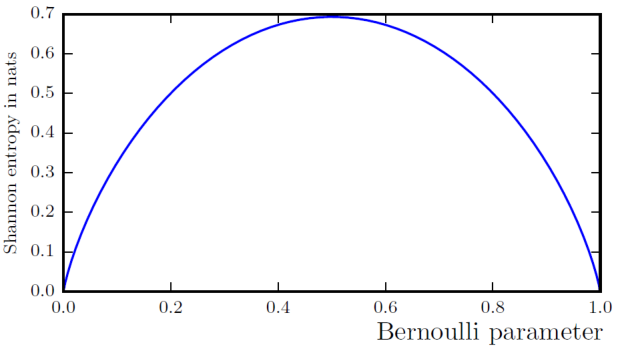

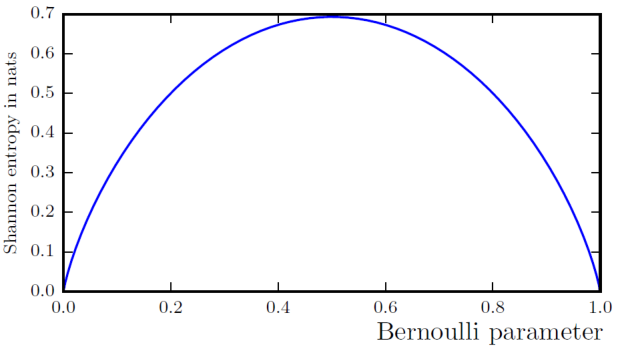

예를 들어, Bernoulli distribution을 고려하자. 이 때의 entropy는 다음과 같이 정의된다.

H(x)=−plogp−(1−p)log(1−p)

만약, distribution이 deterministic하다면, 즉 p=0 또는 p=1이면, H(x)는 0이 된다 (여기서 0log0=0으로 고려).

반면에, 가장 uncertain 한 상황인 p=0.5인 경우, H(x)는 약 0.693 정도로 가장 큰 값을 갖는다.

KL Divergence

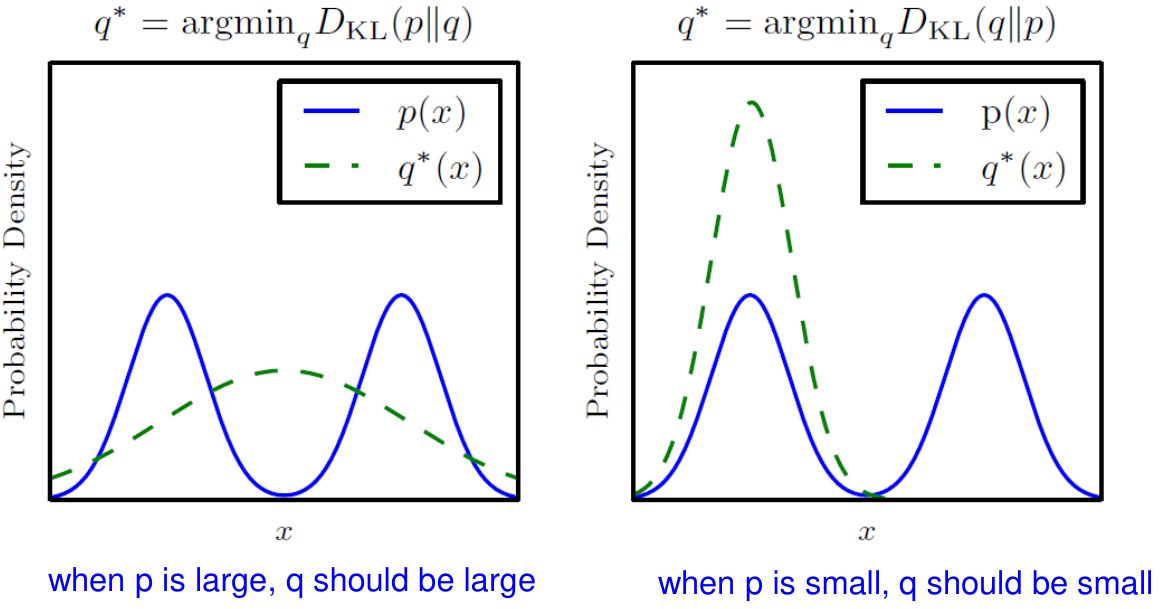

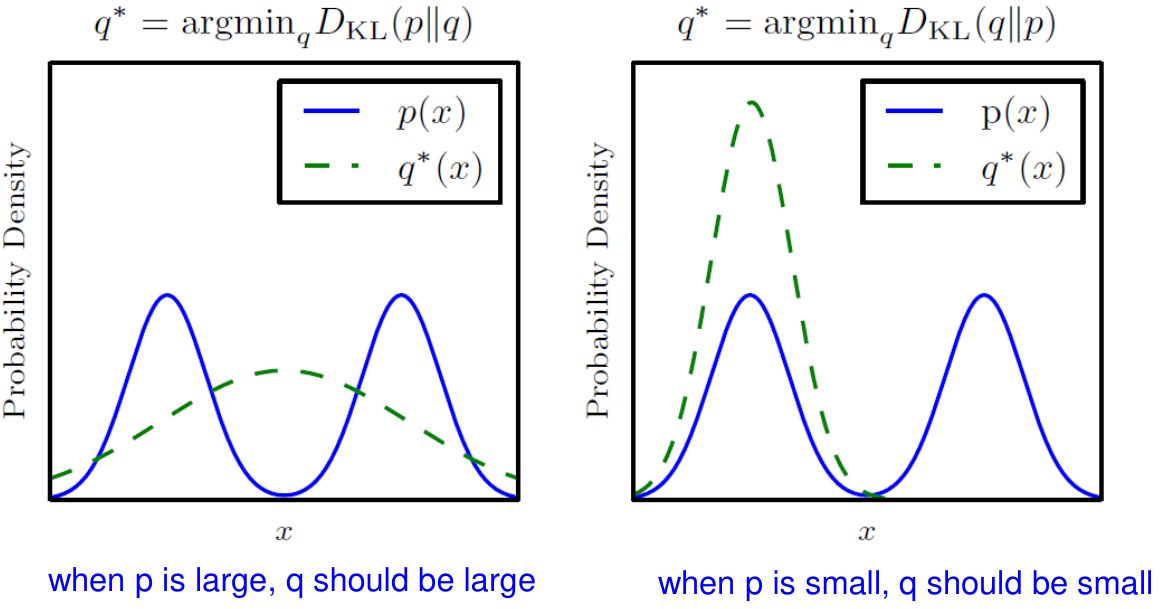

Kullback–Leibler divergence, 또는 KL divergence는 두 distribution에 대한 차이를 나타내는 비대칭적 지표이다.

DKL(P∥Q)=Ex∼P[logQ(x)P(x)]=Ex∼P[logP(x)−logQ(x)]

Cross-entropy

우리가 관심있는 것이 data의 distribution P라고 하자. 하지만, 일반적으로 우리는 P에 대해서는 알지 못한다. 따라서 우리는 P를 모사하는 model을 만들고 P에 대한 추정을 진행한다. 이 때, model의 (output에 대한) distribution을 Q라고 하자.

Cross-entropy는 Q가 model P에 대한 추정을 얼마나 잘하는지를 나타내주는 지표로, 다음과 같이 정의된다.

H(P,Q)=H(P)+DKL(P∥Q)=−Ex∼PlogQ(x)

Cross-entropy는 P를 따르는 주어진 data와 우리가 가정한 distribution Q를 통해 계산할 수 있는 지표로, 이를 최소화하도록 학습을 진행한다면, P에 대해서 더 올바른 추정이 가능하게 된다.

Cross-entropy의 최소화 w.r.t. Q는 KL divergence에 대한 최소화와 동일하다.