chatbot-docker

1. 도커-챗봇 설정

docker pull apptools/chatbot-db:1.0

docker run --privileged -d -p 3306:3306 --name chatbot-db apptools/chatbot-db:1.0

docker exec -e LC_ALL=C.UTF-8 -it chatbot-db /bin/bash

2. mysql

1) mysql 접속

mysql -u root -p

2) db 생성

create database flyai;

use flyai;

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| flyai |

| information_schema |

| mysql |

| performance_schema |

| sys |

+--------------------+

5 rows in set (0.00 sec)

3) 테이블 추가

create table chatbot(

num int not null auto_increment,

type varchar(4),

msg varchar(200),

indate varchar(50),

primary key(num)

);

mysql> desc chatbot;

+--------+--------------+------+-----+---------+----------------+

| Field | Type | Null | Key | Default | Extra |

+--------+--------------+------+-----+---------+----------------+

| num | int | NO | PRI | NULL | auto_increment |

| type | varchar(4) | YES | | NULL | |

| msg | varchar(200) | YES | | NULL | |

| indate | varchar(50) | YES | | NULL | |

+--------+--------------+------+-----+---------+----------------+

4 rows in set (0.00 sec)

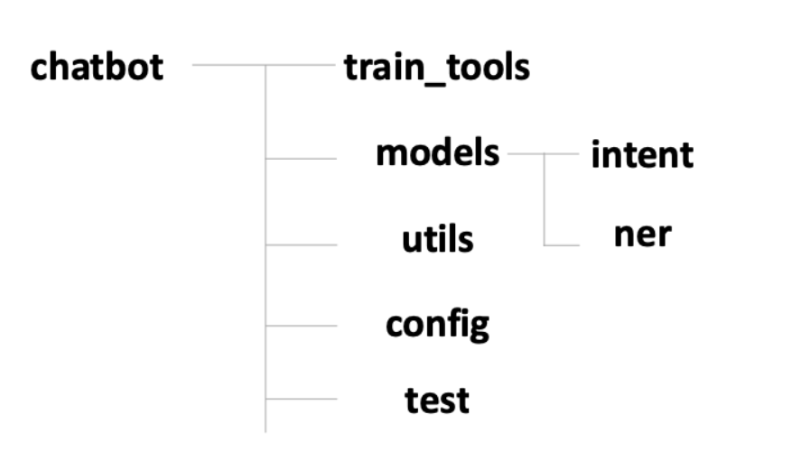

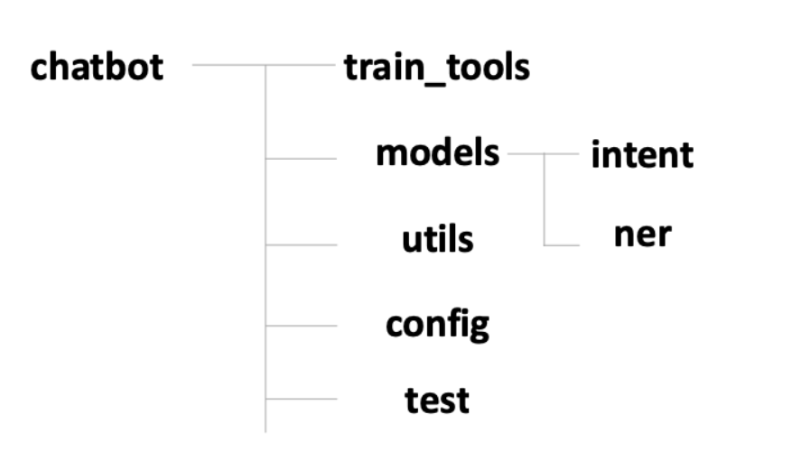

3. 챗봇 학습 툴 만들기

1) 프로젝트 구조

2) config/DatabaseConfig.py

- DB_HOST : 명령 프롬프트에서 ipconfig 실행 후 무선 LAN IP 확인

DB_HOST = "172.23.254.237"

DB_USER = "root"

DB_PASSWORD = "apptools"

DB_NAME = "flyai"

def DatabaseConfig():

global DB_HOST, DB_USER, DB_PASSWORD, DB_NAME

import pymysql

import sys

sys.path.append('c:/flyai/chatbot')

from config.DatabaseConfig import * # DB 접속 정보 불러오기

db = None

try:

db = pymysql.connect(

host=DB_HOST,

user=DB_USER,

passwd=DB_PASSWORD,

db=DB_NAME,

charset='utf8'

)

# 테이블 생성 sql 정의

sql = '''

CREATE TABLE IF NOT EXISTS chatbot_train_data (

id INT UNSIGNED NOT NULL AUTO_INCREMENT,

intent VARCHAR(45) NULL,

ner VARCHAR(1024) NULL,

query TEXT NULL,

answer TEXT NOT NULL,

answer_image VARCHAR(2048) NULL,

PRIMARY KEY (id)

);

'''

# 테이블 생성

with db.cursor() as cursor:

cursor.execute(sql)

except Exception as e:

print(e)

finally:

if db is not None:

db.close()

cd c:/flyai/chatbot/train_tools/qna

python ./create_train_data_table.py

import pymysql

import openpyxl

import sys

sys.path.append('c:/flyai/chatbot')

from config.DatabaseConfig import * # DB 접속 정보 불러오기

# 학습 데이터 초기화

def all_clear_train_data(db):

# 기존 학습 데이터 삭제

sql = '''

delete from chatbot_train_data

'''

with db.cursor() as cursor:

cursor.execute(sql)

# auto increment 초기화

sql = '''

ALTER TABLE chatbot_train_data AUTO_INCREMENT=1

'''

with db.cursor() as cursor:

cursor.execute(sql)

# db에 데이터 저장

def insert_data(db, xls_row):

intent, ner, query, answer, answer_img_url = xls_row

sql = '''

INSERT chatbot_train_data(intent, ner, query, answer, answer_image)

values(

'%s', '%s', '%s', '%s', '%s'

)

''' % (intent.value, ner.value, query.value, answer.value, answer_img_url.value)

# 엑셀에서 불러온 cell에 데이터가 없는 경우, null 로 치환

sql = sql.replace("'None'", "null")

with db.cursor() as cursor:

cursor.execute(sql)

print('{} 저장'.format(query.value))

db.commit()

train_file = './train_data.xlsx'

db = None

try:

db = pymysql.connect(

host=DB_HOST,

user=DB_USER,

passwd=DB_PASSWORD,

db=DB_NAME,

charset='utf8'

)

# 기존 학습 데이터 초기화

all_clear_train_data(db)

# 학습 엑셀 파일 불러오기

wb = openpyxl.load_workbook(train_file)

sheet = wb['Sheet1']

for row in sheet.iter_rows(min_row=2): # 해더는 불러오지 않음

# 데이터 저장

insert_data(db, row)

wb.close()

except Exception as e:

print(e)

finally:

if db is not None:

db.close()

cd c:/flyai/chatbot/train_tools/qna

python ./load_train_data.py

mysql> select id,intent, ner, query from chatbot_train_data;

+----+--------+-----------+--------------------------+

| id | intent | ner | query |

+----+--------+-----------+--------------------------+

| 1 | 인사 | NULL | 안녕하세요 |

| 2 | 인사 | NULL | 반가워요 |

| 3 | 주문 | B_FOOD | {B_FOOD} 주문할게요 |

| 4 | 주문 | B_FOOD | {B_FOOD} 주문할게요 |

| 5 | 예약 | B_DT,B_TI | {B_DT} 예약 |

| 6 | 욕설 | NULL | NULL |

+----+--------+-----------+--------------------------+

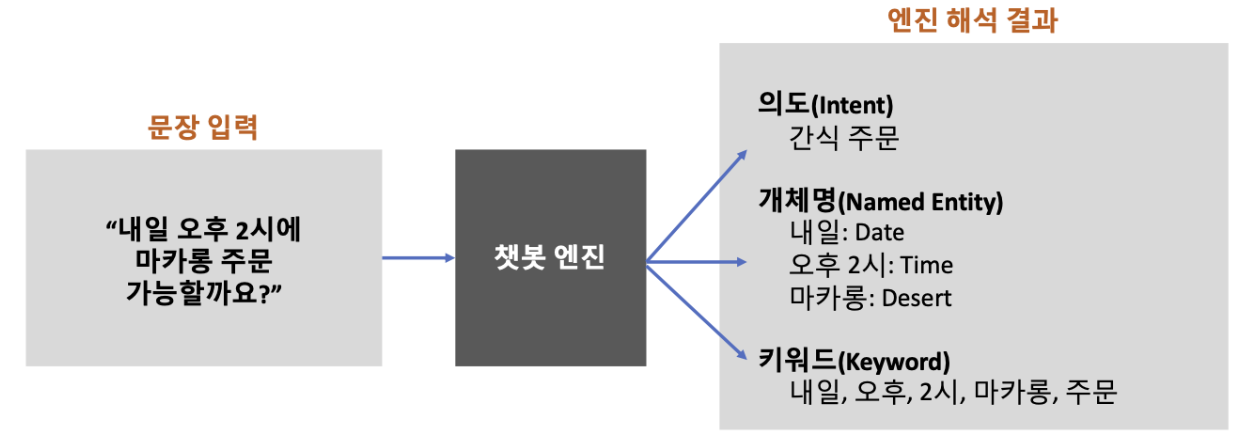

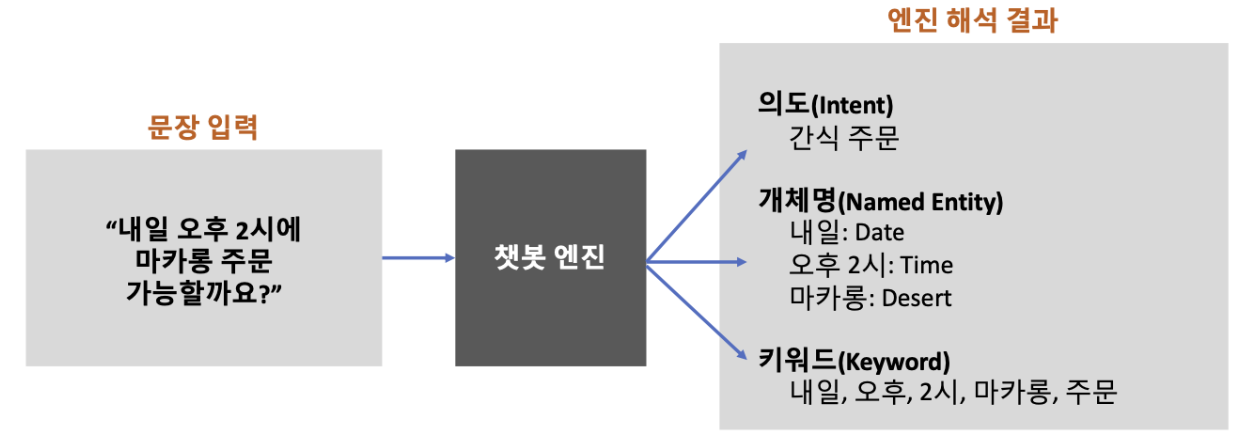

4. 챗봇 엔진 만들기

1) 라이브러리 설치

pip install konlpy

pip install seqeval

pip install tensorflow

2) utils/Preprocess.py

from konlpy.tag import Komoran

import pickle

class Preprocess:

# 생성자

def __init__(self, word2index_dic="", userdic=None):

# 단어 인덱스 사전 불러오기

if word2index_dic != "":

f = open(word2index_dic, "rb")

self.word_index = pickle.load(f)

f.close()

else:

self.word_index = None

# 형태소 분석기 초기화

self.komoran = Komoran(userdic=userdic)

# 제외할 품사

# 참조: https://docs.komoran.kr/firststep/postypes.html

self.exclusion_tags = [

"JKS", "JKC", "JKG", "JKO", "JKB", "JKV", "JKQ", "JX", "JC", # 관계언 제거

"SF", "SP", "SS", "SE", "SO", # 기호 제거

"EP", "EF", "EC", "ETN", "ETM", # 어미 제거

"XSN", "XSV", "XSA", # 접미사 제거

]

# 형태소 분석기 POS tagger (래퍼 함수)

def pos(self, sentence):

return self.komoran.pos(sentence)

# 불용어 제거 후 필요한 품사 정보만 가져오기

def get_keywords(self, pos, without_tag=False):

f = lambda x: x in self.exclusion_tags

word_list = []

for p in pos:

if f(p[1]) is False: # 불용어 리스트에 없는 경우에만 저장

word_list.append(p if without_tag is False else p[0])

return word_list

# 키워드를 단어 인덱스 시퀀스로 변환

def get_wordidx_sequence(self, keywords):

if self.word_index is None:

return []

w2i = []

for word in keywords:

try:

w2i.append(self.word_index[word])

except KeyError:

# 해당 단어가 사전에 없는 경우 OOV 처리

w2i.append(self.word_index["OOV"])

return w2i

- 위 사이트에서 corpus.txt 다운로드 후 붙여넣자.

import sys

sys.path.append('c:/flyai/chatbot')

from utils.Preprocess import Preprocess

from tensorflow.keras import preprocessing

import pickle

# 말뭉치 데이터 읽어오기

def read_corpus_data(filename):

with open(filename, "r", encoding='utf8') as f:

data = [line.split("\t") for line in f.read().splitlines()]

data = data[1:] # 헤더 제거

return data

# 말뭉치 데이터 가져오기

corpus_data = read_corpus_data("./corpus.txt")

# 말뭉치 데이터에서 키워드만 추출해서 사전 리스트 생성

p = Preprocess()

dict = []

for c in corpus_data:

pos = p.pos(c[1])

for k in pos:

dict.append(k[0])

# 사전에 사용될 단어 인덱스 딕셔너리(word_index) 생성

tokenizer = preprocessing.text.Tokenizer(oov_token="OOV")

tokenizer.fit_on_texts(dict)

word_index = tokenizer.word_index

# 사전 파일 생성

f = open("chatbot_dict.bin", "wb")

try:

pickle.dump(word_index, f)

except Exception as e:

print(e)

finally:

f.close()

5) config/globalparams.py

# 단어 시퀀스 벡터 크기

MAX_SEQ_LEN =15

def GlobalParams():

global MAX_SEQ_LEN

6) model/intent/total_train_data.csv

7) utils/user_dic.tsv

8) model/intent/train_model.py

# 필요한 모듈 임포트

import pandas as pd

import tensorflow as tf

from tensorflow.keras import preprocessing

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Embedding, Dense, Dropout, Conv1D, GlobalMaxPool1D, concatenate

# 데이터 읽어오기

train_file = "total_train_data.csv"

data = pd.read_csv(train_file, delimiter=',')

queries = data['query'].tolist()

intents = data['intent'].tolist()

import sys

sys.path.append('c:/flyai/chatbot')

from utils.Preprocess import Preprocess

p = Preprocess(word2index_dic='../../train_tools/dict/chatbot_dict.bin',

userdic='../../utils/user_dic.tsv')

# 단어 시퀀스 생성

sequences = []

for sentence in queries:

pos = p.pos(sentence)

keywords = p.get_keywords(pos, without_tag=True)

seq = p.get_wordidx_sequence(keywords)

sequences.append(seq)

# 단어 인덱스 시퀀스 벡터

# 단어 시퀀스 벡터 크기

from config.GlobalParams import MAX_SEQ_LEN

padded_seqs = preprocessing.sequence.pad_sequences(sequences, maxlen=MAX_SEQ_LEN, padding='post')

# (105658, 15)

print(padded_seqs.shape)

print(len(intents)) #105658

# 학습용, 검증용, 테스트용 데이터셋 생성

# 학습셋:검증셋:테스트셋 = 7:2:1

ds = tf.data.Dataset.from_tensor_slices((padded_seqs, intents))

ds = ds.shuffle(len(queries))

train_size = int(len(padded_seqs) * 0.7)

val_size = int(len(padded_seqs) * 0.2)

test_size = int(len(padded_seqs) * 0.1)

train_ds = ds.take(train_size).batch(20)

val_ds = ds.skip(train_size).take(val_size).batch(20)

test_ds = ds.skip(train_size + val_size).take(test_size).batch(20)

# 하이퍼 파라미터 설정

dropout_prob = 0.5

EMB_SIZE = 128

EPOCH = 5

VOCAB_SIZE = len(p.word_index) + 1 #전체 단어 개수

# CNN 모델 정의

input_layer = Input(shape=(MAX_SEQ_LEN,))

embedding_layer = Embedding(VOCAB_SIZE, EMB_SIZE, input_length=MAX_SEQ_LEN)(input_layer)

dropout_emb = Dropout(rate=dropout_prob)(embedding_layer)

conv1 = Conv1D(

filters=128,

kernel_size=3,

padding='valid',

activation=tf.nn.relu)(dropout_emb)

pool1 = GlobalMaxPool1D()(conv1)

conv2 = Conv1D(

filters=128,

kernel_size=4,

padding='valid',

activation=tf.nn.relu)(dropout_emb)

pool2 = GlobalMaxPool1D()(conv2)

conv3 = Conv1D(

filters=128,

kernel_size=5,

padding='valid',

activation=tf.nn.relu)(dropout_emb)

pool3 = GlobalMaxPool1D()(conv3)

# 3,4,5gram 이후 합치기

concat = concatenate([pool1, pool2, pool3])

hidden = Dense(128, activation=tf.nn.relu)(concat)

dropout_hidden = Dropout(rate=dropout_prob)(hidden)

logits = Dense(5, name='logits')(dropout_hidden)

predictions = Dense(5, activation=tf.nn.softmax)(logits)

# 모델 생성

model = Model(inputs=input_layer, outputs=predictions)

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 모델 학습

model.fit(train_ds, validation_data=val_ds, epochs=EPOCH, verbose=1)

# 모델 평가(테스트 데이터 셋 이용)

loss, accuracy = model.evaluate(test_ds, verbose=1)

print('Accuracy: %f' % (accuracy * 100))

print('loss: %f' % (loss))

# 모델 저장

model.save('intent_model.h5')

cd c:/flyai/chatbot/models/intent

python train_model.py

9) model/intent/intentModel.py

import tensorflow as tf

from tensorflow.keras.models import Model, load_model

from tensorflow.keras import preprocessing

# 의도 분류 모델 모듈

class IntentModel:

def __init__(self, model_name, proprocess):

# 의도 클래스 별 레이블

self.labels = {0: "인사", 1: "욕설", 2: "주문", 3: "예약", 4: "기타"}

# 의도 분류 모델 불러오기

self.model = load_model(model_name)

# 챗봇 Preprocess 객체

self.p = proprocess

# 의도 클래스 예측

def predict_class(self, query):

# 형태소 분석

pos = self.p.pos(query)

# 문장내 키워드 추출(불용어 제거)

keywords = self.p.get_keywords(pos, without_tag=True)

sequences = [self.p.get_wordidx_sequence(keywords)]

# 단어 시퀀스 벡터 크기

from config.GlobalParams import MAX_SEQ_LEN

# 패딩처리

padded_seqs = preprocessing.sequence.pad_sequences(sequences, maxlen=MAX_SEQ_LEN, padding='post')

predict = self.model.predict(padded_seqs)

predict_class = tf.math.argmax(predict, axis=1)

return predict_class.numpy()[0]

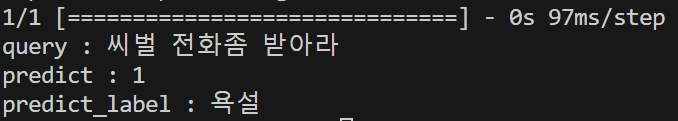

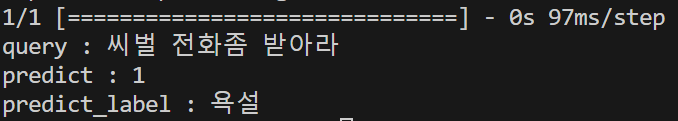

10) test/model_intent_test.py

import sys

sys.path.append('c:/flyai/chatbot')

from utils.Preprocess import Preprocess

from models.intent.IntentModel import IntentModel

p = Preprocess(word2index_dic='../train_tools/dict/chatbot_dict.bin',

userdic='../utils/user_dic.tsv')

intent = IntentModel(model_name='../models/intent/intent_model.h5', proprocess=p)

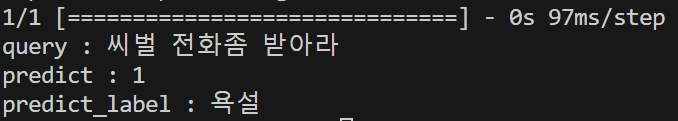

query = "씨벌 전화좀 받아라"

predict = intent.predict_class(query)

predict_label = intent.labels[predict]

cd c:/flyai/chatbot/test

python model_intent_test.py

- 결과

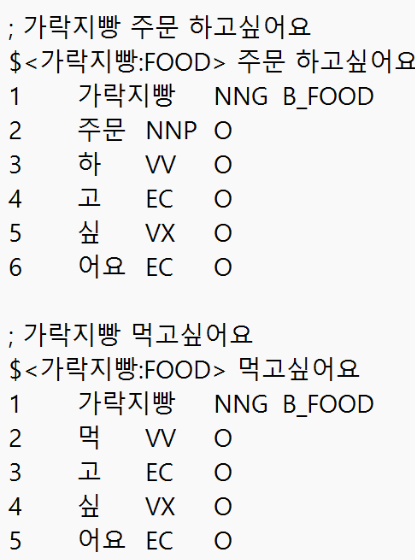

5. 개체명 인식 모델 학습

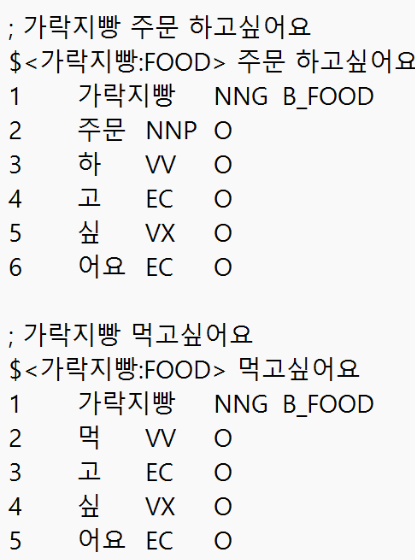

1) models/ner/ner_train.txt

- 경로에 붙여넣기

2) /models/ner/train_model.py

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras import preprocessing

from sklearn.model_selection import train_test_split

import numpy as np

import sys

sys.path.append('c:/flyai/chatbot')

from utils.Preprocess import Preprocess

# 학습 파일 불러오기

def read_file(file_name):

sents = []

with open(file_name, 'r', encoding='utf-8') as f:

lines = f.readlines()

for idx, l in enumerate(lines):

if l[0] == ';' and lines[idx + 1][0] == '$':

this_sent = []

elif l[0] == '$' and lines[idx - 1][0] == ';':

continue

elif l[0] == '\n':

sents.append(this_sent)

else:

this_sent.append(tuple(l.split()))

return sents

p = Preprocess(word2index_dic='../../train_tools/dict/chatbot_dict.bin',

userdic='../../utils/user_dic.tsv')

# 학습용 말뭉치 데이터를 불러옴

corpus = read_file('ner_train.txt')

# 말뭉치 데이터에서 단어와 BIO 태그만 불러와 학습용 데이터셋 생성

sentences, tags = [], []

for t in corpus:

tagged_sentence = []

sentence, bio_tag = [], []

for w in t:

tagged_sentence.append((w[1], w[3]))

sentence.append(w[1])

bio_tag.append(w[3])

sentences.append(sentence)

tags.append(bio_tag)

print("샘플 크기 : \n", len(sentences))

print("0번 째 샘플 단어 시퀀스 : \n", sentences[0])

print("0번 째 샘플 bio 태그 : \n", tags[0])

print("샘플 단어 시퀀스 최대 길이 :", max(len(l) for l in sentences))

print("샘플 단어 시퀀스 평균 길이 :", (sum(map(len, sentences))/len(sentences)))

# 토크나이저 정의

tag_tokenizer = preprocessing.text.Tokenizer(lower=False) # 태그 정보는 lower=False 소문자로 변환하지 않는다.

tag_tokenizer.fit_on_texts(tags)

# 단어사전 및 태그 사전 크기

vocab_size = len(p.word_index) + 1

tag_size = len(tag_tokenizer.word_index) + 1

print("BIO 태그 사전 크기 :", tag_size)

print("단어 사전 크기 :", vocab_size)

# 학습용 단어 시퀀스 생성

x_train = [p.get_wordidx_sequence(sent) for sent in sentences]

y_train = tag_tokenizer.texts_to_sequences(tags)

index_to_ner = tag_tokenizer.index_word # 시퀀스 인덱스를 NER로 변환 하기 위해 사용

index_to_ner[0] = 'PAD'

# 시퀀스 패딩 처리

max_len = 40

x_train = preprocessing.sequence.pad_sequences(x_train, padding='post', maxlen=max_len)

y_train = preprocessing.sequence.pad_sequences(y_train, padding='post', maxlen=max_len)

# 학습 데이터와 테스트 데이터를 8:2의 비율로 분리

x_train, x_test, y_train, y_test = train_test_split(x_train, y_train,

test_size=.2,

random_state=1234)

# 출력 데이터를 one-hot encoding

y_train = tf.keras.utils.to_categorical(y_train, num_classes=tag_size)

y_test = tf.keras.utils.to_categorical(y_test, num_classes=tag_size)

print("학습 샘플 시퀀스 형상 : ", x_train.shape)

print("학습 샘플 레이블 형상 : ", y_train.shape)

print("테스트 샘플 시퀀스 형상 : ", x_test.shape)

print("테스트 샘플 레이블 형상 : ", y_test.shape)

# 모델 정의 (Bi-LSTM)

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Embedding, Dense, TimeDistributed, Dropout, Bidirectional

from tensorflow.keras.optimizers import Adam

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=30, input_length=max_len, mask_zero=True))

model.add(Bidirectional(LSTM(200, return_sequences=True, dropout=0.50, recurrent_dropout=0.25)))

model.add(TimeDistributed(Dense(tag_size, activation='softmax')))

model.compile(loss='categorical_crossentropy', optimizer=Adam(0.01), metrics=['accuracy'])

model.fit(x_train, y_train, batch_size=128, epochs=10)

print("평가 결과 : ", model.evaluate(x_test, y_test)[1])

model.save('ner_model.h5')

# 시퀀스를 NER 태그로 변환

def sequences_to_tag(sequences): # 예측값을 index_to_ner를 사용하여 태깅 정보로 변경하는 함수.

result = []

for sequence in sequences: # 전체 시퀀스로부터 시퀀스를 하나씩 꺼낸다.

temp = []

for pred in sequence: # 시퀀스로부터 예측값을 하나씩 꺼낸다.

pred_index = np.argmax(pred) # 예를 들어 [0, 0, 1, 0 ,0]라면 1의 인덱스인 2를 리턴한다.

temp.append(index_to_ner[pred_index].replace("PAD", "O")) # 'PAD'는 'O'로 변경

result.append(temp)

return result

# f1 스코어 계산을 위해 사용

from seqeval.metrics import f1_score, classification_report

# 테스트 데이터셋의 NER 예측

y_predicted = model.predict(x_test)

pred_tags = sequences_to_tag(y_predicted) # 예측된 NER

test_tags = sequences_to_tag(y_test) # 실제 NER

# F1 평가 결과

print(classification_report(test_tags, pred_tags))

print("F1-score: {:.1%}".format(f1_score(test_tags, pred_tags)))

cd c:/flyai/chatbot/models/ner

python train_model.py

3) models/ner/NerModel.py

import tensorflow as tf

import numpy as np

from tensorflow.keras.models import Model, load_model

from tensorflow.keras import preprocessing

# 개체명 인식 모델 모듈

class NerModel:

def __init__(self, model_name, proprocess):

# BIO 태그 클래스 별 레이블

self.index_to_ner = {1: 'O', 2: 'B_DT', 3: 'B_FOOD', 4: 'I', 5: 'B_OG', 6: 'B_PS', 7: 'B_LC', 8: 'NNP', 9: 'B_TI', 0: 'PAD'}

# 의도 분류 모델 불러오기

self.model = load_model(model_name)

# 챗봇 Preprocess 객체

self.p = proprocess

# 개체명 클래스 예측

def predict(self, query):

# 형태소 분석

pos = self.p.pos(query)

# 문장내 키워드 추출(불용어 제거)

keywords = self.p.get_keywords(pos, without_tag=True)

sequences = [self.p.get_wordidx_sequence(keywords)]

# 패딩처리

max_len = 40

padded_seqs = preprocessing.sequence.pad_sequences(sequences, padding="post", value=0, maxlen=max_len)

predict = self.model.predict(np.array([padded_seqs[0]]))

predict_class = tf.math.argmax(predict, axis=-1)

tags = [self.index_to_ner[i] for i in predict_class.numpy()[0]]

return list(zip(keywords, tags))

def predict_tags(self, query):

# 형태소 분석

pos = self.p.pos(query)

# 문장내 키워드 추출(불용어 제거)

keywords = self.p.get_keywords(pos, without_tag=True)

sequences = [self.p.get_wordidx_sequence(keywords)]

# 패딩처리

max_len = 40

padded_seqs = preprocessing.sequence.pad_sequences(sequences, padding="post", value=0, maxlen=max_len)

predict = self.model.predict(np.array([padded_seqs[0]]))

predict_class = tf.math.argmax(predict, axis=-1)

tags = []

for tag_idx in predict_class.numpy()[0]:

if tag_idx == 1: continue

tags.append(self.index_to_ner[tag_idx])

if len(tags) == 0: return None

return tags

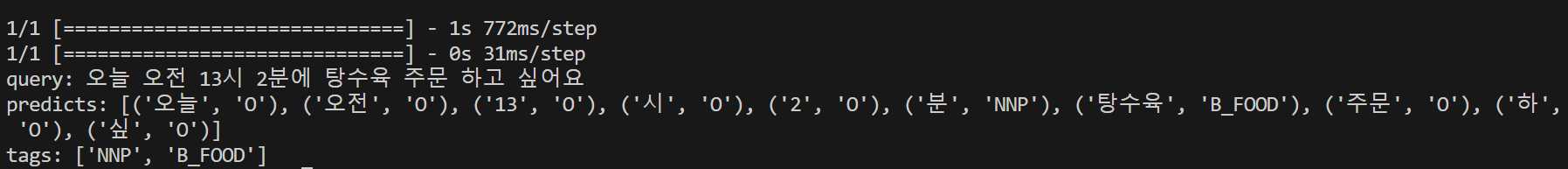

4) test/model_ner_test.py

import sys

sys.path.append('c:/flyai/chatbot')

from utils.Preprocess import Preprocess

from models.ner.NerModel import NerModel

p = Preprocess(word2index_dic='../train_tools/dict/chatbot_dict.bin',

userdic='../utils/user_dic.tsv')

ner = NerModel(model_name='../models/ner/ner_model.h5', proprocess=p)

query = '오늘 오전 13시 2분에 탕수육 주문 하고 싶어요'

predicts = ner.predict(query)

tags = ner.predict_tags(query)

print(predicts)

print(tags)

cd c:/flyai/chatbot/test

python model_ner_test.py