NLP (Natural Language Processing) 즉 자연어 처리라는 말을 AI 뉴스 기사를 몇 번 접해보았다면 들어봤을 말이다. NLP 즉 자연어 처리라는 것은 무엇일까?

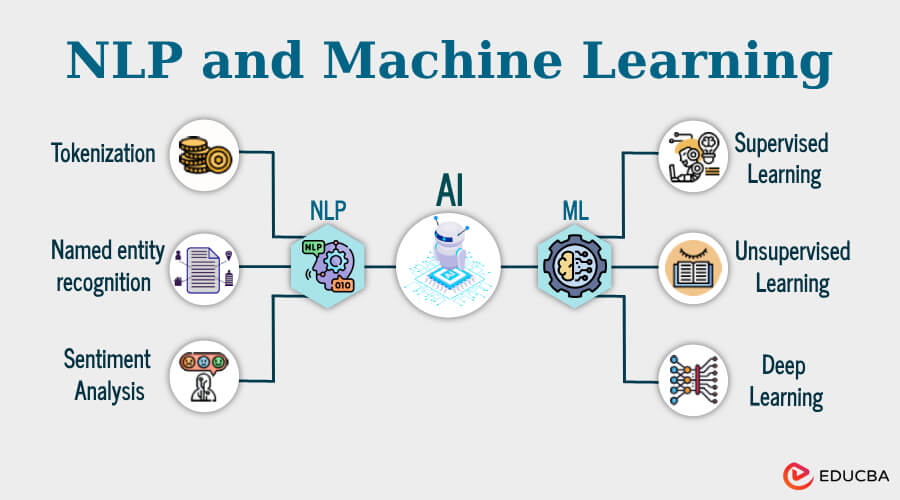

자연어 처리(NLP)는 머신 러닝을 사용하여 컴퓨터가 인간의 언어를 이해하고 소통하도록 돕는 인공 지능(AI)의 하위 분야입니다.

NLP는 인간 언어의 규칙 기반 모델링인 컴퓨터 언어학과 통계 모델링, 머신 러닝, 딥 러닝을 결합하여 컴퓨터 및 디지털 기기가 텍스트와 음성을 인식, 이해, 생성할 수 있게 해줍니다.

출처 : https://www.ibm.com/kr-ko/think/topics/natural-language-processing IBM

즉 우리가 자주 접하는 Chat GPT와 같은 LLM모델을 이용한 AI 기반 챗봇이라든지, 사용자와 소통을 하는 AI기반 타 플랫폼 등 이러한 것들이 모두 NLP를 사용한 기술이다. NLP는 LLM(Large Language Model) 즉 대규모 언어 모델의 커뮤니케이션 기술부터 이미지 생성 모델이 요청을 이해하는 능력에 이르기 까지 생성형 AI 시대를 여는데 큰 도움이 되었다.

이는 이미 사람들에게서 일상의 일부로 자리잡았을 뿐더러, 음성 명령, Amazon의 Alexa, Apple의 Siri 등 여러 분야에서 활동중이다. NLP는 비즈니스 운영의 간소화 및 자동화, 직원 생산성 향상, 비즈니스 프로세스 간소화 등을 지원하는 엔터프라이즈 솔루션에서도 그 역할이 커지고 있다.

이러한 NLP 자연어 처리 분야는 다양한 학문에서 활용된다.

1. Natural Language Processing (자연어 처리)

- 주요 학회 : ACL, EMNLP, NAACL

- 학문 분야

- Low-level parsing

- Tokenization : 가장 작은 정보 단위 토큰(단어), 이러한 token들이 순서에 맞춰서 문장이 됨

- stemming : 같은 단어라도 여려 형태가 존재 (맑다, 맑은, 맑아서, 맑으니), 이러한 측면에서 단어의 다양한 의미 변화를 없애고 의미만을 보존하는 어근을 추출하는 것

- Word and phrase level

- NER(Named Entity Recognation) : 단일단어, 여러 단어로 이루어진 고유명사 (NewYork Times)

- POS(Part-Of-Speech) tagging : 품사를 알아내는 것, 부사구, 형용사구..등

- Sentence level

- 감성 분류(Sentiment Analysis) : 문장 구조가 긍정인지, 부정인지 감성으로 분류

- 기계 번역(Machine Translation) : 주어진 문장을 이해하고 각 언어에 맞는 문법, 순서로 번역

- Multi-sentence and paragraph level

- 논리적 내포 및 모순관계 예측(Entailment Prediction) : 두 문장간에 논리적인 내포, 모순 관계를 예측

- 독해기반 질의응답(question answering) : 질문의 연관 단어가 아닌, 질문의 의미를 독해한 후 도출

- 챗봇(dialog systems) : 챗봇과 같은 대화 수행가능

- 요약(summarization)

- Low-level parsing

2. Text mining (텍스트 마이닝)

- 주요 학회 : KDD, The WebConf(前 WWW), WSDM, CIKM, ICWSM

- 학문 분야

- Extract useful information and insights from text and document data

- 문서 군집화(Document clustering) ex) 토픽 모델링

- Highly related to computational social science : 통계적으로 사회과학적 인사이트 산출

3. Information retrieval (정보 검색) - 성숙한 상태에 이름

- 주요 학회 : SIGIR, WSDM, CIKM, Recsys

- 학문 분야

- Highly related to computational social science

- 정보 검색 분야, 추천 시스템

자연어 처리 분야의 트렌드

- 자연어 처리 분야는 컴퓨터 비전 혹은 영상처리 분야와 더불어 인공지능과 딥러닝 기술이 가장 활발히 적용되며 꾸준비 발전하는 분야 중 하나이다.

- 기존 머신러닝과 딥러닝 기술로 자연어 처리 문제를 해결하기 위해서는 주어진 텍스트 데이터를 숫자로 변환하는 '워드 임베딩(Word Embedding)' 과정을 거치게 된다.

- 텍스트 데이터는 문장을 구성하는 순서 정보가 중요하기 때문에 이를 받아들일 수 있는 특화 모델에 대한 연구가 필요했고, 그 대표적인 예로는 'RNN(Recurrent Neural Network)'이 존재한다. 이후 단점을 보완한 LSTM, GRU 모델이 나와 사용되었다.

- 2017년에는 구글에서 발표한 'Attention is all YOU need' 라는 제목의 논문이 나오면서 '셀프 어텐션(Self-Attention)' 구조를 가진 '트랜스포머(Transformer) 모델'이 각광받기 시작했다. 최근 발표된 대부분의 모델들은 트랜스포머 모델을 기반으로 하는 것이 많으며, 트랜스포머 모델은 주로 사용되던 '기계 번역' 분야를 넘어 현재는 영상/신약개발/시계열 예측 등에서도 다양하게 사용되고 있다.

- 최근에는 자가지도 학습(self-supervised Learning)이 가능한 BERT, GPT 와 같은 모델의 유행하고 있다.

기존의 자연어 처리 기법

1. Bag-Of-Words (단어 가방 모형)

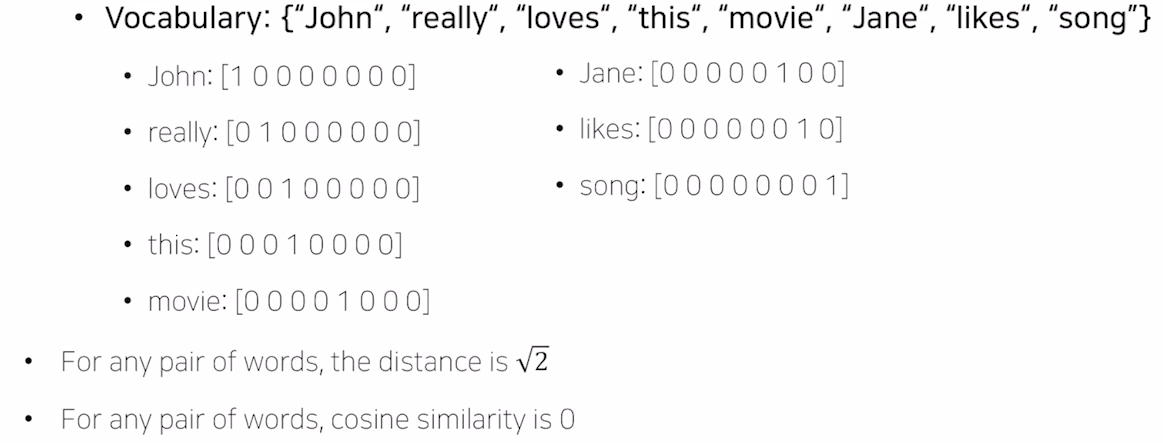

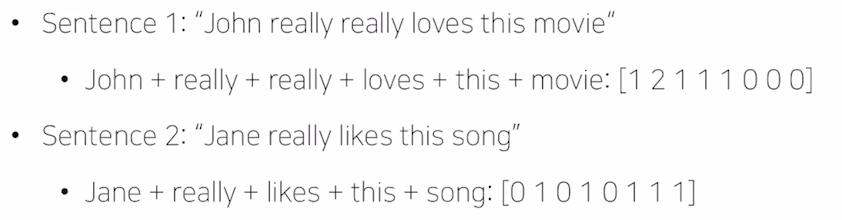

- 단어들의 순서는 전혀 고려하지 않고, 단어들의 출현 빈도(frequency)에만 집중하는 텍스트 데이터의 수치화 표현 방법이다.

- 단어를 벡터로 표현하기 위해서는 주어진 문장에 쓰인 단어들을 사전(Vocabulary) 형태로 저장하며, 이때 주의할 점은 단어들의 중복을 허용하지 않아야 한다.

- 저장된 단어들은 각각 유니크한 카테고리 변수(Categorical variable)이므로, 원-핫 인코딩(One-hot Encoding)를 이용해 벡터로 표현할 수 있다. 이를 통해 주어진 문장을 원-핫 벡터의 합, 즉 숫자로 표현할 수 있게 된다.

- 쉽게 표현하면, Bag-Of-Words는 '가방'이라는 개념을 통해 문장을 구성하고 있는 단어들을 가방에 순차적으로 정리하는 것이다. 가방에 있는 각 단어들은 각각 원-핫 벡터를 통해 숫자로 변환하며, 주어진 문장은 벡터의 합으로 표현된다.

2. Naive Bayes Classifier for Document Classification

- 나이브 베이즈 분류기는 인공 신경망 알고리즘에는 속하지 않지만, 머신러닝의 주요 알고리즘으로 분류에 있어 준수한 성능을 보여주는 것으로 알려져 있다. 나이브 베이즈 분류기를 이해하기 위해서는 우선 베이즈의 정리(Bayes' theorem)를 이해할 필요가 있다. 베이즈 정리는 조건부 확률을 계산하는 방법 중 하나이다.

| Data | Doc(d) | Document (words, w) | Class (c) |

|---|---|---|---|

| Training | 1 | Image recognition used convolutional neural networks | CV |

| 2 | Transformers can be used for image classification task | CV | |

| 3 | Language modeling uses transformer | NLP | |

| 4 | Document classification task is language task | NLP | |

| Test | 5 | Classification task uses transformer | ? |

- 학습 데이터로 주어진 Traing 1~4 번 문장을 통해 우리는 Test data(5번 문장)을 CV, NLP 두 클래스 중에 한 곳으로 분류하려 한다. 5번 문장에 있는 각 단어들이 1~4번 문장에 몇 번 등장했는지를 조건부 확률로 계산하면 쉽게 알 수 있다.

- 다만 이 방식의 맹점은 다른 단어들이 분류하고자 하는 문장에 많이 등장했을지라도, Training data 에서 1번이라도 등장하지 않았다면 모든 단어들의 확률 곱으로 인해 0으로 수렴한다는 점이 다.

- 이와 같은 파라미터 추정 방식은 최대우도법(MLE)을 기반으로 유도된다.