머신러닝이란?

- 한번도 본적없는 data로부터 의미있는 예측값을 생산하기 위해 입력값을 어떻게 조합할지 배우는 것

머신러닝 용어

- label : 예측할 대상값 (단순 선형 회귀에선 y)

- feature : 입력 변수값 (단순 선형 회귀에선 x)

- example : data 예시(unlabeled, labeled) model train을 위해 이용

- model : feature와 label 간의 관계를 정의

- training : 모델을 만들거나 학습하는 것 -> 모델에게 labeled된 example을 제공하고 이를 통해 모델이 feature과 label 사이의 관계를 배우도록 하는 것- inference : unlabeled된 example들에 trained model 적용하는 것 -> 의미있는 예측값을 만들도록 하는것

- model parameter : 올바른 예측값을 얻기 위해 조정하는 변수들

- loss function : 모델의 질을 평가하는 함수(loss function이 작을 수록 좋은 모델이라 할 수 있다.)

-> 손실함수 최적화를 통해 문제상황에 가장 적합한 모델 파라미터를 찾아 모델을 완성하는 것

- Regression(회귀) : 연속적인 값을 예측

- classification(분류) : 이산적인 값을 예측

Regression model

- input 변수를 기반으로 output 변수를 예측 or 추정하는 방법

- 산술적 예측(Numerical Prediction)을 생성하는 모델

Regression model 종류

- linear regression : 두 변수의 관계를 설명하는 선형 함수를 찾아내는 것

- logistic regression : 일반적으로 class 예측에 매핑하는 0.0~1.0 사이 확률을 생성하는 것

linear regression

- 두 변수의 관계를 설명하는 선형 함수를 찾아내는 것

- 실제 데이터에는 노이즈가 있을 수밖에 없고 이런 노이즈들로부터 원래의 선형 연속함수로 돌아가는 과정이기 때문

linear model 세우기

- model : F(m, b; x) = mx+b

- model parameter : m(slope), b(intercept)

- 최소제곱법을 통해 모델 파라미터를 최적화한다.

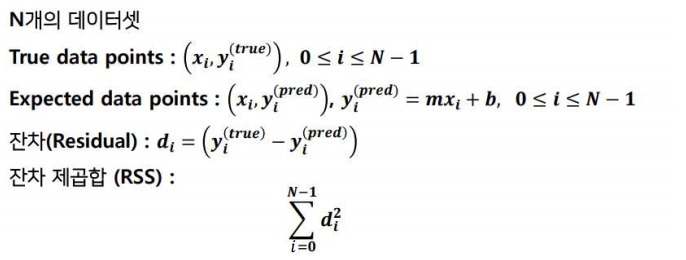

Least Square Method(최소 제곱법)

- 선 또는 곡선에서 Residual(잔차)의 제곱합을 줄이는 방법으로 데이터 점집합에 가장 적합한 곡선 또는 선을 찾는 프로세스 (잔차 : 예측값과 실제값의 차이)

잔차 제곱합(Residual sum of squares, RSS)

- 선형회귀 모델의 학습을 통해 모델파라미터 m, b값을 조절해 RSS 최소화하는 과정

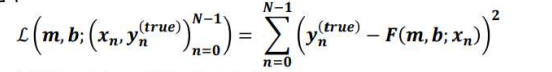

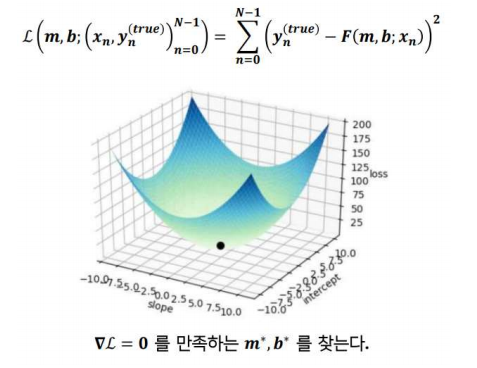

손실함수

- 손실함수를 최소화하는 변수 m, b를 찾는다. 이 과정을 최소제곱법이라 한다.

- 여기서 argmin은 해당 L 를 최소화하는 변수값(m,b) 의 값을 의미한다.

최소제곱법의 한계

- outlier(이상점)이 많은 데이터에서는 사용하지 못한다.

- 모든 data point가 같은 xi를 가지는 경우 사용하지 못한다.

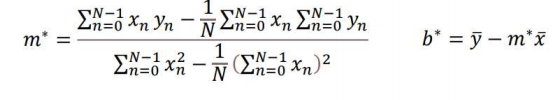

m, b 값 구하기

- loss 값의 m, b에대한 편미분값을 각각 0으로 만들도록 한다.

- 이후 연립을 진행하면

- m, b 를 최소 제곱 추정량이라 한다.

글 재미있게 봤습니다.