Ollama

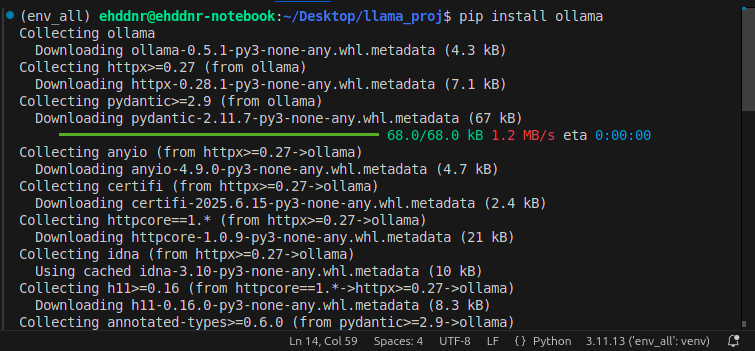

먼저 가상환경을 실행하고 진행합니다.

pip install ollama

from ollama import chat

stream = chat(

model='llama3.1', # 또는 'llama3.1:latest'

messages=[

{'role': 'user',

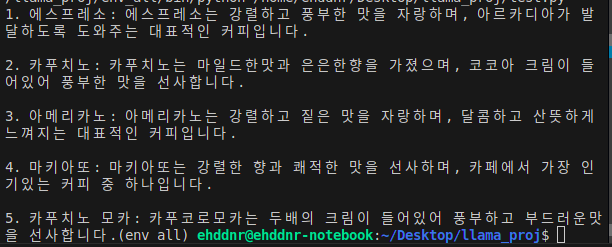

'content': '오늘 마시기 좋은 커피 5개를 추천해주고, 추천한 이유를 알려줘.'}

],

stream=True,

)

for chunk in stream:

print(chunk['message']['content'], end='', flush=True)

1에서 나온 내용을 보면 "아르카디아" 가 발달하도록 도와준다고 하는데..?

5에서도카푸치노 모카라고 잘 얘기했다가 갑자기카푸코로 모카..?라고 답변을 말했다.

?? 할루시네이션이 너무 심각한데??

참으로 어렵다. 이걸 해결하기 위해서는 Fine Tuning이나 다른 방법을 사용해야 된다는데 이게 GPU가 좋아야 되니까 내가 좋은 GPU가 아니라서 좀 고민이다.