Hidden layer(은닉층) activation function

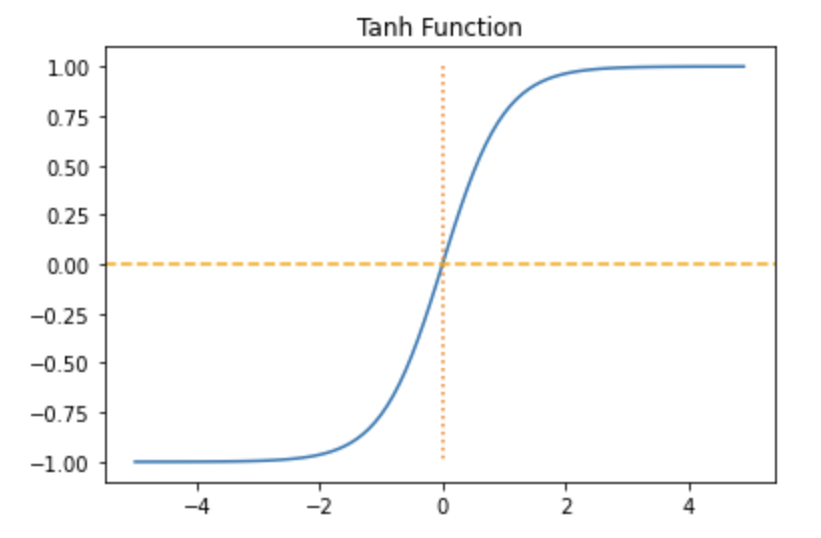

Hyperbolic tangent function

Hidden layer에서 사용

sigmoid 보단 gradient vanishing이 개선되었지만 relu 가 더 많이 쓰임

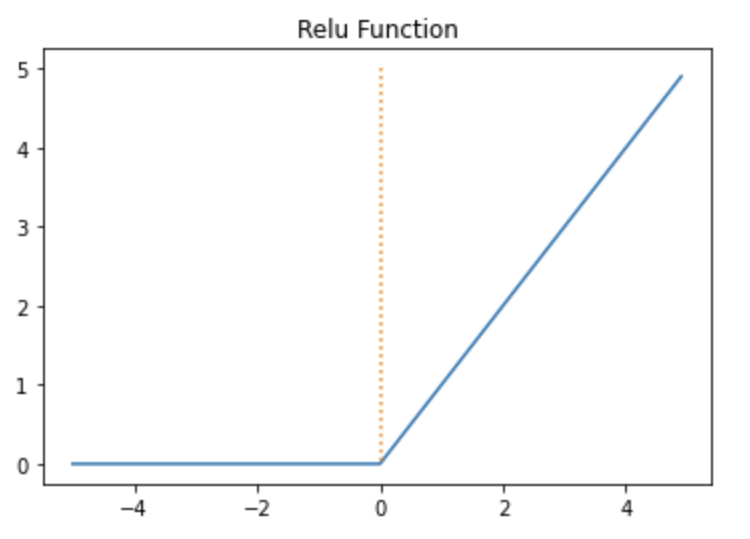

Relu function

0이상의 값은 미분값이 1 -> 깊은 신경망 은닉층에서 잘 동작함

단점 ) 음수면 미분값이 0 -> dying relu

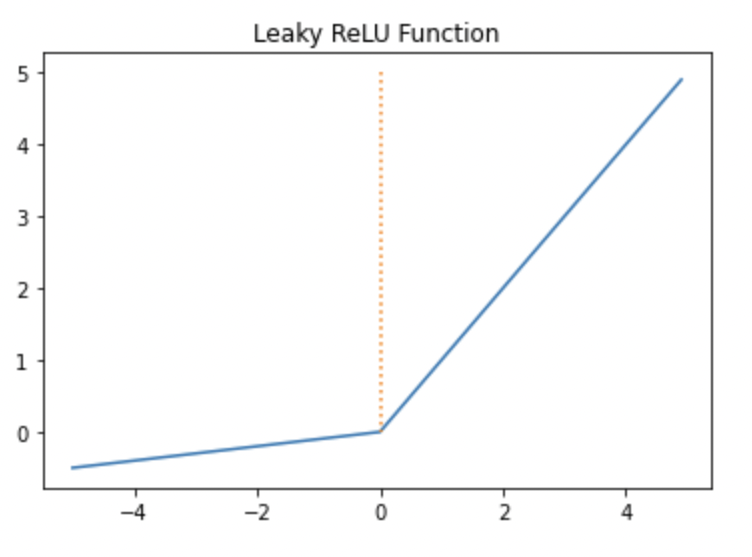

leaky Relu function

relu의 단점을 보완한 relu

음수일 때, 하이퍼파라미터 a(leaky) 의 기울기를 가짐

출력층 activation function

coss function - cross entropy function

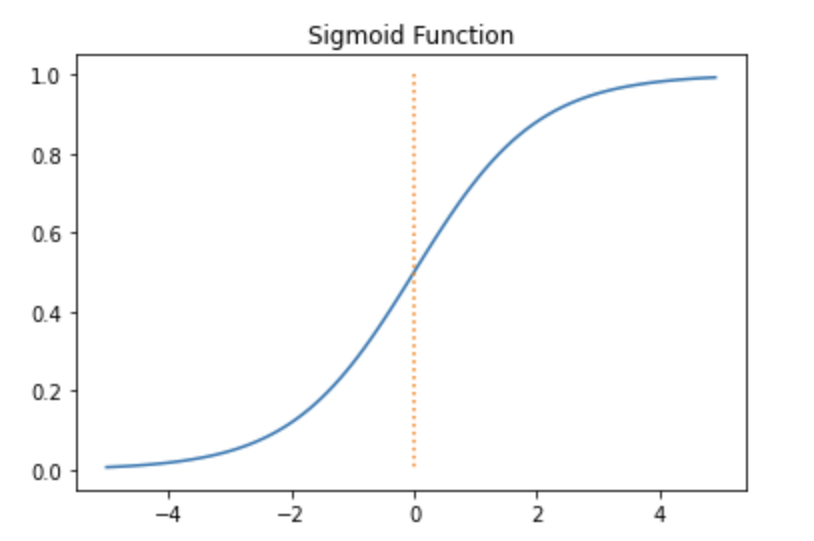

sigmoid function

Binary Classification의 출력층으로 사용

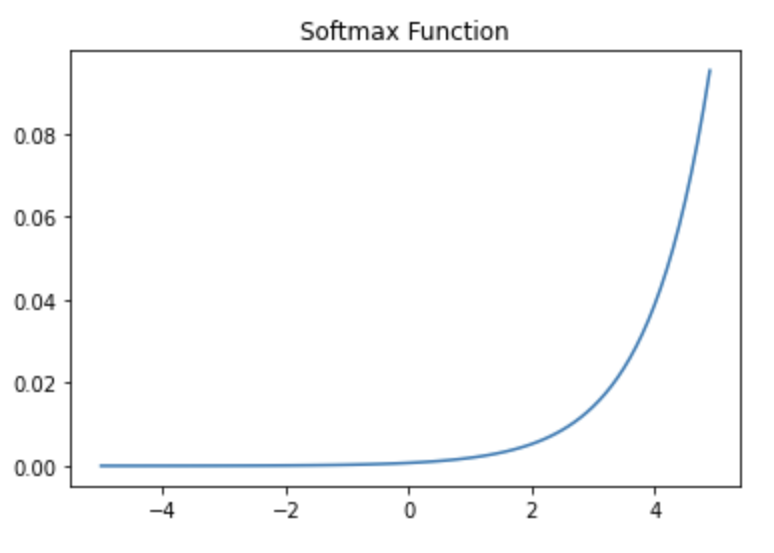

softmax

Multiclass Classification의 출력층으로 사용