최근에 LG AI Research 에서 나온 모델인 Exaone 3.5가 있었다.

그리고 얼마전에 또 추론이 가능한 모델로 Exaone deep 이 출시 되었다.

출처: https://www.lgresearch.ai/exaone

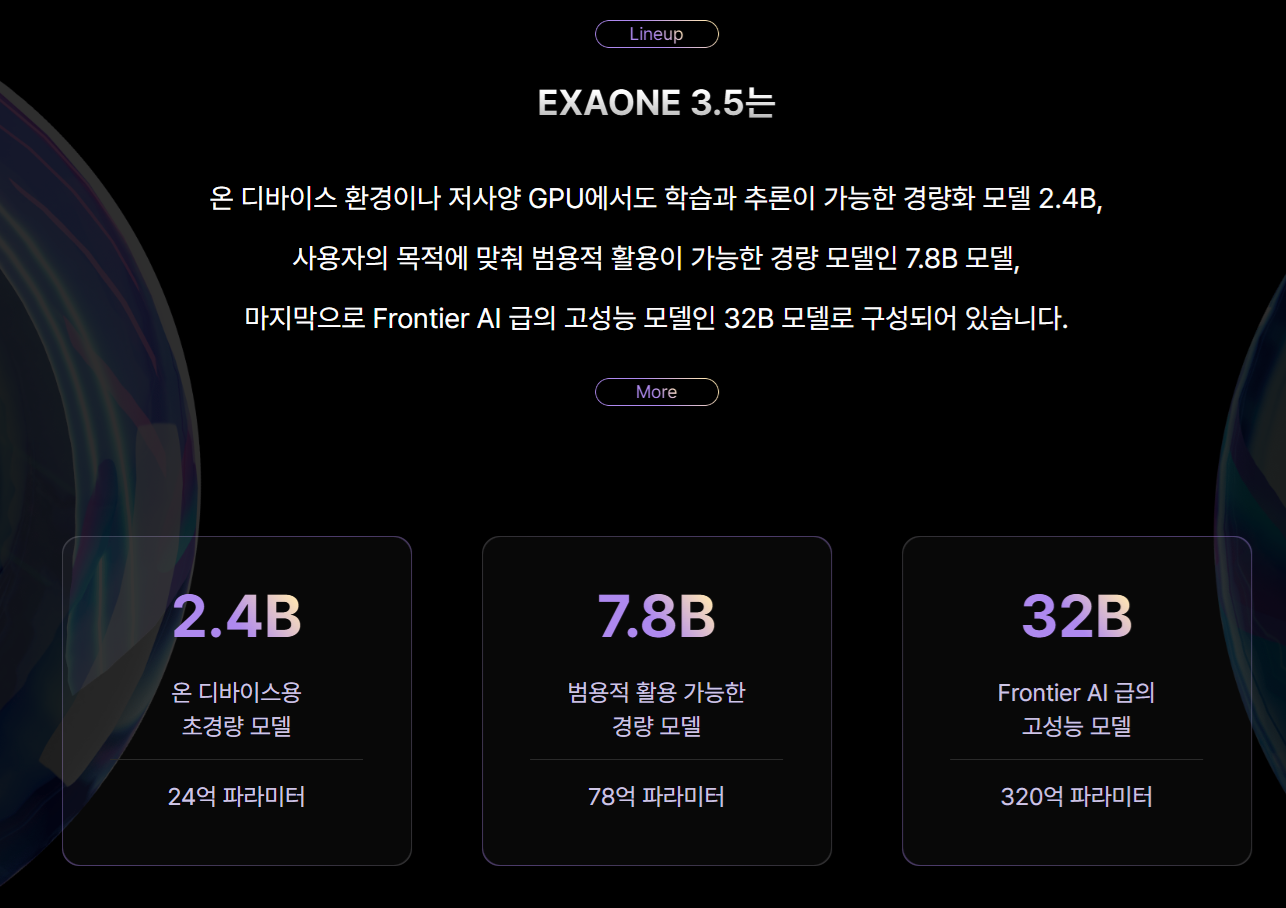

모델 파라미터 수는 2.4B, 7.8B, 32B가 있었다.

내가 가지고 있는 환경에서, 돌릴 수 있는 거는 2.4B랑 7.8B는 무리없이 돌릴 수 있지만, 32B 모델의 경우에는 양자화가 필요하다.

| Models | MATH-500 (pass@1) | AIME 2024 (pass@1/cons@6) | AIME 2025 (pass@1/cons@6) | CSAT Math 2025 (pass@1) | GPQA Diamond (pass@1) | Live Code Bench |

|---|---|---|---|---|---|---|

| EXAONE Deep 32B | 79.5 | 72.1 / 90.0 | 73.7 / 92.6 | 84.5 | 66.1 | 59.5 |

| DeepSeek-R1-Distill-Qwen-32B | 71.3 | 71.2 / 89.3 | 68.5 / 89.2 | 83.4 | 65.9 | 56.3 |

| QwQ-32B | 68.9 | 63.2 / 85.9 | 65.3 / 87.6 | 81.0 | 62.5 | 54.8 |

| DeepSeek-R1 (671B) | 74.3 | 67.6 / 86.7 | 66.4 / 86.2 | 83.1 | 62.9 | 53.7 |

| EXAONE Deep 7.88B | 49.4 | 70.0 / 83.9 | 59.6 / 76.7 | 74.2 | 59.7 | 47.6 |

| DeepSeek-R1-Distill-Qwen-7B | 49.7 | 63.5 / 78.5 | 56.4 / 73.8 | 66.3 | 52.6 | 46.9 |

| DeepSeek-R1-Distill-Llama-8B | 47.1 | 64.6 / 80.0 | 59.3 / 76.4 | 65.7 | 52.2 | 45.9 |

| OpenAI-1 mini | 46.9 | 61.3 / 77.1 | 59.3 / 74.9 | 64.2 | 50.1 | 44.8 |

| EXAONE Deep 2.48B | 29.2 | 59.3 / 72.3 | 37.3 / 64.9 | 56.7 | 39.2 | 32.1 |

| DeepSeek-R1-Distill-Qwen-1.5B | 28.4 | 55.1 / 70.0 | 34.3 / 62.5 | 52.2 | 38.9 | 29.7 |

성능은 아주 준수하게 나온다. 물론 특정 분야긴 하지만, 그래도 엄청 높은 수준이라는 것은 확실하다.

도표출처: https://github.com/LG-AI-EXAONE/EXAONE-Deep?tab=readme-ov-file

https://www.youtube.com/@AZisk 의 유튜브를 참고해보면

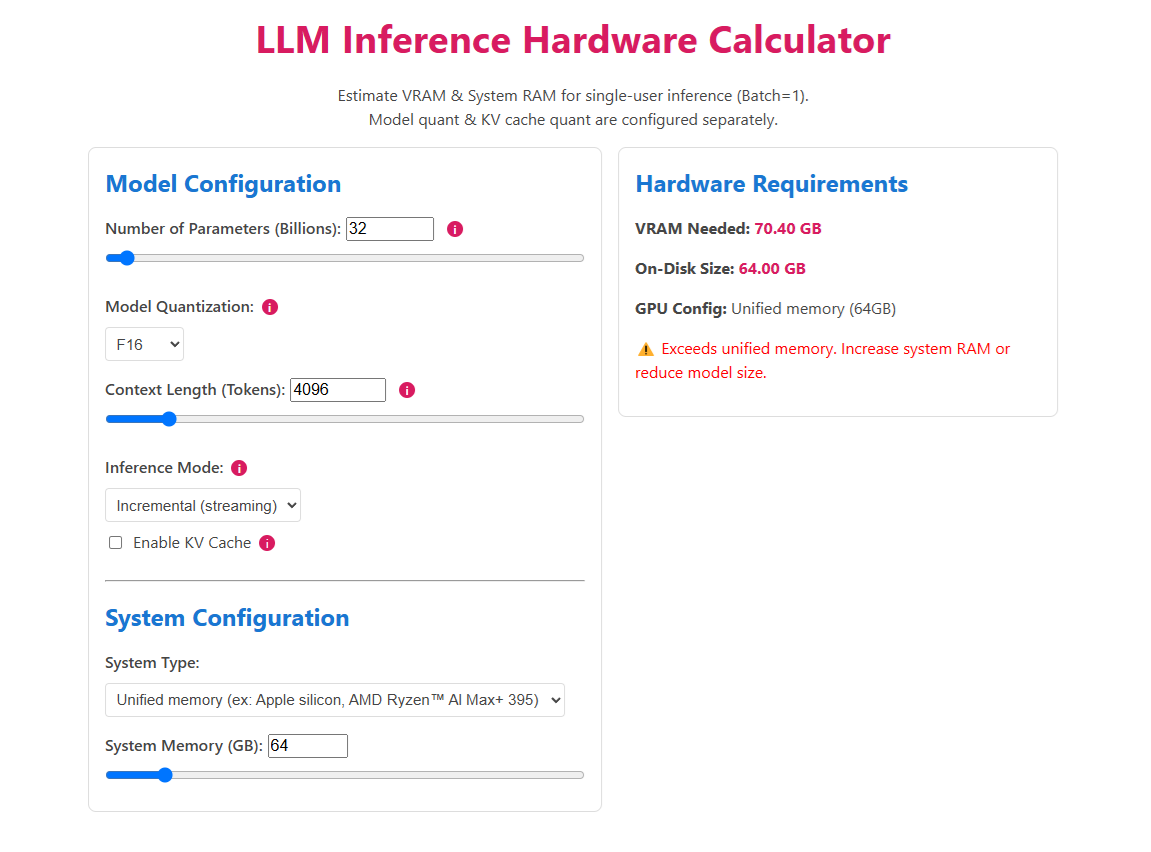

https://llm-inference-calculator-rki02.kinsta.page/ llm 을 돌릴 수 있는 Vram을 계산해주는 홈페이지가 있다.

32B 모델을 돌리기에 FP16(Mac 환경이기 때문)으로는 약간 모자라다. 그래서 Q8 정도로 양자화를 진행하고, 해당 모델을 llama.cpp를 이용해서, ollama에 설치하고, open-webui에 올려 사용해보는 후기를 올리도록 하겠다.

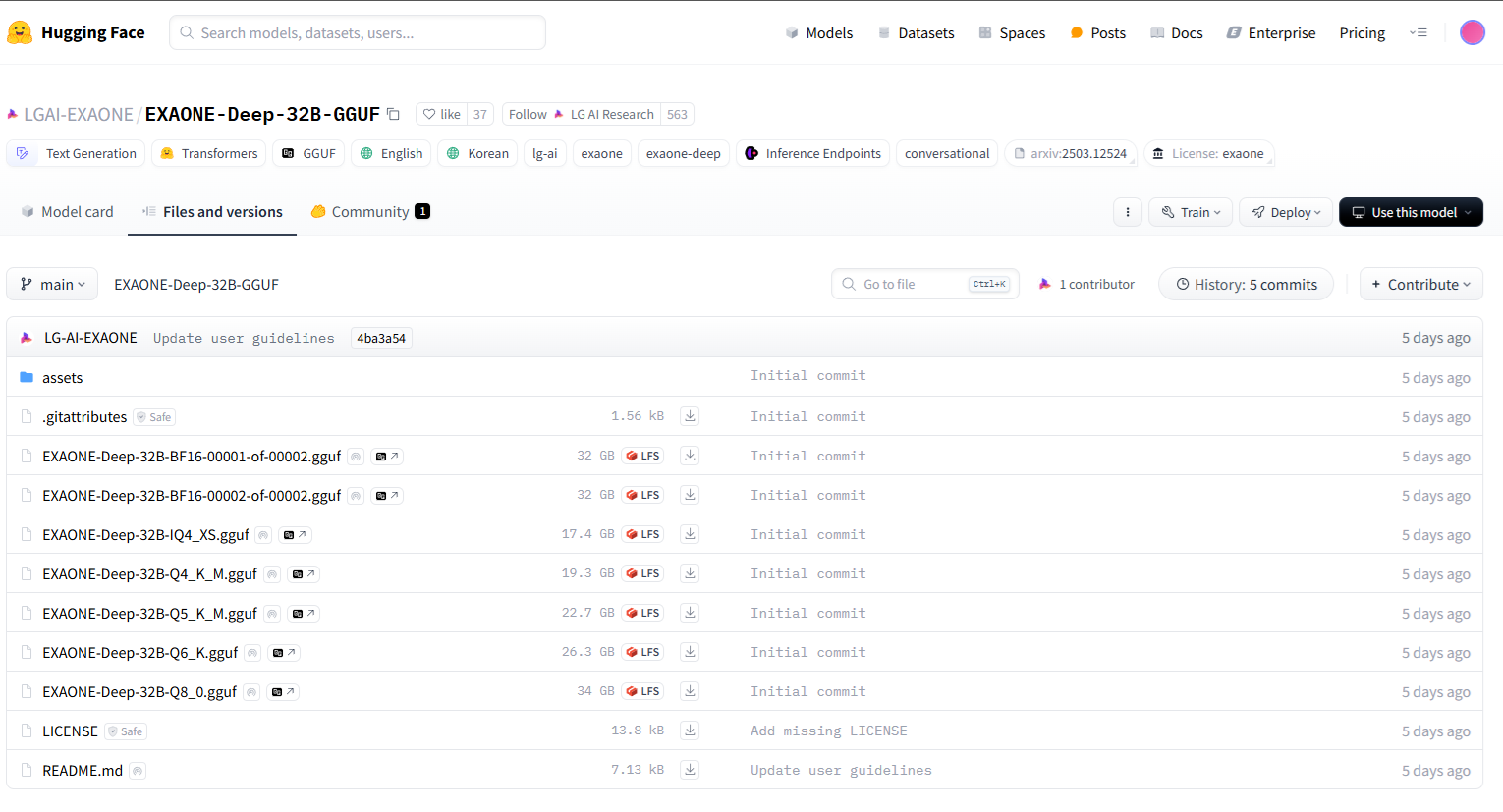

일단 양자화의 경우에는 허깅페이스를 확인해보니,

이미 양자화가 되어있느 gguf 파일들이 있어서, 그냥 Q8 모델을 다운받아서 진행했습니다.

그리고 현재 글 작성 시점에는 ollama에 exaone-deep이 출시가 되어있습니다.

https://ollama.com/library/exaone-deep

제가 진행할 때에는 없어서 직접 다운받아서 했는데, 새로 하실분들은 ollama에서 사용하실거라면 해당 사이트에서 하시는게 편할 것 같습니다.

아무튼 제가 진행한건 이제, Q8로 양자화된 모델을 llama.cpp 이용해서 사용하는 방식이었습니다.

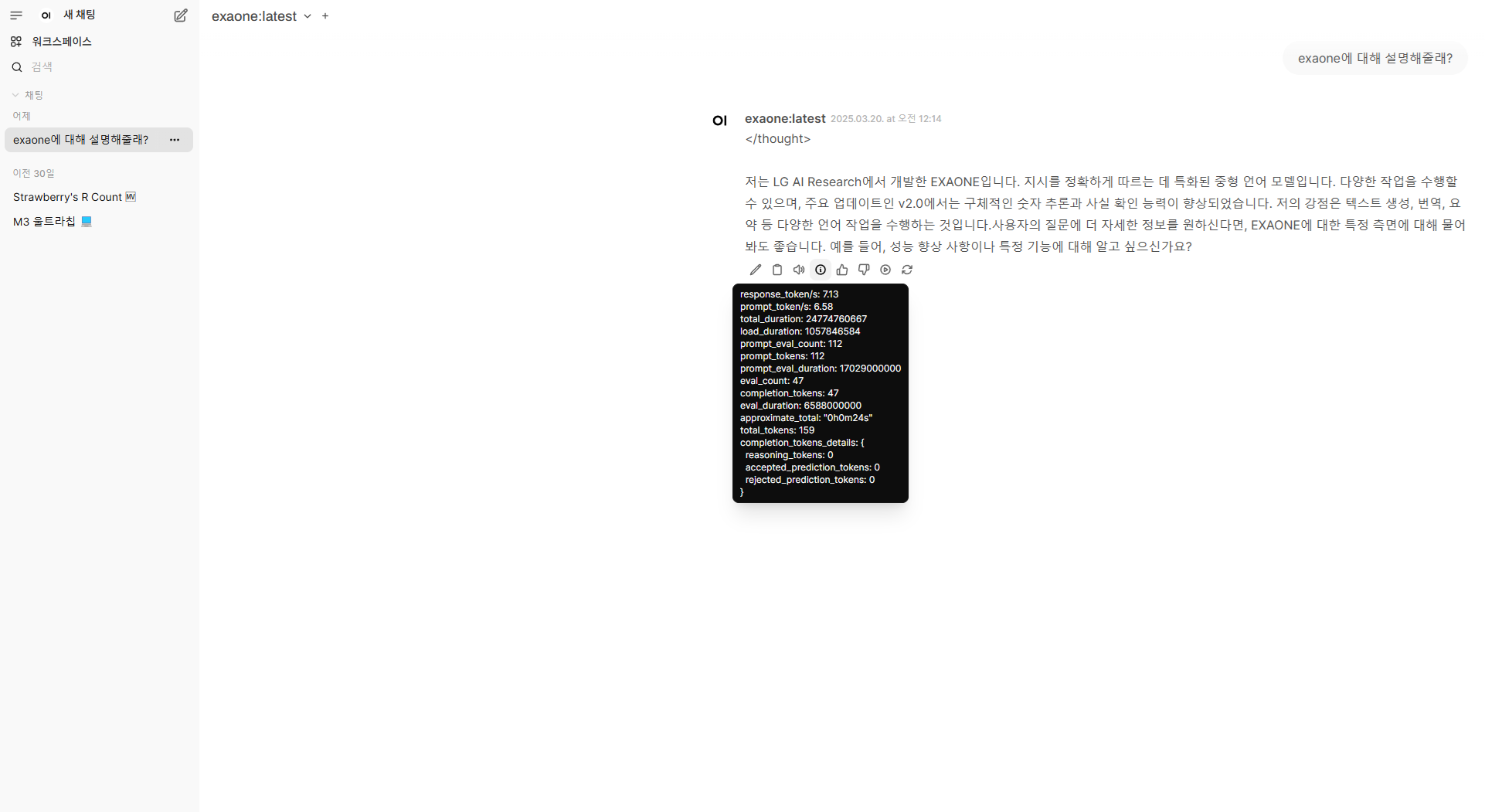

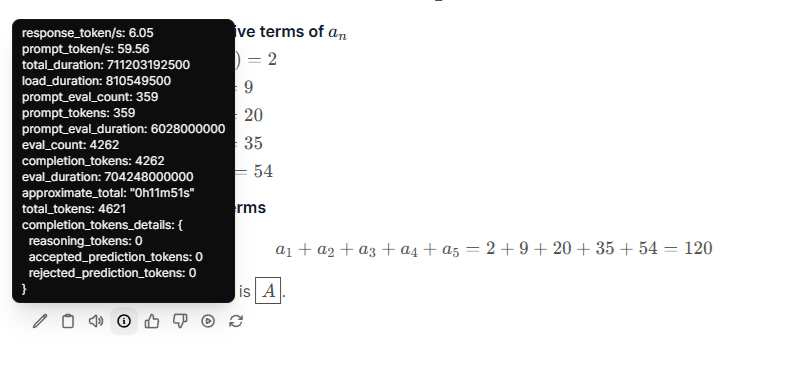

이제 open-webui에서 사용을 해보면,

좋은 것 같다. 속도야 뭐 필자가 mac 환경이라 느린 부분이 있으니까 어쩔 수 없고, 모델 문제는 아니다.

아무튼 한국에서 출시한 모델인 만큼 한국어도 잘 하는 느낌이 들고, 여러 분야에서 사용하기 좋을 것 같다는 생각이다.