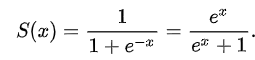

Sigmoid Function(시그모이드 함수)

신경망에서 자주 이용하는 활성화 함수인 Sigmoid Function을 나타낸 식이다.

신경망에서 활성화 함수로 Sigmoid Function를 이용하여,

신호를 변경하고, 그 변환된 신호를 뉴런에 전달한다.

다음은 Sigmoid Function의 그래프이다.

주황색 부분의 기울기를 계산하면 0에 가까운 아주 작은 값이 나오게 된다.

역전파 과정에서 0과 가까운 아주 작은 기울기가 곱해지면, 앞단에는 기울기가 잘 전달되지 않는다. 이러한 현실을 Vanishing Gradient(기울기 소실)문제라고 한다.

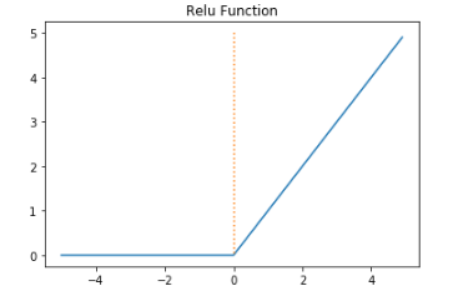

ReLU(Rectified Linear Unit) Function(렐루 함수)

Sigmoid 함수는 신경망 분야에서 오래전부터 이용해왔으나, 최근에는 ReLU 함수를 주로 이용한다.

ReLU는 입력이 0을 넘으면 그 입력을 그대로 출력하고,

0이하이면 0을 출력하는 함수이다

pytorch에서는 torch.nn.relu(x)를 사용하면 된다.

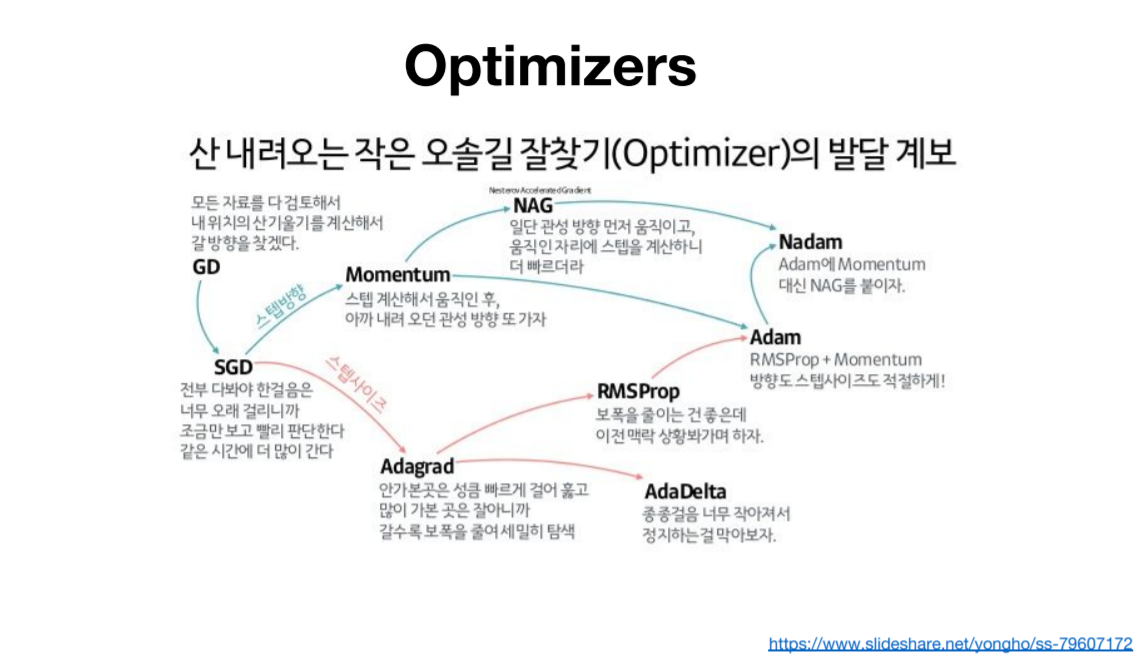

Optimizer

Batch 단위로 Back Propagation하는 과정을 Stochastic Gradient Descent(SGD)라고 하고, 이러한 과정을 Optimization이라고 한다.

SGD 외에도 SGD의 단점을 보완하기 위한 다양한 Optimizer가 있다.