project

1.VPC S3 Gateway Endpoint 설정

VPC S3 Gateway Endpoint 설정을 해주려는 이유는 다음과 같습니다. Private Subnet에 위치한 EC2 인스턴스에서 Airflow DAG를 통해 S3에 대한 api를 지속적으로 호출해야하는 상황입니다. 이때, 일반적인 경우라면 S3에 접속하기

2.[CD] GitHub Actions - Shell Script를 통한 배포

Github Actions를 사용하기 위해서Github repository에 /.github/workflows/ 경로를 생성하고,아래와 같이 2개의 Github Actions 파일을 작성해주겠습니다./.github/workflows/airflow_prod.yml( ma

3.EC2 - Auto Scaling Group 생성

기존 프로젝트를 진행하며 하나의 EC2 내에 Docker를 통한 Airflow 환경을 구축하였습니다.저의 목적은 Airflow Celery Executor를 사용해 여러 개의 Worker node를 만들어 task를 분산처리하는 것입니다.그러나, t3-medium 옵션

4.EC2 내에서 Swap Memory 사용

EC2 내에서 Airflow 시스템을 구축하여 동작을 확인하던 도중,dags 디렉토리에 DAG 파일들을 올리자 EC2 인스턴스가 shut down되는 상황이 발생했습니다.\-> Docker Container들이 차지하는 리소스로 인해 t3.medium의 최대 메모리 3

5.Flower Troubleshooting - Airflow CeleryExecutor 구축기

AWS EC2를 통한 Airflow CeleryExcutor 구축기 를 진행하던 중 발생한Flower Troubleshooting에 관해 다뤄보겠습니다.docker container에 올라간 flower 대시보드가 ALB를 통한 연결이 되지 않는 문제가 발생했었습니다.

6.AWS EC2를 통한 Airflow CeleryExcutor 구축기 1 (VPC, RDS, ElastiCache)

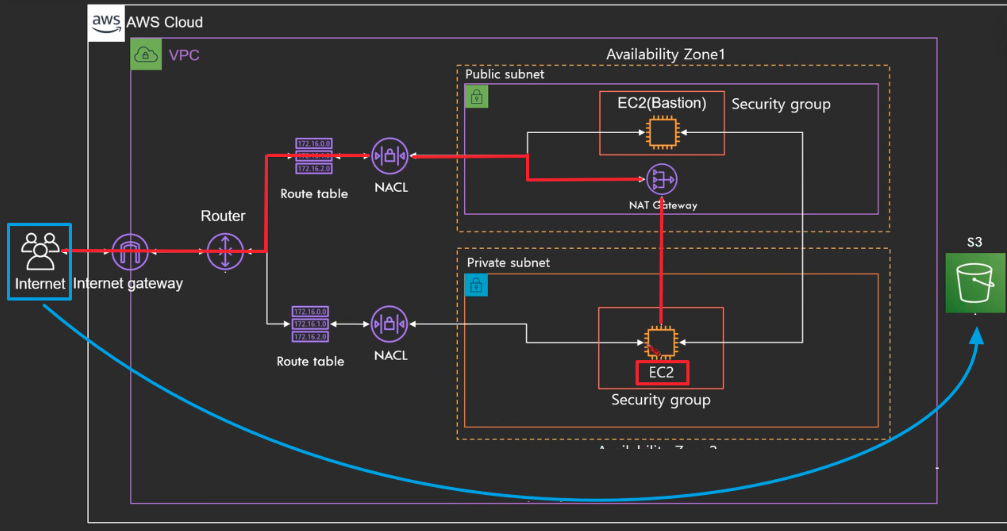

AWS Architecture 프로젝트를 진행하며 위와 같이 AWS Architecture를 구성해보았습니다.WebServer와 Production RDS는 Airflow와 무관한 웹 서비스용이니 제외하고 봐주시면 될 것 같습니다.또한, Chrome Driver는 A

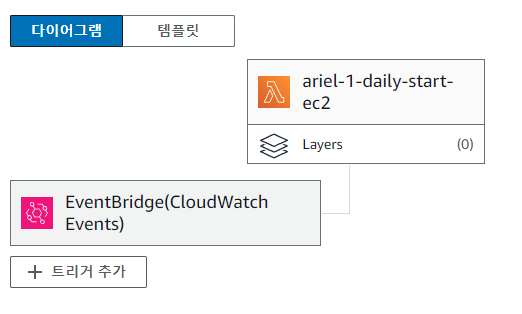

7.AWS 서비스 자동 종료 및 실행

[AWS Infra - Airflow] 자취를 시작하는 분들을 위한 원룸 추천 웹 서비스 제작 위 프로젝트를 진행하며 리소스 낭비를 줄이고자 Lambda함수를 사용해 AWS 서비스를 주기적으로 자동으로 종료하고 실행시키고자합니다. AWS 리소스는 지속적으로 비용을

8.[CD] GitHub Actions - S3와 Lambda 함수를 통한 배포

[CD] GitHub Actions - Shell Script를 통한 배포 초기에는 위 포스팅처럼 Shell Script를 통해 배포를 진행하려했으나, 이 방법의 경우 단일 EC2 인스턴스에 대해서만 배포를 하기 때문에 이를 수정해줄 필요가 있었습니다. 왜냐하면 프

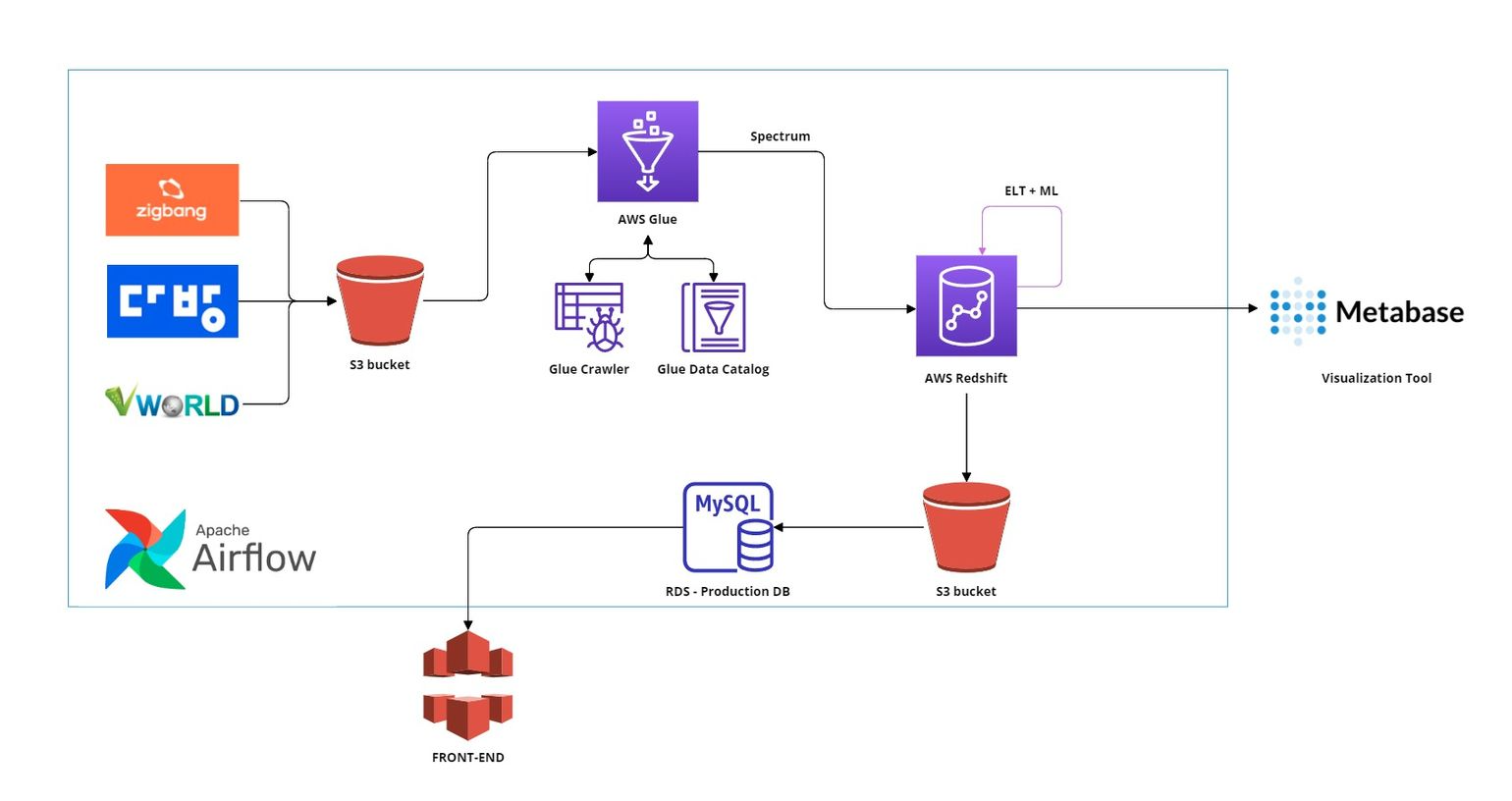

9.[AWS Infra - Airflow] 자취를 시작하는 분들을 위한 원룸 추천 웹 서비스 제작

데브코스3기 데이터 엔지니어링 과정에서 진행한 최종 프로젝트로,AWS IAM 계정 및 여러 리소스를 지원받아서 프로젝트를 진행할 수 있었습니다.저는 프로젝트 내에서 Infra 역할을 맡았기에 제가 다뤘던 AWS 각종 리소스 및 CI/CD 등에 대해 기록을 해두고자 합니

10.우분투 자체 프로세스를 통한 Airflow 구축 시도 및 실패

아래는 수행한 절차와 실패한 내용에 대한 기록입니다. Airflow 2.5.1 설치 방법을 참고하여 진행하였습니다. airflow.cfg에서 그 후에 Airflow를 실행시켰을 때는 문제없이 잘 동작했습니다. 메모리 점유율에도 이상이 없었고 Webserver의 UI도 잘 나왔으며, Scheduler나 Worker도 정상적으로 동작했습니다. 그러나 ...

11.AWS EC2를 통한 Airflow CeleryExcutor 구축기 2 (EC2, AutoScalingGroup)

Private subnet에 위치한 Airflow 서버에 접근하기 위해Public subnet에 구축한 Bastion Host입니다.ubuntu 22.04 버전을 사용하였고,단순히 터널링 용도로만 사용할 것이기 때문에 t2.micro로 최소사양 설정을 해주었습니다.그리