spark

1.local, cluster 비교

2개의 core에서 작동하여 map에서 (1,2), (3,4,5)로 나누어 수행하였기 때문에 map의 결과는 순서대로 나오지 않을 수 있다이후 collect를 통해 array로 가져오므로 순서대로 출력됨SparkSubmit은 위의 local 환경임scala> val r

2.spark standalone

각 포트 번호 등은에서 설정한 값이 그대로 나옴master web UI: http://spark-master-01:8188 로 변경master web UI의 Workers(1)에서 변화 확인

3.spark application 배포

spark-submit -> spark application 배포\--class org.apache.spark.examples.SparkPi -> class로 SparkPi 실행/skybluelee/spark3/examples/jars/spark-examples_2.1

4.History Server

spark application의 driver program이 종료되면 web ui는 더 이상 볼 수 없음. 이전 정보의 로그를 저장하여 화면에서 볼 수 있도록 하기 위함eventLog가 많아지면 memory에 문제가 발생하므로 적절히 삭제하거나 위치를 바꾼다.Hist

5.Dynamic Allocation

static allocationexecutor의 최대 개수가 고정만약 다른 application이 executor를 사용하고 있어서 원하는 executor를 전부 사용하지 못한다면 사용 가능한 executor를 먼저 사용하고, application이 종료되어 exec

6.Pipelining and Stage Skip

1개의 thread에서 동작 local에서 동작하더라도 driver와 executor가 동시에 존재. map 함수는 executor 안에서 동작 map5부터는 shuffle되어 순서가 제대로 나오지 않음 동일한 코드를 반복하면 stage0(map1~map3)의

7.Passing Functions to Spark

master를 따로 설정하지 않으면 local의 모든 core를 사용하도록 master가 설정 됨counter 변수는 driver 내부에 존재scala 문법중 s-str은 python의 f-str과 유사. 전체 str에서 $이후는 변수를 가지고 옴위의 counter는

8.RDD Persistence

편의성을 위해 setName 추가persist를 통해 disk로 cache아직까지 action을 실행하지 않은 상태 -> Spark shell web UI: http://spark-master-01:4040/ 의 storage에서는 아무것도 없음action 실

9.Whole File-Based RDDs

파일을 executor로 복사하기 위해서는 hdfs 상에 파일을 생성해야 함여기서는 local에서 실행spark는 파일을 line 단위로 읽는데, wholeTextFiles를 사용하면 파일 단위로 파일을 읽는다.print는 줄바꿈 없이, println은 줄바꿈을 하고

10.Broadcast

broadcast 이전의 m과 broadcastVar은 동일repartition은 shuffle 용도로 stage를 다르게 만들기 위함master web UI: http://spark-master-01:8180/ Running Applications (1) -

11.Accumulator

task들의 결과 값을 driver에서 확인 가능값이 계속해서 증가하지만Spark shell web UI: http://spark-master-01:4040/ 안에서는 이전의 값 확인 불가능하며 각 executor의 결과와 최종 결과만 나와있다.

12.RDD Map-Side Join

큰 테이블과 상대적으로 작은 테이블간 join할 때 사용Large table <=> Fact tableSmall table <=> Dimension tablescala 결과 창에서 table들이 rdd에 즉 executor에 있음을 알 수 있다. broadc

13.Spark SQL

기존의 RDD를 DF으로 transform이 가능broadcast: shuffle을 하지 않게 만드는 용도Spark shell web UI: http://spark-master-01:4040/ 의 SQL에서 실행 과정 확인 가능Spark SQL은 adaptiv

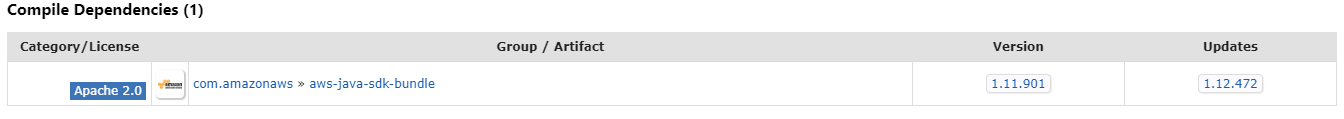

14.spark, s3 connection

본 포스트는 jhleeeme님의 Spark에서 S3 데이터 읽어오기를 참고했습니다. 링크 설치 및 수행 Hadoop-AWS.jar, AWS-java.jar 다운 Hadoop-AWS.jar는 나의 hadoop 버전인 3.3.3을 AWS-java.jar는 최신 버전을 설치

15.spark redshift

databricks에 관련된 package를 설치한다.spark 폴더에서 실행(폴더 내부에 bin 폴더가 있을 것)이 부분은 필수가 아닐수도 있음redshift 관련 jar 파일을 다운 받고conf에 extraClassPath로 경로를 지정한다.conf에 대한 설정은

16.kafka 설정

kafka에는 master, slave 개념이 없음kafka는 worker에만 설치/skybluelee/kafka_2.12-3.0.0/bin안에 zookeeper에 대한 설정 파일이 존재worker별로 노드를 다르게 설정한다.현 위치: worker-1server1은 m

17.kafka 실습

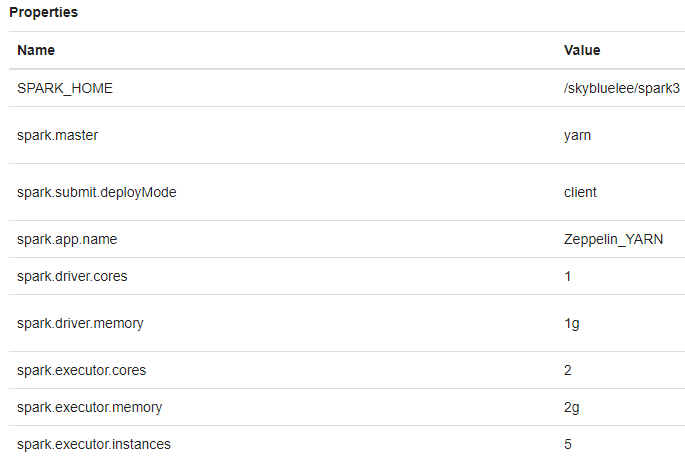

spark_yarn interpreter 수정spark.jars : /skybluelee/spark3/mysql-connector-java-5.1.49.jarspark.jars.packages : org.apache.bahir:spark-streaming-twitter